Deswegen gibt Intel das Power Limit vor, woran die Mainboard-Hersteller sich werkseitig nicht halten, es auch unter Comet-und Rocket Lake nicht getan haben, sodass diese Prozessoren, wie der Igor sagt, laufen gelassen werden (saufen), und der unbdarfte Nutzer, der davon keinen Schimmer hat, holt sich ein ineffektives, kaum bzw. gar nicht zu bändigendes System ins Haus.

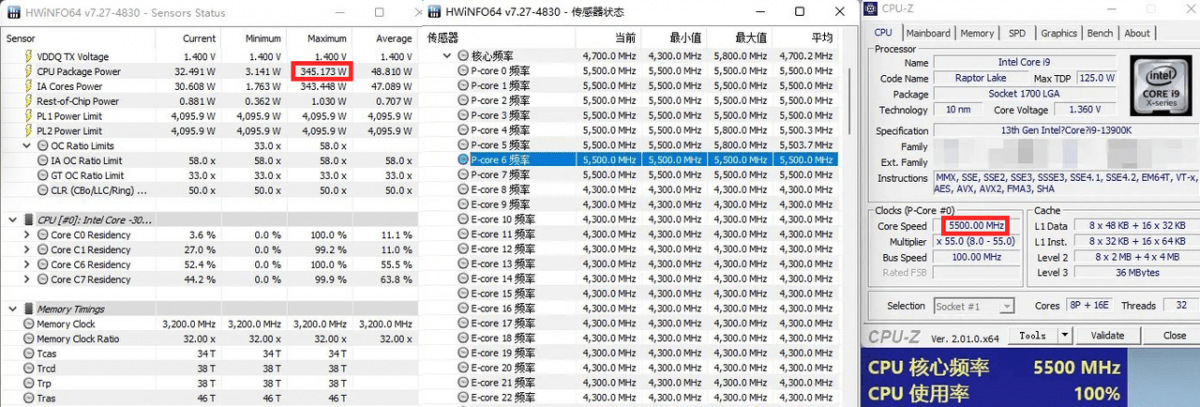

Zieht man zum Beispiel meinen Prozessor zurate, so gibt Intel für das Base Profile eine maximale Leistungsaufnahme von 188 Watt an. Das entspricht schon von seitens Intel exakt dem, was ein YouTube Content Creator (KreativEcke) ermittelt für exakt dieses Modell hat - eine bestmögliche Effizienz um die 180 Watt für die maximale Performance. In darüberhinaus schwinden die Vorteile, die Nachteile überwiegen. Von dem Performance Profile, dieses Intel in ebenso angibt, rate ich ab, zumindest für die i7-und i9-Modelle, weil das in der Regel in kaum mehr zu bändigen ist; Luftkühler steigen vollständig aus und auch die besten AiO-Wasserkühlungen geraten an ihr Limit. Für den Gamer empfehle ich daher, das Power Limit von 125 für den Langzeitbetrieb auch für den Kurzzeitbetrieb zu setzen.

Da geht die im Multiplayer durchaus bis 200 Watt hoch

Da geht die im Multiplayer durchaus bis 200 Watt hoch