Sicher? FC HBASeit 8G gibt es keine Quadport-Karten mehr.

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] 10Gbit Homenetzwerk

- Ersteller barnacle2k

- Erstellt am

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Natürlich fungieren FC Storages als Target, das hab ich ja auch nie bezweifelt

Aber das FC HBAs als Target funktionieren können war für mich neu, das ging spurlos an mir vorbei.

Ich hab jetzt zwei QLE2560 hier und werds mal ausporbieren!

Aber das FC HBAs als Target funktionieren können war für mich neu, das ging spurlos an mir vorbei.

Ich hab jetzt zwei QLE2560 hier und werds mal ausporbieren!

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

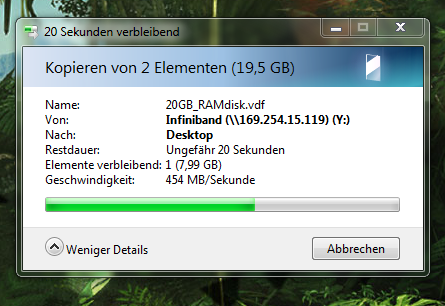

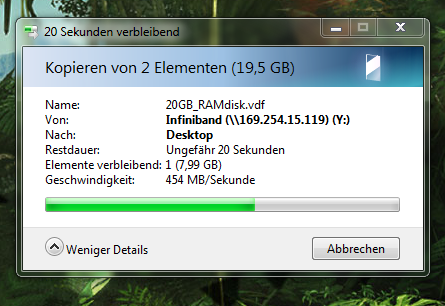

Seit 5 Minuten kommt auch in meinem Netzwerk Infiniband zum Einsatz

Danke für das ausführliche HowTo, Schlingel_INV

Zu der Test-Konfig:

Client:

Intel Core i7-3930K

32GB RAM

3x ADATA S510 @ RAID-0

IB: Voltaire 400Ex

Server:

Intel Xeon X3440

12GB RAM

OCZ RevoDrive 3

IB: Voltaire 400Ex

Danke für das ausführliche HowTo, Schlingel_INV

Zu der Test-Konfig:

Client:

Intel Core i7-3930K

32GB RAM

3x ADATA S510 @ RAID-0

IB: Voltaire 400Ex

Server:

Intel Xeon X3440

12GB RAM

OCZ RevoDrive 3

IB: Voltaire 400Ex

Zuletzt bearbeitet:

Schlingel_INV

Urgestein

Bei mir schlummern die Karten ein wenig. Das meiste habe ich noch über ein System und passende externe Anbindung über SAS geregelt....

Bei mir schlummern die Karten ein wenig. Das meiste habe ich noch über ein System und passende externe Anbindung über SAS geregelt....Trotzdem gut, wenn man ne 10Gb Letung für alle Fälle hat - und was besonderes ists sowieso

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Mein geplanter zentraller Stroage wird sich drüber freuen

Ich würde gern mein ESXi noch mit einer 10Gb-Leitung versorgen, aber die aktuellen Treiber von Mellanox unterstützen anscheinend nur noch die neueren Infiniband-Karten und somit wird das wohl ein Traum bleiben

http://www.mellanox.com/content/pages.php?pg=osv_support_ib&menu_section=34

Ich würde gern mein ESXi noch mit einer 10Gb-Leitung versorgen, aber die aktuellen Treiber von Mellanox unterstützen anscheinend nur noch die neueren Infiniband-Karten und somit wird das wohl ein Traum bleiben

http://www.mellanox.com/content/pages.php?pg=osv_support_ib&menu_section=34

Zuletzt bearbeitet:

jumas

Enthusiast

Du solltest die Open Fabrics probieren.

https://www.openfabrics.org/ofed-for-linux-ofed-for-windows/windows-installer.html

Grüße

Jürgen

Edit: Upps...ist die Windows Abteilung..

https://www.openfabrics.org/ofed-for-linux-ofed-for-windows/windows-installer.html

Grüße

Jürgen

Edit: Upps...ist die Windows Abteilung..

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Edit: Upps...ist die Windows Abteilung..

Jenau so is dat

Auf den Windows-Clients und Servern benutze ich die OpenFabrics-Treiber.

Schlingel_INV

Urgestein

Was spricht gegen die älteren Treiber?

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Ich glaub die sind mit der aktuelle ESXi-Version nicht mehr kompatibel

PhreakShow

Enthusiast

- Mitglied seit

- 02.08.2004

- Beiträge

- 1.116

Ich versuche grad, die Voltaire HCA 400 EX mit dem ESXi 5.1 zum Laufen zu bringen, nachdem Passthrough damit nicht richtig funzt. Den Treiber hab ich installiert nach Anleitung, lspci listet die Karte auch korrekt auf als MT25208. Aber ich krieg keine Verbindung zu meinem Windows 7 her, ibstat sagt immer "link down". Kanns jetzt nicht sein oder...

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Welche Treiber haste den installiert ?

Den Treiber von der Mellanox-Seite ?

Wird die Karte den im vSphere-Client als Netzwerkkarte aufgelistet oder findest du diese nur im Passthrough-Menüpunkt ?

Den Treiber von der Mellanox-Seite ?

Wird die Karte den im vSphere-Client als Netzwerkkarte aufgelistet oder findest du diese nur im Passthrough-Menüpunkt ?

PhreakShow

Enthusiast

- Mitglied seit

- 02.08.2004

- Beiträge

- 1.116

Ich seh die Karte nicht im vSphere Client. Wenn ich sie für Passthrough konfigurieren möchte klappt das zwar, ich kann sie auch einer VM zuordnen, aber innerhalb der VM (2008R2) kommt nach Installieren der Treiber immer Code 10: Gerät kann nicht gestartet werden.

Treiber hab ich von der Mellanox-Seite, MLNX-OFED-ESX-1.8.0.0.zip. Ich seh auch dass er nach dem Boot die Module lädt, "esxcli software vib list | grep Mellanox" zeigt die Liste an wie in dem manual von Mellanox. Allerdings taucht das Device selbst nicht auf, wenn ich "esxcli network nic list | grep -i Mellanox" eingebe. Der SM ist auf meinem Client installiert, Win7 x64. ibstat dort zeigt immer "link down".

Treiber hab ich von der Mellanox-Seite, MLNX-OFED-ESX-1.8.0.0.zip. Ich seh auch dass er nach dem Boot die Module lädt, "esxcli software vib list | grep Mellanox" zeigt die Liste an wie in dem manual von Mellanox. Allerdings taucht das Device selbst nicht auf, wenn ich "esxcli network nic list | grep -i Mellanox" eingebe. Der SM ist auf meinem Client installiert, Win7 x64. ibstat dort zeigt immer "link down".

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Ich seh die Karte nicht im vSphere Client. Wenn ich sie für Passthrough konfigurieren möchte klappt das zwar, ich kann sie auch einer VM zuordnen, aber innerhalb der VM (2008R2) kommt nach Installieren der Treiber immer Code 10: Gerät kann nicht gestartet werden.

Treiber hab ich von der Mellanox-Seite, MLNX-OFED-ESX-1.8.0.0.zip. Ich seh auch dass er nach dem Boot die Module lädt, "esxcli software vib list | grep Mellanox" zeigt die Liste an wie in dem manual von Mellanox. Allerdings taucht das Device selbst nicht auf, wenn ich "esxcli network nic list | grep -i Mellanox" eingebe. Der SM ist auf meinem Client installiert, Win7 x64. ibstat dort zeigt immer "link down".

Genau das is das Problem.

Die Voltaire 400EX-Karten sind, wenn ich mich nicht Irre, gelabelte Mellanox Infinihost III-Karten.

Die aktuellen ESXi-Treiber von der Mellanox-Seite unterstützen nur die neue Generation von Mellanox-Karten ( ConnectX-Modelle ).

Würde der Treiber die Voltaire 400EX unterstützen würden wir die Karten über den vSphere Client auch angezeigt bekommen.

Wenn ich die Tage keine kompatiblen ESX-Treiber finde, werde ich wohl zu Windows 2008 R2 und VMware Worksation 9 greifen müssen.

Die Share-Funktion von der aktuellen 9er Version kann sich echt sehen lassen ...

Zuletzt bearbeitet:

PhreakShow

Enthusiast

- Mitglied seit

- 02.08.2004

- Beiträge

- 1.116

Ach komm, das ist doch zum Kotzen. Prinzipiell wärs mir ja egal ob das Kram unter ESXi rennt, wenn ich wenigstens den Passthrough hinbekommen würde. Aber da lässt sich das Gerät nicht starten. Hast du ne Idee dazu?

Edit: Ja, die Voltaire 400Ex sind gelabelte Mellanox InfiniHost III Karten. Sagt jedenfalls der Treiber, der meine Karte in lspci ja auch richtig erkennt.

Edit: Ja, die Voltaire 400Ex sind gelabelte Mellanox InfiniHost III Karten. Sagt jedenfalls der Treiber, der meine Karte in lspci ja auch richtig erkennt.

Zuletzt bearbeitet:

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Im Moment hab ich echt kein Spruch zu der ganxzen Sache.

Ich hab gestern mal probiert die alten ESXi 4.x-Treiber zu installieren, aber die Installation wird nicht fortgesetzt, da die Pakete explizit für die 4er Version gestickt wurden

Ein Downgrade von ESXi 5.x auf ESXi 4.x wäre noch eine Möglichkeit, aber für mich kommt das eher nicht in Frage ...

Ich hab gestern mal probiert die alten ESXi 4.x-Treiber zu installieren, aber die Installation wird nicht fortgesetzt, da die Pakete explizit für die 4er Version gestickt wurden

Ein Downgrade von ESXi 5.x auf ESXi 4.x wäre noch eine Möglichkeit, aber für mich kommt das eher nicht in Frage ...

XTaZY

aka h0schi

- Mitglied seit

- 01.11.2004

- Beiträge

- 7.082

- Ort

- HD

- Desktop System

- MESHi

- Laptop

- Apple Macbook Air M1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7945HX

- Mainboard

- Minisforum BD790i

- Kühler

- Custom-Loop

- Speicher

- 32GB Kingston FURY DDR5-5600

- Grafikprozessor

- Nvidia RTX 5070 Ti

- Display

- Dell AW3225QF

- SSD

- Samsung 9100 Pro & 960 Evo 1TB

- Soundkarte

- Onboard

- Gehäuse

- SSUPD Meshlicious

- Netzteil

- Corsair SF750

- Keyboard

- Qwertykeys Neo80 TKL

- Mouse

- Lemokey G2

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- Aquaero 6 LT

- Internet

- ▼1000 MBit ▲50 MBit

Ich hätte da vielleicht noch eine Idee.

Ich werde die Tage mal ESXi 4.0 installieren, die alten kompatiblen Treiber einspielen und danach ein Update mit vSphere CLI auf die Version 5.1 einspielen.

Vielleicht bleiben die Treiber der 4er ESXi-Version durch das Update dennoch erhalten.

Ich werde die Tage mal ESXi 4.0 installieren, die alten kompatiblen Treiber einspielen und danach ein Update mit vSphere CLI auf die Version 5.1 einspielen.

Vielleicht bleiben die Treiber der 4er ESXi-Version durch das Update dennoch erhalten.

jumas

Enthusiast

Hi,

hier gibts ne Anleitung, wie man den 3.1er OFED Treiber unter Windows 8 und Server 2012 zum laufen bekommt.

https://www.openfabrics.org/forum/6-installation/179-windows-server-2012.html

Bei mir scheints zu laufen.

Grüße

Jürgen

hier gibts ne Anleitung, wie man den 3.1er OFED Treiber unter Windows 8 und Server 2012 zum laufen bekommt.

https://www.openfabrics.org/forum/6-installation/179-windows-server-2012.html

Bei mir scheints zu laufen.

Grüße

Jürgen

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Hat sich da denn was geändert?

jumas

Enthusiast

Hat sich da denn was geändert?

Wie meinst Du das?

Der 3.1er Treiber lies sich gar nicht installieren, da der die Windows Version geprüft hatte.

Ich musste 2 Monate ohne Infiniband leben. Hab den Artikel heute erst gefunden.

Wer weis schon wann der 3.2 rauskommt.

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Ach, ok, verstehe! Ich hatte das falsch interpretiert!

konfetti

Urgestein

Hallo mal in die Runde.

Les hier schon länger mit, aber eine größere Aufstellung im Ersten Post fehlt mir dennoch.

Da wir nächstes Jahr ein Haus bauen werden, das in jedem Zimmer 2 Ports zur Verfügung haben wird, reicht mein 24er Gigabit eh nicht mehr ganz aus.

Bei der Neuanschaffung schwebt mir nun folgendes Gerät vor:

Netgear ProSafe GS752TXS, 48-Port, smart managed, stackable Preisvergleich | Geizhals Deutschland

Der Switch besitzt 4x 10GE Ports, die ich auch dafür nutzen möchte.

Vorerst sollen der zentrale Fileserver, der passende Backup-Server und ein ESXi damit über 10GE verbunden werden, je nach Auslastung wird ein 2ter ESXi dazukommen.

nun brauch ich also 3-4 Karten, mit denen ich das ganze recht easy realisieren kann. - Oder gibt es andere Switche die diesen Preisrahmen nicht wesentlich sprengen werden und auch 4x 10GE bieten?

Danke für Tips und Hinweise

Les hier schon länger mit, aber eine größere Aufstellung im Ersten Post fehlt mir dennoch.

Da wir nächstes Jahr ein Haus bauen werden, das in jedem Zimmer 2 Ports zur Verfügung haben wird, reicht mein 24er Gigabit eh nicht mehr ganz aus.

Bei der Neuanschaffung schwebt mir nun folgendes Gerät vor:

Netgear ProSafe GS752TXS, 48-Port, smart managed, stackable Preisvergleich | Geizhals Deutschland

Der Switch besitzt 4x 10GE Ports, die ich auch dafür nutzen möchte.

Vorerst sollen der zentrale Fileserver, der passende Backup-Server und ein ESXi damit über 10GE verbunden werden, je nach Auslastung wird ein 2ter ESXi dazukommen.

nun brauch ich also 3-4 Karten, mit denen ich das ganze recht easy realisieren kann. - Oder gibt es andere Switche die diesen Preisrahmen nicht wesentlich sprengen werden und auch 4x 10GE bieten?

Danke für Tips und Hinweise

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Die Karten siehst du ja im ersten Post. Großartig mehr kommt da auch nicht, seitdem dieser Thread existiert hat sich da nicht viel getan. Offenbar wirst du ja eine LWL Verkabelung einsetzen, daher stehen dir viele Möglichkeiten offen. Kommt ein bisschen darauf an wo du einkaufen willst bzw. ob die Teile neu oder gebraucht sein sollen. Beim ESX kannst du noch in die Kompatibilitätsmatrix schauen, allerdings sollten die genannten Modelle alle supportet sein, sind ja durchaus gängige Komponenten.

konfetti

Urgestein

Also der Switch sollte schon neu sein, allein schon wegen der Garantie - bei den Karten wärs relativ egal - Aber funktioniert dann schon so, das ich auch mit den normalen Gigabit-Clients auf den Server komm der am 10GE hängt? - Dacht da gäbs evtl. noch was zu beachten

Gibts sonst evtl. Tips wo man günstiger ran kommt? - Neu würden ja Switch und 4 Karten auch sowas um die 2.500€ kosten... - liegt noch im Rahmen, aber wenns günstiger ginge, wäre ich nicht abgeneigt.

Gibts sonst evtl. Tips wo man günstiger ran kommt? - Neu würden ja Switch und 4 Karten auch sowas um die 2.500€ kosten... - liegt noch im Rahmen, aber wenns günstiger ginge, wäre ich nicht abgeneigt.

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Ja, das funktioniert genau so, wenn du es entsprechend konfigurierst. Diese Switche sind ja komplett managable.

10G Karten kriegt man bei eBay für roundabout 100 Euro, ohne SFPs und SFP+ CU geht nicht bei allen.

Die Modelle schwanken je nach Verfügbarkeit und insgesamt tauchen die halt doch eher selten auf. Da nicht alle Karten auf allen Boards laufen werden handelt es sich sowieso ein bisschen um Glücksspiel. Beispiel HP NC550SFP vs. IBM 49Y4201: Beides sind Emulex OCe10102 als jeweilige OEM Version. Abgesehen von der mechanischen Veränderung des PCIe Anschlusses durch IBM sind diese Karten technisch identisch, sie laufen auch mit dem selben Treiber. Die IBM Karte funktioniert auf einem Asus P9X79, die HP Karte nicht. In anderen Systemen wiederum funktionieren beide und in nochmal anderen ging nur die HP Karte. Bei der HP Karte funktionieren optische SFPs und SFP+ CU Kabel, bei der von IBM nur die optischen SFPs.

Wenn du die Hardware neu kaufst wirst du mit 2500 Euro für Switch und vier Karten übrigens tendenziell eher nicht hinkommen, falls du gezwungen sein solltest optische SFPs zu benutzen. Ist eh die Frage ob SFP+ CU für dich überhaupt ein Thema ist, da der Weg zu einem zentralen Switch ja meistens zu lang ist. Dann brauchst du nochmal acht SFPs (einen pro Karte und vier für den Switch) und die originalen der jeweiligen Hersteller kosten so zwischen ~400 und ~1000 Euro pro Stück für SR Transcevier. Nachbauten oder als "kompatible" SFPs anderer Hersteller verkaufte Transceiver kosten weniger, aber da ist das mit der Kompatibilität immer so eine Sache.

Beispiel HP NC550SFP: HP NC550SFP, 2x 10GBase SFP+, PCIe x8 (581201-B21) Preisvergleich | Geizhals Deutschland

Für 330 Euro kriegst du die nackte Karte und brauchst dann mindestens einmal pro Karte diesen Transceiver: HP BladeSystem c-Class 10Gb SR SFF Plug-Option, 1x 10GBase-SR SFP+ (455883-B21) Preisvergleich | Geizhals Deutschland

Wir reden also eher von 900 Euro pro Server, 1200 Euro für den Switch und vier Transceiver dafür: Netgear ProSafe AXM761, 1x 10GBase-SR SFP+ Modul Preisvergleich | Geizhals Deutschland

Wenn man da dann einen Strich drunter macht reden wir eher von 4*900+1200+4*450 = 6600 Euro für deine notwendige 10G Infrastruktur.

10G Karten kriegt man bei eBay für roundabout 100 Euro, ohne SFPs und SFP+ CU geht nicht bei allen.

Die Modelle schwanken je nach Verfügbarkeit und insgesamt tauchen die halt doch eher selten auf. Da nicht alle Karten auf allen Boards laufen werden handelt es sich sowieso ein bisschen um Glücksspiel. Beispiel HP NC550SFP vs. IBM 49Y4201: Beides sind Emulex OCe10102 als jeweilige OEM Version. Abgesehen von der mechanischen Veränderung des PCIe Anschlusses durch IBM sind diese Karten technisch identisch, sie laufen auch mit dem selben Treiber. Die IBM Karte funktioniert auf einem Asus P9X79, die HP Karte nicht. In anderen Systemen wiederum funktionieren beide und in nochmal anderen ging nur die HP Karte. Bei der HP Karte funktionieren optische SFPs und SFP+ CU Kabel, bei der von IBM nur die optischen SFPs.

Wenn du die Hardware neu kaufst wirst du mit 2500 Euro für Switch und vier Karten übrigens tendenziell eher nicht hinkommen, falls du gezwungen sein solltest optische SFPs zu benutzen. Ist eh die Frage ob SFP+ CU für dich überhaupt ein Thema ist, da der Weg zu einem zentralen Switch ja meistens zu lang ist. Dann brauchst du nochmal acht SFPs (einen pro Karte und vier für den Switch) und die originalen der jeweiligen Hersteller kosten so zwischen ~400 und ~1000 Euro pro Stück für SR Transcevier. Nachbauten oder als "kompatible" SFPs anderer Hersteller verkaufte Transceiver kosten weniger, aber da ist das mit der Kompatibilität immer so eine Sache.

Beispiel HP NC550SFP: HP NC550SFP, 2x 10GBase SFP+, PCIe x8 (581201-B21) Preisvergleich | Geizhals Deutschland

Für 330 Euro kriegst du die nackte Karte und brauchst dann mindestens einmal pro Karte diesen Transceiver: HP BladeSystem c-Class 10Gb SR SFF Plug-Option, 1x 10GBase-SR SFP+ (455883-B21) Preisvergleich | Geizhals Deutschland

Wir reden also eher von 900 Euro pro Server, 1200 Euro für den Switch und vier Transceiver dafür: Netgear ProSafe AXM761, 1x 10GBase-SR SFP+ Modul Preisvergleich | Geizhals Deutschland

Wenn man da dann einen Strich drunter macht reden wir eher von 4*900+1200+4*450 = 6600 Euro für deine notwendige 10G Infrastruktur.

Zuletzt bearbeitet:

konfetti

Urgestein

Hmpf... - Das schaut aber "unschön" aus...

vergleichsweise werden sich die Preise ja wohl kaum wirklich schnell ändern oder? - bei den SFPs dachte ich an Finisar... zumindest ham in unseren andern Netgears die Finisar sehr gut funktioniert. - bei den Karten weiß ichs natürlich nicht, naja, ich werd in der Bucht mal die Augen offen halten.

vergleichsweise werden sich die Preise ja wohl kaum wirklich schnell ändern oder? - bei den SFPs dachte ich an Finisar... zumindest ham in unseren andern Netgears die Finisar sehr gut funktioniert. - bei den Karten weiß ichs natürlich nicht, naja, ich werd in der Bucht mal die Augen offen halten.

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Wegen was genau willst du denn die vier Server mit 10G anbinden? Infiniband ist für längere Distanzen nicht geeignet, aber vielleicht kommt FibreChannel für dich in Frage. Wenn es nur darum geht Storage zu verteilen ist das vielleicht eine günstigere Option. Die normale LAN Anbindung kannst du dann mit 1G umsetzen.

Du sparst dir den Switch mit den 10G Ports und hast bei den Karten die Wahl zwischen 4 Gbit, die man fast geschenkt bekommt, und 8 Gbit. Ist dafür etwas mehr Gebastel und die Server, die Storage bereitstellen sollen, müssen mit Linux laufen.

Das ist die SCST Geschichte an der ich im Moment bastel, ich hab das mittlerweile auch schonmal live in Aktion getestet und das funktioniert ganz gut. Die Konfiguration und EInrichtung ist etwas fummelig, aber irgendwas ist ja immer...

Du sparst dir den Switch mit den 10G Ports und hast bei den Karten die Wahl zwischen 4 Gbit, die man fast geschenkt bekommt, und 8 Gbit. Ist dafür etwas mehr Gebastel und die Server, die Storage bereitstellen sollen, müssen mit Linux laufen.

Das ist die SCST Geschichte an der ich im Moment bastel, ich hab das mittlerweile auch schonmal live in Aktion getestet und das funktioniert ganz gut. Die Konfiguration und EInrichtung ist etwas fummelig, aber irgendwas ist ja immer...

konfetti

Urgestein

Naja, Hauptproblem ist das nur 2 Server ständig laufen werden, der Haupt-Filer im Keller sowie 1 ESX - der Backup-Filer wird nur zur Sicherung laufen, genauso wie der 2te ESX wohl nur am WE oder abends zeitweise an ist.

Ich wollte halt nicht alles doppelte Leitungen pro Server - gut Haupt-Filer und Backup-Filer können mit ner 10GE direkt reden, aber dann brauch ich immernoch an beiden den 1GE-Link - der ESX hätte auch nur einen 10GE bekommen, über den alles laufen soll, nicht 2 oder 3 Kabel, dafür müsste der 10GE ja ausreichen.

Der längste Weg ist der vom Haupt- zum Backup-Filer ~ 15-20m wenn ich mich nicht vertan habe, aber mal gucken, vlt. kann man das ja noch etwas "umdesignen"...

Ich danke erstmal für die Infos.

Ich wollte halt nicht alles doppelte Leitungen pro Server - gut Haupt-Filer und Backup-Filer können mit ner 10GE direkt reden, aber dann brauch ich immernoch an beiden den 1GE-Link - der ESX hätte auch nur einen 10GE bekommen, über den alles laufen soll, nicht 2 oder 3 Kabel, dafür müsste der 10GE ja ausreichen.

Der längste Weg ist der vom Haupt- zum Backup-Filer ~ 15-20m wenn ich mich nicht vertan habe, aber mal gucken, vlt. kann man das ja noch etwas "umdesignen"...

Ich danke erstmal für die Infos.

DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

Hast du mal eine Infrastrukturskizze mit allen Servern und Clients und deren Positionen sowie den angedachten Standorten für die zentralen Netzkomponenten, d.h. Switch und Internetzugang, wo man auch die Entfernungen drauf erkennt? Zur Planung ist sowas immer extrem praktisch.

Vielleicht kann man ja noch irgendwie konsolidieren und am Ende mit einem kleinen Technologiemix arbeiten um Kosten zu sparen. Wie genau sehen deine Use Cases aus? Redundante Filer machen ja vielleicht sogar noch Sinn, aber direkt zwei ESX Hosts?

Vielleicht kann man ja noch irgendwie konsolidieren und am Ende mit einem kleinen Technologiemix arbeiten um Kosten zu sparen. Wie genau sehen deine Use Cases aus? Redundante Filer machen ja vielleicht sogar noch Sinn, aber direkt zwei ESX Hosts?

konfetti

Urgestein

Skizze ist zu Hause...

nunja, Ein ESXi Host, ist nur zum spielen, der auch leicht mal mit auf LAN genommen wird, da aber nur begrenzt lokalen Platz hat, zu Hause aber auf das Storage zugreifen soll, der kann auch ausgeschaltet werden - läuft wohl aber am WE - Testumgebung und so.

der andere soll immer laufen, Webserver, Backup-FTP für die Webseite (extern), Mediadienste, [evtl. nen AD auf Basis Small-Business Server], DLNA-Server, Hausautomatisierung

(extern), Mediadienste, [evtl. nen AD auf Basis Small-Business Server], DLNA-Server, Hausautomatisierung

Ich guck, das ich die Skizze heut abend mal anhänge.

nunja, Ein ESXi Host, ist nur zum spielen, der auch leicht mal mit auf LAN genommen wird, da aber nur begrenzt lokalen Platz hat, zu Hause aber auf das Storage zugreifen soll, der kann auch ausgeschaltet werden - läuft wohl aber am WE - Testumgebung und so.

der andere soll immer laufen, Webserver, Backup-FTP für die Webseite

Ich guck, das ich die Skizze heut abend mal anhänge.

amdpc

Enthusiast

Hallöchen,

mal ne Frage aus der anderen Ecke als Zuhause ;-)

Hat jemand ernsthafte Erfahrungen mit Cisco Nexus 5000 und ner 10 Gbit !!RJ-45!! Intel Karte ?

Hatte da mal n bisschen was falsches bestellt

Mit freundlichen Grüßen

amdpc

mal ne Frage aus der anderen Ecke als Zuhause ;-)

Hat jemand ernsthafte Erfahrungen mit Cisco Nexus 5000 und ner 10 Gbit !!RJ-45!! Intel Karte ?

Hatte da mal n bisschen was falsches bestellt

Mit freundlichen Grüßen

amdpc

Ähnliche Themen

- Antworten

- 7

- Aufrufe

- 9K

- Antworten

- 3

- Aufrufe

- 3K

[User-Review]

Synology DP320 ActiveProtect

- Antworten

- 1

- Aufrufe

- 2K

- Antworten

- 9

- Aufrufe

- 10K