Werbung

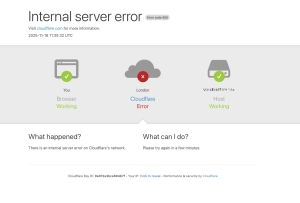

Am 18. November 2025 kam es ab 11:20 UTC zu gravierenden Störungen im Netzwerk von Cloudflare. Für zahlreiche Internetnutzer äußerte sich der Ausfall in Form von Fehlerseiten, die auf Probleme innerhalb des Cloudflare-Netzwerks hinwiesen. Die Ursache lag nicht in einem externen Angriff, sondern in einer internen Fehlkonfiguration, die tief in die Infrastruktur des Dienstes eingriff und zentrale Routingprozesse lahmlegte. Dies geht aus einem Bericht hervor, den Cloudflare veröffentlicht hat.

Auslöser war eine Änderung an den Berechtigungen eines Datenbanksystems. Diese führte dazu, dass die zugrunde liegende Abfrage fehlerhafte Inhalte erzeugte und ein Konfigurationsdokument - ein sogenanntes Feature File - für das Bot-Management deutlich größer wurde als vorgesehen. Dieses Feature File wird regelmäßig neu generiert und anschließend an sämtliche Systeme im weltweiten Netzwerk verteilt. Die Datei dient unter anderem dazu, die lokalen Komponenten mit aktuellen Informationen zur Erkennung automatisierter Angriffe zu versorgen.

Das Routing- und Bot-Management-System in den Rechenzentren ist darauf ausgelegt, diese Datei in bestimmten Größenlimits zu verarbeiten. Die durch den Berechtigungsfehler verdoppelte Dateigröße überschritt jedoch diese Grenze. Dadurch brachen die entsprechenden Softwaremodule auf einer Vielzahl von Maschinen ab, was zu einer weitreichenden Störung des Datenverkehrs führte. Da die neue Version des Feature Files durch ein verteiltes Aktualisierungssystem propagiert wurde, verbreitete sich der Fehler innerhalb kurzer Zeit im gesamten Netzwerk.

Die Analyse wurde zunächst dadurch erschwert, dass der Fehler in regelmäßigen Abständen verschwand und wieder auftrat. Hintergrund war ein Cluster von ClickHouse-Datenbankknoten, das schrittweise aktualisiert wurde. Nur auf den bereits aktualisierten Knoten wurde das fehlerhafte Feature File erzeugt. Alle fünf Minuten entstand daher entweder eine funktionierende oder eine fehlerhafte Variante. Abhängig davon, welcher Knoten die Datei generierte, wechselten die Systeme zwischen funktionsfähig und instabil. Diese Schwankungen gaben zunächst Anlass zu der Vermutung, es könnte sich um einen sehr groß angelegten DDoS-Angriff handeln.

Erst als alle Knoten des Clusters die problematische Berechtigungsänderung übernommen hatten, stabilisierte sich der Zustand - jedoch in der fehlerhaften Variante. Ab diesem Zeitpunkt traten die Störungen dauerhaft auf. Die Fehlerraten bei HTTP-Anfragen stiegen stark an und zeigten deutlich, dass der Kern des Routing-Systems nicht mehr ordnungsgemäß arbeitete.

Die Wiederherstellung begann ab 14:30 UTC, als das Problem eindeutig identifiziert wurde. Cloudflare stoppte die Erzeugung und Verbreitung des fehlerhaften Konfigurationsdokuments und ersetzte es manuell durch eine vorherige, funktionierende Version. Anschließend wurden zentrale Proxy-Komponenten neu gestartet, um den fehlerhaften Zustand aufzulösen. Der Datenverkehr normalisierte sich schrittweise. Einzelne Systeme wurden im Verlauf der nächsten Stunden ebenfalls neu initialisiert, um verbleibende Fehlzustände zu beheben.

Um 17:06 UTC meldete Cloudflare dann, dass alle Systeme wieder wie gewohnt arbeiteten. Der Ausfall machte deutlich, wie stark das globale Internet von korrekt funktionierenden Verteilungssystemen abhängig ist und wie sensibel große Infrastrukturkomponenten auf fehlerhafte Konfigurationsdaten reagieren können. Cloudflare kündigte an, Prozesse, Sicherheitsmechanismen und interne Qualitätsprüfungen anzupassen, um ähnliche Vorfälle in Zukunft zu verhindern.