Werbung

Multi-Chip-Module sind keine neue Technik und werden immer wieder zum Thema, wenn es um zukünftige Chipentwicklungen geht. AMD setzt solche MCM (Multi-Chip-Module) bei den aktuellen Ryzen- und Epyc-Prozessoren ein und tat dies bereits in der Vergangenheit. Die ersten Dual-Core-Prozessoren bestanden aus zwei Single-Core-Dies, die einfach in einem Package zusammengebracht wurden.

Bei den GPUs spielen Multi-Chip-Module hingegen noch keine Rolle. Dies könnte sich in Zukunft aber ändern, denn auch wenn die Hersteller dies aktuell noch verneinen, angesichts der immer komplexeren Fertigung und immer größeren GPUs mit inzwischen 15 Milliarden Transistoren auf 815 mm² ist derzeit nicht abzusehen, wie eine Leistungssteigerung mit monolithischen GPUs weiter erreicht werden soll.

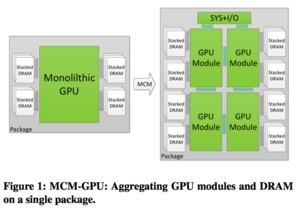

Dementsprechend gibt es offenbar auch bei den GPUs Entwicklungen hin zu MCM-Designs. NVIDIA hat nun zusammen mit einigen Wissenschaftlern der Arizona State University, University of Texas at Austin und dem Barcelona Supercomputing Center ein Papier mit dem Titel "MCM-GPU: Multi-Chip-Module GPUs for Continued Performance Scalability" ( PDF) veröffentlicht.

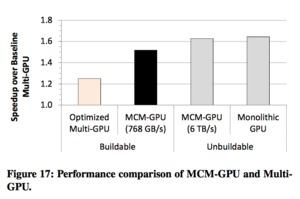

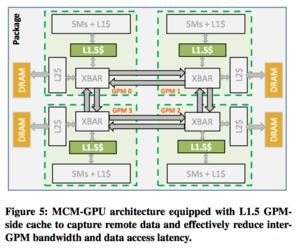

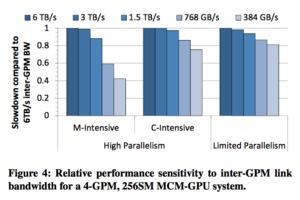

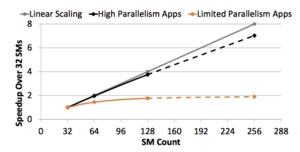

In diesem wird auf die Entwicklung eines recht "einfachen" GPU-Modules (GPMs) eingegangen, welches dann zum Beispiel in einem Mesh mit weiteren solchen Modulen in einem MCM zusammengebracht wird. Es handelt sich dabei um spezielle MCM-GPUs, die auf die Bedürfnisse in einem MCM angepasst sind. Damit erreichen die Forscher eine um den Faktor fünf reduzierte interne GPU-Kommunikation über einen internen Interconnect und gleichzeitig kann die Leistung des einzelnen GPM um 22,8 % gesteigert werden.

Eine im MCM-Design simulierte GPU kann deutlich komplexer sein als dies in einem monolithischen Design der Fall ist. Gleichzeitig soll die Leistung sich in etwa im gleichen Bereich (+/- 10 %) bewegen. Gegenüber klassischen Multi-GPU-Systemen sind die speziellen MCM-Designs um 26,8 % im Vorteil.

Für ein MCM-Design ist es wichtig, einen Datenaustausch zwischen den einzelnen Modulen möglichst gering zu halten. Daten zwischen verschiedenen Modulen auszutauschen wird zum einen durch die Bandbreite limitiert, zum anderen aber auch durch die Latenzen. Welche Auswirkungen dies haben kann, zeigt die aktuelle Strategie bei AMD und Intel.

Vergleicht man die Chipgröße der aktuellen Intel- und AMD-Prozessoren, fällt auf, dass beide unterschiedliche Strategien bei den größeren Chips anwenden. Während AMD auf einen modularen Aufbau setzt, verwendet Intel große monolithische Chips mit enormer Fläche.

Beides hat seine Vor- und Nachteile. Chips im MCP-Design lassen sich relativ einfach fertigen, sind jedoch von einem schnellen Interconnect abhängig. Große monolithische Chips hingegen erreichen inzwischen enorme Größen, sind entsprechend aufwändig zu fertigen, die Kommunikation innerhalb des Chips ist aber hinsichtlich der Bandbreite und vor allem Latenz berechenbarer. Dies alles lässt sich auf die GPUs übertragen.

Zurück zum Forschungspapier: Neben jeder Menge Details zur Cache-Hierarchie und einem dazugehörigen Aufbau kommt das Papier zum Schluss, dass ein MCM-Design bei den GPUs durchaus Sinn macht. Vor allem im Hinblick auf die immer größer und komplexer werdenden Chips könnten solche MCM-Designs ein Ausweg sein.

Mit dem High Bandwidth Memory und dem Interposer ist die grundsätzliche Technik dazu bereits vorhanden, denn ein Interposer wäre notwendig, um die Kommunikation zwischen den Chips und dem Speicher zu bewerkstelligen.

Auch AMD scheint bei den GPUs an MCM zu arbeiten

Wirft man einen Blick auf AMDs GPU-Roadmap, werden auch hier Ansätze für MCM-Designs sichtbar. Nach der Vega-Architektur soll Navi erscheinen. Für diese nennt AMD eine neue Speichertechnologie als wichtiges Merkmal, auch wenn derzeit nicht abzusehen ist, um was es sich dabei genau handeln könnte. Außerdem nennt AMD im Zusammenhang mit Navi Scaleability, also Skalierbarkeit. Darauf gab es zu Beginn bereits einen Hinweis, denn in Zukunft erwartet AMD einen immer weiter steigenden Bedarf nach GPU-Rechenleistung. Dazu beitragen soll auch das Thema Virtual Reality. Immer höher auflösende Displays sind der treibender Faktor hinter dieser Entwicklung. Dieser Bedarf wird durch eine Recheneinheit oder eine GPU immer schwieriger abzudecken sein und auch hierzu gab AMD bereits im März 2016 erste Hinweise.

Der Interposer biete außerdem Möglichkeiten, über die aktuell zwar noch nicht konkret nachgedacht werde, die aber in wenigen Jahren ebenfalls eine Rolle spielen könnten. Denn trotz immer kleinerer Fertigungsgrößen sei es zunehmend schwerer, darin große Chips zu fertigen. Bei den GPUs werde aber versucht, mehr und mehr Shader und weitere GPU-Infrastruktur in einem Chip unterzubringen, so dass diese natürlich immer komplizierter werden. Die Interposer-Technologie biete nun die Möglichkeit, mehrere GPUs auf einem Interposer zu verbinden – eine Art integriertes CrossFire. Wie gesagt, dabei handelt es sich um theoretische Überlegungen und noch nicht um konkrete Pläne:

Robert Hallock: "Yes, it is absolutely possible that one future for the chip design industry is breaking out very large chips into multiple small and discrete packages mounted to an interposer. We're a long ways off from that as an industry, but it's definitely an interesting way to approach the problem of complexity and the expenses of monolithic chips."