Werbung

Nicht nur neue Supercomputer werden mit einer Vielzahl der neue Tesla P100 ausgestattet werden, für das Training und den Betrieb von Deep-Learning-Netzwerken bietet NVIDIA ab sofort auch einen eigenen "kleinen Supercomputer" an – den DGX-1. Dieser verwendet acht Tesla P100 Beschleuniger auf Basis der neuen Pascal-Architektur.

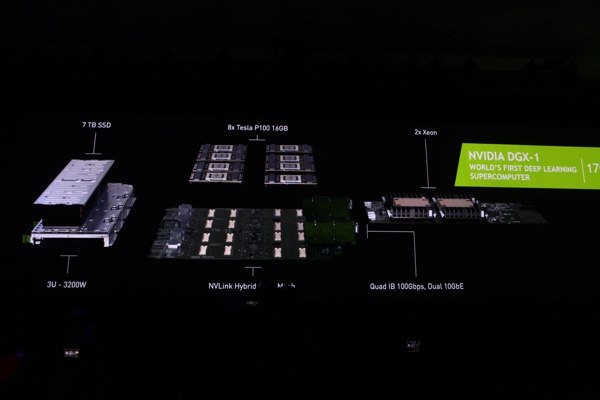

Der DGX-1 Supercomputer ist ein komplettes System in einem 3U-Gehäuse. Darin befinden sich wie gesagt acht Tesla P100 Beschleuniger mit jeweils 16 GB an HBM2. Hinzu kommen zwei Xeon-Prozessoren von Intel, bei denen es sich um die neuen Xeon E5-2600 v4 mit bis zu 22 Kernen handeln dürfte. Hinzu kommen 7 TB an SSD-Speicher sowie vier 100 GBit und zwei 10 GBit schnelle Netzwerkinterfaces. Die acht Tesla P100 sind mittels eines NVLink-Netzwerks miteinander verbunden. Das komplette System ist für eine Leistungsaufnahme von 3.200 W ausgelegt.

NVIDIA DGX-1 Supercomputer mit acht Tesla P100

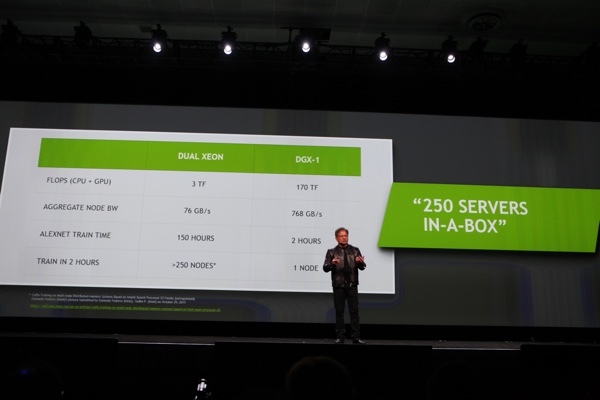

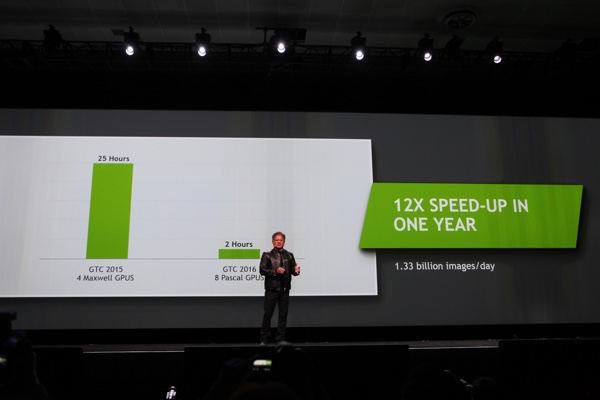

Die Rechenleistung eines DGX-1 beträgt 170 TFLOPS für Berechnungen bei halber Genauigkeit (FP16). NVIDIA liefert natürlich auch gleich die dazugehörigen Leistungsvergleiche. Demnach kommt ein Dual-Xeon-System auf 3 TFLOPS und die aggregierte Bandbreite im Knoten beträgt beim DGX-1 768 GB/s, während es bei anderen Servern nur 76 GB/s sind. Alexnet ist eine beliebte Datenbasis für Deep-Learning-Netzwerke und mittels DGX-1 ist ein Training innerhalb von zwei Stunden möglich, während es auf einem Dual-Xeon-System 150 Stunden sein sollen. Die im vergangenen Jahr vorgestellte Digits Devbox mit vier Maxwell-GPUs benötigte für diese Ausgabe 25 Stunden.

NVIDIA DGX-1 Supercomputer mit acht Tesla P100

"Artificial intelligence is the most far-reaching technological advancement in our lifetime," so Jen-Hsun Huang, CEO von NVIDIA. "It changes every industry, every company, everything. It will open up markets to benefit everyone. Data scientists and AI researchers today spend far too much time on home-brewed high performance computing solutions. The DGX-1 is easy to deploy and was created for one purpose: to unlock the powers of superhuman capabilities and apply them to problems that were once unsolvable."

Der DGX-1 Supercomputer kann ab sofort vorbestellt werden, allerdings nennt NVIDIA keinen Termin für die Auslieferung. Der Preis ist mit 129.000 US-Dollar natürlich ein Faktor, den es dabei im Auge zu behalten gilt.

Update:

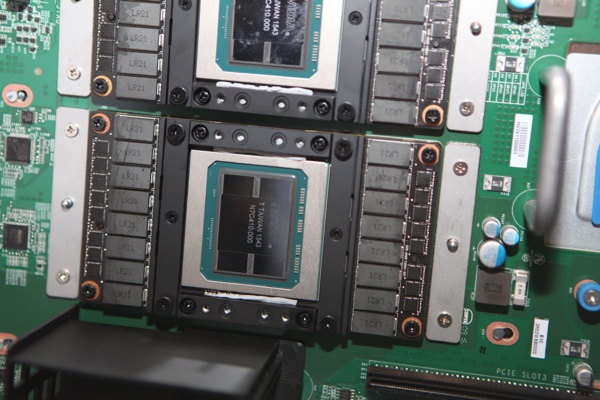

Im Ausstellungsbereich auf der GPU Technology Conference stellt QCT eine Abwandlung des NVIDIA DGX-1 aus. Das Gehäuse ist zwar auch in drei Höheneinheiten gehalten, allerdings etwas anders aufgebaut, als dies NVIDIA gezeigt hat. Interessant ist der Blick in das Gehäuse, denn dort sind die acht Tesla P100 zu sehen, die allesamt auf dem Sockel für die SXM2-Module sitzen. Die Packdichte ist dabei beeindruckend, vor allem wenn man sich die Rechenleistung vorstellt.

QuantaPlex T21W-3U

Offenbar wurden die GPUs auf den Modulen in der 43. Woche 2015 gefertigt und NVIDIA wird nicht erst in den letzten Tagen damit begonnen haben die GPUs zu fertigen. Dies dürfte allerdings noch nicht für die HBM2-Speicherchips gelten. Anders als bei AMD sind diese auf gleicher Höhe zur GPU. NVIDIA verwendet dazu einen Spacer, den man in Zukunft anpassen kann, um die größeren HBM2 zu verbauen.

QCT bietet den QuantaPlex T21W-3U zusammen mit einem Intel Xeon E5-2600 v3 und v4 an. Hinzu kommen die besagten 7 TB SSD-Speicher, die Netzwerkkontroller sowie die Möglichkeit bis zu 16 TB an Arbeitsspeicher zu verbauen. Dazu bietet der Server 16 Slots an, in die entweder Module mit 512 GB RDIMM oder Module mit 1.024 GB LRDIMM verbaut werden können.