Werbung

Bei AMD und NVIDIA scheint der Weg für eine zukünftige Speichertechnologie geebnet zu sein. Während AMD bereits ab diesem Sommer auf High Bandwidth Memory setzt - z.B. auf der Radeon R9 Fury X, Radeon R9 Fury und Radeon R9 Nano - wird NVIDIA erst im kommenden Jahr mit der Pascal-GPU auf eben diesen Speichertyp setzen. Ob dann SK Hynix wie bei AMD der Lieferant für diesen Speicher ist oder aber Samsung ebenfalls erste größere Volumen liefern wird, steht noch in den Sternen.

HBM wird bis auf absehbare Zeit dem High-End-Bereich vorbehalten bleiben. Ab der Mittelklasse setzten AMD und NVIDIA wohl noch einige Zeit auf GDDR5, der inzwischen Taktraten von bis zu 2.000 MHz erreicht, auf den Karten machen die Hersteller derzeit aber nur Gebrauch von 1.750 MHz. In die Lücke zwischen HBM und dem vermeintlich abgehängten GDDR5 möchte Micron mit GDDR5X springen. Dieser basiert technisch auf der aktuellen Speichertechnologie, wird allerdings in einigen Details derart angepasst, dass die Datenrate ansteigt.

Briefing von Micron zu GDDR5X

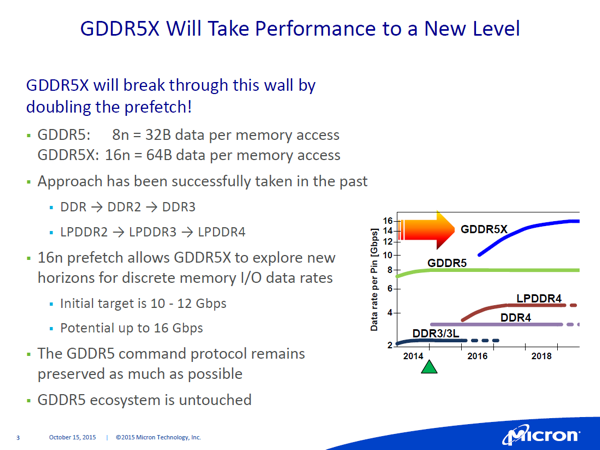

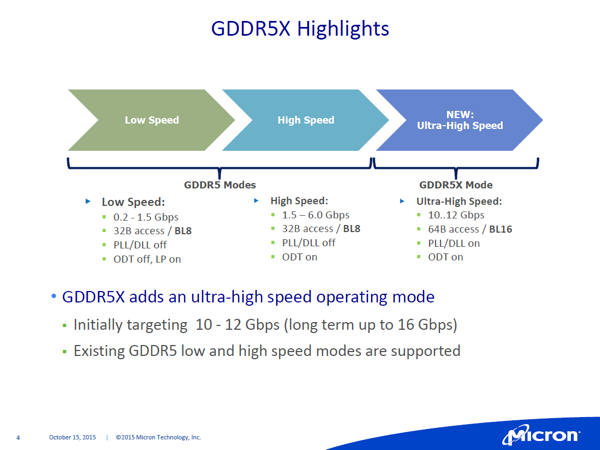

So wird der Prefetch von 32 auf 64 Bit verdoppelt. Dadurch verdoppelt sich auch die Anzahl der Datenwörter pro Zugriff von 8 auf 16. Die Datenraten pro Speicherchip liegen aktuell bei 8 GBit/s bei den erwähnten GDDR5-Varianten mit 2.000 MHz. Micron arbeitet in der aktuellen Ausführung von GDDR5X mit 10 bis 12 GBit/s, plant aber mit bis zu 16 GBit/s. Laut Micron sorgen die geringen Unterschiede zwischen GDDR5 und GDDR5X dafür, dass nur wenige Änderungen beim Design der Speichercontroller vorgenommen werden müssen, was AMD und NVIDIA sicherlich entgegen kommt.

Ein paar Rechenbeispiele dazu: Besitzt eine GPU aktuell ein Speicherinterface mit 256 Bit, so steigert der Einsatz von GDDR5X bei 12 GBit/s die Speicherbandbreite von 256 auf 384 GB/s (bei einem angenommenen Chiptakt von 2.000 MHz). Bei 16 GBit/s wäre sogar eine Verdopplung auf 512 GB/s möglich und damit läge man schon auf Niveau der aktuellen HBM-Generation. An dieser Stelle muss aber auch erwähnt werden, dass ein GDDR5X mit 16 GBit/s derzeit noch nicht realisierbar ist.

Briefing von Micron zu GDDR5X

High Bandwidth Memory ist die zukünftige Speichertechnologie, soviel steht wohl bereits jetzt fest. Gerade der nächste Entwicklungsschritt auf die 2. Generation zeigt ein enormes Potenzial. Aber HBM wird nicht über eine komplette Produktpalette eingeführt werden können - AMD macht dies aktuell vor. GDDR5X besitzt also seine Daseinsberechtigung, zumal die Entwicklung hier ebenfalls voranschreitet und die Integration bzw. die Anbindung an bestehende Speichercontroller recht einfach wäre (ähnliche/identische Timings und Clocks). Netter Nebeneffekt ist die Senkung der Speicherspannung von aktuell 1,5 auf 1,35 V. Selbst das Pinlayout der Chips ist identisch.