Werbung

Am kommenden Samstag will AMD den 30. Geburtstag der GPUs und des Gamings feiern. Dazu wird man die Veranstaltung live aus Denver in die Welt streamen. Natürlich bietet sich diese Gelegenheit an, die seit Wochen in den News bereits behandelte Radeon R9 285 auf Basis der neuen "Tonga"-GPU endlich offiziell vorzustellen. Dies liegt nicht nur nahe, sondern ist auf halboffiziellem Wege auch schon bestätigt worden, auch wenn eine endgültige Gewissheit erst herrschen kann, wenn AMD diesen Schritt wirklich auch vollzieht.

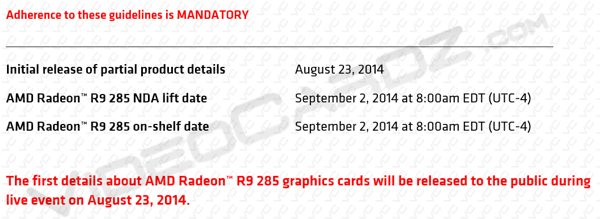

In gewisser Weise wird dies nun von Videocardz bestätigte, denn hier ist der Screenshot eines AMD-Dokuments zu finden, das auf einen initialen Release am 23. August hindeutet und von einem Test-NDA sowie einer Verfügbarkeit am bzw. ab dem 2. September spricht. Weiterhin ist die Rede davon, dass die Radeon R9 285 die R9 280 ersetzen soll. Weitere vier Wochen nach dem Release der ersten "Tonga"-Karte soll dann die Radeon R9 285X folgen, welche folgerichtig als Ersatz der Radeon R9 280X geplant ist. Bisher war eigentlich immer nur von einer Radeon R9 285 die Rede, ein zweites Modell fand sich in den bisherigen Meldungen nicht wieder.

Am kommenden Samstag werden wir vermutlich zumindest zu einem Modell endgültig Gewissheit haben. Sollte es wirklich zu einer Ankündigung einer neuen Grafikkarte kommen, werden wir euch in den News darüber informieren.

{jphoto image=59863}

| AMD-Radeon-R9-280-Serie in der Übersicht | ||||

|---|---|---|---|---|

| Modell | AMD Radeon R9 280 | AMD Radeon R9 280X | AMD Radeon R9 285 | AMD Radeon R9 285X |

| Straßenpreis | ab 165 Euro | ab 210 Euro | - | - |

| Homepage | www.amd.de | www.amd.de | www.amd.de | www.amd.de |

| Technische Daten | ||||

| GPU | Tahiti Pro | Tahiti XT | Tonga Pro | Tonga XT |

| Fertigung | 28 nm | 28 nm | 28 nm | 28 nm |

| Transistoren | 4,3 Milliarden | 4,3 Milliarden | - | - |

| GPU-Takt (Base Clock) | - | 1.000 MHz | 918 MHz | - |

| GPU-Takt (Boost Clock) | 933 MHz | 1.050 MHz | - | - |

| Speichertakt | 1.250 MHz | 1.500 MHz | 1.375 MHz | 1.375 MHz |

| Speichertyp | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Speichergröße | 3.072 MB | 3.072 MB | 2.048 / 4.096 MB | 2.048 / 4.096 MB |

| Speicherinterface | 384 Bit | 384 Bit | 256 Bit | 256 Bit |

| Speicherbandbreite | 240,0 GB/Sek. | 288,0 GB/Sek. | 176,0 GB/Sek. | 176,0 GB/Sek, |

| DirectX-Version | 11.2 | 11.2 | 11.2 | 11.2 |

| Shadereinheiten | 1.792 | 2.048 | 1.792 | 2.048 |

| Texture Units | 112 | 128 | - | - |

| ROPs | 32 | 32 | - | - |

| TDP | 250 Watt | 250 Watt | - | - |