Werbung

Am kommenden Donnerstag wird NVIDIAs neue GeForce GTX 780 Ti für empfohlene 699 US-Dollar in den Handel kommen. So viel hat die kalifornische Grafikschmiede bereits verraten. Nach den zahlreichen Spekulationen und den ersten Benchmarks am Wochenende, zeichnet sich ab, dass die Ti-Version der GeForce GTX 780 die lang ersehnte GeForce GTX Titan Ultra werden wird, vermutlich mit den vollen Shadereinheiten der GK110-Architektur ausgestattet sein wird und es so der AMD Radeon R9 290X, welche leistungsmäßig mit dem bisherigen NVIDIA-Flaggschiff gleichzog, schwer machen wird.

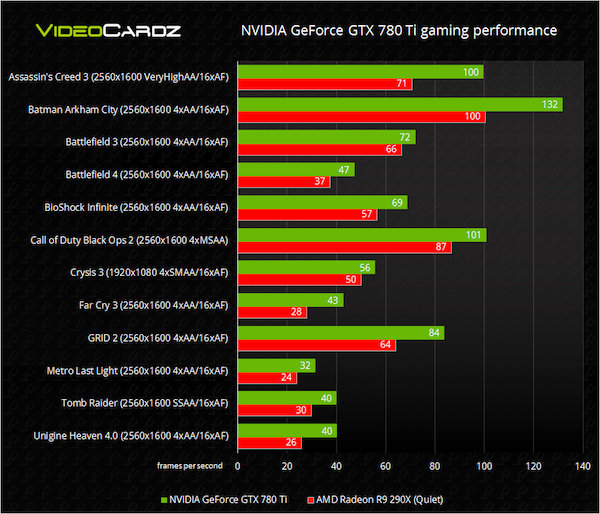

In der Vergangenheit hatten die Kollegen von Videocardz.com mit ihren zahlreichen Spekulationen und Benchmarks zu kommenden Grafikkarten im Nachhinein häufig Recht. Nun veröffentlichte man dort neue Benchmarks, die wohl direkt von NVIDIA stammen. Demnach ist die GeForce GTX 780 Ti tatsächlich deutlich schneller als die Radeon R9 290X. Zu beachten ist dabei aber, dass es sich um hersteller-eigene Benchmarks handeln dürfte und das Konkurrenz-Modell lediglich im Quiet-Mode und nicht im schnelleren Uber-Mode getestet wurde. Im Schnitt wäre der AMD-Gegner zwischen acht und zwölf Prozent schneller. Auch 4K-Benchmarks fehlen, verwendet wurde durchgehend eine Auflösung von 2.560 x 1.600 Bildpunkten. Als Test-Plattform kam ein Intel Core i7-3960X unter Windows 8.1 zum Einsatz. Treiberseitig wurden der Catalyst 13.11 Beta 8 und der GeForce 331.70 installiert.

Vor allem Spiele, in welchen NVIDIA PhysX vorantrieb, ist die NVIDIA-Karte deutlich schneller. Assassins Creed 3 und Batman: Arkham City sind klar eine NVIDIA-Domäne. Nicht ganz so groß fällt der Unterschied in Crysis 3, Metro: Last Light und Battlefield 3 aus. Im Schnitt liegt die NVIDIA GeForce GTX 780 Ti den Benchmarks zufolge etwa 20 Prozent vor der Konkurrenz. Der Vorsprung dürfte im Uber-Modus der AMD Radeon R9 290X auf etwa 13 Prozent schmelzen. In 4K-Benchmarks sollte die Radeon-Karte aufgrund des größeren Speicherausbaus etwas besser abschneiden.

Unabhängige Benchmarks dürften reihenweise am kommenden Donnerstag veröffentlicht werden. Dann kommt die neue NVIDIA GeForce GTX 780 Ti offiziell auf den Markt.