Werbung

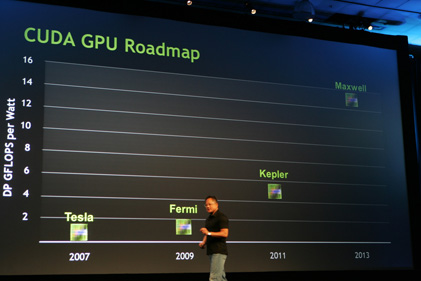

Auf der GPU Technology Conference 2010 gab NVIDIA bereits einen kleinen Ausblick auf seine kommenden GPUs und nannte dabei auch erste Codenamen (wir berichteten). Den damaligen Plänen zufolge sollte im Jahr 2011 der Fermi-Nachfolger Kepler erscheinen - gefolgt von Maxwell im Jahr 2013. Die nächste Generation sollte dabei zwischen 4 und 6 GFLOPS Dual-Precission-Performance pro Watt erreichen und im zweiten Quartal 2011 als Prototyp zur Verfügung stehen. Dies ließ NVIDIA-Chef Jen-Hsun Huang damals höchstpersönlich verlauten. Wie die stets gut bediente Gerüchteküche Fudzilla.com nun erfahren haben will, soll Kepler jetzt sein TapeOut hinter sich gebracht haben. Im Klartext heißt dies, dass NVIDIA einen wichtigen Meilenstein in der Entwicklung seines kommenden Grafikchips erreicht hat und dessen Entwicklung damit zum Abschluss gebracht hat. Sollten die jetzt anstehenden Tests allerdings noch Fehler im Design aufdecken, so kann es noch ein weiteres TapeOut geben. Fallen die Tests aber positiv aus, könnte NVIDIA schon in den nächsten Monaten die Massenproduktion starten. Laut Fudzilla.com soll die kommende 28-nm-GPU in etwa die gleiche TDP besitzen, wie das aktuelle Flaggschiff der Kalifornier.

Optimistisch betrachtet könnte Kepler, der rund 10x schneller als Fermi sein soll, schon im vierten Quartal 2011 auf den Markt kommen. Da der Auftragsfertiger TSMC wohl aber noch ein bisschen mehr Zeit für die filigranere Chipproduktion benötigen könnte, könnte die NVIDIA-GeForce-GTX-600-Familie - oder wie sie auch immer heißen mag - auch erst im nächsten Jahr ins Rennen geschickt werden.

Durch Klick auf das Bild gelangt man zu einer vergrößerten Ansicht

Update

Wie Fudzilla.com weiter berichtet, könnte NVIDIA Kepler zwar schon im vierten Quartal auf den Markt werfen, doch seien die Auftragsfertiger zu diesem Zeitpunkt schlichtweg noch nicht bereit, die Massenfertigung von 28-nm-Chips stemmen zu können. Demnach soll NVIDIAs nächste Grafikkarten-Generation erst während des ersten Quartals 2012 vorgestellt werden. Sollten die Gerüchte aber zutreffen, wird man zumindest noch in diesem Jahr einen kleinen Ausblick auf die Architektur geben, schließlich sollen die Modelle der Konkurrenz noch innerhalb der nächsten fünf Monate erscheinen (wir berichteten).

Weiterführende Links: