Werbung

NVIDIA hat sich für die diesjährige Pressekonferenz auf der Consumer Electronics Show das Thema Automotive als Schwerpunkt der Pressekonferenz auserkoren. Tausende Entwicklungsstunden hat NVIDIA in die Soft- und Hardware dazu in den vergangenen Monaten gesteckt und die ohnehin schon offensichtlichen Ambitionen in diesem Segment weiter unterstrichen. Software, Hardware und die Möglichkeiten des Deep Learning spielen dabei eine besonders wichtige Rolle.

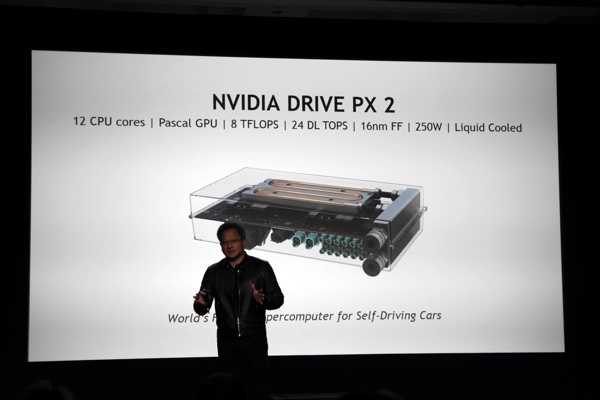

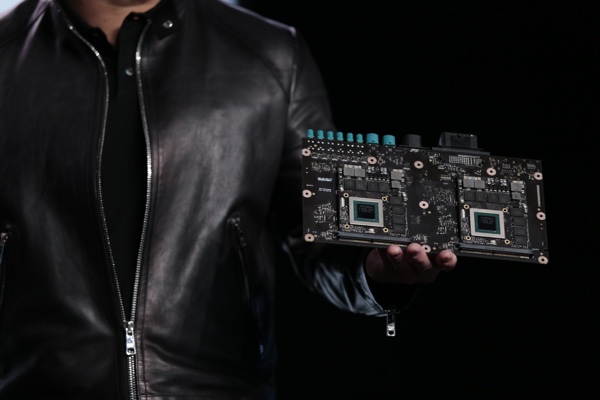

Heute neu vorgestellt wurden Drive PX 2. Dabei handelt es sich um eine Hardware-Modul in der Größe einer Lunchbox, welche die notwendige Rechenleistung aufbringen soll, um eine selbstfahrendes Auto möglich zu machen. Dieses Versprechen wurde zwar bereits mit früheren Versionen gegeben, allerdings kann ein selbstfahrendes Auto mehr und mehr Rechenleistung verwenden, um sicher und schnell an das Ziel zu gelangen. Drive PX 2 verwendet 12 CPU Cores, besonders entscheidend aber dürften die GPUs der Chips sein, die auf der Pascal-Architektur basieren, die bisher noch nicht in allen Details offiziell vorgestellt wurde.

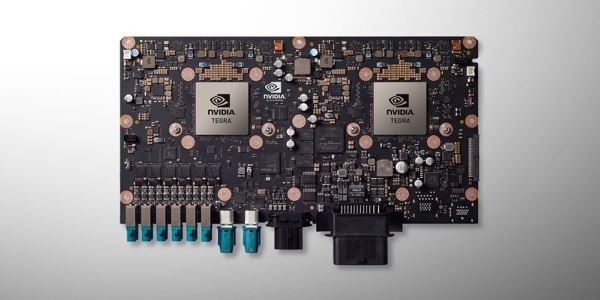

Auf dem Chip befinden sich acht CPU-Kerne (ARM Cortex A57) plus vier Kerne mit der eigenen Denver-Architektur. Auf der Rückseite der Tegra-Prozessoren befinden sich die Pascal-GPUs - ein Drive-PX-2-Modul verwendet jeweils zwei Tegra-Prozessoren und zwei GPUs. Der Tegra-Chip dürfte auf den Codenamen Parker hören. Die Rechenleistung soll bei 8 TFLOPS liegen und damit liegt Drive PX 2 auf Niveau aktueller High-End-GPUs im Desktop-Bereich - eine GeForce GTX Titan X liefert eine ähnliche Rechenleistung. Für Deep-Learning-Netzwerke spricht NVIDIA von 24 Teraoperationen pro Sekunde, die ausgeführt werden können. Gefertigt wird die GPU in 16 nm mit FinFET-Transistoren. Damit schließt NVIDIA in dieser Hinsicht mit AMD auf, die erste heute die Polaris-Architektur mit neuer Fertigungsgröße vorgestellt haben, die Mitte des Jahres in ersten Produkten zu haben sein soll. Auch wenn Pascal die Unterstützung von HBM nachgesagt wird, so verwendet die auf Drive PX 2 verbauten GPUs offenbar GDDR5-Speicher, wie auf den Bildern deutlich zu erkennen ist. Bisher ist nur bekannt, dass die Pascal-Architektur auf Mixed Precision, NVLink und HBM setzen wird.

Allerdings hat die erwähnte Rechenleistung auch ihre Kehrseite, denn die Leistungsaufnahme und damit Abwärme beträgt 250 W. Um diese Abwärme abführen zu können, verwendet NVIDIA für Drive PX 2 eine Wasserkühlung. Diese muss beim Platzbedarf des eigentlichen Drive-PX-2-Moduls zusammen mit Pumpe und Radiator natürlich mit bedacht werden. Für rein elektrische Fahrzeuge ist eine Wasserkühlung zur Kühlung der Akkus meist ohnehin vorgesehen, so dass ein Drive-PX-2-Modul einfach darin eingebunden werden könnte.

Nicht unerwähnt lassen will NVIDIA aber einmal mehr, dass das Training der Deep-Learning-Netzwerke nicht auf dem mobilen Modulen wie Drive PX 2 erfolgt, sondern in Rechenzentren, die ebenfalls weiterhin auf leistungsstarke GPUs angewiesen sind. Die GPU Technology Conference im vergangenen Jahr behandelte dieses Thema ausführlich.

Mit NVIDIA Drivenet hat das Unternehmen sich eine eigene Testplattform geschaffen, welches vom Deep-Learning-Netzwerk bis zum Drive PX 2 alle Schritte beinhaltet. Das Deep-Learning-Netzwerk besteht dabei aus neun Inception-Layern, 37 Millionen Neuronen und 40 Milliarden Operationen, die auf einem DIGITS-System erstellt wurden. Dazu gab es auch eine Livedemo auf der Bühne, denn das Netzwerk kann in Echtzeit weiter antrainiert werden. Die initialen Daten werden auf 170 Millionen Bildern erstellt, die selbst auf einer schnellen Deep-Learning-Hardware fast einen Monat zur Analyse benötigte. Ohne GPU-Beschleunigung hätte dies vermutlich mehrere Jahre gedauert. In einem zweiten Schritt werden diese Daten um weitere Modelle erweitert, so dass neben einfachen Objekten auch Unterschiede zwischen Fußgängern, Autos, Fahrrädern, Verkehrszeichen gemacht werden können. Dabei lernt das System selbstständig die Unterschiede zu erkennen und weiß daher auch mit einer unterschiedlichen Gewichtung damit umzugehen. So sind stehen Objekte weniger eine Gefahr als Fußgänger, die sich auf die Fahrbahn bewegen.

{jphoto image=88858}

Um den Entwicklern die Arbeit zu erleichtern bietet NVIDIA ab sofort auch ein Software-Developer-Kit an. DriveWorks bündelt die zur Verfügung stehenden Software-Ressourcen und vereinfacht die Zusammenarbeit mit der dazugehörigen Hardware. In einer Art Referenzsystem wird hier ein Fahrzeug mit sechs Kameras und weiteren Sensoren simuliert. Alleine die Sensoren liefern dabei 1,6 Millionen Messwerte pro Sekunde. Hinzu kommt die Bildanalyse der sechs Kameras.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Um das Vertrauen in selbstfahrende Fahrzeuge zu stärken, hat NVIDIA eine Visualisierung entwickelt, welche die durch Drive PX 2 gewonnen Erkenntnisse per Drive CX auf dem Infotainment-System anzeigen kann. Auf einer virtuellen Windschutzscheibe können die realen Bilder der Kameras sowie die Sensor-Analyse direkt miteinander verglichen werden.

Als erster Fahrzeughersteller soll Volvo Drive PX 2 verbauen. In welchen Fahrzeugen und wann dies der Fall sein wird, wollte NVIDIA aber nicht weiter ausführen.

Update:

Noch ein kleines Update mit weiteren Details bzw. Einschätzungen zur Rechenleistung der beiden Pascal-GPUs auf dem Drive PX 2. Auf den Bildern sind pro GPU jeweils acht GDDR5-Speicherchips aus dem Hause Elpida zu sehen. Über die Kapazität der einzelnen Chips können wir aber keine Angaben machen. 8 GB dürften es aber sein.

Etwas verwirrend sind die Angaben zur Rechenleistung. Einerseits spricht NVIDIA von 8 TFLOPS Gesamtrechenleistung für Drive PX 2. Andererseits aber ist auch von 24 Deep-Learning-Teraoperationen pro Sekunde die Rede – eine recht ungewöhnliche Angabe für die Rechenleistung. Die dahinterstehenden Berechnungen werden vermutlich ausschließlich auf der GPU ausgeführt. Pro GPU wären dies demnach 12 DL TOPS. Da es sich dabei um einfache FLOPS (Floating-Point Operations per Second) handeln sollte, passt dies aber nicht mit der Angaben der Gesamtrechenleistung zusammen.

Vermutlich erreicht NVIDIA durch Mixed Precision, also die Möglichkeit FP32-Kerne auch dazu nutzen zu können, jeweils zwei FP16-Berechnungen durchführen zu können. Dazu werden FP16-Berechnungen zusammengelegt, damit sie auf FP32-Kernen ausgeführt werden können. Damit die FP16-Berechnungen zusammengelegt werden können, müssen sie allerdings die gleichen Operationen ausführen. Zum Beispiel können nur zwei Additionen oder zwei Multiplikationen zusammengeführt werden. Für die Video- bzw. Bildanalyse sind solche FP16-Berechnungen im hohen Maße wichtig und könnten daher bei Pascal eine besonders wichtige Rolle spielen. Vermutlich erreicht NVIDIA daher auch in Deep-Learning-Netzwerken die besonders hohe Rechenleistung.

Am Donnerstag haben wir einen Termin mit NVIDIA und werden versuchen noch einige weitere Details in Erfahrung zu bringen.

2. Update:

Abgesehen von der Pascal-GPU sind einige Besonderheiten bei dem von NVIDIA auf dem Drive-PX-2-Modul verwendeten Tegra-SoC auffällig. Während Tegra X1 jeweils vier Cortex-A53- und Cortex-A57-Kerne verwendet, sind es auf dem "Tegra P1" – so wollen wir ihn angelehnt an die bisherige Namensgebung einmal nennen – vier Kerne auf Basis des Cortex-A57 und zwei weitere Denver-Kerne. Die Denver-Kerne dürften mit denen des Tegra K1 identisch sein. Bereits erwähnt haben wir die Möglichkeit, dass es sich beim Tegra P1 um den Parker-SoC aus den vergangenen Roadmaps handelt, auch wenn dieser die Maxwell-Architektur für die GPU verwenden sollte und wir nun offensichtlich ein Zusammenspiel mit einer Pascal-GPU sehen, die sich aber außerhalb des SoC-Package befindet, was ebenfalls bemerkenswert ist.

Da sich NVIDIA aktuell aber nicht weiter zur verbauten GPU äußern möchte, schauen wir uns die CPU-Konfiguration noch einmal etwas genauer an. Vier Cortex-A57-Kerne und zwei Denver-Kerne sind eine Kombination, die wir so noch nicht gesehen haben. NVIDIA muss eine Art eigenen Interconnect verwenden, um diese CPUs zur Zusammenarbeit zu bewegen. Ein ARM CoreLink CCI kommt eigentlich nicht in Frage, da dieser auf die Zusammenarbeit mit den eigenen CPU-Kernen abgestimmt ist. Die Frage ist aber vielmehr, warum NVIDIA vier schnelle Cortex-A57- mit zwei ebenfalls schnellen Denver-Kernen kombiniert. Vermutlich will NVIDIA hier den verschiedenen Anforderungen an einen CPU-Kern gerecht werden, denn hinsichtlich der Single-Threaded-Performance gehören die Denver-Kerne zu den schnellsten aktuellen Implementierungen. Denkbar wäre auch, dass die meisten Prozesse auf den Cortex-A57-Kernen laufen und die beiden Denver-Kerne nur eine Art Co-Prozessor sind. Weitere Details hierzu stehen aber noch aus.