Die Daten die aktuell gelesen werden, wurden vor ca. 2 Jahren dort abgelegt. Also ich finde, das das darf doch nicht sein.

Das passiert halt bei TLC (und QLC) NAND, wenn die Daten nicht rechtzeitig refresht werden und deshalb die langsame LDPC Fehlerkorrektur statt der schnelle BCH ECC verwendet werden muss. Es gehen eben mit der Zeit Elektronen aus den Zellen verloren und dann ist es schwerer den korrekten Ladezustand der Zellen zu erkennen und genau dafür ist die LDPC Fehlerkorrektur ja da. Sonst könnte man diese Daten gar nicht mehr Lesen und dagegen ist es besser sie wenigstens langsam Lesen zu können. Noch besser wäre es natürlich, wenn die FW der SSD erkennen würde, welche Daten schon so alt sind, dass dies passieren wird und diese dann intern umkopiert, also eben Refresht.

wo der Unterschied der Ultra 3d mit Version -g30 und der -g25 liegt. Vielleicht hat das mit neuer FW oder sonstigen Funktionen zu tun, die das lesen alter Daten beschleunigen?

Kann sein, aber wahrscheinlich hat die neuere Version einfach nur NAND einer neueren Generation, denn die Ultra3D ist ja schon länger auf dem Markt und die damals verbauten NANDs werden vermutlich gar nicht mehr gefertigt bzw. wären im Vergleich zur aktuellen Generation zu teuer:

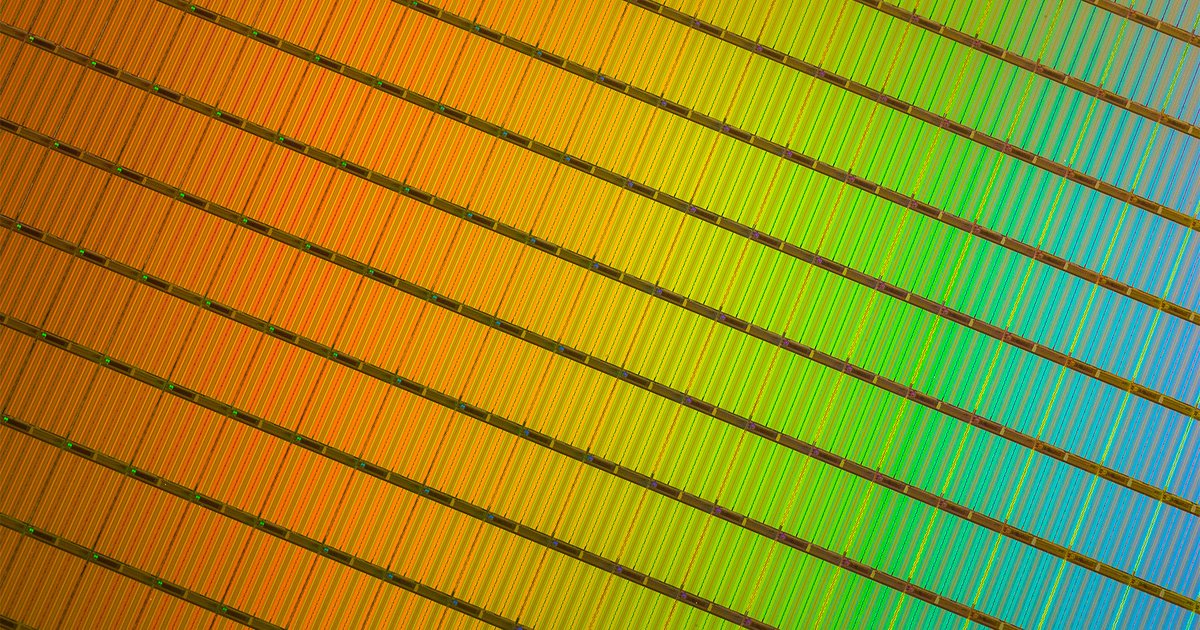

Derzeit ist BiCS 5 mit 112 Layern das aktuelle NAND und wird in immer mehr SSDs BiCS4 ersetzen, BiCS 6 mit 162 soll im nächsten Jahr in Massenfertigung gehen. Vergiss nicht, dass es das Hauptziel bei der Weiterentwicklung von NAND ist die Kosten zu senken und daher die neuste NAND Generation immer auch die günstigste ist, sobald die Produktion richtig in Gang gekommen ist.

Das kommt auf die Qualität des Flashs an. In Consumer-SSDs wurde der letzte Dreck verbaut

Das mag bei einigen SSDs von Anbietern ohne eigene NAND Fertigung so sein, aber so generell ist diese Aussage schlicht falsch! Die am besten gebinnten NANDs gehen zwar in die Enterprise SSDs, aber die NANDs für Consumer SSDs sind zumindest bei denen mit eigener NAND Fertigung schon von einer ausreichend hohen Qualitätsstufe und der letzte Dreck darunter wird dann eben extern verkauft und ist eben für anderen Anwendungen wie billige Smartphones oder auch Spielzeuge gedacht. Micron verkauft solche über seine Restrampe Spectek:

Das hatten vor nicht einmal einem Jahr

hier schon einmal und da Scour "Vielleicht reiner ZUfall, aber bei meiner Supertalent ist Spectek TLC verbaut". Und es gibt auch andere SSDs in denen Spectek NAND steckt, meisten erfährt man aber gar nicht mehr welches NAND verbaut ist, weil die SSD Anbieter eigene Label auf die Chips machen lassen.

Das ist Sondermüll! Ich habe hier geschrieben "Elektronen verdampfen" oder verdunsten. Das ist fehlerhafte Konstruktion der Chips oder dreckiges Material oder eben Ausschuss für die Consumer.

Das ist wie gesagt Quatsch, die Konstruktion der Chips ist für alle NANDs der gleichen Generation wie eben z.B. aktuell BiCS 5 gleich und wenn es da "dreckiges Material" geben würde, dann sind die alle Ausschuss, wie es ja gerade bei Kioxia/WD passiert ist:

Severely impacting NAND supplies, which could cause prices to rise

www.datacenterdynamics.com

Was das mit dem "Ausschuss für die Consumer" angeht, s.o., ja gibt es, aber ich erwarte von den SSDs der NAND Hersteller und ihrer Tochterfirmen schon, dass sie da wenigstens Tier2 NAND verbaut haben und dies ist kein Ausschuss, meist ist sogar Tier 1 NAND verbaut, welches man am Logo des Hersteller erkennt, denn Tier2 hat meist nur Nummern auf dem Chip.

Schmeißt solche Dinger in die Tonne. Deshalb habe ich seit vielen Jahren auf NVMe gewartet.

Das ist doch totaler Blödsinn und hat rein gar nichts mit dem Protokoll zu tun, Ob SATA oder NVMe ändert gar nichts an der Problematik, dass die NAND Zellen eben mit der Zeit Ladung verlieren, je mehr umso wärmer sie sind, die NAND der meisten M.2 NVMe SSDs dürften im Betrieb wohl wärmer als die NANDs der meisten SATA SSDs sein und das dann eben die BCH ECC ggf. nicht mehr reicht und die langsame LDPC verwendet werden muss, bei der werden u.a. die Zellen mehrfach mit unterschiedlichen Parametern ausgelesen und schon deshalb dauert LDPC länger und entsprechend ist die Lesegeschwindigkeit eben geringer. Dies kann man nur vermeiden, wenn man keine SSDs mit TLC oder QLC NAND kauft, nur gibt es zumindest im Consumersegment praktisch keine anderen SSDs mehr und selbst bei den Enterprise SSDs gibt es meines Wissens nach nur noch die Samsung Z-SSDs mit SLC und schon lange keine neuen Modelle mehr mit MLC NAND, aber die Z-SSDs kosten ähnlich viel wie Intels Optane DC Modelle.