(Irgendwelche Register haben wohl die meisten CPUs oder Controller? Wie groß?)

Wie groß das RAM oder die Register oder was immer der Kerne im Sandforce sind, sagt Sandforce nicht, aber einige MB müssen es schon sein, sonst könnte der ja keine größeren Datenvolumen cachen und das macht er ja, wenn Du Dir die 4k Schreibend mal ansiehst. Außerdem werden die Daten noch komprimiert, was auch nur im RAM passieren kann, wenn man überlegt, dass ja ein Datenstrom von mindestens 550MB/s in Echtzeit komprimiert wird.

Was ein Controller ohne eine größere Menge RAM schafft, sieht man an den Benchmarks von SSDs mit altmodischen Controllern, wie diese SandDisk aus dem Mediamarkt. Oder schau Dir mal die 4k schreibend der meisten USB Sticks an, da geht es direkt ins NAND und wir reden i.d.R. von 0.001 bis 0.01 MB/s.

Eine Crucial m4 oder Plextor M3S schaffen ohne Schreibcache nur wenige MB/s bei 4k Schreiben.

http://www.bswd.com/FMS10/FMS10-Werner.pdf

Mein Gott, das ist halt das, was ich aus Werbedokus herauslese und mir mühsam zusammenvermute.

Dann solltest Du aber Deine Quellen besser auswählen und nicht allzu ernst nehmen, was das Marketing erzählt.

Du musst nicht alles konfrontationsmäßig zerpflücken - wenn du bessere Infos hast, dann verlinke sie bitte hier.

Wie schon gesagt, es gibt wenig technische Dateils über die Sandforce, so wie es auch über anderen SSD Controller und selbst die NANDs kaum etwas öffentlich gibt.

Mapping Strategies for Integrity and Availability

1. Full Map resident in Flash – Best Approach...

Deswegen sind die IOPS bei den Sandforce ja auch teils deutlich geringer, wenn diese über 85% der Kapazität gemessen werden und nicht nur über 8GB. Bei AS-SSD kommt der deswegen auch so gut weg, weil der die IOPS sogar nur über GB misst. Andere Controller nutzen das RAM ja vor allem um die Mappingtabellen dort zu cachen (im NAND muss es sowieso immer auch aktuell stehen, sonst wären die Daten weg, wenn der Strom plötzlich ausfällt).

Lies mal anands

"The Indirection Table" aus "The Intel SSD DC S3700: Intel's 3rd Generation Controller Analyzed" by Anand sowie die nachfolgende Seite

"The New Indirection Table". Dann wird Dir auch klar, warum die SSD Reihe bei mehr Kapazität auch mehr RAM verbaut haben, etwas was beim Sandforce nicht möglich ist und deshalb sind die SF-2281 mit 480/512GB auch langsamer als die mit 240GB, da passt einfach noch weniger von den Daten ins RAM, die man braucht um das Mapping zu realisieren.

Und irgendwo kam zum Ausdruck, dass die eingehenden Benutzerdaten direkt in komplett freie Zellen geschrieben und erst später 2 Pages zusammengefügt werden, ohne DRAM-Cache. Als Vorteil wurde genannt, dass dadurch keine Userdaten (erst mal) verloren gehen könnten.

Alles Werbelügen. Das kann so nicht gehen, denn wie sollen dann bitte die Daten komprimiert werden? Das kann man zwar in kleinen Portionen machen, aber eben nicht ohne diese in einem RAM (oder einer Unmenge Registern) zwischenzuspeichern. Wieso Sandforce nicht zugibt RAM zu verwenden, verstehe ich beim besten Willen ist. Der Controller hat doch auch nur irgendwelche lizenzierten Kerne wie z.B. die von ARM (die werden bei den meisten Controllern verwendet) und keine Eigenentwicklungen drin. Dazu wäre ein Startup wohl auch kaum in der Lage gewesen.

Wenn dann später beim Zusammenfummeln zweier Pages der Strom weg ist, dann...Jedenfalls hat meine Intel 330 mit Sandforce ein heftiges Problem mit der Energieeinsparung unter W7, das seit Jahren von Sandforcees bekannt ist.

Was die da wie zusammenfummeln, kann ich nicht sagen, aber wenn die auch nur das erste Bit beschreiben und dann die Daten noch mal umkopieren würden, dann müsste da eine viel, viel bessere Schreibrate bei rauskommen. Das der Sandforce Probleme mit dem Energiesparen hat, ist ja auch logisch, der macht einfach zu viel im Idle. Denn anders als die meisten Controller, räumt der Controller ja im Idle einen Teil der NANDs frei, so viel wie ab Werk als Free Area vorhanden ist, weshalb die Schreibrate auch nach einigen Stunden im Idle wieder auf den Normalwert ansteigt, wenn man in kurzer Zeit mehr geschrieben hat als eben in diese Free Area passen und der Controller somit im Recovery Mode ist.

Der Sandforce räumt dann zwar die Blöcke frei, löscht sie aber erst, wenn sie tatsächlich beschrieben werden, was höhere Lebensdauer ergeben soll (reine Werbeaussage). Das würde eine geringer Write Amplification erfordern, aber die WA ergibt sich ja daraus, dass noch gültige Daten kopiert werden müssen, die in Blöcken stehen die gelöscht werden sollen. Wenn es solche Daten nicht gibt, dann gibt es auch keine WA und somit keine Nachteile für die Lebensdauer. Warum der Sandforce die Blöcke trotzdem nicht dann löscht wenn keine gültigen Daten mehr drin, so wie andere Controller es machen und dadurch die volle Schreibrate wie im Neuzustand erhalten, kann ich auch nicht nachvollziehen, jedenfalls bekommt der Kunde nach dem erstmaligem Beschreiben alles Pages die volle Schreibrate beim Sandforce nur durch ein Secure Erease zurück.

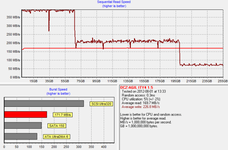

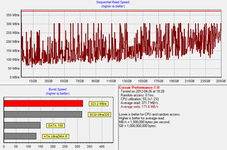

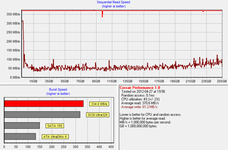

"Write speed drops to as low as 25MB/s," Das sehe ich aber in _der_ Grafik nicht. Ich sehe dort überhaupt keine Kurve bezüglich SEQUENTIAL WRITE SPEED.

Es gibt da mehrere Kurven, i.d.R. einmal neu, einmal gefoltert (was so bei normalen System nicht kommen wird) und dann wieder nach TRIM. Die 25MB/s gibt es nur bei gefolterten SSDs und da kann es auch nicht anders sein, denn überlege doch mal, was da passiert:

Die SSD wird vollgeschrieben und dann werden die LBAs noch mal eine ganze Weile mit Random Writes überschrieben, da bleibt also kein freier Plate und Daten der einzelnen LBAs sind wild im NAND verstreut. Dann gibt es wohl i.d.R. eine Pause (leider wohl nicht immer und nicht immer gleich lange) und die LBAs werden sequentiell überschrieben. In der Pause kann der Controller etwas aufräumen, denn Daten werden ja durch zwei Bedingungen ungültig:

1. Der LBA zu dem gehörten wird überschrieben

2. Der LBA zu dem gehörten wird getrimmt

In dem Test wird da noch nichts getrimmt, erst im letzten Teil des Tests. Daher ist die ganze nutzbare für den Controller voller gültiger Daten und wenn nun wieder geschrieben wird, dann beschreibt es idealerweise erst mal seine Free Area, die im vorher leergeräumt hat. Dann aber muss der Controller beim Schreiben Platz schaffen, also Blöcke auswählen die möglichst wenige Pages mit noch gültige Daten enthalten, diese noch gültigen Daten in den Pages der zuletzt gelöschten Blöcke kopieren (womit weniger Platz für die neuen, zu schreibenden Daten bleibt) und diesen Block dann löschen. Dabei bricht die Schreibrate natürlich ein, denn dauert das Kopieren der Daten sowie das Löschen der Blöcke seine Zeit und dann sind die gerade gelöschte Blöcke ja auch schon wieder gut gefüllt. Zumindest am Anfang, wenn noch nicht so viele LBAs überschrieben wurden, mit der Zeit werden ja immer mehr LBAs überschrieben und damit auch immer mehr alte Daten ungültig, so dass immer weniger kopiert werden müssen, die Schreibrate steigt also wieder an.

Idealerweise sieht es dann genau so aus,

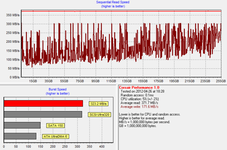

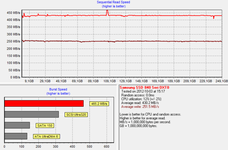

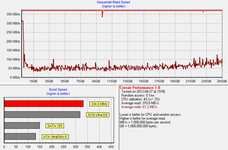

wie bei der Cruicial m4 mit der FW 0009:

Eine SSD die sich so verhält ist auch optimal für den Einsatz ohne TRIM geeignet (also etwa an einem RAID Controller), denn der Controller räumt ja den freien Platz gut auf und kann entsprechend ein paar GB schnell schrieben. Dann muss man sich nur entscheiden, wie viele GB mal so schnell schreiben können will und eine entsprechenden Teil der Kapazität unpartitioniert lassen, damit der Controller immer entsprechend viel Free Area zu Verfügung hat.

Vorhin habe ich geschrieben, das der Controller zuerst seine Free Area beschreibt, die er es idealerweise vorher leergeräumt hat. Das sieht man bei

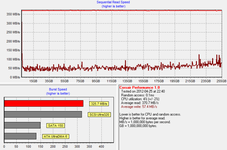

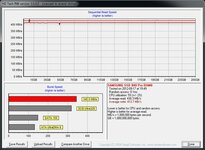

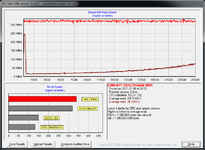

Anands Test der Corsair Performance Pro sehr gut. Da sieht man auch, wie genau das passiert was ich oben beschrieben habe, denn zuerst hat er die viel zu kurz gefoltert und so eine Kurve bekommen:

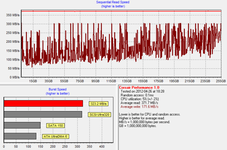

Wenn wenn da die Schreibrate so hoch ist, dann war da die Daten praktisch so nacheinander im NAND wie sie auch in den LBAs stehen, weil da keine oder wenig Radom Writes auf die LBAs erfolgt sind und somit beim Überschreiben gleich ganze Blöcke ungültig wurden, also nichts zu kopieren war. Das wäre schon so der Worst Cace für Heimanwender ohne TRIM. Dann hat er sie länger gefoltert und sofort seq. Überschrieben:

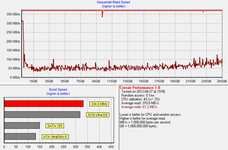

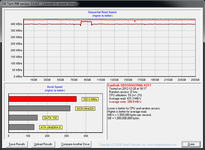

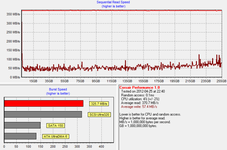

Dann noch mal die gleiche Folter, aber zwischen Folter über dem Test (seq. Überschreiben) waren diesmal 40 Minuten Pause:

Siehst Du den Unterschied? Anand hat ihn wohl nicht erkannt, denn er geht im Test nur auf die 4MB/s Unterschied ein. Die sind doch belanglos, die abfallende Flanke in der Kurve der Schreibrate macht den Unterschied! Das ist das Ergebnis der Aufräumarbeit des Controllers im Idle, wo er sich Platz geschaffen hat um wieder so viel Daten schnell schreiben zu können wie er Platz frei hat. Das ist das wichtige bei dem Test, nicht es im schlimmsten Fall auf 25MB/s oder 35MB/s runter geht, da will man sowieso nicht hinkommen! Da kommt man auch nie hin, wenn man nie mehr Daten am Stück schreibt, als der Controller freien Platz (und Zeit) zum Aufräumen hatte. Beide fehlt ihm normalerweise nur, wenn man große Dateien nicht löscht (und die LBAs getrimmt werden) sondern überschreibt (wobei ja keine TRIM Befehle ausgelöst werden).

Wenn ich jetzt keine Tomaten auf den Augen habe, dann würde ich sagen, das sind alles nur bezahlte Schönwetter-Auftrags-Gefälligkeitstests.

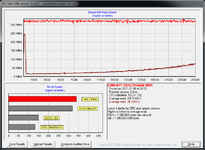

Du hast Tomaten auf den Augen, es gibt i.d.R. immer 3 Screenshots von HDTach bei Anands TRIM Performance Test in SSD Reviews, einmal den im Neuzustand, dann den unter Folter (also wie oben beschrieben) und am Ende den nach TRIM. Beim ersten und letzten sieht man idealerweise nur zwei gerade Linien, wobei die dunkelrote die Schreibrate zeigt und die hellrote die Leseraten. Da HD Tach wohl nur bis 400MB/s benchen oder anzeigen kann, sind beide oft bei etwa 400MB/s begrenzt, denn HD Tach ist eben kein SSD Tool und auch schon recht alt.

Hm, ich weiß nicht...Ich sehe da keine Grafik des Vollschreibens einer SSD. Siehst Du eine?!

Jeder der Anhänge in diesem Post zeigt so eine Kurve, es geht von Links nach rechts einmal über die ganze Nutzkapazität der SSD.

Harte und "gemeine" Schreibtests findet man eher auf Enterprise-Websites als in Consumerforen.

Sowas interessiert da niemanden, denn die schreiben nicht sequentiell auf die SSDs sondern fast nur Random, aber massiv parallel und ohne Pause. Darüber findest Du was in

"Exploring the Relationship Between Spare Area and Performance Consistency in Modern SSDs und bei den Performance Consistency Tests von Anands letzten SSD Reviews.

"Die Studie deutet an, dass Hersteller Verschleißteile in ihre Geräte einbauen, um frühzeitig, aber möglichst nach Ablauf der Garantiezeit, Defekte auszulösen."

Deshalb will ich 5 Jahre Garantie.

Bei Computerhardware wird man sowas kaum brauchen, denn die ist nach Ablauf der Garantie sowieso veraltet und wird ersetzt. Ansonsten ist das Thema uralt und es gab schon in den 30er Jahren des vorherigen Jahrhunderts in den USA eine entsprechende Gesetzesinitiative die das sogar vorschreiben sollte um die Wirtschaft aus der Depression zu bekommen. Daraus wurde nicht und erst der 2. Weltkrieg hat der US-Wirtschaft einen starken Aufschwung beschert, denn bei Waffen und Munition brauchte man sowas nicht einzubauen um die Nachfrage zu steigern.

e

e fficial&client=firefox-

fficial&client=firefox-

Vertex4 128GB + 1TB /\ 840pro 128GB + 1TB /\ Samsung 840 250GB ohne zusätzliche HDD

Vertex4 128GB + 1TB /\ 840pro 128GB + 1TB /\ Samsung 840 250GB ohne zusätzliche HDD