Und USB ist alles andere als zuverlässig ..... Hatte mal auf einigen USB3 Storages VMs laufen .... keine gute Idee....

Naja, auf eine mit USB3 angeschlossene Platte gleich den VM-Storage laufen lassen… Stimme ich dir zu, "keine gute Idee". 🙃

Doch es ging darum, eine Boot-Platte dran anzuschließen? Als Alterantive zum onboard-USB2-only Anschluss? Dann finde ich das durchaus eine praktikable Idee. Ich mein, bei einem 4-Kern-System will man ja vermutlich einen davon für das ESXi/Proxmox/wasauchimmer bestimmen – dann hat man "Platz" für drei Systeme. Höchstens. (Ich schließe Overprovisioning mal aus, wenn "USB3 ist nicht zuverlässig genug" im Raum steht.)

Selbst wenn man sich richtig reinhängt und eine andere/bessere CPU und SSD-RAID (mit dediziertem Controller, natürlich) reinmacht: Ganz ehrlich, fängt dann nicht der Schuh woanders an zu drücken? 1GB-Anschlüsse? Stromversorgung? Wenn man … sagen wir 6-8 Maschinen auf dem Gen10+ virtualisieren will, dann hat man doch ganz andere Probleme als "die Boot-Platte hängt an USB3" – oder verstehe ich was falsch?

Ganz ehrlich, ich überlege schon eine 6-Kern/12-Threads CPU zu kaufen (drüber würde ich nicht gehen, wegen begrenztem Strom-Budget) – was ich dann da drauf virtualisieren würde, dürfte dann aber nicht nur einen Thread haben. Ich hätte viel lieber VMs mit 1-Kern/2-Threads: Daraus folgt, dass selbst mit einer solchen CPUs maximal 5 VMs drauf liefen. Und dann … wenn's doch nur 4 sind, dann könnte jede VM einen dedizierten SATA-Anschluss und einen dedizierten GB-Link zugewiesen bekommen. Folge ich dieser Logik, dann scheint das Bild ja zu passen. Es fehlt "nur" der LAN-Anschluss für den Hypervisor – oh schau mal, da ist ja einer beim iLO drauf! 😊 – und ein Anschluss, um das Hypervisor-Medium zu booten.

Womit sich der Kreis schließt: Ich teile die Meinung, dass Onboard-USB2 (viel) zu schlecht ist (und m.2 schon cool gewesen wäre), aber der Workaround mit USB3 finde ich … akzeptabel. Zumal ich beim Hypervisor nicht erwarte bzw. eigentlich verlange, dass der nicht so viel Daten schreibt.

Würden da nicht für die meisten unter uns diese 2.5G oder 5G USB3 Adapter ausreichen?

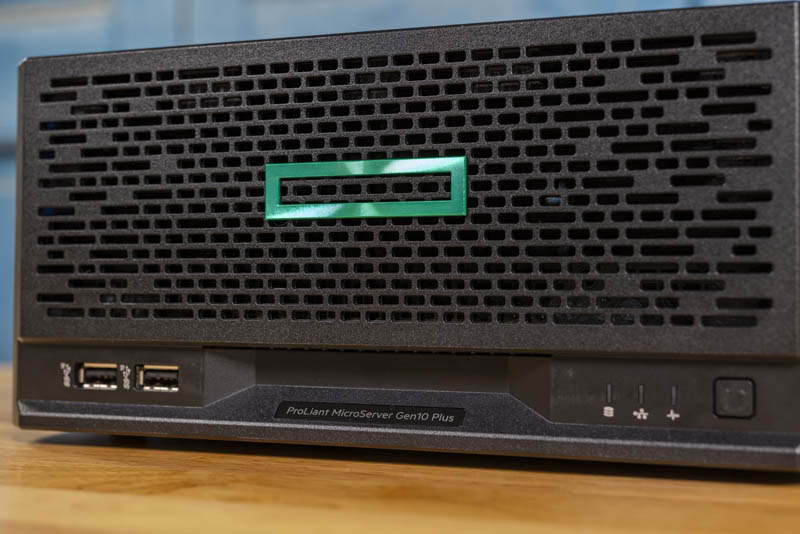

That's the spirit: Brauchst man wirklich >7 VMs zuhause? 😜 Wobei, stopp, anders gefragt: Wenn jemand >7 VMs zuhause braucht, dann ist eher die Frage: Warum ein Microserver? Offenbar ist eine solche Person auf der Suche nach mehr als nur Gigabit. Oder 8-Kern-CPUs. Oder nur einem PCIe-Steckplatz. Oder mehr als 180W. 😊