Hallo liebe Hardwareluxx Community,

zu aller erst vielen Dank dafür, dass ich die Möglichkeit erhalte habe ein nagelneues Produkt von Synology so kurz nach dem Marktstart testen zu dürfen.

Hinweis zum Review: Die Bilder sind von meinem Server verlinkt, da ich hier im Forum nicht genug hochladen konnte, sollte aber flott laden

Begonnen am PC meines Vaters, meinen ersten eigenen PC mit 10 Jahren, kurze Ausflüge in die Linux-Welt, meinen ersten selbst zusammengebauten Rechner, ein Studium in technischer Informatik inkl. Abschluss und schlussendlich dann meine Berufung zum Beruf gemacht. In dieser ganzen Zeit konnte ich dabei einiges Wissen in vielen Gebieten der IT sammeln.

Als ich für den Lesertest ausgewählt wurde hat mich das sehr gefreut, da mein bestehendes Synology DS220+ inzwischen aus allen Nähten platzt da es sowohl für den Produktivbetrieb als auch für meine Backups zuständig ist. Außerdem interessiert mich die neue Backuplösung grundsätzlich um meinen Wissensdurst zu befriedigen und ggfs. auch direkt etwas für die Arbeit zu lernen.

alle Infos auch auf der Webseite von Synology zu finden.

Alle Infos auch auf der Webseite von Synology zu finden.

Folgende Inhalte lagen dem Paket noch bei:

Vorne befinden sich wie gewohnt die Status-LEDs (Status, Disk 1 & Disk 2), ein USB3 Port sowie 1 Powerbutton.

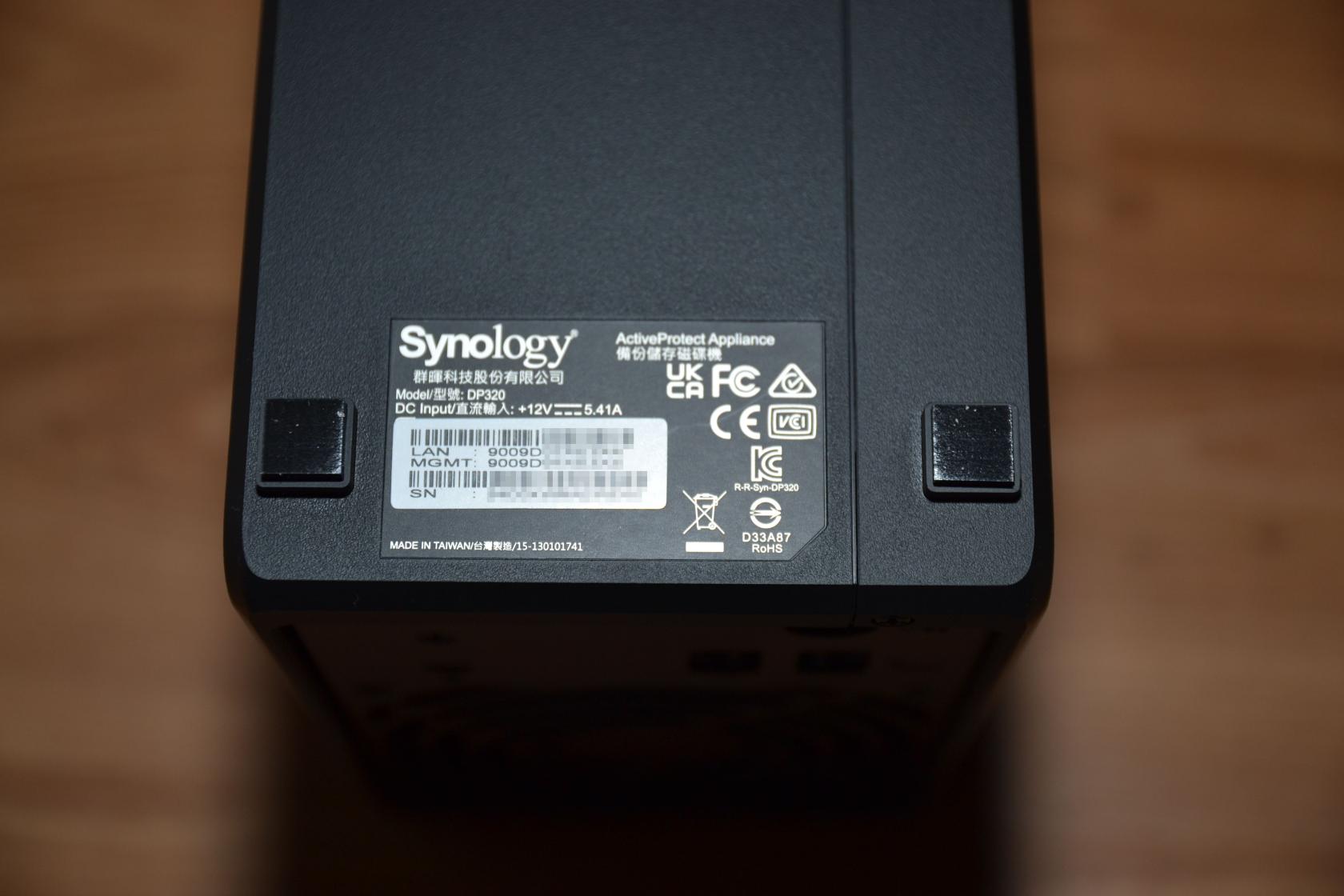

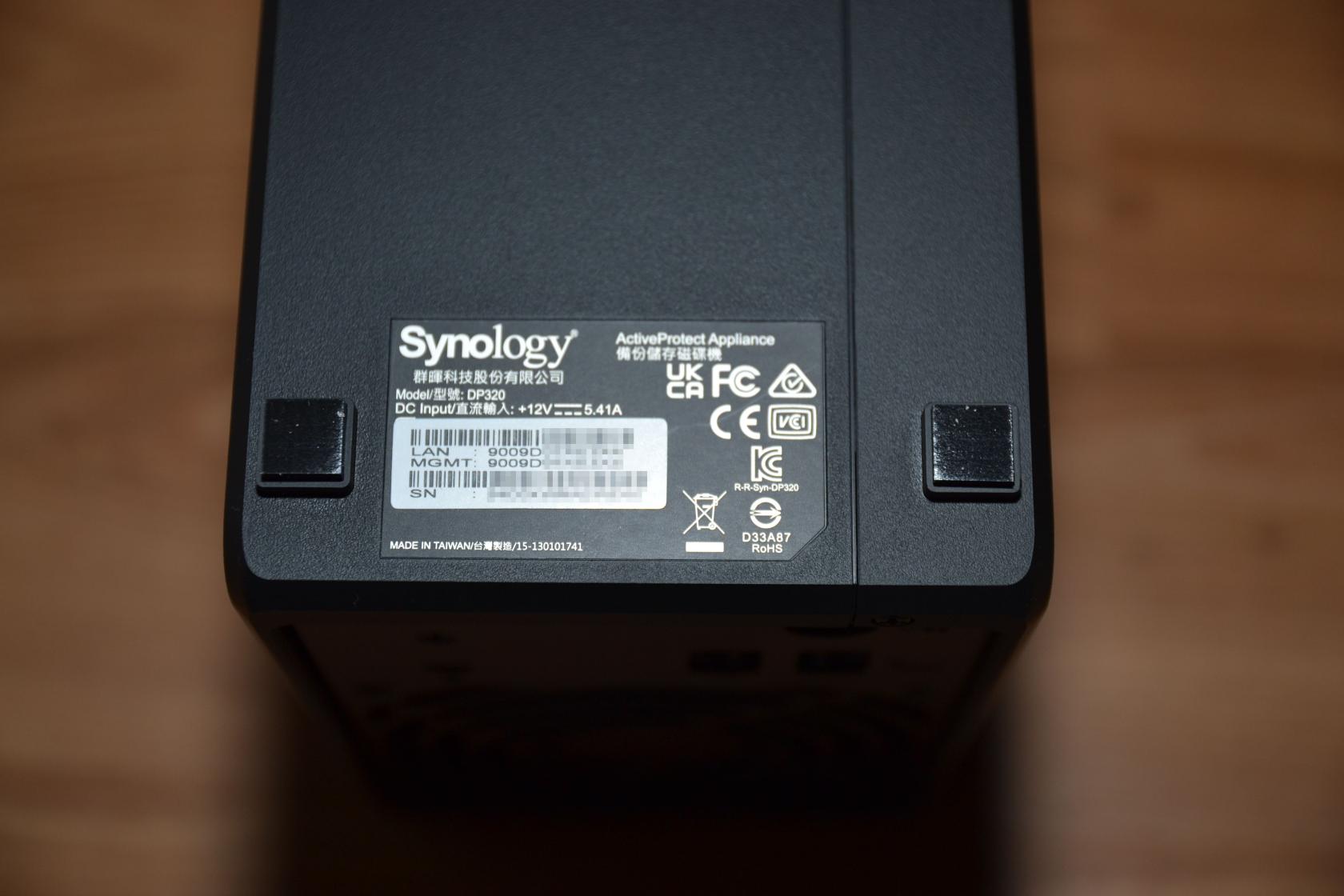

Auf der Rückseite befinden sich 2 Gigabit-LAN Ports, einer davon als reiner Management Port und der andere Port für die Datenübertragung. Außerdem befindet sich hier der Netzteilanschluss sowie ein Kensington-Lock.

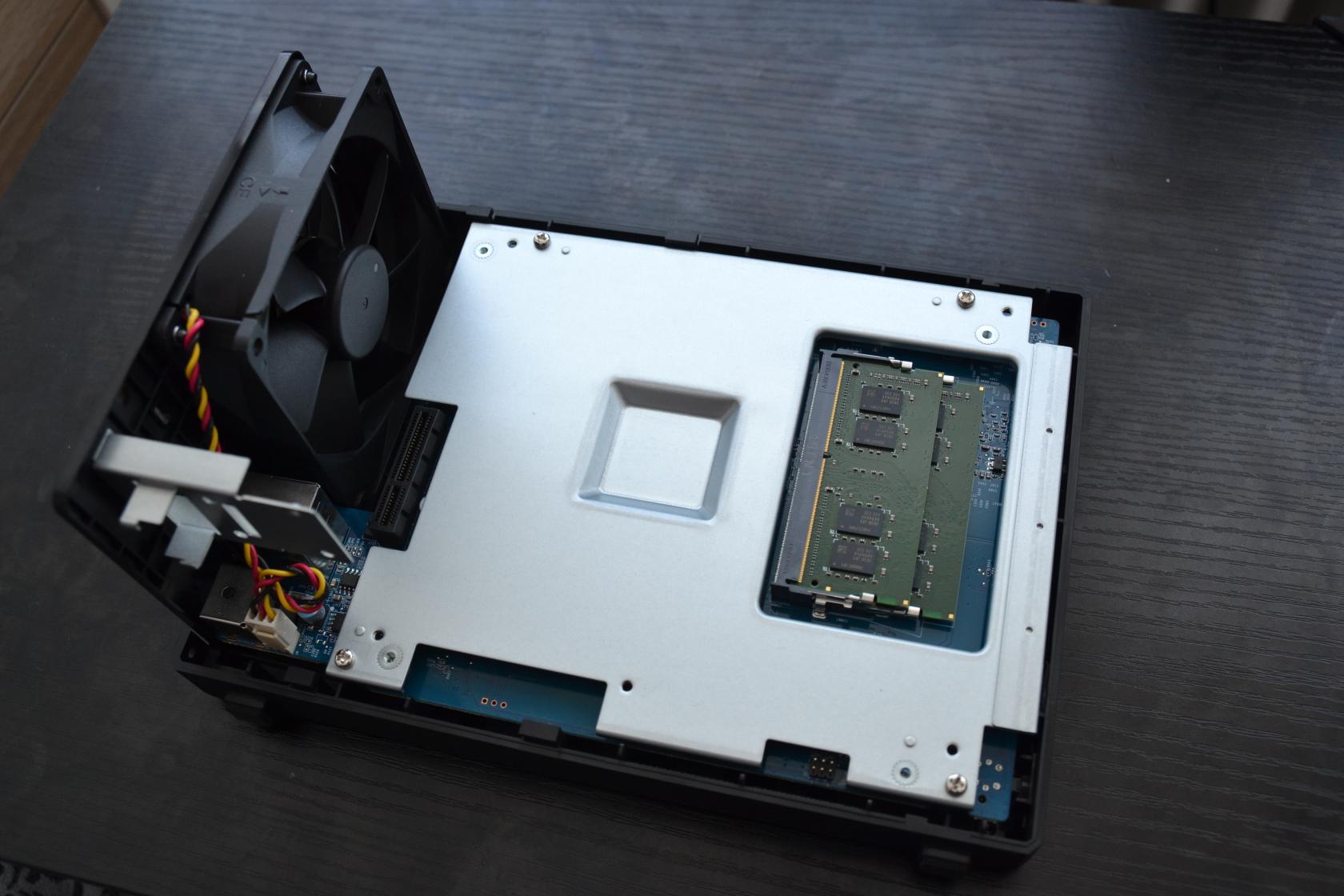

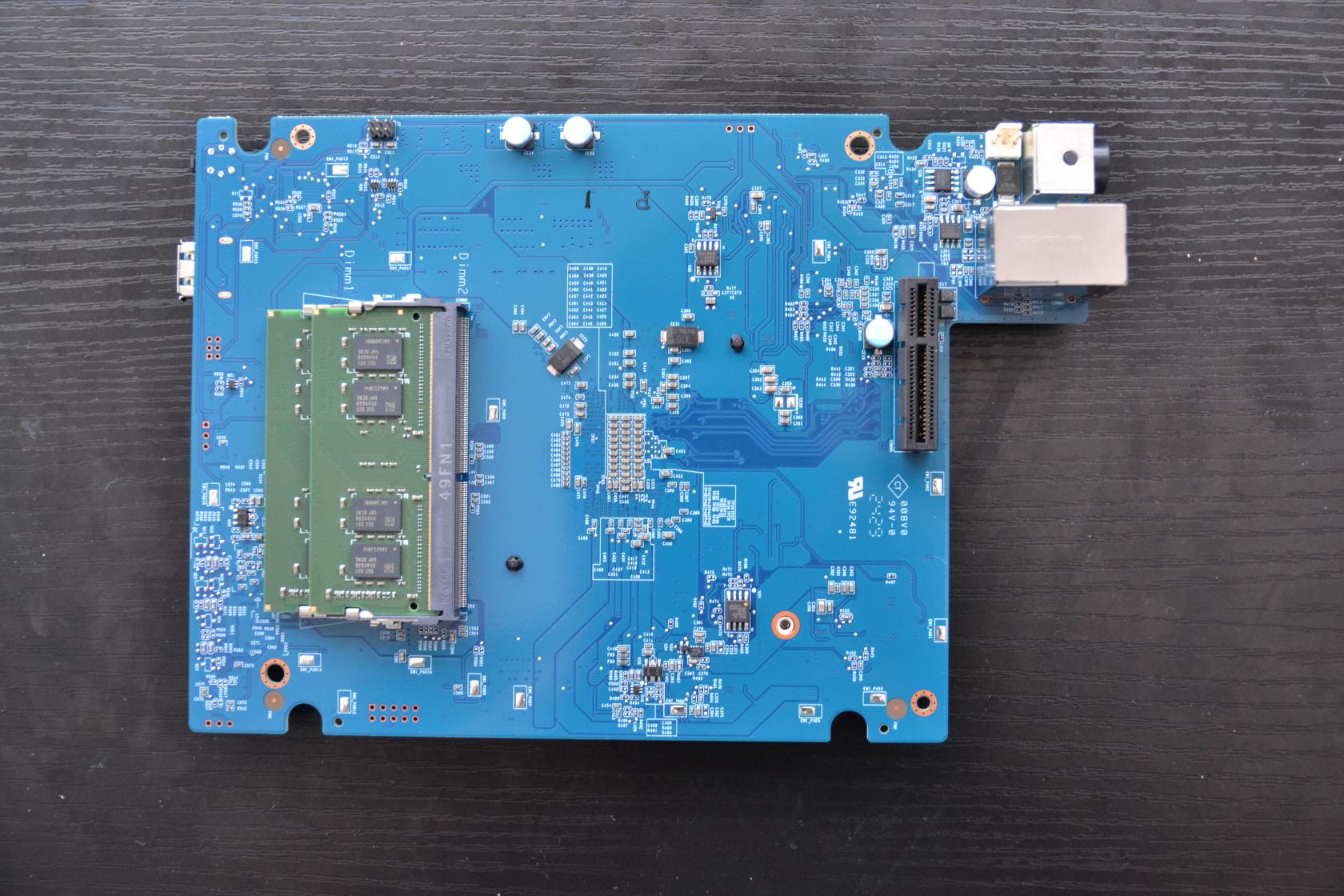

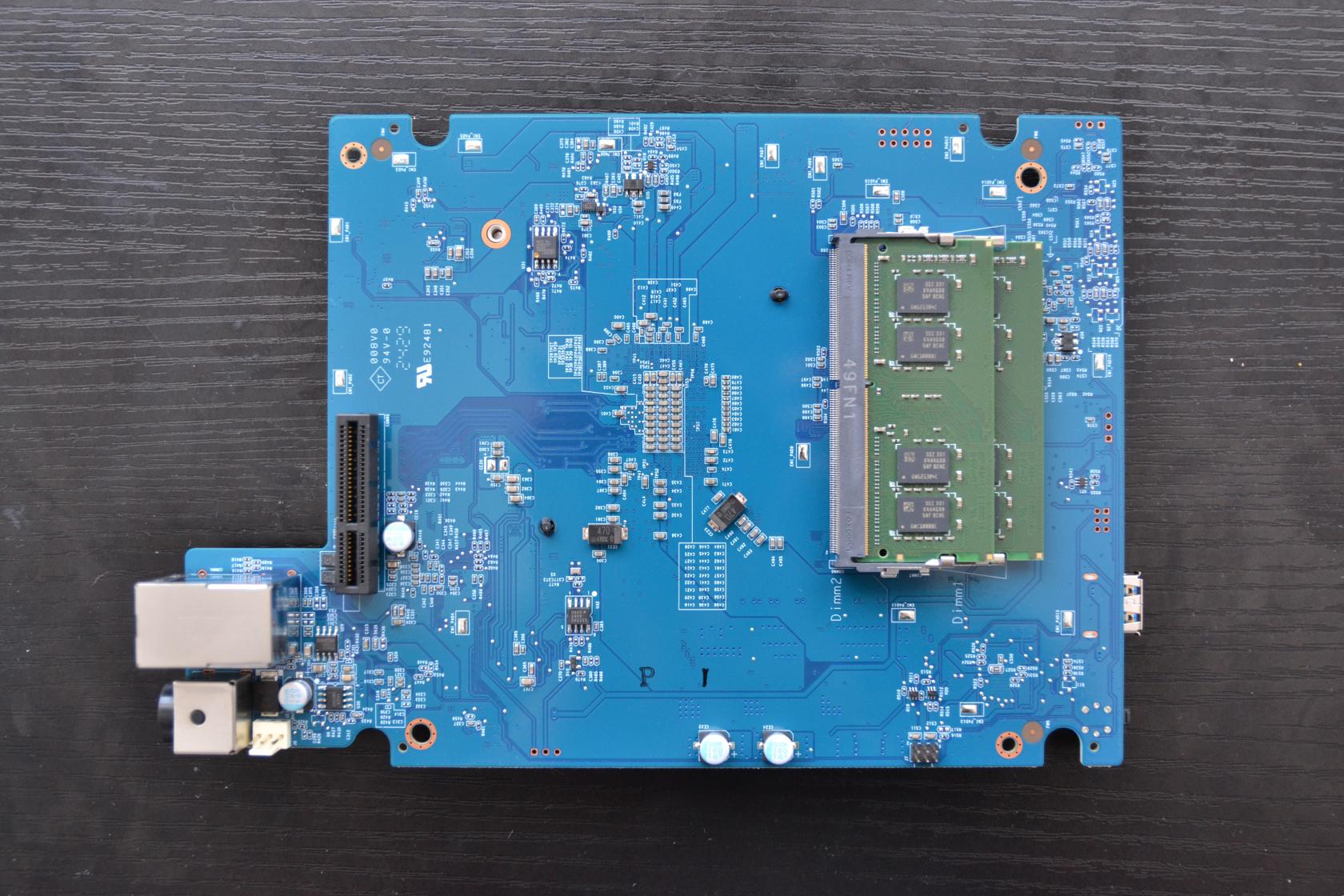

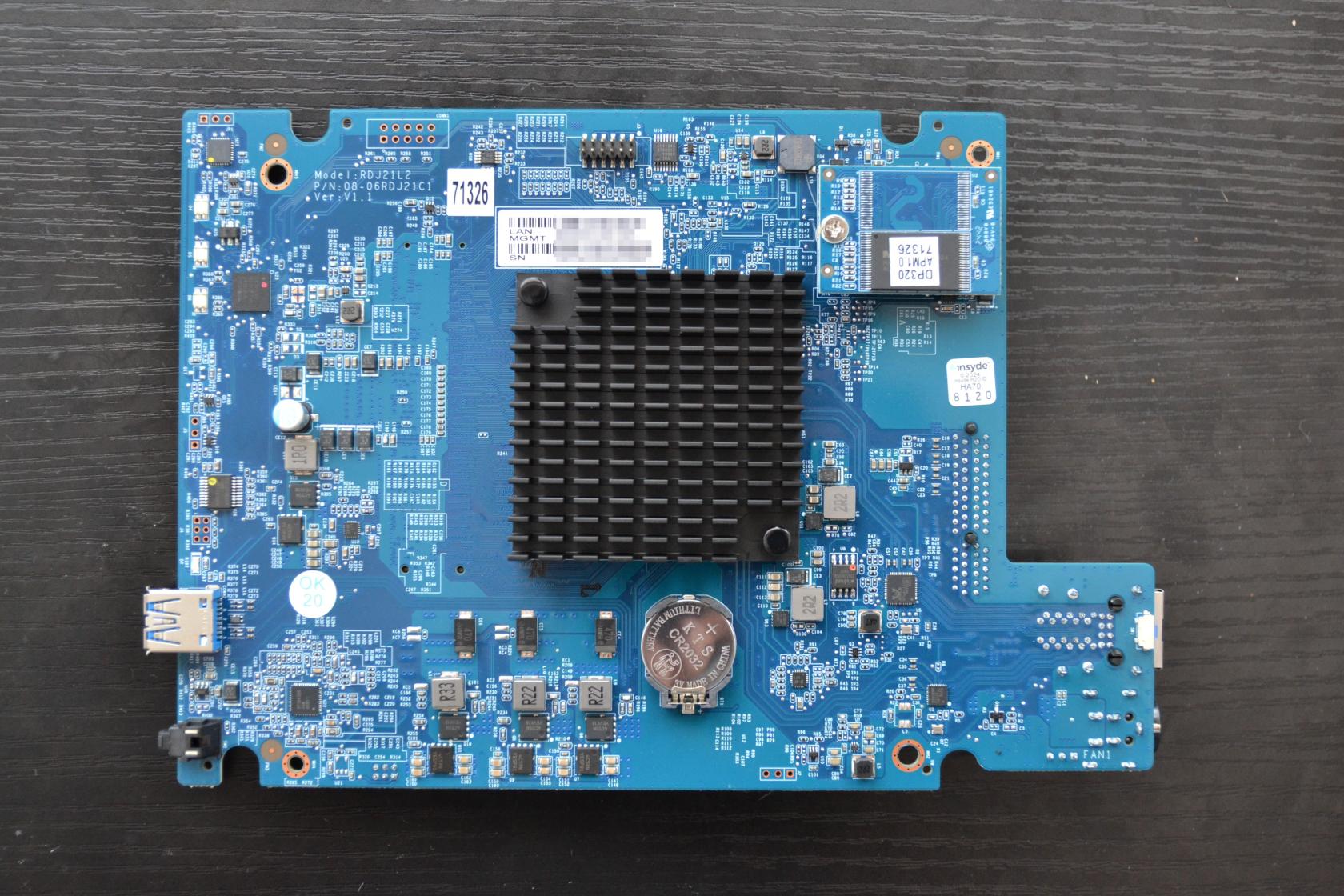

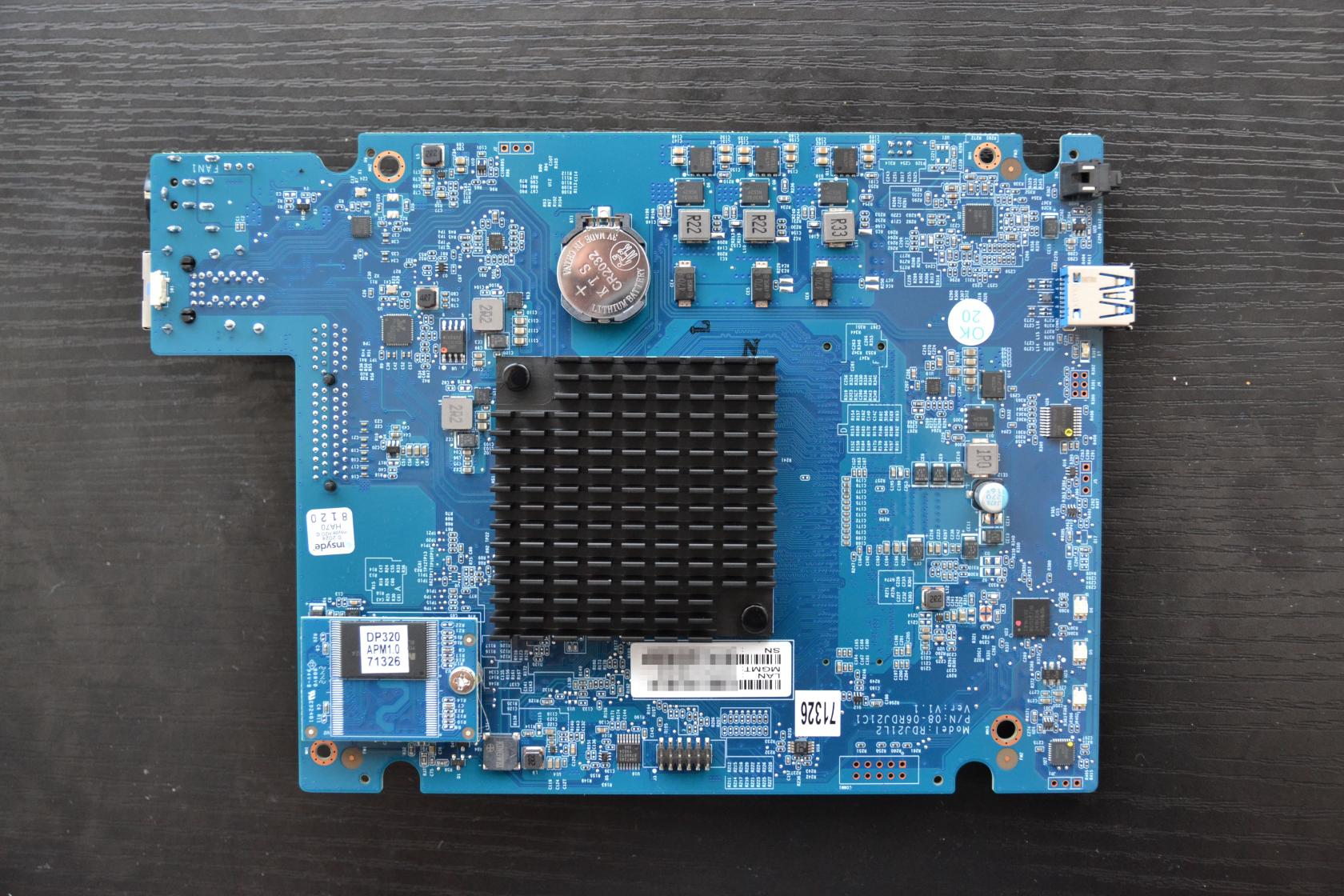

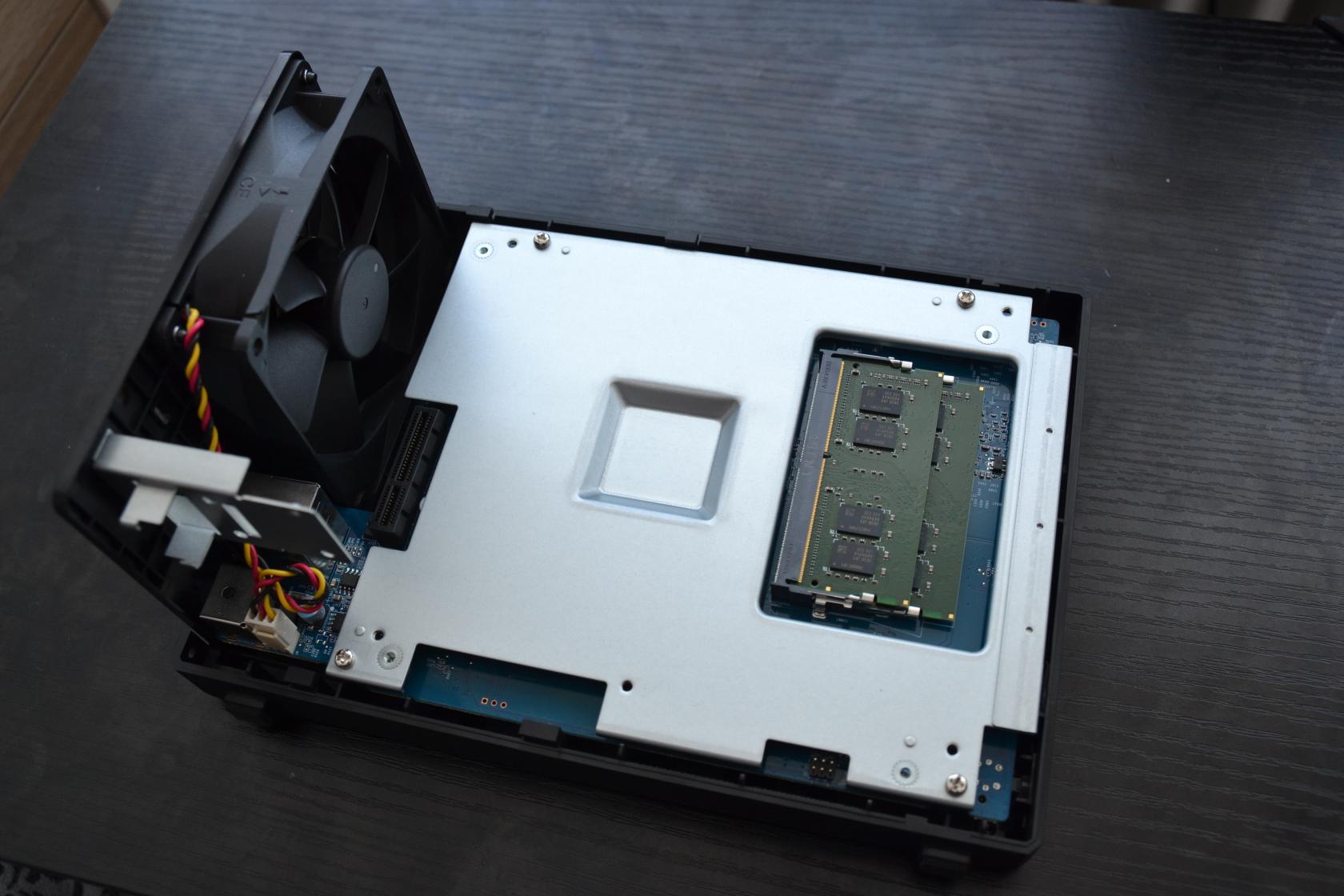

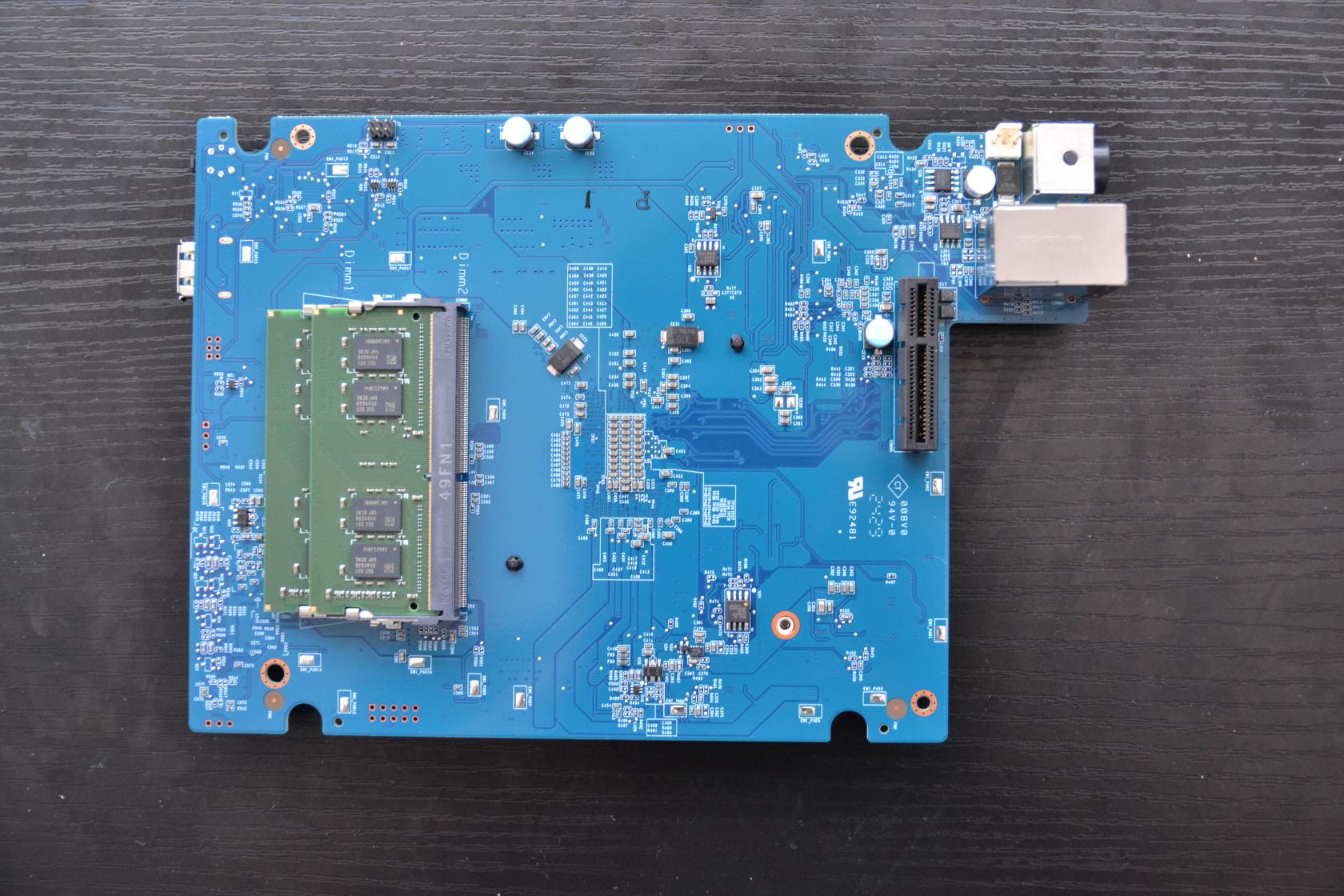

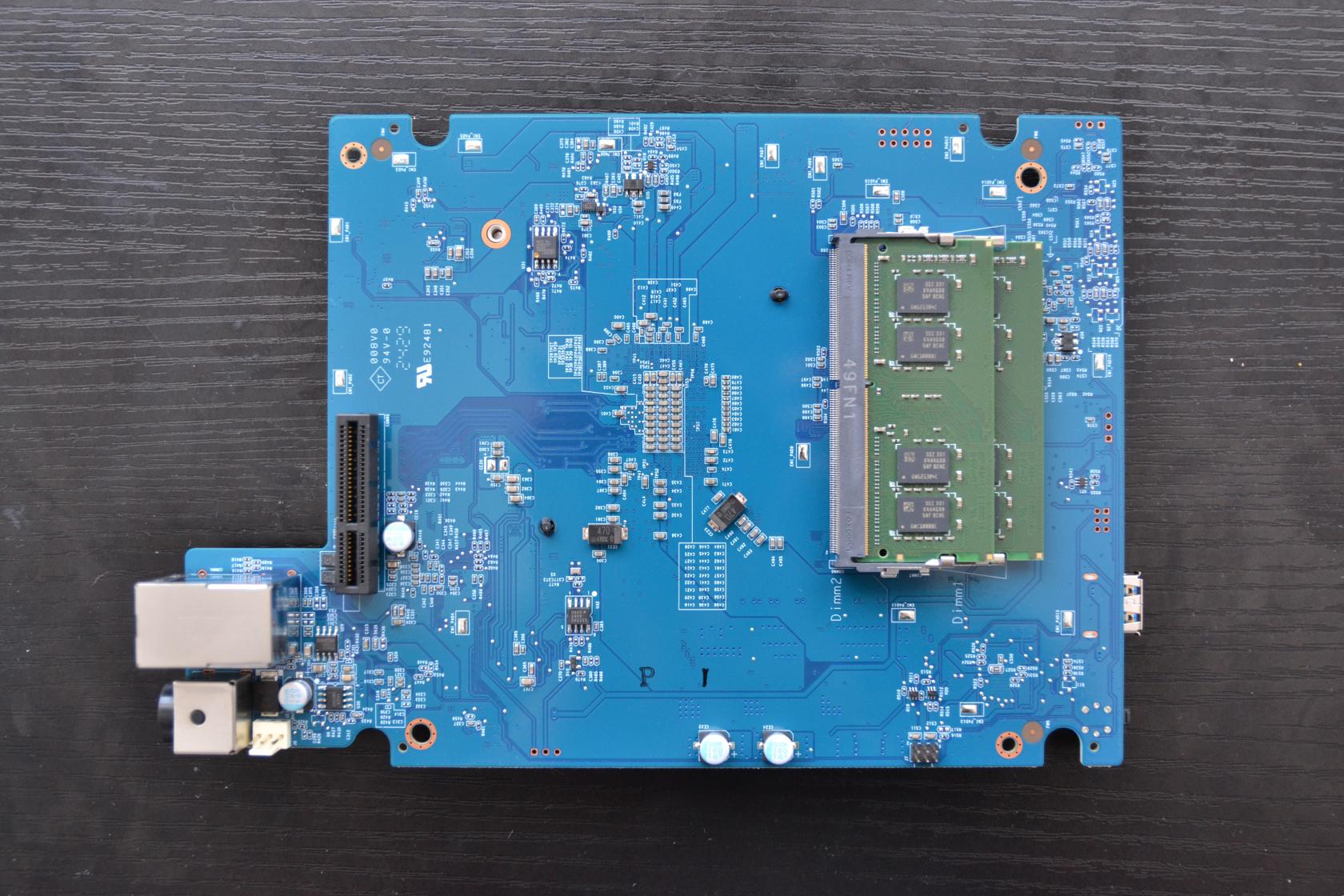

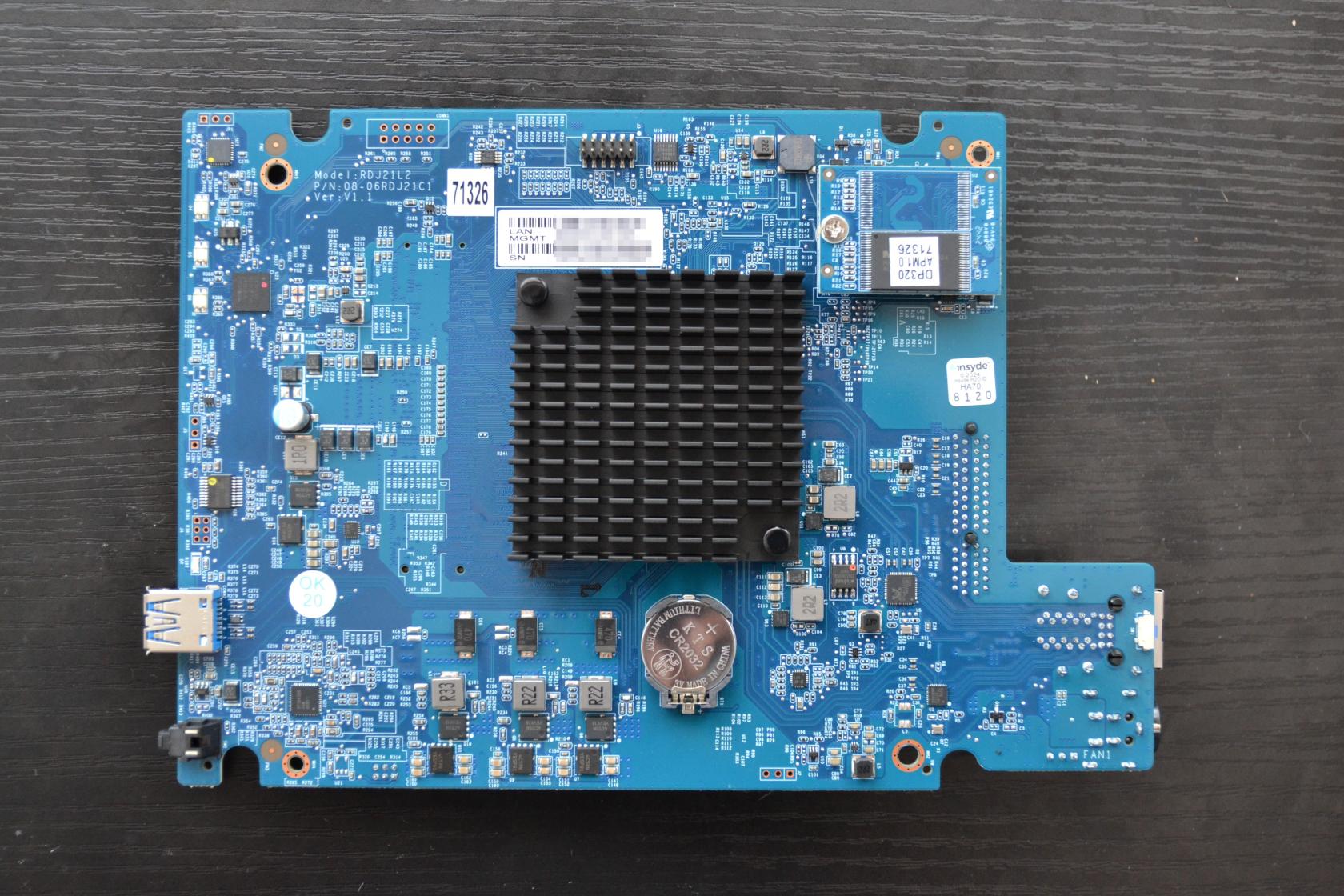

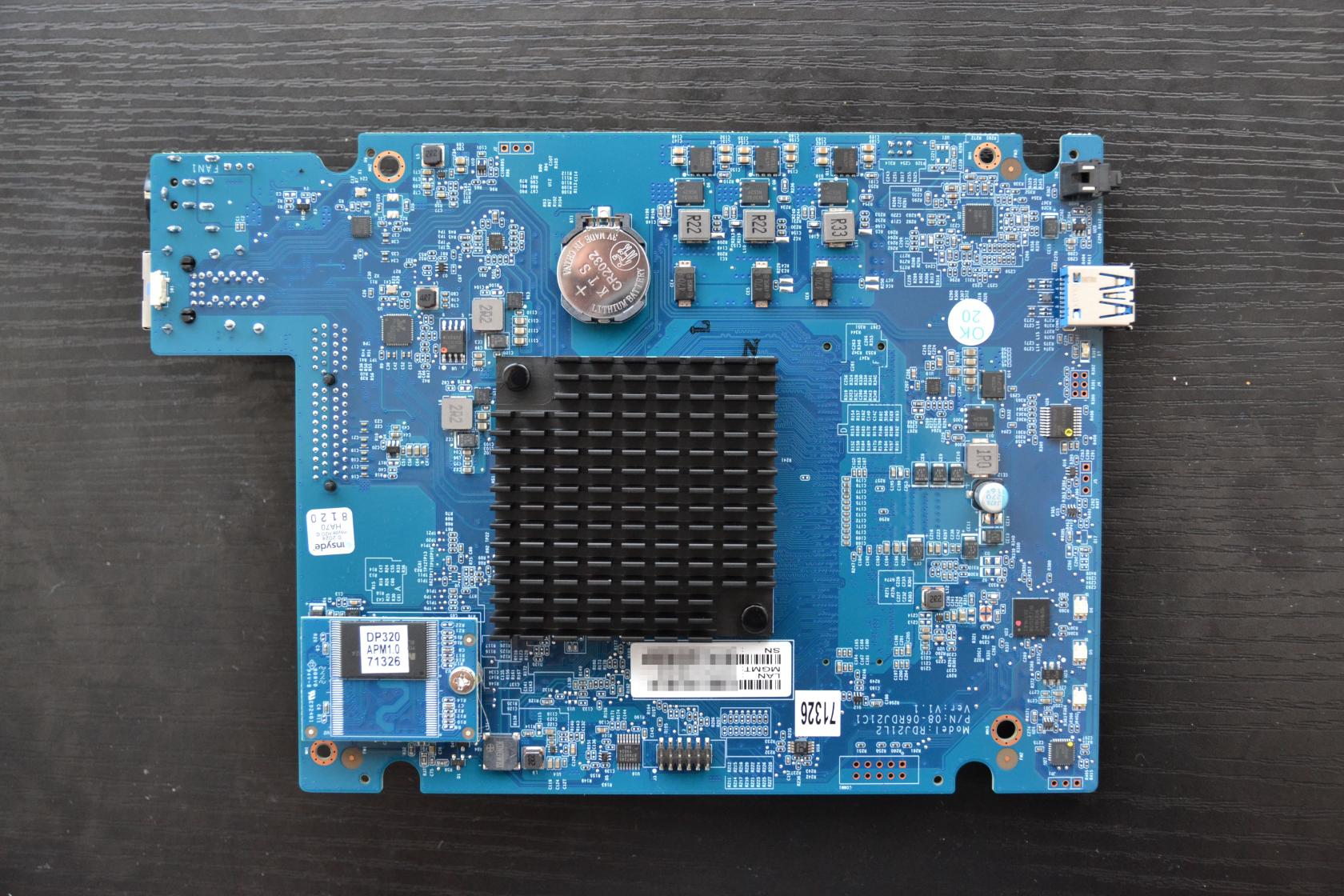

Innen befinden sich ein Festplattenkäfig mit 2 Einschüben, die primär für 3,5’‘ SATA-Festplatten genutzt werden können. Dazu lassen sich die Festplatten mit einem einfachen Klick-Mechanismus einsetzen und arretieren. Mit einem Blick nach innen bei entfernten Festplattenkäfigen sieht man die SATA Anschlüsse für die 2 möglichen Festplatten. Diese sind nach rechts mit dem Mainboard verbunden. Außerdem finden sich auf der rechten Seite auch die 2 ECC RAM Module, die man im Zweifelsfall einfach austauschen kann.

Die beiden mitgelieferten Festplatten sind vom Typ HAT3310-8T der Plus-Serie von Synology. Diese Festplatten wurden speziell für NAS Systeme entwickelt und werden beschrieben als "Zuverlässige Festplatten, speziell entwickelt für Synology Systeme für Privatnutzer und kleine Büros" (Quelle). Mehr als 500.000 Stunden an internen Validierungstests sollen diese Aussage bekräftigen. Vermutlich werde ich aber diese Leistung während des Tests nicht erreichen

Weitere Vorteile sind:

Die Performancewerte werde ich später im Review prüfen.

Für alle diejenigen die es interessiert hier die Bilder vom Innenleben.

Ich fand dabei interessant zu sehen, dass das Speichermodul für das APM auf einem separaten Modul ist und auch gleich mit der ausgelieferten Version beschriftet ist.

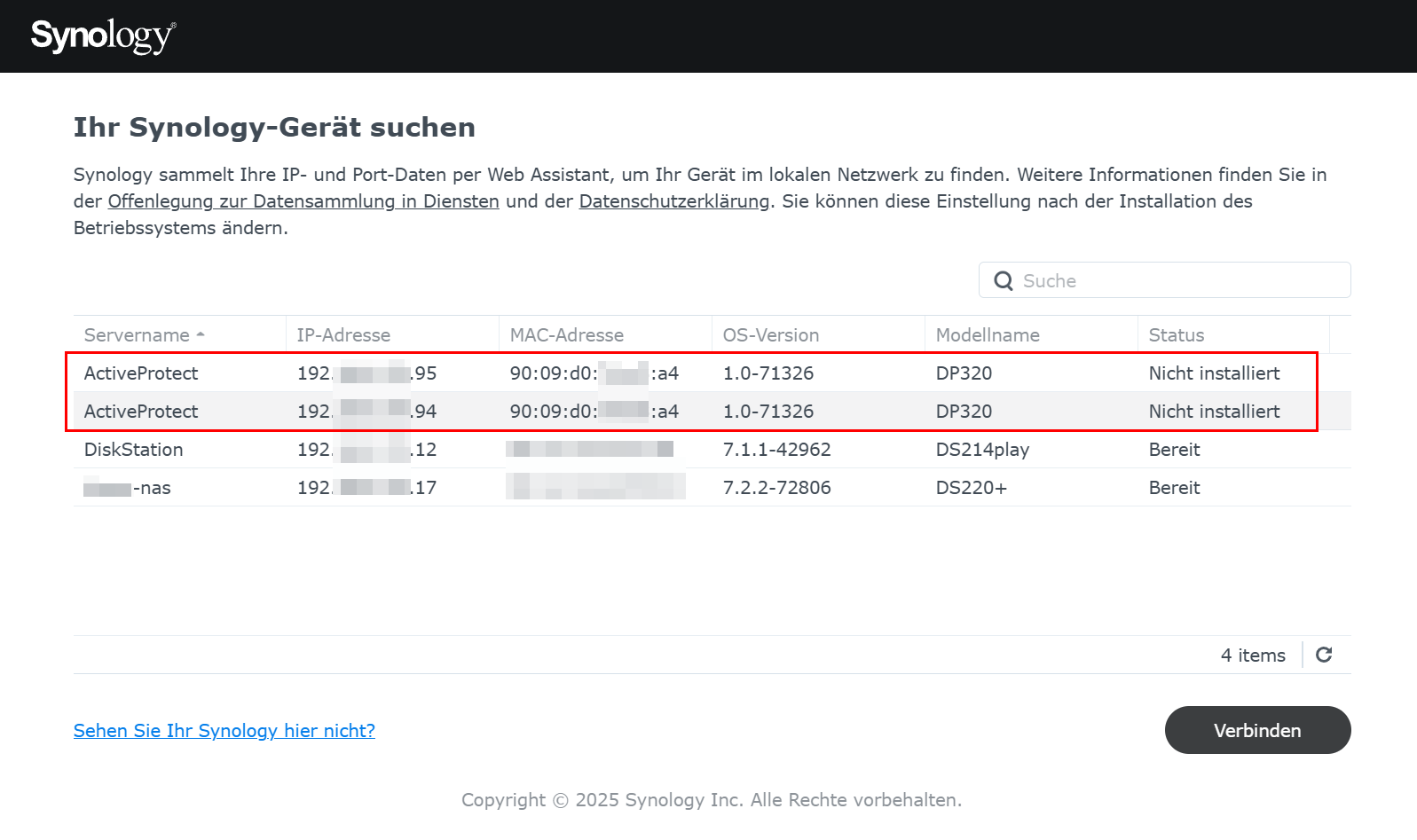

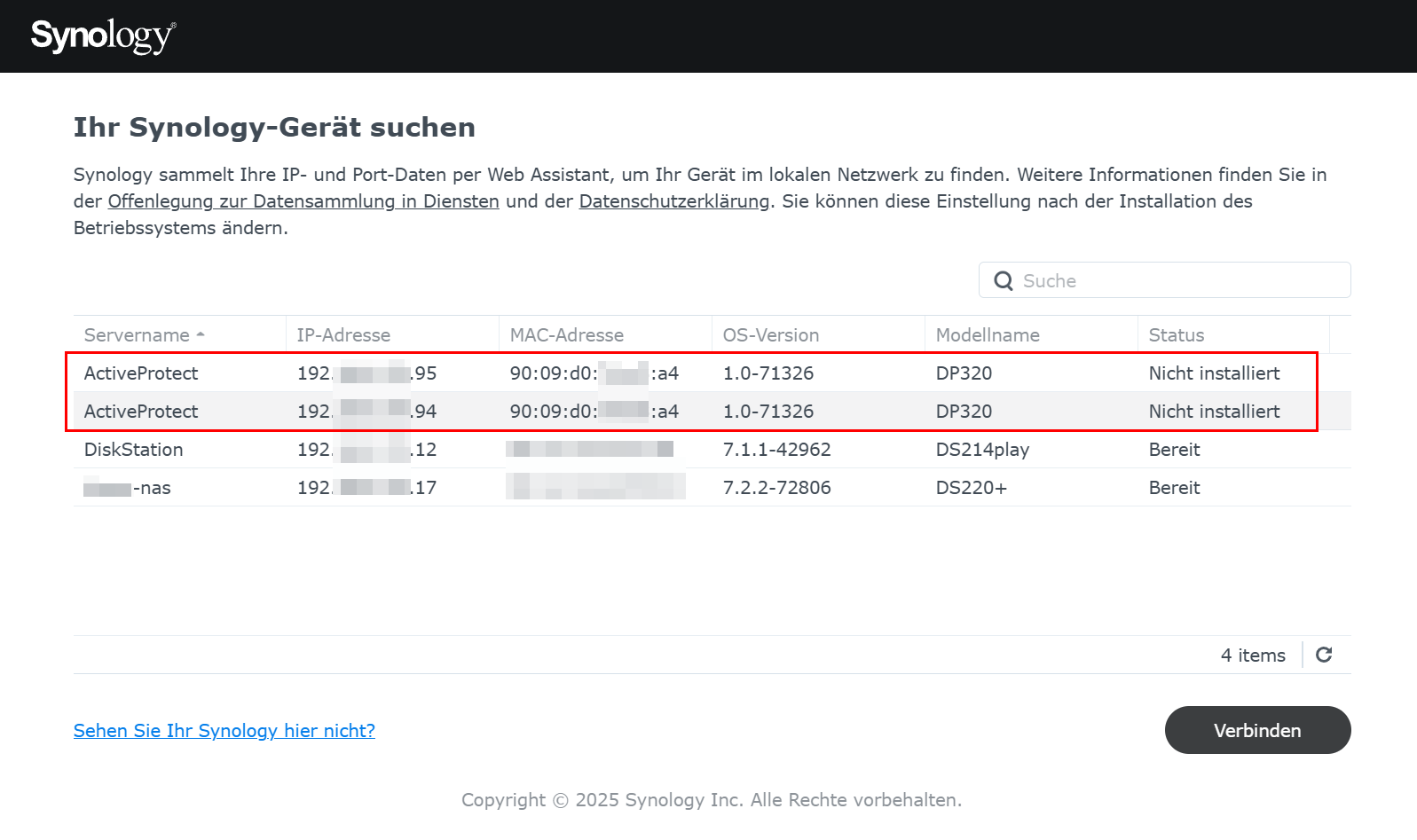

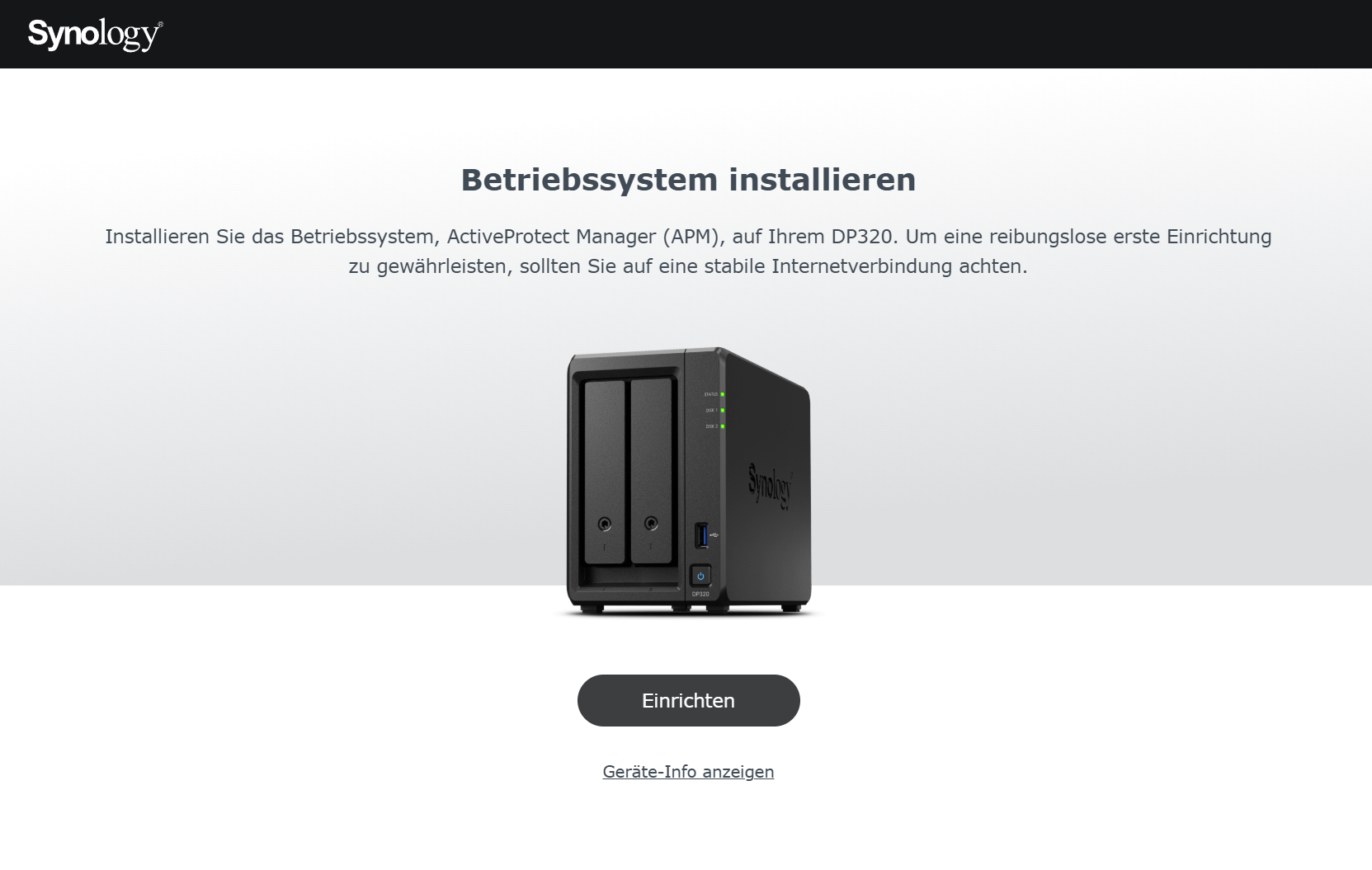

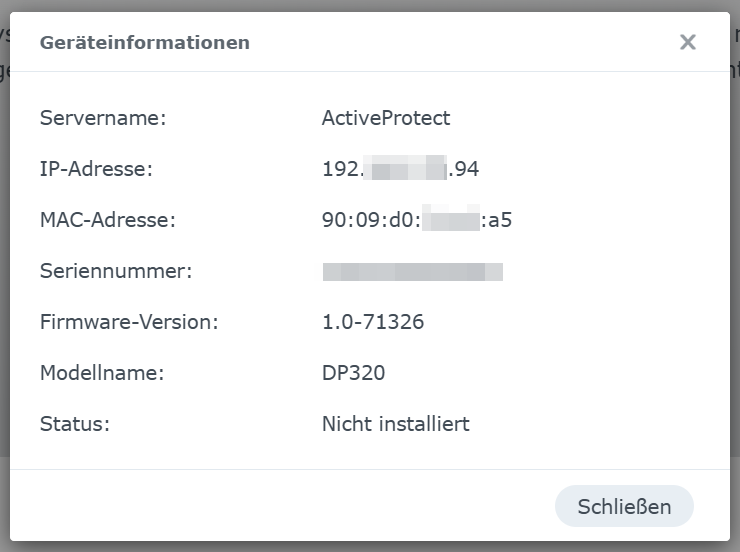

Das Gerät kann nun über die Webseite https://finds.synology.com im lokalen Netzwerk gefunden werden. Hier sollte man aber lediglich den Management Port verbinden, da sonst beide Ports mit der selben MAC Adresse in der Übersicht auftauchen.

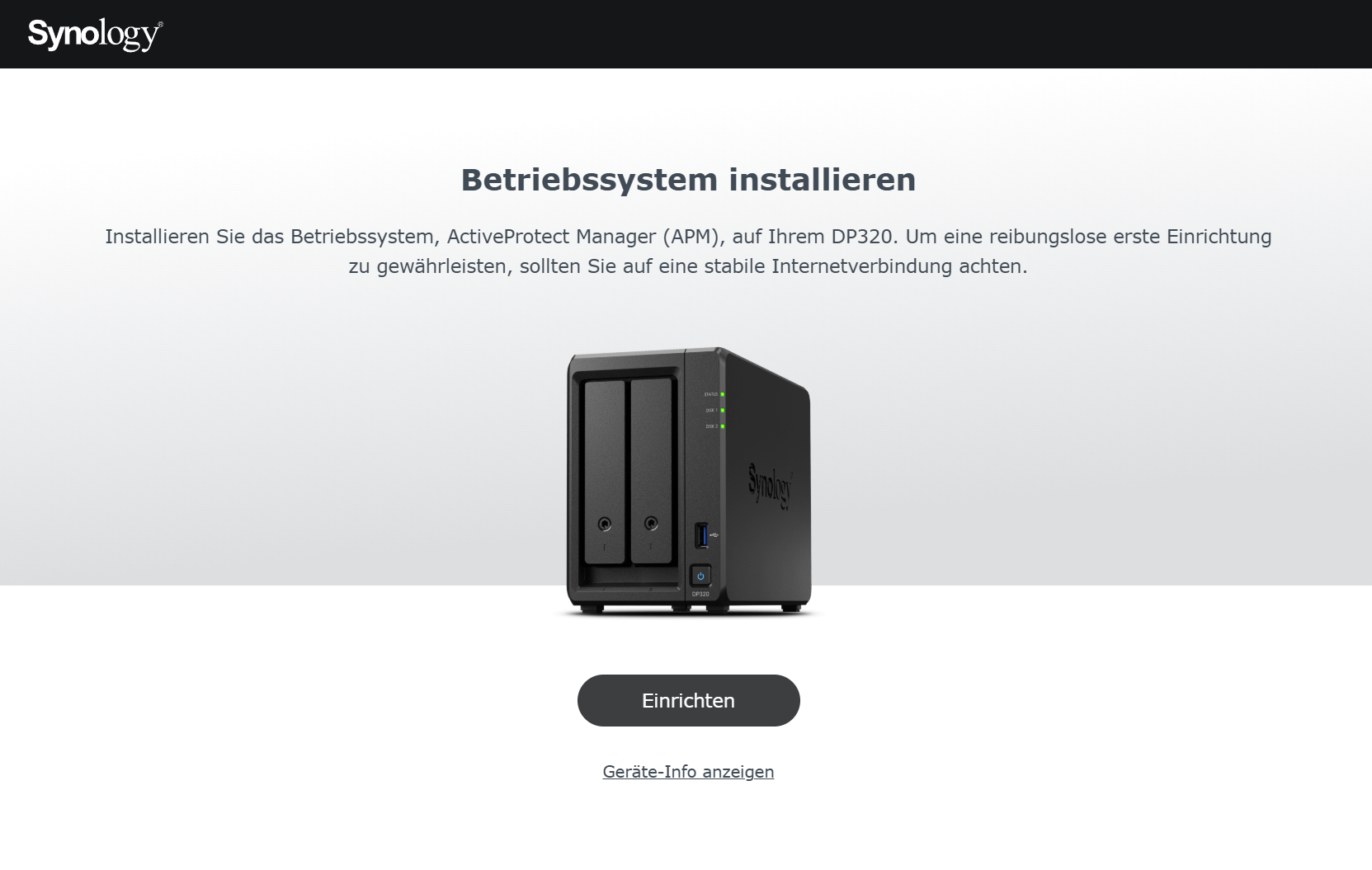

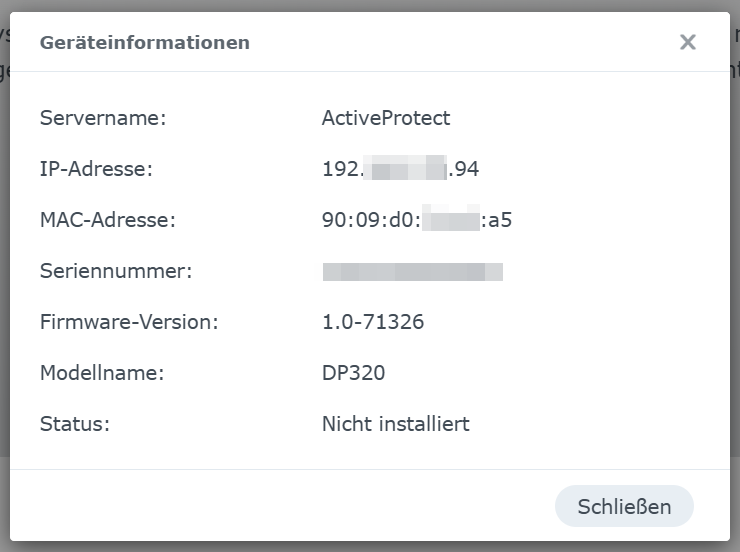

Hat man das korrekte Interface ausgewählt führt einen der Assistent nun als nächstes zur Installation des Betriebssystems. Hier kann man sich auch noch einmal die Geräte-Informationen anschauen wenn man möchte.

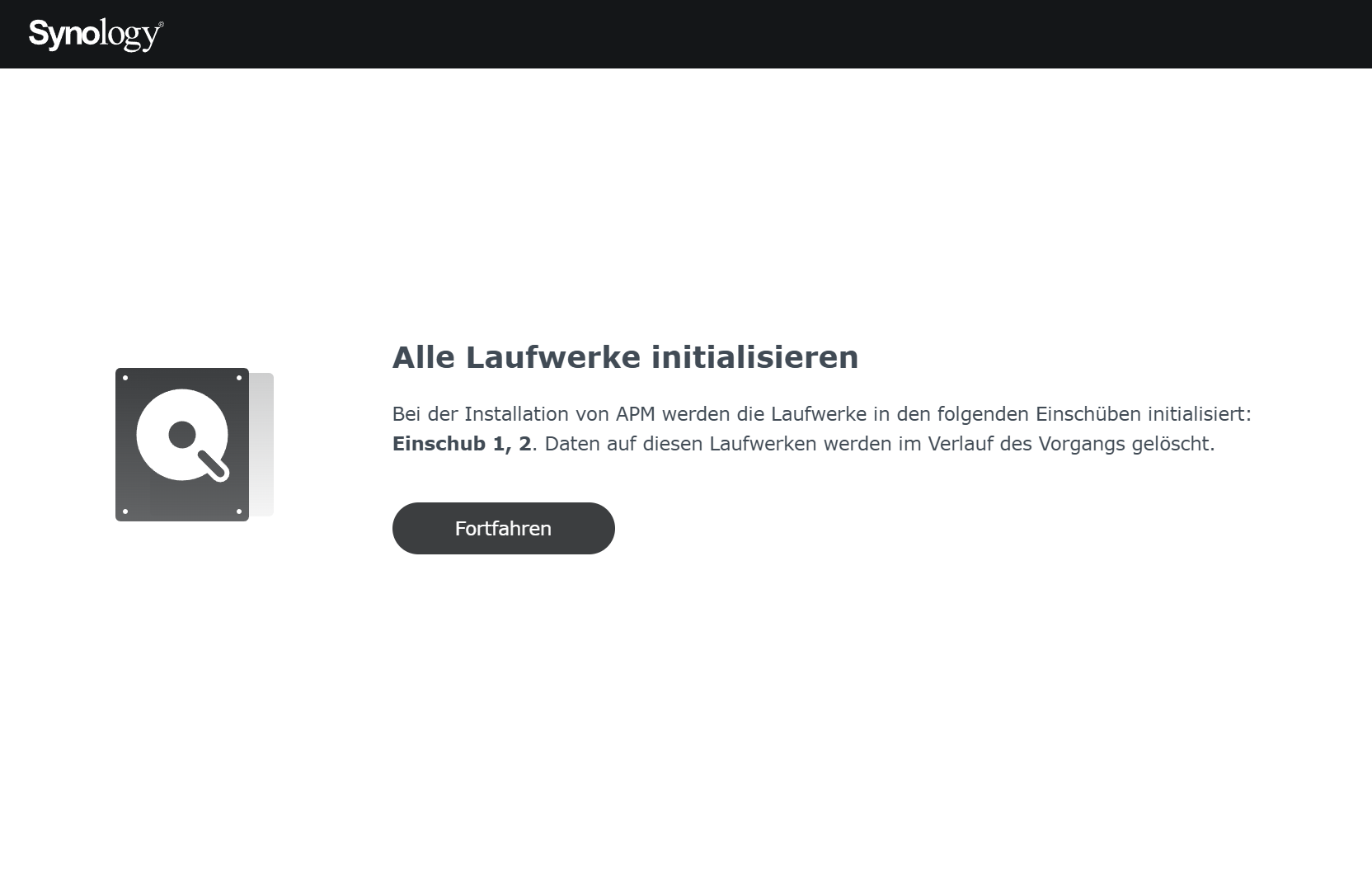

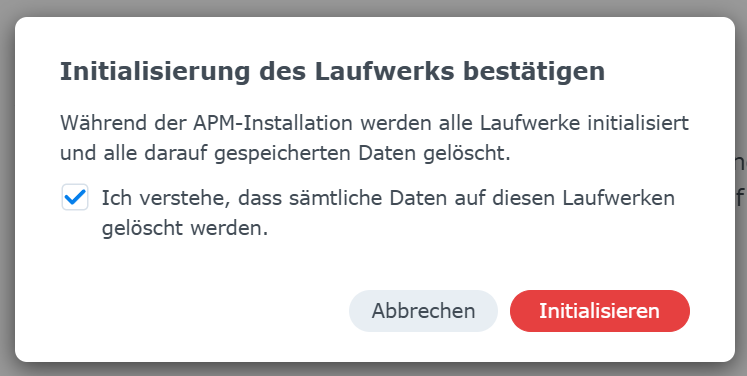

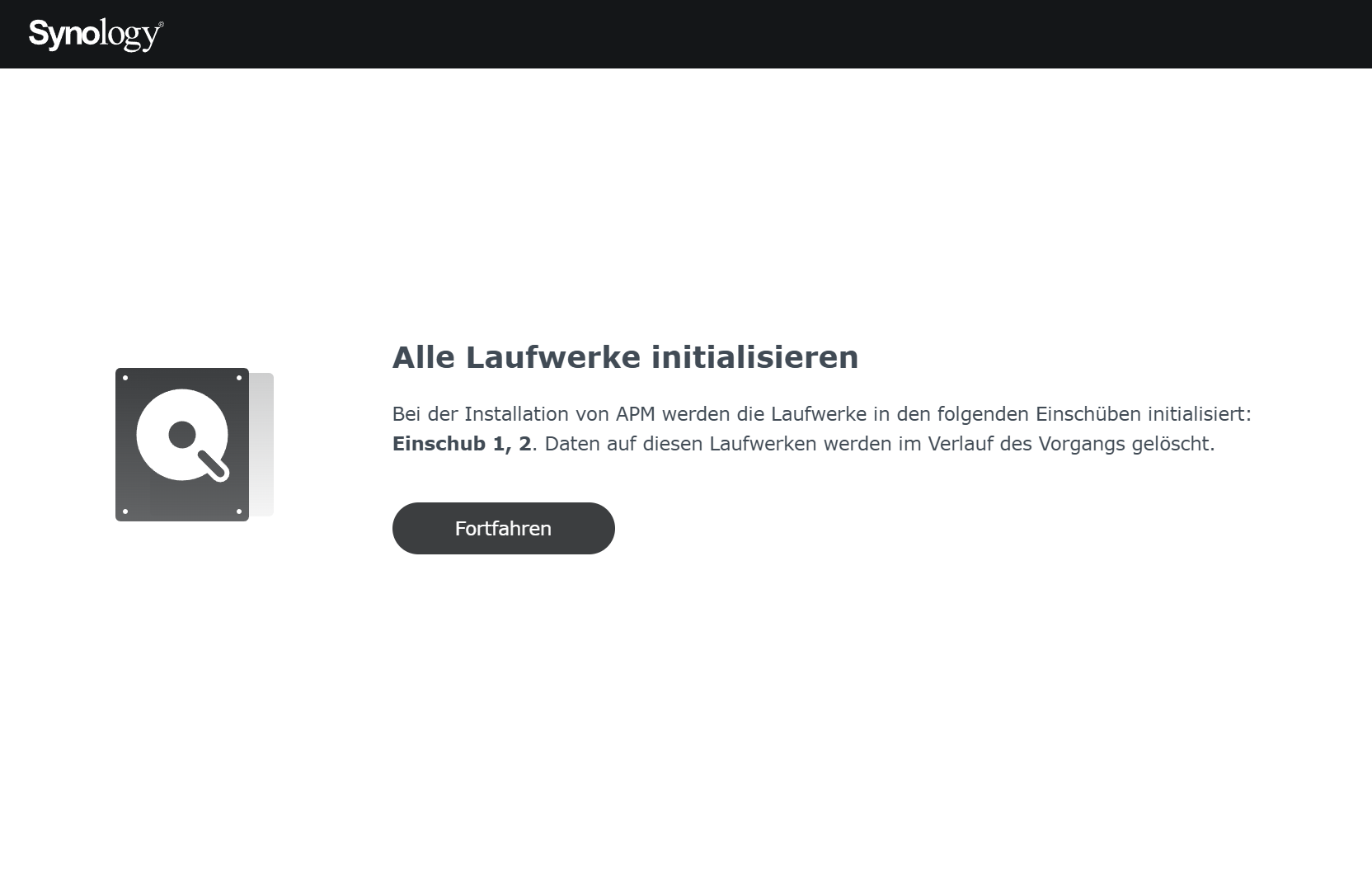

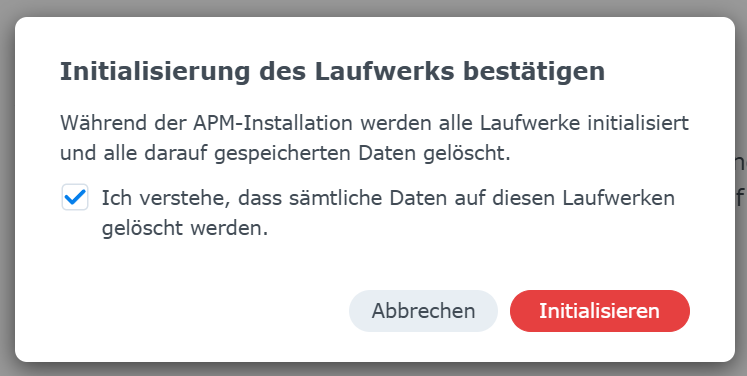

Nach der Bestätigung dass man (natürlich) die EULA gelesen hat werden im nächsten Schritt die Festplatten initialisiert, wobei noch einmal bestätigen muss dass dabei alle Daten gelöscht werden.

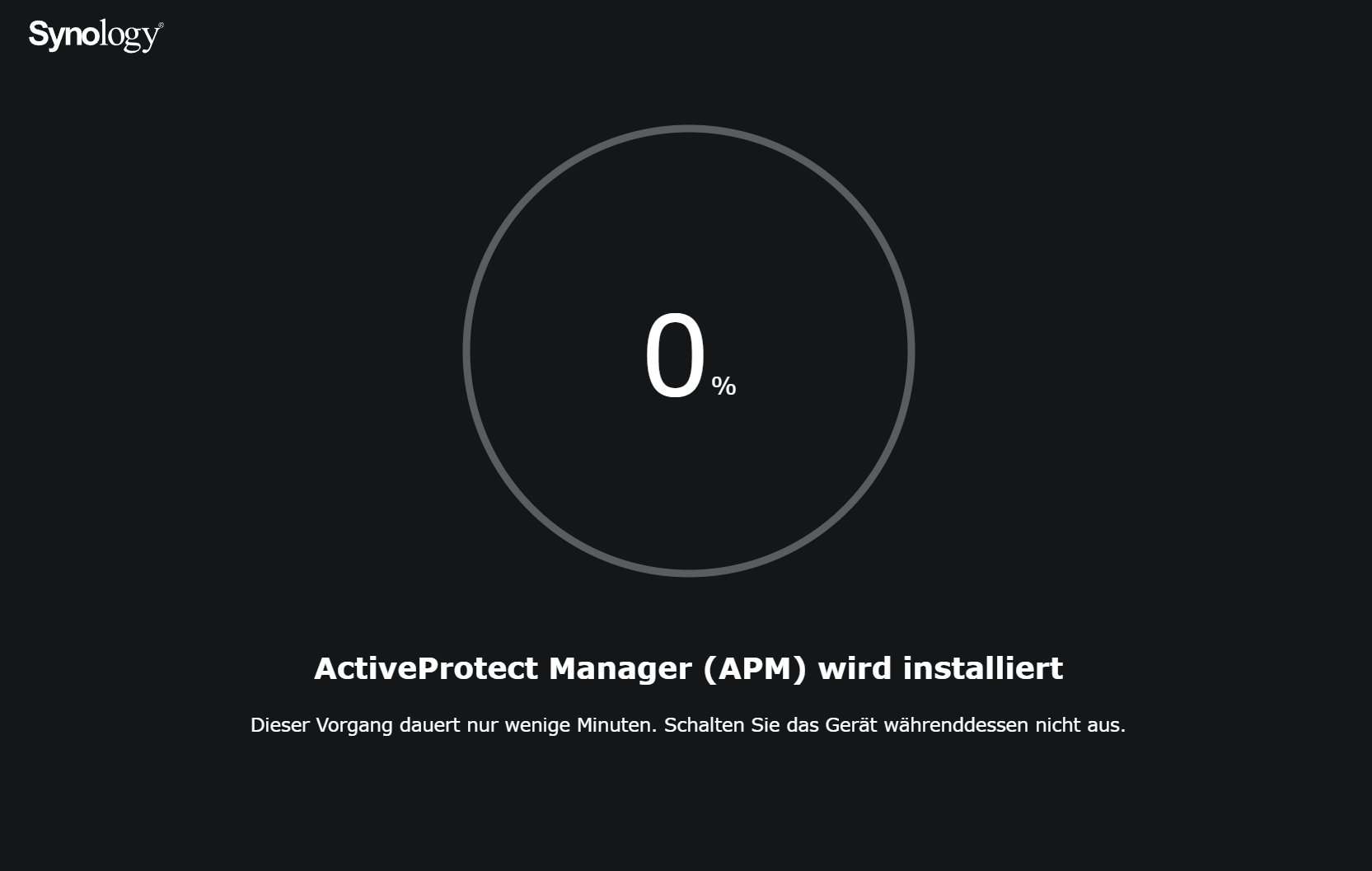

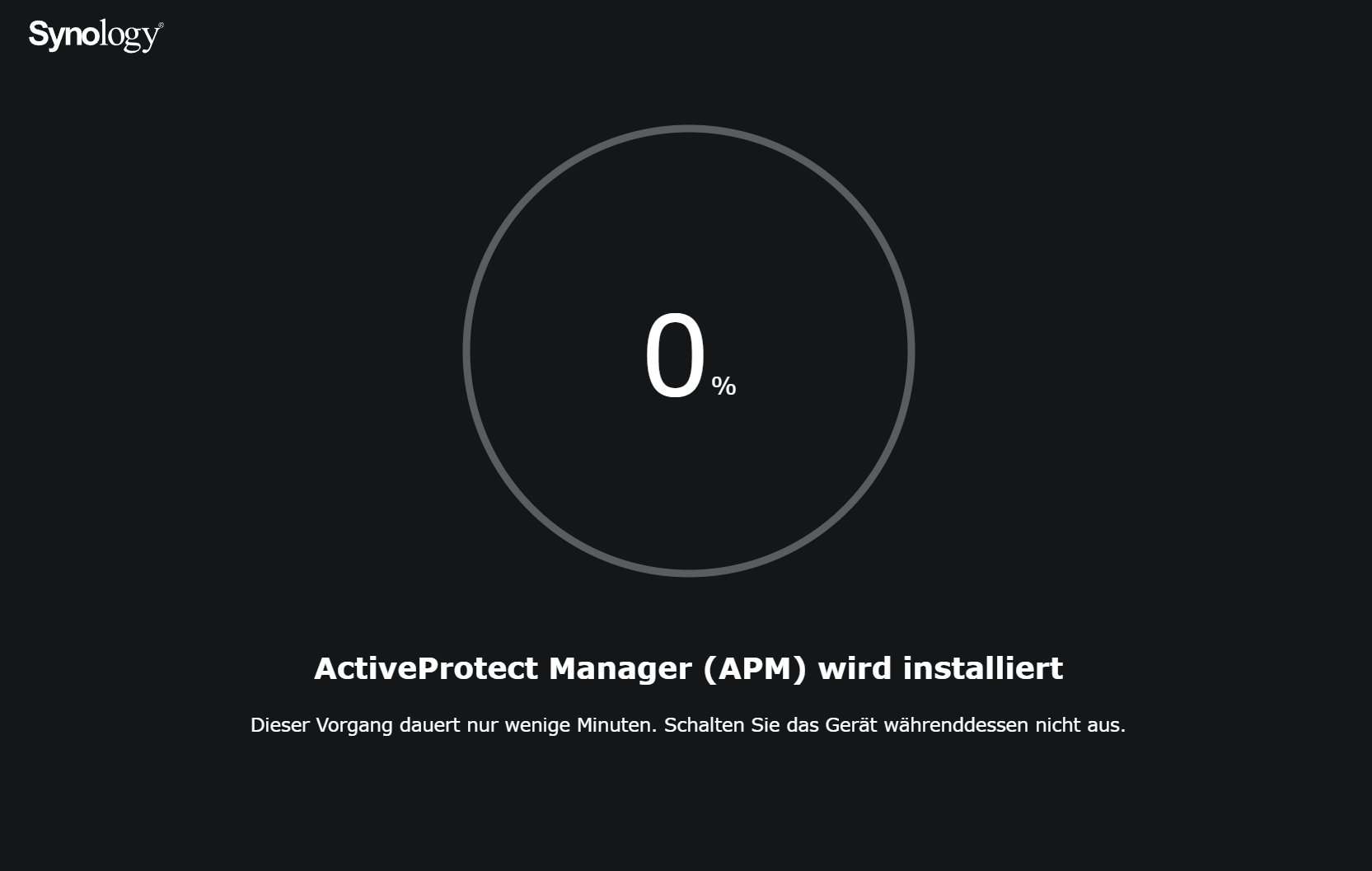

Nun wird der APM (ActiveProtect Manager) installiert, das Betriebssystem der Appliance. Das hat mir lediglich 1 Minute gedauert und im Anschluss wurde das Gerät direkt neu gestartet.

Inkl. des Neustarts war das APM nach 5 Minuten einsatzbereit. Ich wünschte mein Windows wäre bei der Installation oder einem Update so schnell

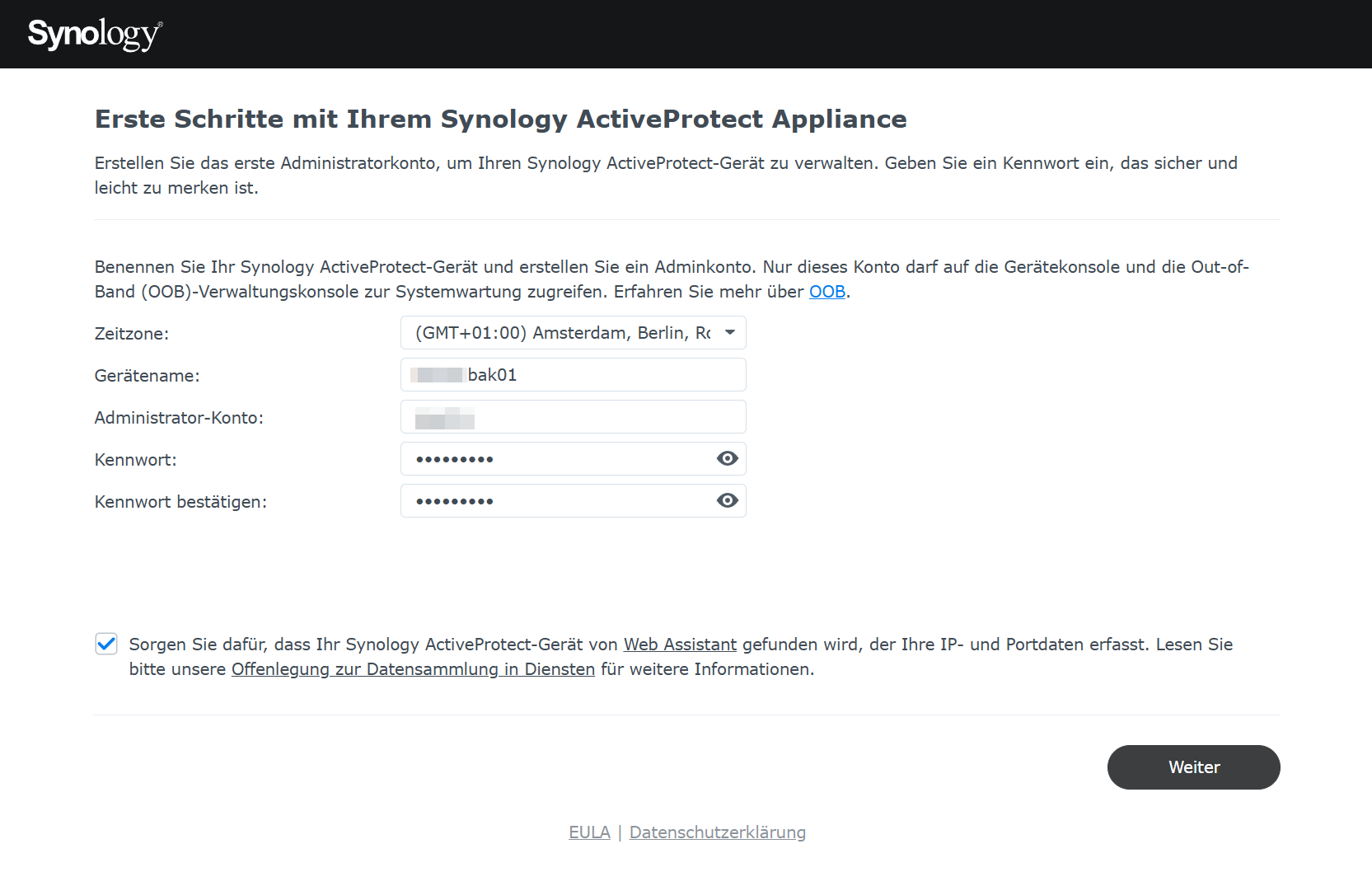

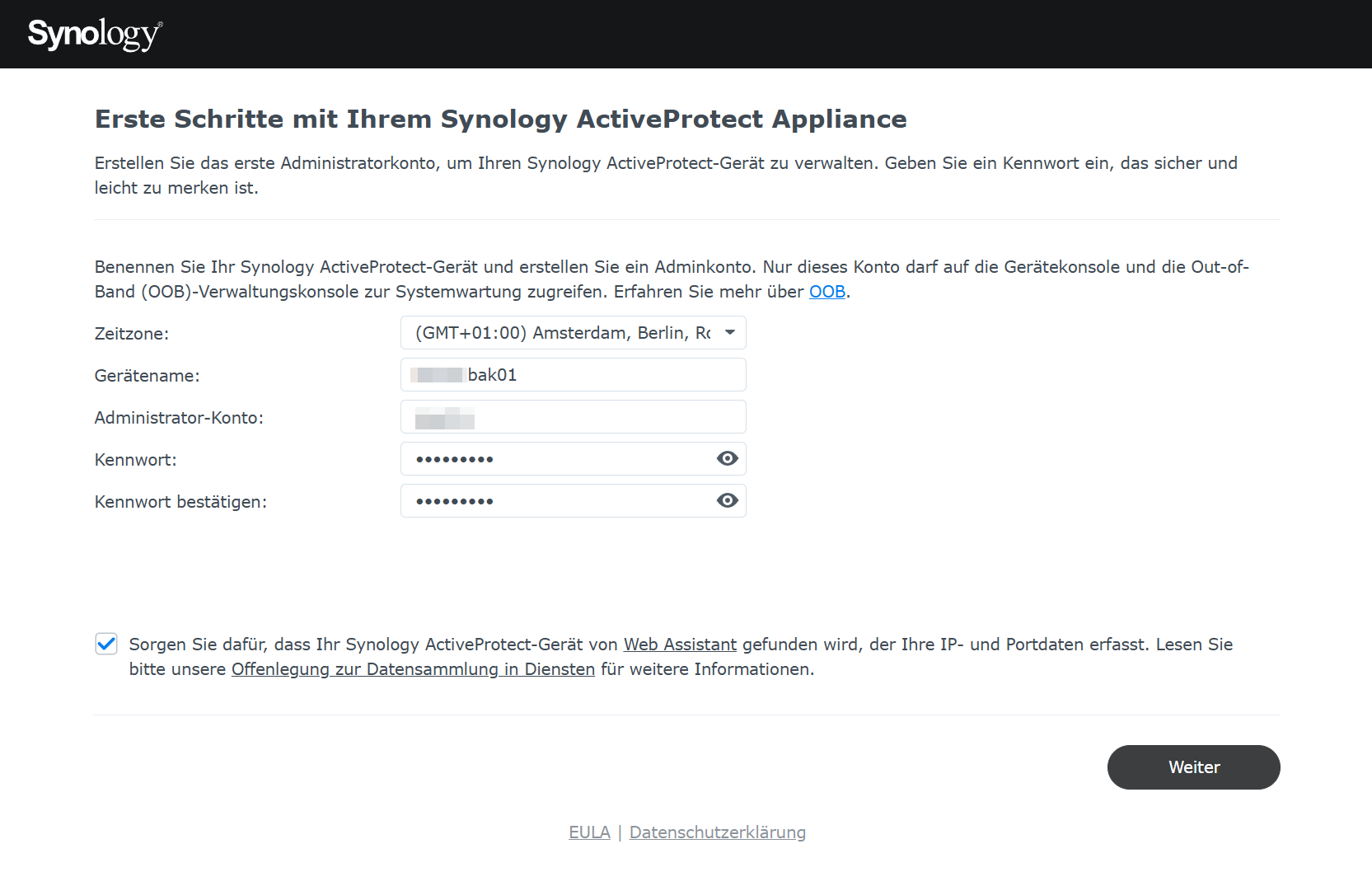

Im Anschluss startet sich das Synology NAS automatisch neu und erwartet die Eingabe eines Gerätenamens und eines Administrator-Kontos. Gefüllt mit einem Servernamen für das NAS, einem Benutzernamen und einem sicheren Kennwort kann das Formular abgeschickt werden.

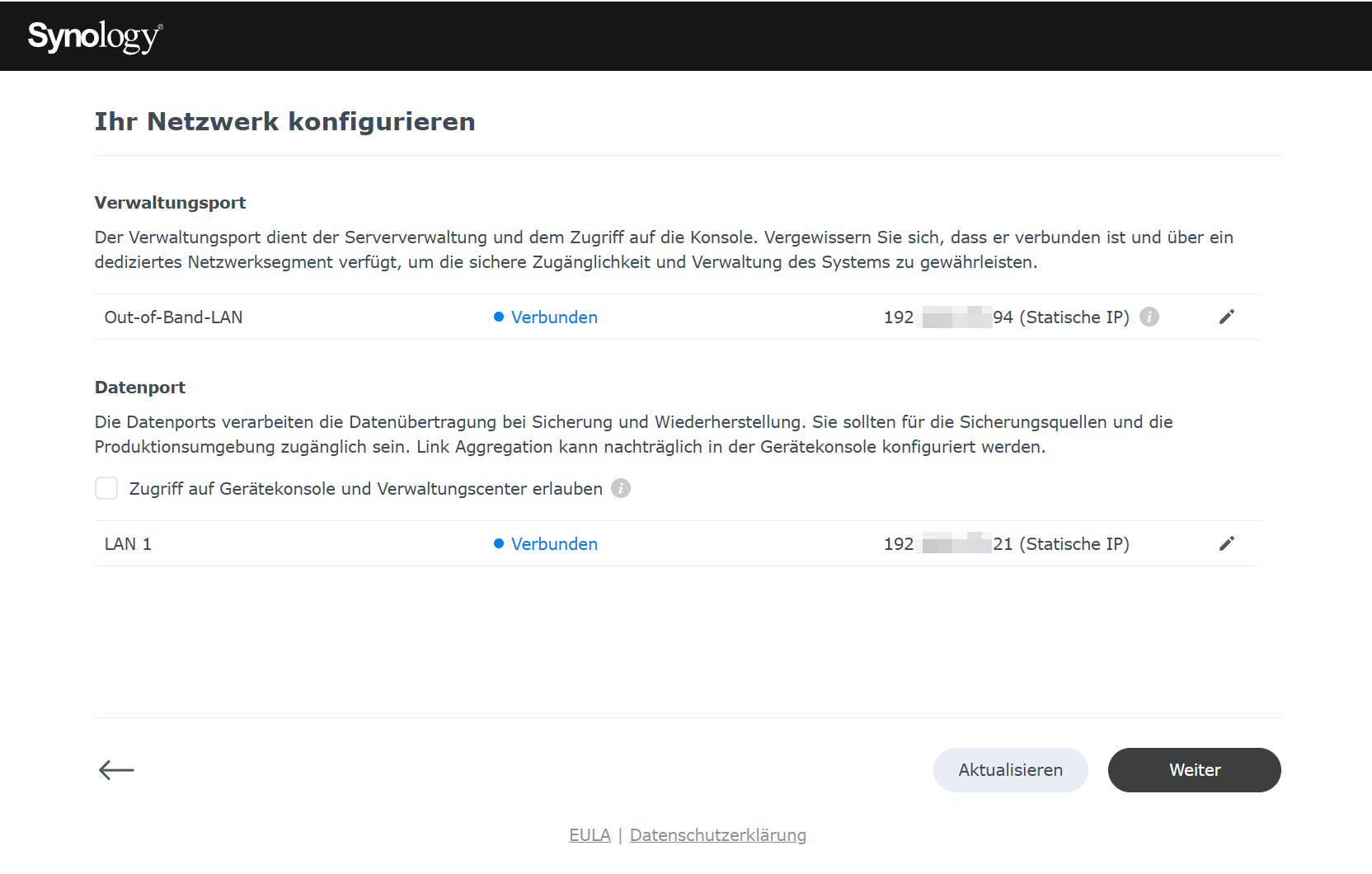

Bis hierhin war die Installation identisch zu einem Synology DSM. Der nächste Schritt zeigt nun aber den ersten Unterschied.

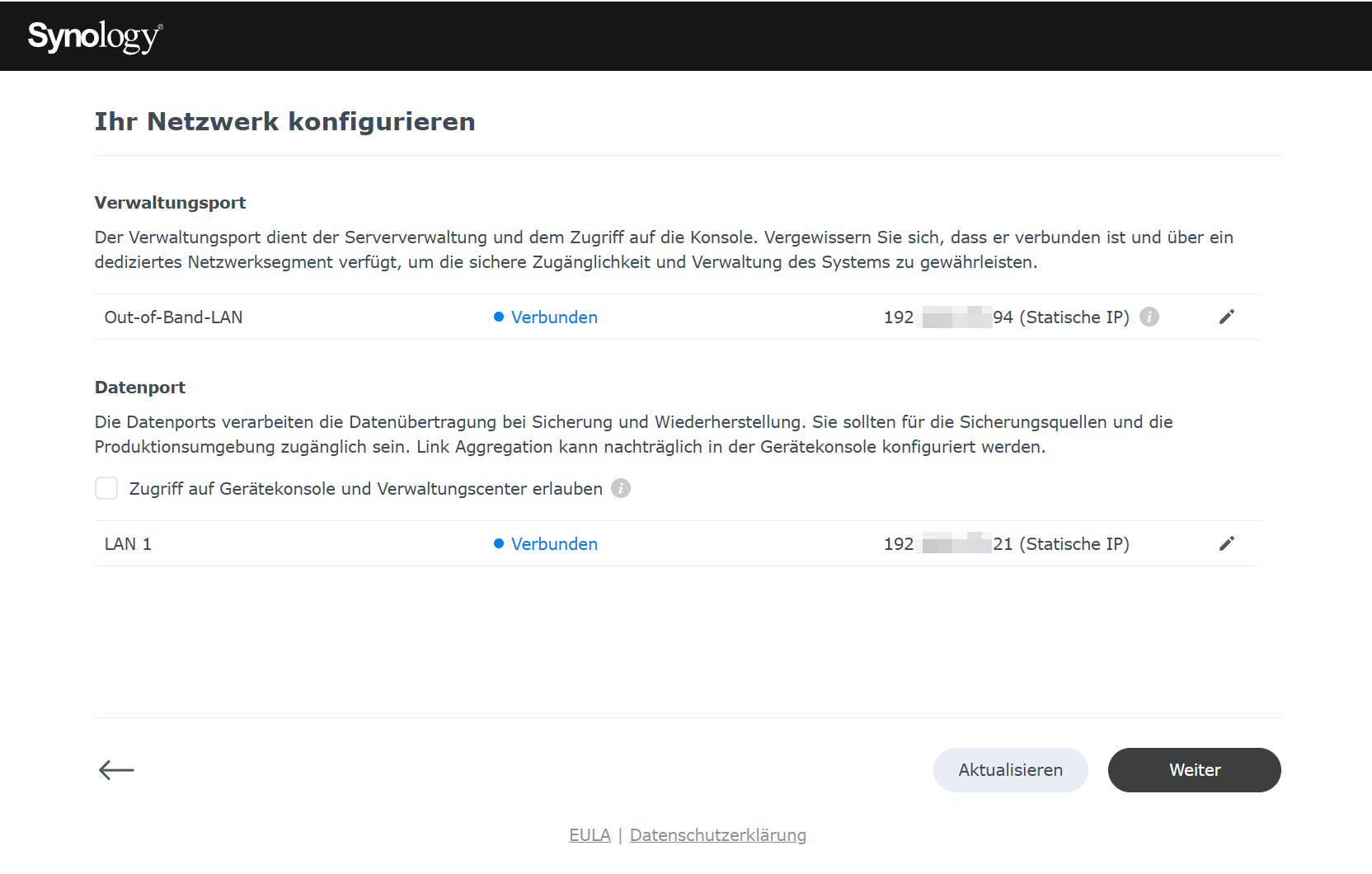

Hier lässt sich nun das Management und das Datennetzwerk getrennt einrichten. Das ist nun auch der Schritt an dem das LAN-Kabel in den Data-Port eingesteckt werden kann. Nach der Aktualisierung sieht man auch, dass sich das Netzwerk nun verbunden hat. An dieser Stelle habe ich für den Data-Port eine statische IP-Adresse vergeben, für den Management Port werde ich das später noch durchführen.

Hier ist anzumerken dass der Management Port bei mir auf DHCP steht, hier aber als statische IP behandelt wird. Der Tooltip dazu zeigt folgende Info an: Die diesem DHCP-Server zugewiesene IP-Adresse wird in APM als statische IP-Adresse behandelt. Führen Sie Änderungen an Ihrer Netzwerkkonfiguration mit Sorgfalt durch, um Konflikte mit IP-Adressen zu vermeiden.

Es gibt auch noch die Möglichkeit den Data-Port ebenfalls für das Management zu nutzen, das lasse ich hier aber mit Absicht weg.

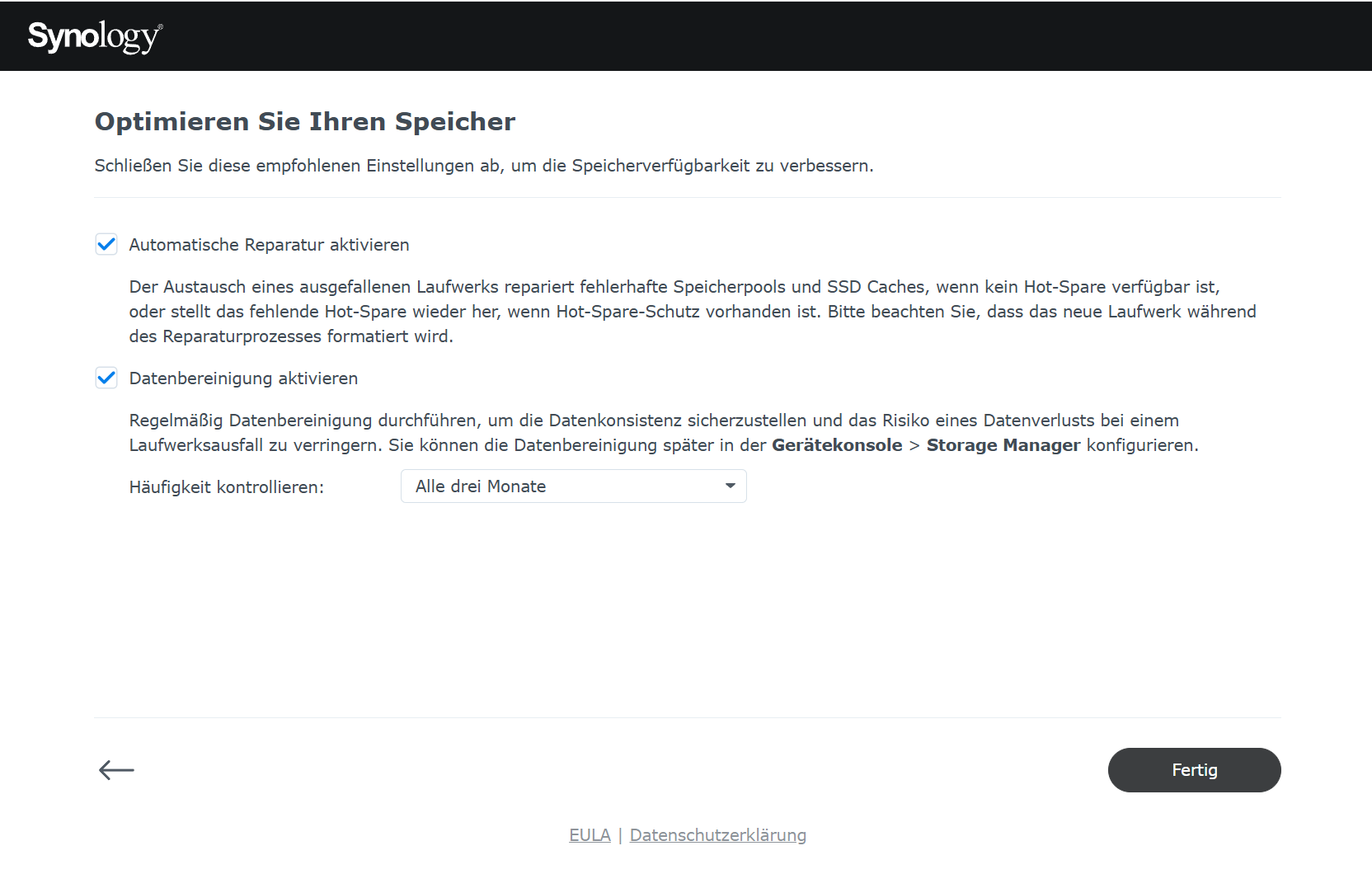

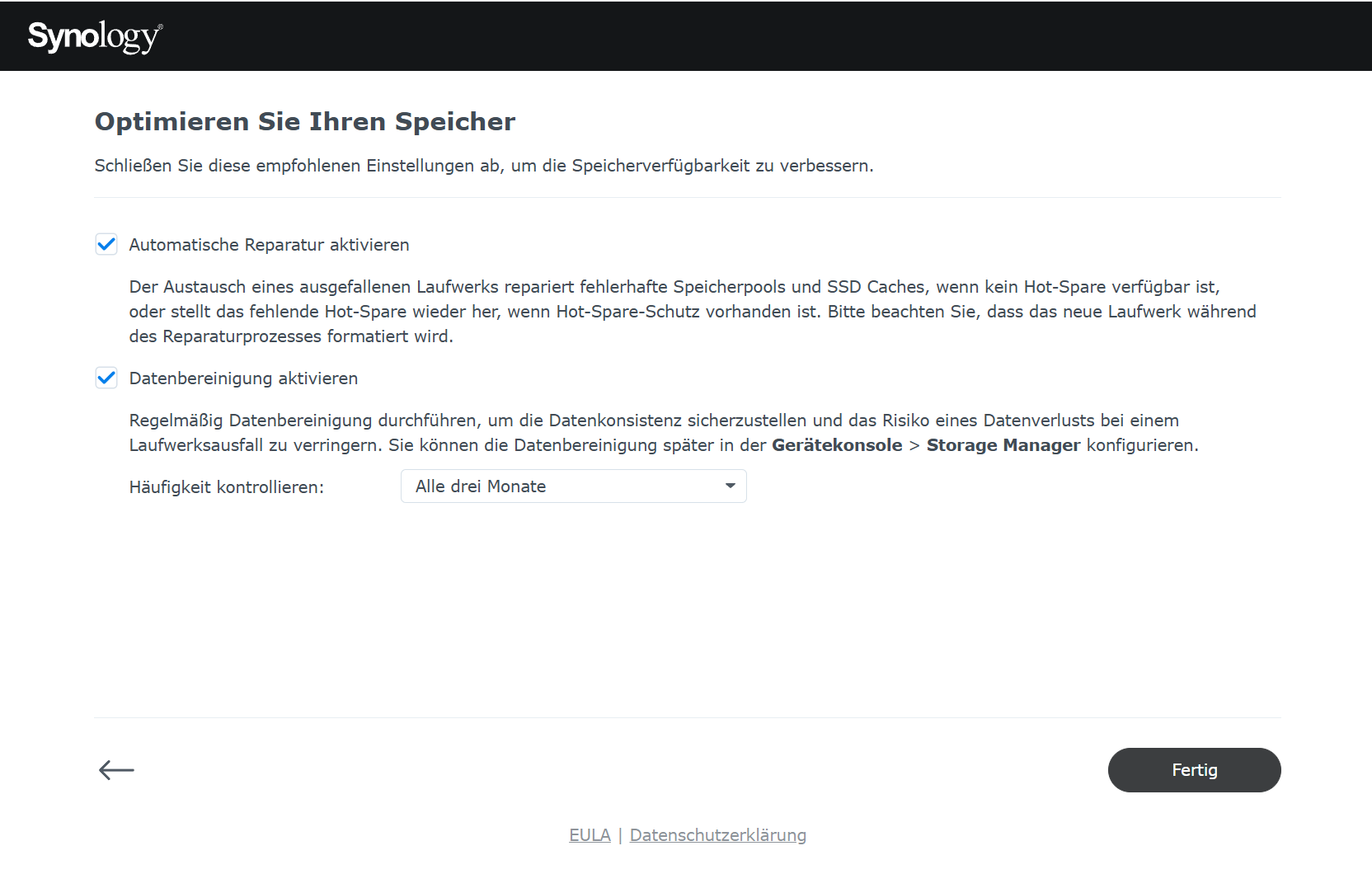

Nun gibt es noch die Option die Speicheroptimierungen einzurichten. Diese Einstellungen lasse ich ebenfalls beide aktiv.

Zum Schluss muss noch einmal etwas Geduld mit bringen bis alle Einstellungen fertig konfiguriert sind. Die 15 Minuten sind aber sehr großzügig bemessen und bei mir war die Konfiguration nach ca. 2 Minuten abgeschlossen.

Im Anschluss wird man mit der Weboberfläche begrüßt und erhält einen kleinen Einführungs-Assistenten um die ersten Workload uns Server zu hinterlegen. Diesen habe ich aber übersprungen.

Die Tests fanden in unterschiedlichen Umgebungen statt einmal direkt auf dem NAS und einmal direkt an meinem PC per SATA. Hierbei ging es mir um die nackte Performance der Festplatte, ohne das Betriebssystem als Overhead, damit auch ihr ein Gefühl für die HAT3310-Festplatten bekommt.

Auf die einzelnen Tests gehe ich an den entsprechenden Stellen kurz ein und stelle dann die Ergebnisse vor.

Das Ergebnis aus diesem Test: Die Festplatten können mit den größeren HAT5300 die in meinem Synology DS220+ verbaut sind mithalten, allerdings sind die größeren Modelle konstanter in der Leistung. So waren diese bei den Test mit /dev/zero durchgehend bei über 200 MB/s.

Da das Netzwerkinterface allerdings sowieso nur 1 GBit/s liefert sollte das aber kein Problem darstellen.

![2025-04-13 21_23_57-CrystalDiskMark 8.0.6 x64 [Admin].png 2025-04-13 21_23_57-CrystalDiskMark 8.0.6 x64 [Admin].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-13-21-23-57-crystaldiskmark-8-0-6-x64-admin.png)

Das Lesen der selben Datei ist auf einem sehr konstanten Wert von ca. 250 MB/s.

Hier die Ergebnisse.

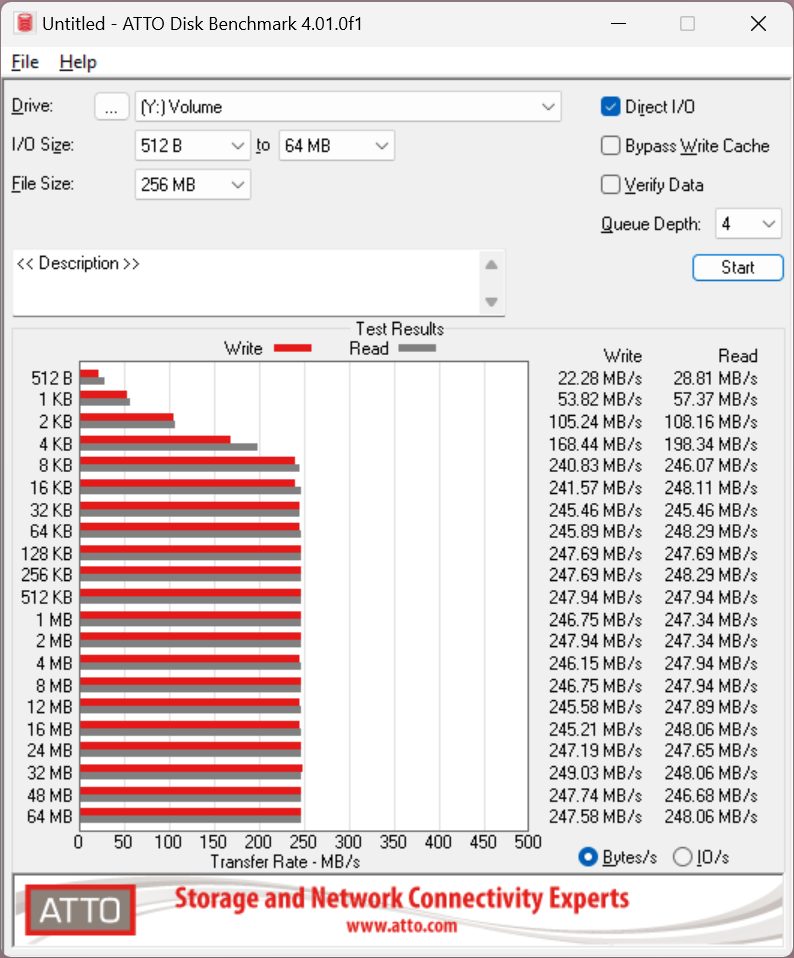

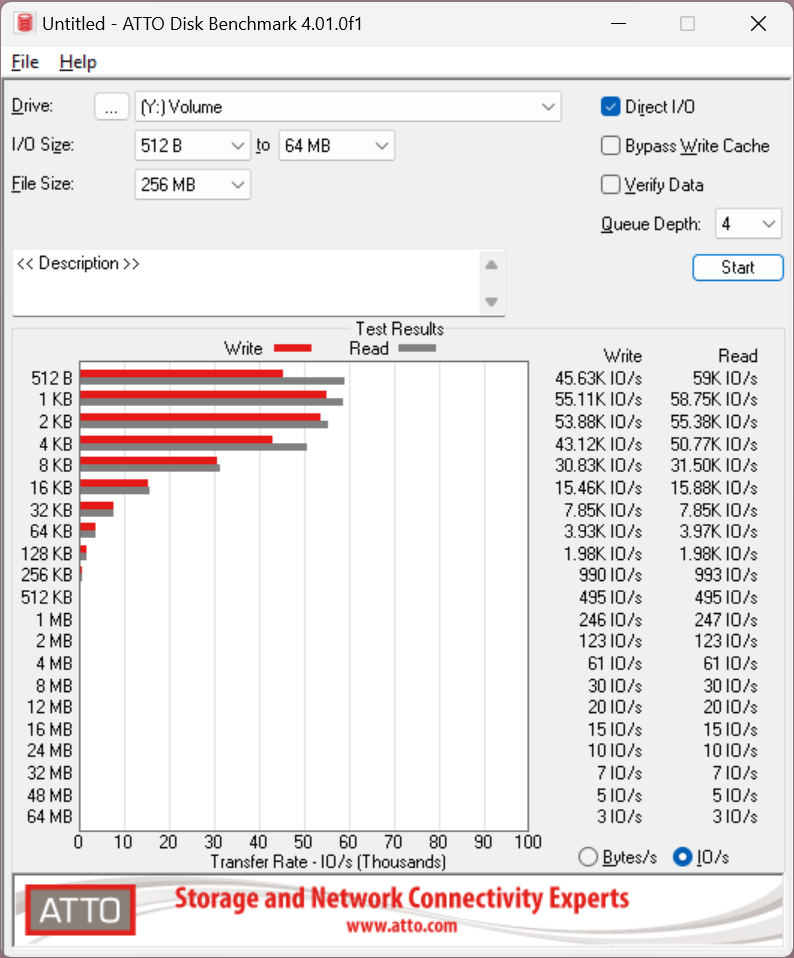

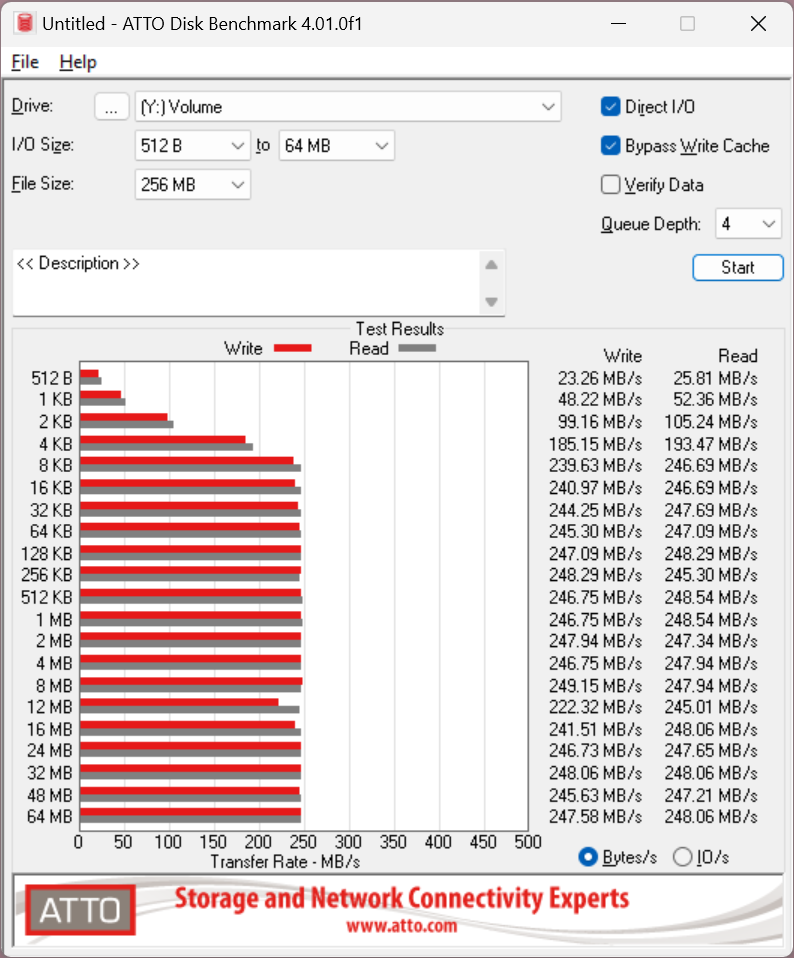

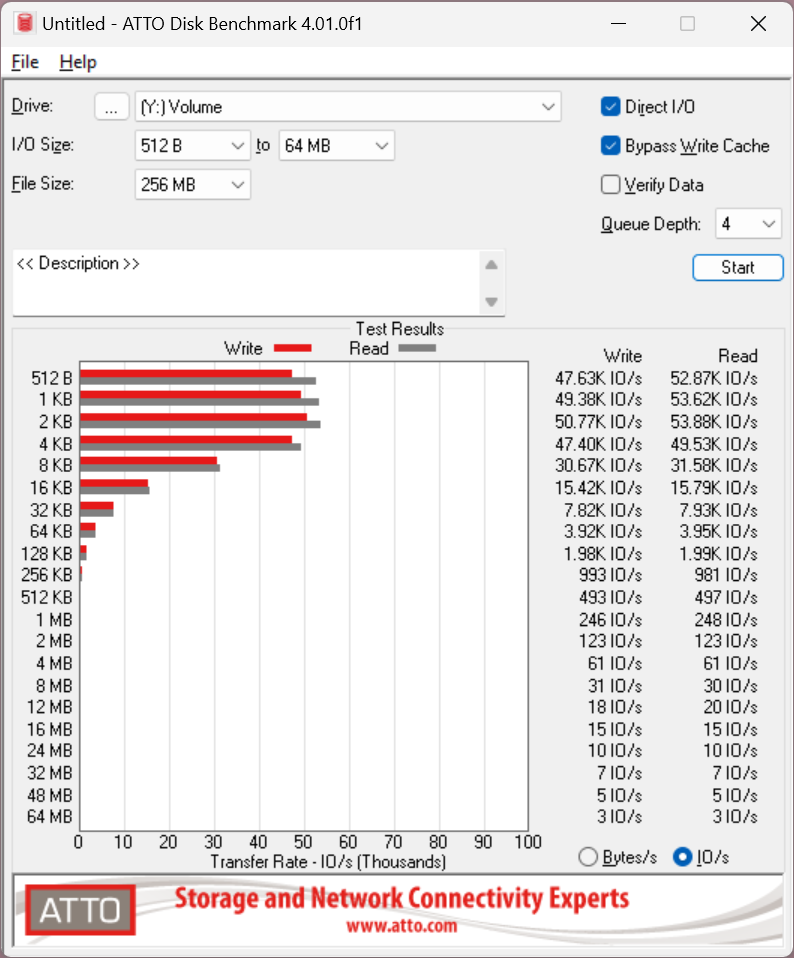

mit Write Cache

ohne Write Cache

Damit liegt die Platte auf den Werten andere NAS Festplatten und muss sich definitiv nicht verstecken.

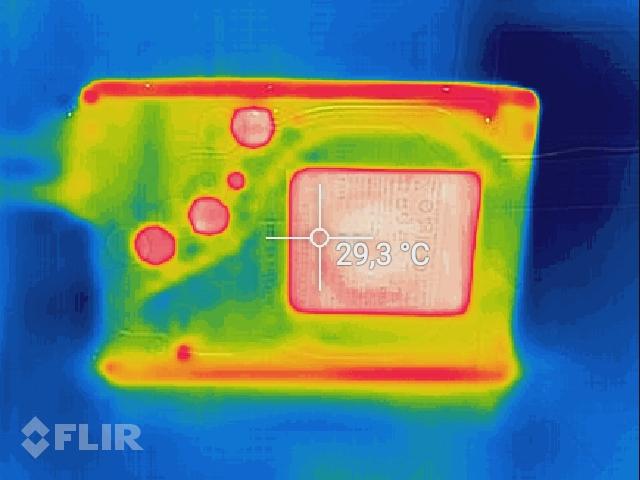

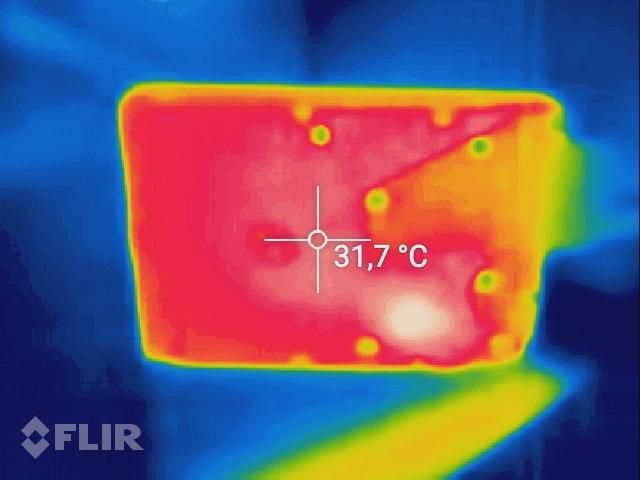

Vorderseite:

Rückseite:

Die Frontseite ist angenehm kühl mit knapp unter 30°C und auch die Rückseite mit der Platine ist bei den Tests nicht ganz handwarm geworden mit Maximalwerten (heller Spot unten rechts) um die 35°C.

Dabei konnte ich ganz knapp das volle Gigabit ausschöpfen.

![2025-04-14 22_22_30-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-14 22_22_30-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-14-22-22-30-remote-desktop-manager-hama-bak01-management.png)

Auch nach mehreren Tagen im Betrieb hat die Performance des Systems nicht nachgelassen. Die Backups und auch Restores klappen gefühlt mit der gleichen Geschwindigkeit wie am ersten Tag. Das finde ich super, da viele Systeme hier nach kurzer Zeit schon etwas nachlassen.

Selbst ein Neustart der Appliance ist in weniger als 2 Minuten abgeschlossen, so dass man das System auch problemlos unter Tags neu starten kann ohne lange auf die Oberfläche zu warten.

Der Appliance kann ich damit eine durchgehend stabile und gleichbleibende Performance attestieren.

Die ActiveProtect-Appliances kommen mit einer zentralen Verwaltungskonsole namens ActiveProtect Manager (APM), über die man alle Backup- und Wiederherstellungsaufgaben steuern kann. Egal ob physische oder virtuelle Server, Endgeräte wie PCs oder Laptops, Datenbanken oder Microsoft 365, alles wird von hier aus verwaltet. Die Plattform ist dabei so ausgelegt, dass sie bis zu 150.000 Workloads oder 2.500 Standorte stemmen kann. Das macht sie auch für größere, verteilte Umgebungen interessant.

Was ActiveProtect so besonders macht:

Was mir allerdings etwas negativ aufgefallen ist, ist die fehlende Möglichkeit mit der DP320 mein Active Backup auf meiner DS220+ zu verwalten. Das ist leider nur den großen Modellen vorbehalten. Schade!

ActiveProtect ist eher für Unternehmen gedacht, die eine zentrale und sichere Backup-Infrastruktur suchen, während ABB ein flexibles Backup-Paket für Synology NAS-Systeme ist.

Als langjähriger Nutzer von Synology DSM und den Plus-Modellen, sowohl privat als auch bei Kunden, habe ich natürlich mit der "alten" Sicherungslösung einiges an Erfahrung sammeln können. Ich möchte hier gerne einmal auf die funktionalen Unterschiede der beiden Lösungen eingehen.

Nach einiger Zeit im Betrieb sind mir deshalb die folgenden Defizite von ActiveProtect im Vergleich zu Active Backup aufgefallen:

Für alle die den Begriff noch nicht kennen, hier eine kleine Tabelle dazu mit den wichtigsten Aspekten:

Hier lassen sich die wichtigsten Unterschiede herauslesen. Die Vorteile liegen vor allem in der Unveränderbarkeit der gesicherten Daten. Diese können weder durch einen User, noch einen Admin auf dem System verändert oder gelöscht werden. Das bedeutet aber auch, dass man eine gute Backupplanung erstellen muss, denn wenn ein Speicher vollläuft kann man nicht durch die Löschung alter Backups Platz gewinnen.

Die einzige Möglichkeit die Daten zu löschen ist den RAID zu zerstören bzw. die Festplatten zu formatieren.

Dadurch ergeben sich folgende Vor- und Nachteile (Fett = Vorteil, Kursiv = Nachteil)

Ein Immutable Backup ist hierbei besonders für kritische Daten interessant, also Daten oder Server die z.B. Dokumente beherbergen, Finanzdaten oder andere geschäftskritische Daten vorhalten müssen.

Dabei sollte man aber auch immer die DSGVO im Hinterkopf behalten, so sollten z.B. Bewerberdaten nicht auf einem Immutable Speicher liegen, da diese nach einer bestimmten Zeit gelöscht werden müssen.

Andere Daten für das Finanzamt wiederum müssen 10 Jahre vorgehalten werden und dürfen in dieser Zeit nicht verändert werden, hier bietet sich ein Plan mit einem Immutable Backup an.

Natürlich wollte ich auch prüfen ob die Daten wirklich unlöschbar sind. Über die Oberfläche kann ich das auf jeden Fall bestätigen, hier erhält man direkt eine Infobox die einem mitteilt dass der Workload nicht gelöscht werden kann.

![2025-05-04 22_57_31-Remote Desktop Manager [hama-bak01].png 2025-05-04 22_57_31-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-04-22-57-31-remote-desktop-manager-hama-bak01.png)

Was macht also der clevere IT-ler? Er versucht es über die Kommandozeile mit dem root-User.

Hier konnte ich die Dateien ohne Probleme löschen mit einem einfachen rm Befehl. Das hat mich wenn ich ehrlich bin etwas geschockt. Hier dazu noch der passende Screenshot:

![2025-05-04 23_47_22-Remote Desktop Manager [hama-bak01].png 2025-05-04 23_47_22-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-04-23-47-22-remote-desktop-manager-hama-bak01.png)

Wenn ich nun versuche die Version im Wiederherstellungsportal zu öffnen erhalte ich auch eine Fehlermeldung und soll mich an den Synology-Support wenden.

Das habe ich tatsächlich nicht erwartet, da eine "Immutable Backup" die Daten vor jeglicher Veränderung oder Löschung schützten soll. Das ist hier aber faktisch nicht gegeben. In meinem Fall müsste nur jemand die SSH Verbindung hacken und könnte meine kompletten Daten löschen.

Viele werden nun sicher schreiben: Dann trenne doch das Management Netzwerk vom Backup Netzwerk. Das mag korrekt sein, aber solange es die Funktion gibt, reicht auch schon eine Schwachstelle in der Software mit der sich ein Angreifer root-Rechte erschleichen kann um die Backups zu löschen oder zu kompromittieren.

Hier muss also definitiv noch etwas passieren, mindestens ein Hinweis in der Oberfläche welche Art von Immutability genutzt wird (Enterprise = löschbar oder Compliance = unlöschbar). Leider habe ich nichts dergleichen im System entdecken können. Besser wäre es noch die Art der Immutability selbst wählen zu können wie dies unter DSM mit der WORM Funktion der Fall ist.

![2025-04-22 23_56_50-Remote Desktop Manager [hama-bak01].png 2025-04-22 23_56_50-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-22-23-56-50-remote-desktop-manager-hama-bak01.png)

Hier sieht man das neue Dashboard, das wichtige Informationen an einer zentralen Stelle sammelt, z.B. ob Backups erfolgreich waren oder fehlgeschlagen sind, wie die Speicherverteilung nach der Deduplizierung aussieht und und ob in den vergangenen Tagen die Sicherungen erfolgreich waren oder ob es Probleme gab. Diese Art des Dashboards kennt man aber schon aus dem Active Backup for Business (ABB), hier ist die Ansicht dafür etwas moderner gestaltet.

![2025-04-22 23_57_08-Remote Desktop Manager [hama-bak01].png 2025-04-22 23_57_08-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-22-23-57-08-remote-desktop-manager-hama-bak01.png)

In der Serverübersicht sieht man alle gesicherten Systemen im Überblick, das finde ich besser gelöst als beim bisher genutzten Vorgänger ABB. Man sieht sofort und über alle Systeme hinweg ob eine Sicherung erfolgreich war, wie groß die Sicherung ist, wann diese das letzte Mal lief und den Verlauf der letzten 30 Tage.

![2025-04-22 23_57_15-Remote Desktop Manager [hama-bak01].png 2025-04-22 23_57_15-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-22-23-57-15-remote-desktop-manager-hama-bak01.png)

Ebenso aufgeräumt sieht die Ansicht beim MS365 Backup aus. Auch hier sieht man sofort welches Objekt man gerade prüfen bzw. Wiederherstellen möchte, wie groß das Backup ist und ob es gelaufen ist oder nicht. An dieser Stelle ein großes Lob an Synology.

Ebenso einfach ist es den Sicherungsplan zu wechseln. Musste man hierzu im ABB eine Aufgabe editieren, kann man hier einfach per Rechtsklick einen neuen Plan mit den entsprechenden Einstellungen auswählen.

Doch auch das ActiveProtect (AP) bietet über den Port 5001 noch die alte Oberfläche an, jedoch mit deutlich reduziertem Funktionsumfang, sowohl auf der Oberfläche selbst als auch in der Systemsteuerung. Diese Oberfläche steht aber auch nicht im Mittelpunkt der neuen Lösung.

![2025-04-23 00_14_04-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 00_14_04-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-00-14-04-remote-desktop-manager-hama-bak01-management.png)

Um diese zu erstellen benötigt es eigentlich nur zwei Dinge:

Der Wizard besteht dabei aus 7 Schritten.

Für virtuelle Workloads entfällt der Verbindungsschlüssel, hier muss man lediglich die Zugangsdaten eintragen und kann im Anschluss die virtuellen Maschinen manuell auswählen oder alle VMs in einen automatischen Sicherungsplan aufnehmen.

Nach ca. 2,5 Wochen sieht die Übersicht der Backups dann z.B. wie folgt aus:

![2025-05-02 21_36_20-Remote Desktop Manager [hama-bak01].png 2025-05-02 21_36_20-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-02-21-36-20-remote-desktop-manager-hama-bak01.png)

Die Last während eines Backups auf dem System selbst ist relativ hoch, da die Appliance aber nicht anderes macht außer Backups sollte das allerdings auch kein Problem darstellen.

![2025-05-02 21_26_12-Remote Desktop Manager [hama-bak01].png 2025-05-02 21_26_12-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-02-21-26-12-remote-desktop-manager-hama-bak01.png)

Diese neue Funktion finde ich super, da nun das 3-2-1 Backups System einfacher umsetzbar ist. Eine externe Kopie lässt sich hier direkt im Anschluss an das eigentliche Backup erstellen. Bisher musste man sich im Synology-Umfeld hier mit zeitlich aufeinander abgestimmten Workarounds wie HyperBackup oder Snapshot Replication behelfen.

Allerdings kann man hier lediglich zwischen einer weiteren ActiveProtect Appliance, Synology C2 Block Storage und Amazon S3 auswählen kann. Wäre hier beispielsweise noch ein SMB-Server oder rsync an einen weiteren Standort möglich dann wäre dieses Feature um einiges hilfreicher.

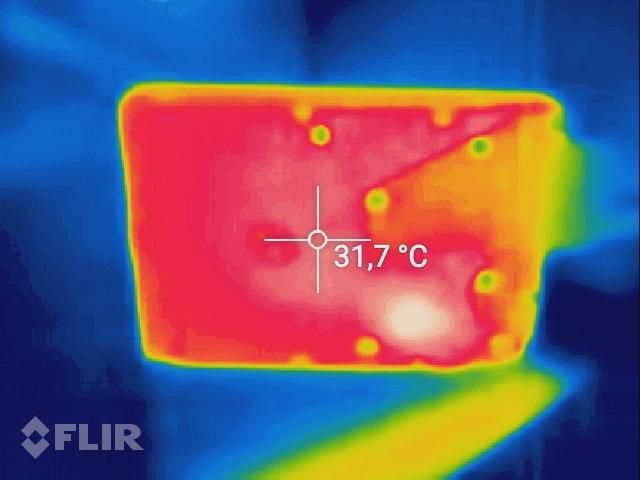

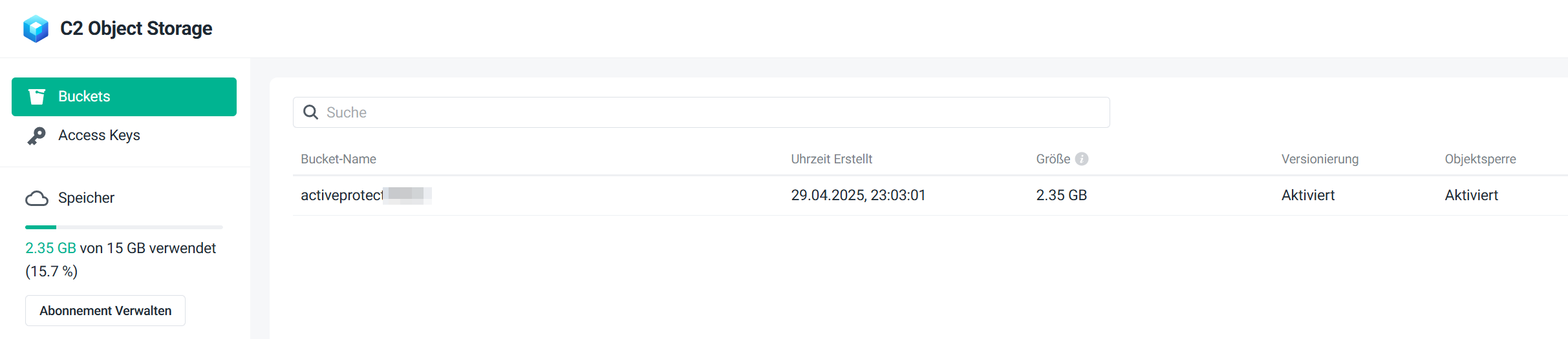

So habe ich eben nur mein Paperless zum Test auf den kostenlosen Synology C2 Speicher mit 15GB gesichert.

Das wiederum hat wunderbar geklappt.

Sicherlich gibt es hier auch Use-Cases in denen mehr als eine Sicherungskopie gewünscht ist. Das ist aber mit dem aktuellen Softwarestand von ActiveProtect nicht möglich oder ich habe die Funktion schlicht nicht gefunden.

In der C2 Weboberfläche sieht man dann die gesicherten Daten. Bzw. um genau zu sein sieht man nur Chunks, da die Daten vollständig verschlüsselt sind, aber man sieht die Speicherbelegung.

Sollte eine Wiederherstellung der gesicherten Daten nicht möglich sein kann ich mir das Backup auch komplett sparen und einfach auf gut Glück durch den Tag leben.

Genau aus diesem Grund hab ich mir aber natürlich auch die Wiederherstellungsfunktionen von ActiveProtect angeschaut. Diese sind vom Umfang her identisch mit denen von Active Backup. Es gibt ein Wiederherstellungsportal, in dem man komplette VMs oder auch nur einzelnen Dateien aus den VMs wiederherstellen kann, es gibt die Möglichkeit gesicherte Clients und native Server über einen bootbaren USB-Stick direkt auf Bare-Metal wiederherzustellen und man kann E-Mails, Dateien, Chats und mehr aus MS365 Umgebungen wiederherstellen.

Dazu sucht man sich in der Oberfläche eine gesicherte Workload aus und kann dann per Rechtsklick im Kontextmenü das Wiederherstellungsportal auswählen. Hier findet man nun den File-Level-Restore der gesicherten Workloads und kann die Dateien entweder direkt auf dem System selbst wiederherstellen oder einfach herunterladen und dann auf eine andere Art und Weise zur Verfügung stellen.

Gesicherte "Server" kann ich alternativ auch zu einer virtuellen Maschine wandeln. Damit habe ich quasi die Möglichkeit, native Systeme zu sichern und danach als VM weiter zu betreiben sollte ich diese in der Zukunft noch einmal benötigen.

Diese Funktion ist auf der DP320 leider sehr eingeschränkt. Während die größeren Modelle hier auf dem Papier die Möglichkeit bieten mehrere gesicherte Umgebungen gleichzeitig zu starten und auch z.B. Malware-Scans vor dem Restore durchzuführen, beschränkt sich die Sandbox-Umgebung auf der DP320 lediglich darauf die Server und VMs auf die Restore-Fähigkeit zu prüfen. Das heißt: Server hochfahren & Login Bildschirm abwarten und das alles als kurzes Video aufzeichnen.

Hier hätte mich mir etwas mehr Funktionalität gewünscht, vor allem den Malware-Scan. Auch kleine Umgebungen oder Unternehmen könnten von dieser Funktion profitieren und haben auch sicher nicht wirklich etwas dagegen wenn das Backup oder der Restore dafür etwas länger dauert.

Mein System hat nach nicht ganz 4 Wochen Testbetrieb ein Deduplizierungsrate von 51%.

![2025-05-05 21_19_48-Remote Desktop Manager [hama-bak01].png 2025-05-05 21_19_48-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-19-48-remote-desktop-manager-hama-bak01.png)

Damit ist die Appliance nun zu 22% belegt und hat noch Luft für zukünftige Sicherungen.

Da das System auch die Abfrage über SNMP anbietet habe ich das System auch in mein Checkmk aufgenommen und geprüft was sich auslesen lässt. Mit dabei sind CPU, Memory, Festplatte, Netzwerkinterfaces, RAID Status, HDD Temperaturen, usw. Damit ist eine vollumfängliche Überwachung möglich und ich kann rechtzeitig reagieren, da ich die Benachrichtigungen aus meinem Checkmk per Push auf mein Smartphone erhalten.

![2025-05-05 21_29_58-Remote Desktop Manager [Check_MK Web].png 2025-05-05 21_29_58-Remote Desktop Manager [Check_MK Web].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-29-58-remote-desktop-manager-check-mk-web.png)

![2025-05-05 21_30_16-Remote Desktop Manager [Check_MK Web].png 2025-05-05 21_30_16-Remote Desktop Manager [Check_MK Web].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-30-16-remote-desktop-manager-check-mk-web.png)

![2025-05-05 21_30_31-Remote Desktop Manager [Check_MK Web].png 2025-05-05 21_30_31-Remote Desktop Manager [Check_MK Web].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-30-31-remote-desktop-manager-check-mk-web.png)

Leider war ich von der Oberfläche selbst etwas enttäuscht, da es hier keinerlei Hinweise auf eine defekte Festplatte gibt, weder im Dashboard noch in der Ansicht des Sicherungsservers. Erst in den Speicher-Details des Sicherungsservers gab es dann einen Hinweis dass eine Platte ausgefallen ist.

![2025-04-23 21_02_12-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_02_12-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-02-12-remote-desktop-manager-hama-bak01.png)

![2025-04-23 21_02_22-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_02_22-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-02-22-remote-desktop-manager-hama-bak01.png)

![2025-04-23 21_04_04-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_04_04-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-04-23-21-04-04-remote-desktop-manager-hama-bak01.png)

In der Gerätemanager-Oberfläche hingegen wird man quasi an jeder Stelle auf den Fehler aufmerksam gemacht.

![2025-04-23 21_02_57-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 21_02_57-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-02-57-remote-desktop-manager-hama-bak01-management.png)

![2025-04-23 21_01_32-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 21_01_32-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-01-32-remote-desktop-manager-hama-bak01-management.png)

Um es dem System schwer zu machen habe ich die Festplatte per SATA wieder an meinen Rechner angesteckt, mit NTFS neu formatiert, ein paar ISOs abgelegt und danach die Platte wieder zurück in das DP320 gesteckt.

Die Festplatte wurde anstandslos wiedererkannt und das System hat auch direkt mit der Reparatur des RAID1 begonnen. Dazu wurde zu Beginn die Systempartition geprüft was keine 3 Minuten gedauert hat.

![2025-04-23 21_03_51-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 21_03_51-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-03-51-remote-desktop-manager-hama-bak01-management.png)

Im Anschluss wurde mit der eigentlichen Reparatur des RAID begonnen. Dieser Vorgang läuft etwas länger, da die Festplatte einen neuen Spiegel aller Daten der noch funktionierenden Platte erhält.

![2025-04-23 21_05_32-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_05_32-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-05-32-remote-desktop-manager-hama-bak01.png)

Die technische Umsetzung eines Plattenausfalls ist wie bei allen anderen Systemen von Synology tadellos und hier gibt es nicht zu bemängeln. Allerdings hätte ich mir im Dashboard der AP-Oberfläche einen Hinweis gewünscht, dass etwas mit der Hardware bzw. den Festplatten nicht in Ordnung ist. Hier ist aus meiner Sicht noch Nachholbedarf.

Der Zugriff per SSH war mir ausschließlich mit den folgendem Befehl möglich: ssh -c aes128-cbc -m hmac-sha1 -oHostKeyAlgorithms=+ssh-rsa -oKexAlgorithms=+diffie-hellman-group1-sha1 -p 57 sascha@192.168.178.20

Hier sieht man die veralteten Ciphers. Mac-Keys und Algorithmen. Eine Möglichkeit diese anzupassen habe ich leider nicht gefunden, hier sollte Synology auf jeden Fall nachbessern und aktuelle Werte akzeptieren, da die hier genannten Werte seit den Jahren 2015-2017 als Unsicher zu betrachten sind.

Bei einem Standby Stromverbrauch von durchschnittlich 24W (gemessen) kommen hier ca. 0,43 kWh / Tag zusammen die ich mir sparen kann.

Etwas gerundet (Verbrauch 0,5 kWh, Strompreis 30 Cent / kWh) spare ich mir hier dann ganze 15 kWh bzw. grob 4,50€ pro Monat ein. Geld dass ich lieber in meine Kinder investiere.

Im Betrieb braucht die Appliance grob 30W. das ist aus meiner Sicht ein guter Wert für 2x 3,5 Zoll Festplatten.

Leider gibt es bei der ActiveProtect Appliance keine Möglichkeit im Vergleich zu DSM einen Aus- & Einschalt-Timer anzulegen. Also musste ich mir einen Workaround über meinen HomeAssistant bauen der mein NAS über einen SSH Befehl mit "expect" herunterfährt und per WoL wieder hochfährt. Vielleicht folgt diese Funktion aber noch in Zukunft.

Doch wo Licht ist, ist auch Schatten. So finde ich es immer noch schade dass weiterhin keine Unterstützung für ARM-basierte Server vorhanden ist mit dem ActiveProtect Agent. Gerade im Zeitalter von energieeffizienten ARM-Servern, die in immer mehr Unternehmen und Home-Labs zum Einsatz kommen, ist das schlicht nicht mehr zeitgemäß.

Ebenso enttäuschend oder sogar schon schlimmer: Proxmox, eine der aktuell beliebtesten Open-Source-Virtualisierungslösungen nach der Aktion von Broadcom, wird immer noch nicht unterstützt. Für viele IT-Profis und Admins ist das ein echter Showstopper, gerade weil Proxmox im Mittelstand und bei IT-affinen Nutzern sehr beliebt und weit verbreitet ist.

Ein weiterer und massiver Kritikpunkt ist die unsichere Standardkonfiguration der SSH-Verbindung. In einer Backup-Appliance, die per Definition sensible Daten verwaltet, darf so etwas einfach nicht passieren. SHA1 ist schon seit mehreren Jahren nicht mehr sicher. Hier muss Synology dringend nachbessern, besser gestern als morgen. Sicherheit darf keine Option, sondern muss Standard sein.

Auch die künstliche Trennung der Produktlinien ist ärgerlich: Die Möglichkeit, bestehende ABB-Installationen auf kleineren Modellen zentral zu verwalten, bleibt den großen Appliances vorbehalten. Ebenso die abgespeckte Sandbox-Umgebung bei den kleinen Modellen finde ich schade.

Unterm Strich ist die DP320 eine leistungsfähige und angenehm unkomplizierte Backup-Appliance, die gerade für klassische x86-Umgebungen eine echte Empfehlung bleibt. Wer auf ARM-Server-Backups, Proxmox-Support oder maximale Sicherheit out-of-the-box setzt, findet hier zwar noch nicht alle Wünsche erfüllt, doch Synology zeigt mit der ActiveProtect-Serie, dass viel Potenzial und Komfort in einer modernen Backup-Lösung stecken kann. Wer mit den aktuellen Einschränkungen leben kann, bekommt ein zuverlässiges, schnelles und erfreulich wartungsarmes System, das im Alltag überzeugt und mit zukünftigen Updates hoffentlich noch weiter an Reife gewinnen wird.

Vielen Dank an dieser Stelle an die Hardwareluxx Media GmbH und Synology Deutschland für das Testgerät und die Möglichkeit dieses Reviews. Der Test hat mir viel Spaß gemacht und ich werde das Gerät trotz meiner gemischten Gefühle weiter nutzen, auch in der Hoffnung dass hier in naher Zukunft noch Firmware Updates kommen werden die den Funktionsumfang und die Sicherheit erhöhen.

Euer Sascha (Man-in-Black)

zu aller erst vielen Dank dafür, dass ich die Möglichkeit erhalte habe ein nagelneues Produkt von Synology so kurz nach dem Marktstart testen zu dürfen.

Hinweis zum Review: Die Bilder sind von meinem Server verlinkt, da ich hier im Forum nicht genug hochladen konnte, sollte aber flott laden

Ein bisschen was zu mir

Ich habe die IT im Alter von 8 Jahren für mich entdeckt und auch heute, 31 Jahre später, ist die IT immer noch ein großes Hobby von mir, welches ich auch vor 17 Jahren zum Beruf gemacht habe.Begonnen am PC meines Vaters, meinen ersten eigenen PC mit 10 Jahren, kurze Ausflüge in die Linux-Welt, meinen ersten selbst zusammengebauten Rechner, ein Studium in technischer Informatik inkl. Abschluss und schlussendlich dann meine Berufung zum Beruf gemacht. In dieser ganzen Zeit konnte ich dabei einiges Wissen in vielen Gebieten der IT sammeln.

Als ich für den Lesertest ausgewählt wurde hat mich das sehr gefreut, da mein bestehendes Synology DS220+ inzwischen aus allen Nähten platzt da es sowohl für den Produktivbetrieb als auch für meine Backups zuständig ist. Außerdem interessiert mich die neue Backuplösung grundsätzlich um meinen Wissensdurst zu befriedigen und ggfs. auch direkt etwas für die Arbeit zu lernen.

Synology DP320

Fangen wir zuerst einmal mit den technischen Daten an, die sich auch alle so auf der Homepage von Synology wiederfinden.Allgemeine Spezifikationen

| Empfohlene Sicherungsquelle | 5 TB |

| Empfohlene integrierte wiederhergestellte VMs | 1 |

Technische Daten

| CPU | AMD Ryzen R6000 (2 Kerne) |

| Arbeitsspeicher | 8 GB DDR4 ECC SODIMM |

| Steckplätze für Arbeitsspeicher | 2 (beide bestückt) |

| Laufwerkstyp | 2 x 3,5" SATA HDD/SSD - 2 x 8 TB HDD (Raid 1) |

| Hot-Swap-fähig | Ja |

| Externe Anschlüsse | 1x USB 3.0 |

| LAN-Anschlüsse | 2x Gigabit (RJ-45) - 1x Management, 1x Data |

| Wake-on-LAN | Ja |

| Betriebssystem | Synology APM (ActiveProtect Manager) |

| Geräuschentwicklung | Verzichtet, nicht hörbar außer bei Festplattenzugriffen im Alltag zu viele Umgebungsgeräusche |

| Leistungsaufnahme | Idle (Festplatten aus): 1,8W Idle (Festplatten an): 10,9W Schreiben: 16,2W |

Festplatten HAT3310-8T

| Modellnummer | HAT5300-8T |

| MTTF | 1 Millionen Stunden |

| Schnittstelle | SATA III 6 Gbit/s |

| Formfaktor | 3,5‘‘ |

| Drive Design | Luft |

| Sektorgröße | 512e |

| Rotationsgeschwindigkeit | 7200 U/min |

| Puffer | 256 MB |

| Garantie | 3 Jahre |

| Verfahren | CMR |

| Kapazität | 8 TB |

| Workload | 180 TB / Jahr |

| Vibrationen | 2 Hz bis 300 Hz: 7,35 m/s² 300 Hz bis 350 Hz: 4,90 m/s² 350 Hz bis 500 Hz: 2,45 m/s² |

| Geräuschentwicklung | 31 dB (ruhend) 35 dB (suchend) |

| Leistungsaufnahme Leerlauf | 5,61W |

| Leistungsaufnahme Betrieb | 8,41W |

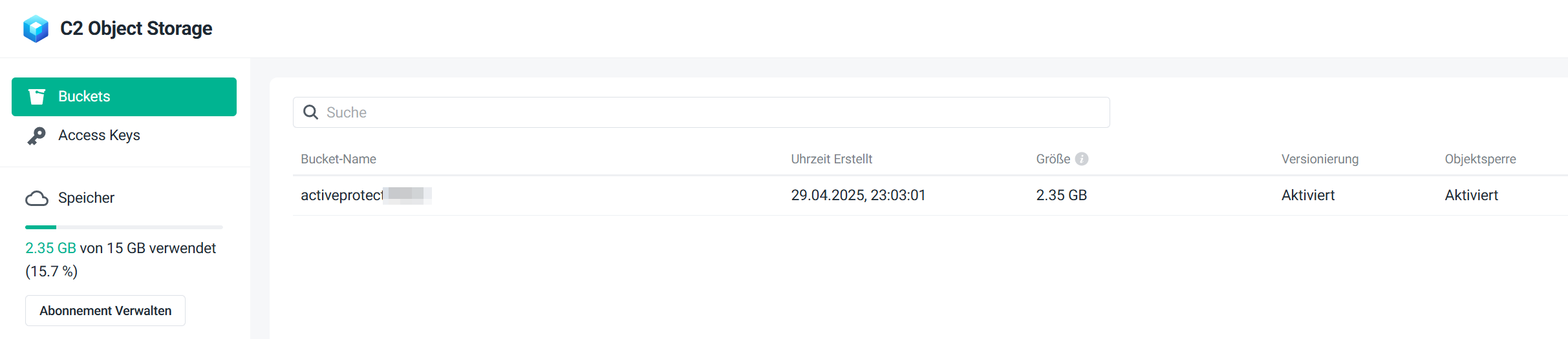

Unboxing

Das Synology kam doppelt verpackt bei mir an, einmal ein großer Versandkarton und darin ein kleinerer Karton mit dem eigentlichen Gerät. Drum herum gab es keine Polsterung oder der gleichen. Ein persönlicher Brief wie damals beim DS220+ war diesmal leider nicht dabei.Folgende Inhalte lagen dem Paket noch bei:

- 1x Synology DP320

- 1x 65W Netzteil

- 1x Kaltgerätekabel

- 2x CAT.5e Netzwerkkabel (jeweils 1,5m)

- 2x Festplatte (HAT3310-8T)

- Schnellanleitung

Vorne befinden sich wie gewohnt die Status-LEDs (Status, Disk 1 & Disk 2), ein USB3 Port sowie 1 Powerbutton.

Auf der Rückseite befinden sich 2 Gigabit-LAN Ports, einer davon als reiner Management Port und der andere Port für die Datenübertragung. Außerdem befindet sich hier der Netzteilanschluss sowie ein Kensington-Lock.

Innen befinden sich ein Festplattenkäfig mit 2 Einschüben, die primär für 3,5’‘ SATA-Festplatten genutzt werden können. Dazu lassen sich die Festplatten mit einem einfachen Klick-Mechanismus einsetzen und arretieren. Mit einem Blick nach innen bei entfernten Festplattenkäfigen sieht man die SATA Anschlüsse für die 2 möglichen Festplatten. Diese sind nach rechts mit dem Mainboard verbunden. Außerdem finden sich auf der rechten Seite auch die 2 ECC RAM Module, die man im Zweifelsfall einfach austauschen kann.

Die beiden mitgelieferten Festplatten sind vom Typ HAT3310-8T der Plus-Serie von Synology. Diese Festplatten wurden speziell für NAS Systeme entwickelt und werden beschrieben als "Zuverlässige Festplatten, speziell entwickelt für Synology Systeme für Privatnutzer und kleine Büros" (Quelle). Mehr als 500.000 Stunden an internen Validierungstests sollen diese Aussage bekräftigen. Vermutlich werde ich aber diese Leistung während des Tests nicht erreichen

Weitere Vorteile sind:

- Entwicklung für den 24/7 Betrieb

- Firmware Updates direkt über das Synology Betriebssystem

- Support aus einer Hand

Die Performancewerte werde ich später im Review prüfen.

Teardown

Als leidenschaftlicher Techniker, Informatiker und Administrator hat mich natürlich nicht nur das Äußere der DP320 Appliance interessiert, sondern auch das Innenleben. Also hab ich kurzerhand zum Schraubenzieher gegriffen und das komplette Gerät demontiert. Lediglich den CPU Kühler habe ich in Ruhe gelassen.Für alle diejenigen die es interessiert hier die Bilder vom Innenleben.

Ich fand dabei interessant zu sehen, dass das Speichermodul für das APM auf einem separaten Modul ist und auch gleich mit der ausgelieferten Version beschriftet ist.

Inbetriebnahme

Installation

Die Installation gestaltet sich wie bei Synology DSM auch hier denkbar einfach. Dazu muss das Gerät lediglich mit Strom und Netzwerk verbunden werden. Nach ca. 30 Sekunden gibt es Geräten einen kleinen Piep von sich und kündigt damit seine Bereitschaft an.Das Gerät kann nun über die Webseite https://finds.synology.com im lokalen Netzwerk gefunden werden. Hier sollte man aber lediglich den Management Port verbinden, da sonst beide Ports mit der selben MAC Adresse in der Übersicht auftauchen.

Hat man das korrekte Interface ausgewählt führt einen der Assistent nun als nächstes zur Installation des Betriebssystems. Hier kann man sich auch noch einmal die Geräte-Informationen anschauen wenn man möchte.

Nach der Bestätigung dass man (natürlich) die EULA gelesen hat werden im nächsten Schritt die Festplatten initialisiert, wobei noch einmal bestätigen muss dass dabei alle Daten gelöscht werden.

Nun wird der APM (ActiveProtect Manager) installiert, das Betriebssystem der Appliance. Das hat mir lediglich 1 Minute gedauert und im Anschluss wurde das Gerät direkt neu gestartet.

Inkl. des Neustarts war das APM nach 5 Minuten einsatzbereit. Ich wünschte mein Windows wäre bei der Installation oder einem Update so schnell

Im Anschluss startet sich das Synology NAS automatisch neu und erwartet die Eingabe eines Gerätenamens und eines Administrator-Kontos. Gefüllt mit einem Servernamen für das NAS, einem Benutzernamen und einem sicheren Kennwort kann das Formular abgeschickt werden.

Bis hierhin war die Installation identisch zu einem Synology DSM. Der nächste Schritt zeigt nun aber den ersten Unterschied.

Hier lässt sich nun das Management und das Datennetzwerk getrennt einrichten. Das ist nun auch der Schritt an dem das LAN-Kabel in den Data-Port eingesteckt werden kann. Nach der Aktualisierung sieht man auch, dass sich das Netzwerk nun verbunden hat. An dieser Stelle habe ich für den Data-Port eine statische IP-Adresse vergeben, für den Management Port werde ich das später noch durchführen.

Hier ist anzumerken dass der Management Port bei mir auf DHCP steht, hier aber als statische IP behandelt wird. Der Tooltip dazu zeigt folgende Info an: Die diesem DHCP-Server zugewiesene IP-Adresse wird in APM als statische IP-Adresse behandelt. Führen Sie Änderungen an Ihrer Netzwerkkonfiguration mit Sorgfalt durch, um Konflikte mit IP-Adressen zu vermeiden.

Es gibt auch noch die Möglichkeit den Data-Port ebenfalls für das Management zu nutzen, das lasse ich hier aber mit Absicht weg.

Nun gibt es noch die Option die Speicheroptimierungen einzurichten. Diese Einstellungen lasse ich ebenfalls beide aktiv.

Zum Schluss muss noch einmal etwas Geduld mit bringen bis alle Einstellungen fertig konfiguriert sind. Die 15 Minuten sind aber sehr großzügig bemessen und bei mir war die Konfiguration nach ca. 2 Minuten abgeschlossen.

Im Anschluss wird man mit der Weboberfläche begrüßt und erhält einen kleinen Einführungs-Assistenten um die ersten Workload uns Server zu hinterlegen. Diesen habe ich aber übersprungen.

Performance-Tests

synthetische Benchmarks

Die Performance der Appliance ich über die Konsole sowie im im Live-Betrieb getestet. Anders als im DSM gibt es hier allerdings keine Möglichkeiten Dateien auf der Oberfläche zu verwalten oder den Raid-Typ anzupassen.Die Tests fanden in unterschiedlichen Umgebungen statt einmal direkt auf dem NAS und einmal direkt an meinem PC per SATA. Hierbei ging es mir um die nackte Performance der Festplatte, ohne das Betriebssystem als Overhead, damit auch ihr ein Gefühl für die HAT3310-Festplatten bekommt.

Auf die einzelnen Tests gehe ich an den entsprechenden Stellen kurz ein und stelle dann die Ergebnisse vor.

mit "dd" auf der Konsole

Mit dem Befehl dd kann man unter Linux Dateien in einer beliebigen Größe erstellen. Das habe ich genutzt um die Geschwindigkeit der Festplatten ohne Netzwerk und ohne Betriebssystem-Funktionen zu testen. In der Tabelle sieht man ob eine Datei nur mit Nullen (Zero) oder mit zufälligen Werten (Urandom) gefüllt wurde. Als Ergebnis findet sich am Ende noch die abgelaufene Zeit und der Datendurchsatz.| Typ | Größe | Blockgröße | Zeit | Durchsatz |

| Zero | 1 G | 1K | 2,42447 s | 441 MB/s |

| Zero | 10 G | 1K | 56,107 s | 191 MB/s |

| Zero | 100 G | 1K | 612,606 s | 175 MB/s |

| Urandom | 1 G | 1K | 523,455 s | 2,1 MB/s |

Da das Netzwerkinterface allerdings sowieso nur 1 GBit/s liefert sollte das aber kein Problem darstellen.

CrystalDiskMark

CrystalDiskMark ist ein synthetischer Test der Festplattengeschwindigkeit. Mit den hier gemessen Werten liegt die Platte leicht über dem Niveau der HAT5300 Festplatten.![2025-04-13 21_23_57-CrystalDiskMark 8.0.6 x64 [Admin].png 2025-04-13 21_23_57-CrystalDiskMark 8.0.6 x64 [Admin].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-13-21-23-57-crystaldiskmark-8-0-6-x64-admin.png)

Kopieren unter Windows

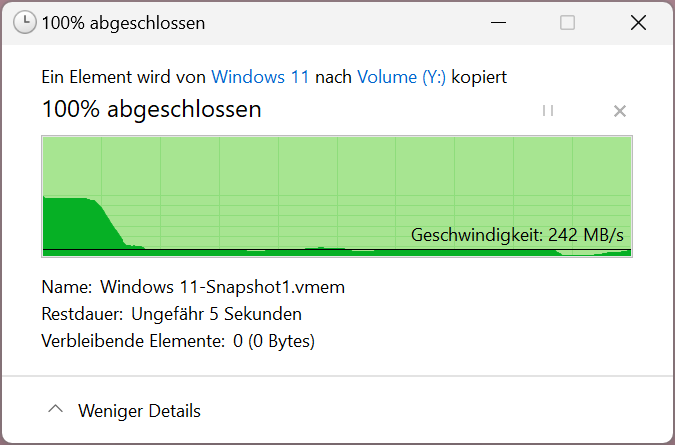

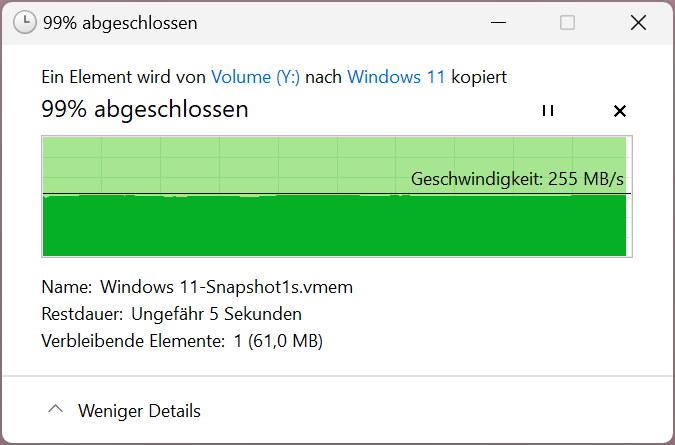

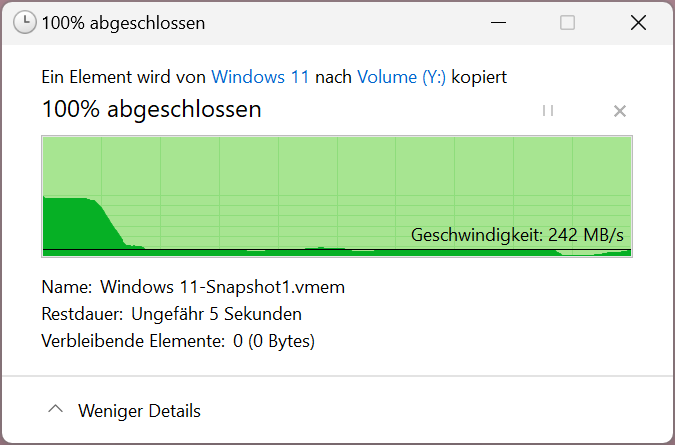

Das Schreiben auf die Festplatte einer 8 GB großen Testdatei startet mit eine sehr hohen Schreibrate über 1 GB/s, die aber recht flott auf Werte um die 250 MB/s einbricht. Diesen Wert hält die Festplatte größtenteils konstant, allerdings sieht man auch hier und da ein paar kleine Einbrüche die fast auf 0 MB/s herunterfallen.

Das Lesen der selben Datei ist auf einem sehr konstanten Wert von ca. 250 MB/s.

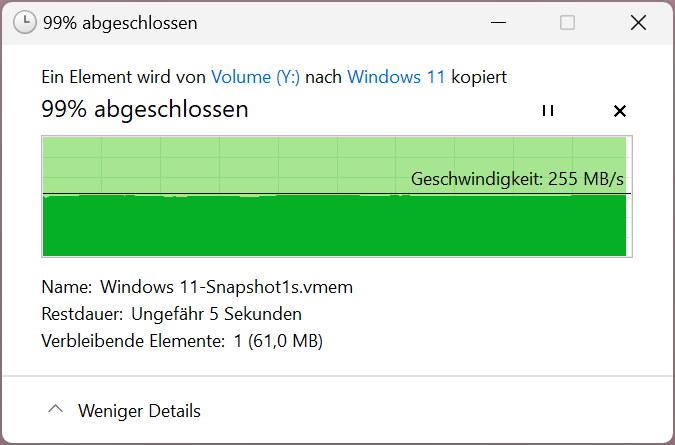

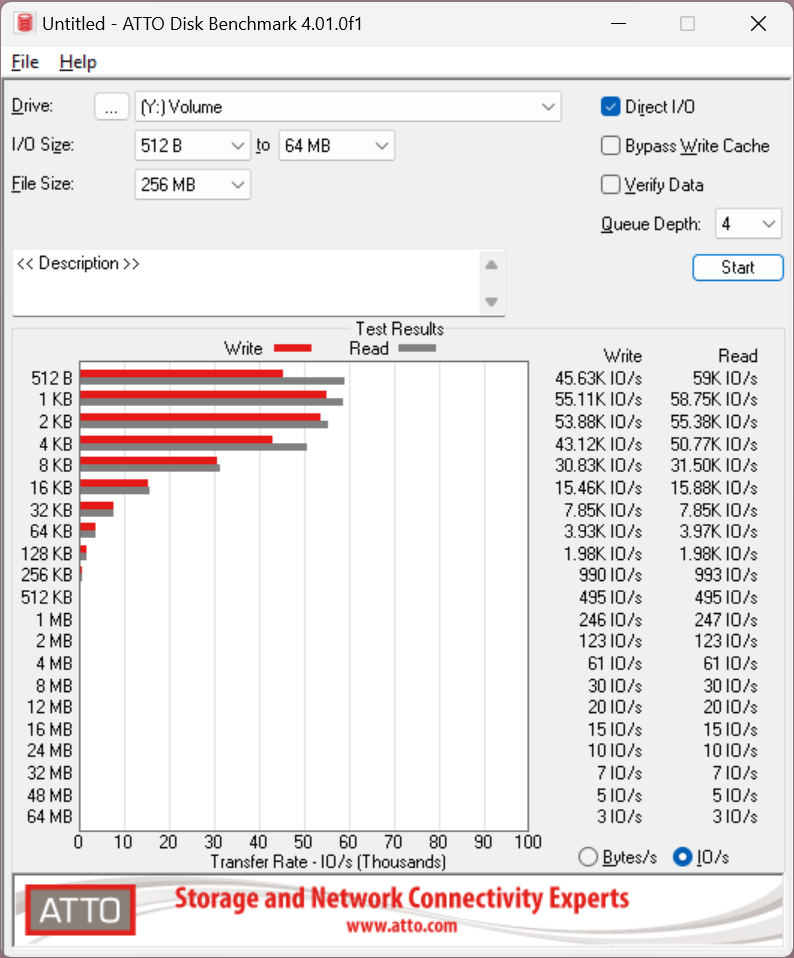

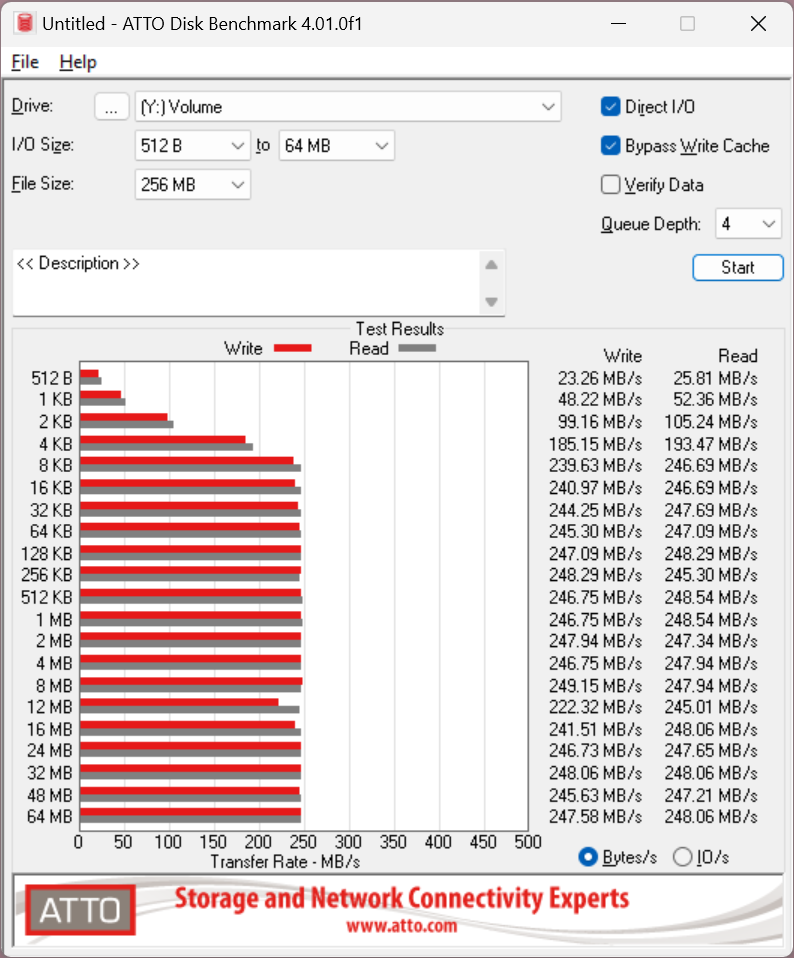

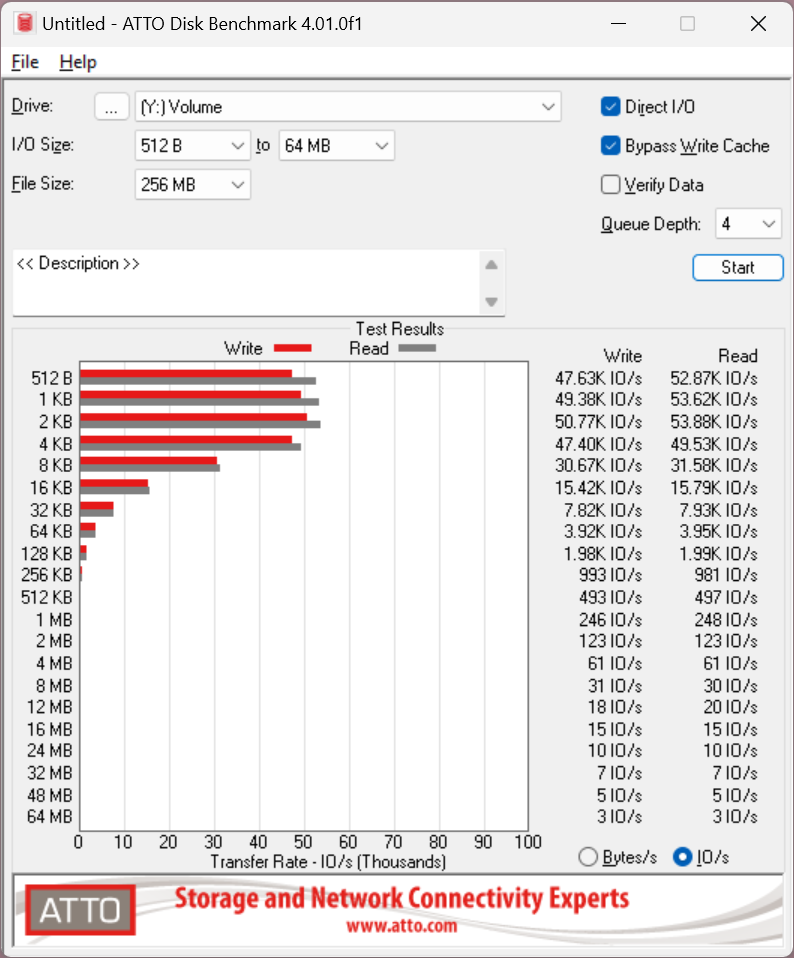

ATTO

Atto ist ebenfalls ein synthetischer Festplattentest, bei dem aber die Möglichkeit besteht, den Festplattencache zu umgehen und so die rohe Schreibleistung der Festplatte selbst zu erhalten. Der Test ohne Cache unterscheidet sich allerdings nur minimal von dem Test mit Cache und bringt nur bei sehr kleinen Dateien einen Vorteil. Außerdem wird mit dem Tool noch die IO getestet und ausgegeben.Hier die Ergebnisse.

mit Write Cache

ohne Write Cache

Damit liegt die Platte auf den Werten andere NAS Festplatten und muss sich definitiv nicht verstecken.

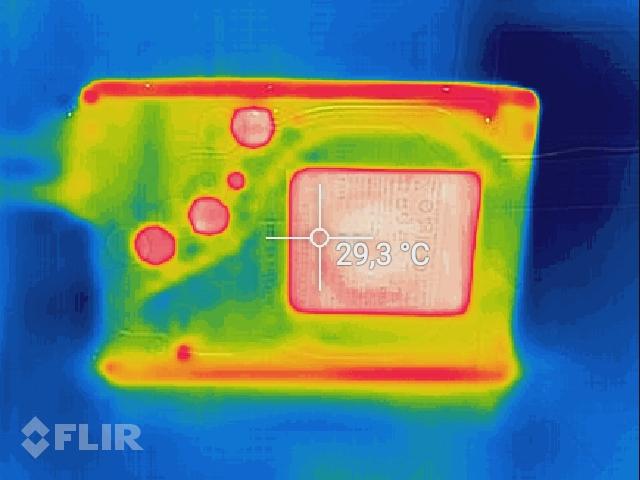

Wärmeentwicklung

Direkt nach dem Ende der synthetischen Tests habe ich noch die Temperatur der Festplatte mit einer Wärmebildkamera geprüft.Vorderseite:

Rückseite:

Die Frontseite ist angenehm kühl mit knapp unter 30°C und auch die Rückseite mit der Platine ist bei den Tests nicht ganz handwarm geworden mit Maximalwerten (heller Spot unten rechts) um die 35°C.

Tests im Produktivbetrieb

Was macht eine reine Backup Appliance im Produktivbetrieb? Genau, Backups erstellen. Da hier die Netzwerkgeschwindigkeit auf 1 Gbit/s begrenzt ist habe ich kurzerhand meinen Rechner von dem aus ich auch dieses Review schreibe mit dem ActiveProtect Agent gesichert.Dabei konnte ich ganz knapp das volle Gigabit ausschöpfen.

![2025-04-14 22_22_30-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-14 22_22_30-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-14-22-22-30-remote-desktop-manager-hama-bak01-management.png)

Auch nach mehreren Tagen im Betrieb hat die Performance des Systems nicht nachgelassen. Die Backups und auch Restores klappen gefühlt mit der gleichen Geschwindigkeit wie am ersten Tag. Das finde ich super, da viele Systeme hier nach kurzer Zeit schon etwas nachlassen.

Selbst ein Neustart der Appliance ist in weniger als 2 Minuten abgeschlossen, so dass man das System auch problemlos unter Tags neu starten kann ohne lange auf die Oberfläche zu warten.

Der Appliance kann ich damit eine durchgehend stabile und gleichbleibende Performance attestieren.

ActiveProtect

Allgemeines

ActiveProtect ist Synologys Antwort auf die Frage, wie man Datensicherung in Unternehmen zentral, skalierbar und vor allem einfach gestaltet. Anders als die klassischen NAS-Lösungen, die man so kennt, ist ActiveProtect eine Appliance, also eine Kombination aus Hard- und Software, die speziell für Backups entwickelt wurde. Das Ziel? Komplexität reduzieren, Verwaltungsaufwand minimieren und gleichzeitig die Datensicherheit auf ein neues Level heben.Die ActiveProtect-Appliances kommen mit einer zentralen Verwaltungskonsole namens ActiveProtect Manager (APM), über die man alle Backup- und Wiederherstellungsaufgaben steuern kann. Egal ob physische oder virtuelle Server, Endgeräte wie PCs oder Laptops, Datenbanken oder Microsoft 365, alles wird von hier aus verwaltet. Die Plattform ist dabei so ausgelegt, dass sie bis zu 150.000 Workloads oder 2.500 Standorte stemmen kann. Das macht sie auch für größere, verteilte Umgebungen interessant.

Was ActiveProtect so besonders macht:

- Zentrale Verwaltung für alle Backups und Recovery-Prozesse

- Lokale, hybride und Cloud-Backups werden unterstützt

- Integrierte Sicherheitsfeatures wie unveränderliche (immutable) Backups und Air-Gap-Optionen

- Effiziente Datensicherung dank globaler, quellseitiger Deduplizierung

- Schnelle Wiederherstellung durch Bare-Metal- oder File-Level-Restore

- Einfache und schnelle Inbetriebnahme

- Einmalige Lizenzierung ohne laufende Kosten pro Workload (bei bis zu drei Backup-Servern)

Was mir allerdings etwas negativ aufgefallen ist, ist die fehlende Möglichkeit mit der DP320 mein Active Backup auf meiner DS220+ zu verwalten. Das ist leider nur den großen Modellen vorbehalten. Schade!

Vergleich zu Active Backup for Business

ActiveProtect (AP) und Active Backup for Business (ABB) sind beides Lösungen von Synology für Datensicherung, aber sie unterscheiden sich in einigen Punkten:| Merkmal | ActiveProtect | Active Backup for Business (ABB) |

| Plattform | Dedizierte Appliance mit eigenem OS (APM) | DSM-Paket auf Synology NAS |

| Verwaltung | Zentrale Konsole für alle Backups | Einzelanwendung, Integration in DSM |

| Zielgruppe | Mittelstand & Enterprise | KMU, kleinere Unternehmen |

| Lizenzierung | Einmalige Appliance-Lizenz, keine Workload-Gebühren (bis 3 Server) | Kostenfrei als DSM-Paket |

| Funktionsumfang | All-in-One: Backup, Recovery, Deduplizierung, Air-Gap, Immutability | Backup & Recovery |

| Skalierbarkeit | Bis 150.000 Workloads, 2.500 Standorte | Begrenzt durch NAS-Hardware |

| Hardware | Vorkonfiguriert, keine freie Wahl | Nutzer wählt NAS und Festplatten selbst |

| Integration | Kann ABB-Installationen zentral verwalten (gilt nicht für DP320 und DP340) | Eigenständige Lösung |

Als langjähriger Nutzer von Synology DSM und den Plus-Modellen, sowohl privat als auch bei Kunden, habe ich natürlich mit der "alten" Sicherungslösung einiges an Erfahrung sammeln können. Ich möchte hier gerne einmal auf die funktionalen Unterschiede der beiden Lösungen eingehen.

Vorteile und Nachteile

Vorteile von ActiveProtect

- Zentrale Verwaltung: Ein Dashboard für alle Backups, auch standortübergreifend.

- Skalierbarkeit: Kann auch sehr große Umgebungen mit vielen Workloads verwalten.

- Sicherheit: Unveränderliche Backups und Air-Gap-Optionen schützen vor Datenverlust.

- Effizienz: Globale Deduplizierung spart Speicherplatz und Netzwerkbandbreite.

- Schnelle Inbetriebnahme: Appliances sind schnell einsatzbereit.

- Flexible Lizenzierung: Keine laufenden Kosten pro Workload (bis zu drei Server).

Nachteile von ActiveProtect

- Weniger flexibel bei Hardware: Appliances sind vorkonfiguriert.

- Fokus auf Backup: Keine Multifunktionalität wie bei DSM-basierten NAS (z.B. Medienserver).

- Kosten: Höhere Anschaffungskosten durch dedizierte Hardware.

- Eingeschränkte Anpassbarkeit: Erweiterungen sind auf Synology-Ökosystem beschränkt.

direkter Vergleich mit Active Backup

Leider, und ich hoffe dass sich das in Zukunft nochmal ändert, fehlt ActiveProtect einiges an Funktionen, die bei Active Backup vorhanden waren.Nach einiger Zeit im Betrieb sind mir deshalb die folgenden Defizite von ActiveProtect im Vergleich zu Active Backup aufgefallen:

- Kein Google Workspace Backup

- fehlende Anzeige des Online-Status für die gesicherten Geräte

- Video zu Restore-Prüfung nur pro Maschine möglich (1 Video, vorher mehrere Videos je nach Anzahl Maschinen im Job)

- Fileserver Sicherung kann kein rsync mehr

- fehlende Geschwindigkeitsanzeige bei einem laufenden Backup

- keine manuelle Löschung von einzelnen Versionen möglich

- keine Backupplanung auf Grund von "Ereignissen", wie z.B. "Benutzer hat sich angemeldet"

Unveränderliche Backups (Immutable Backups)

ActiveProtect kann ohne weitere Anpassungen Immutable Backups erstellen. Hierzu muss lediglich ein entsprechender Plan erstellt werden (siehe weiter unten).Für alle die den Begriff noch nicht kennen, hier eine kleine Tabelle dazu mit den wichtigsten Aspekten:

| Aspekt | Immutable Backup | Normales Backup |

|---|---|---|

| Veränderbarkeit | Daten sind schreibgeschützt (WORM-Prinzip), keine Änderungen möglich | Daten können überschrieben/gelöscht werden |

| Schutz vor Ransomware | Hoher Schutz durch unveränderbare Speicherung | Anfällig für Manipulationen (Veränderung / Löschung) |

| Speichertechnologie | WORM (Write Once Read Many) | Traditionelle Speichermethode und -Medien |

| Wiederherstellung | Zuverlässige Versionen dank fester Retention (täglich) | Abhängig von manuell definierten Sicherungszyklen |

| Flexibilität | Automatische Prozesse, weniger Anpassungsmöglichkeiten | Volle Kontrolle über Backup-Frequenz |

| Retentionsdauer | Fest definiert | Variabel, oft kürzere Aufbewahrungsfristen |

Die einzige Möglichkeit die Daten zu löschen ist den RAID zu zerstören bzw. die Festplatten zu formatieren.

Dadurch ergeben sich folgende Vor- und Nachteile (Fett = Vorteil, Kursiv = Nachteil)

| Aspekt | Immutable Backup | Konventionelles Backup |

|---|---|---|

| Sicherheit | Schutz vor Ransomware (Daten bleiben unverschlüsselt) | Anfällig für Angriffe (Daten können manipuliert/gelöscht werden) |

| Wiederherstellung | Zuverlässige Recovery (fest definierte Retention) | Abhängig von manuellen Backups (Zeitpunktabhängig) |

| Flexibilität | Starre Retention (fest vorgegebene Speicherdauer) | Variable Anpassung (beliebige Änderungen möglich) |

| Schutz vor Fehlern | Sicher gegen menschliche Fehler (kein versehentliches Löschen) | Fehleranfällig (manuelle Eingriffe möglich) |

| Skalierbarkeit | Komplexere Skalierung (abhängig vom Speicheranbieter) | Einfache Erweiterung (mit Standardlösungen) |

Dabei sollte man aber auch immer die DSGVO im Hinterkopf behalten, so sollten z.B. Bewerberdaten nicht auf einem Immutable Speicher liegen, da diese nach einer bestimmten Zeit gelöscht werden müssen.

Andere Daten für das Finanzamt wiederum müssen 10 Jahre vorgehalten werden und dürfen in dieser Zeit nicht verändert werden, hier bietet sich ein Plan mit einem Immutable Backup an.

Natürlich wollte ich auch prüfen ob die Daten wirklich unlöschbar sind. Über die Oberfläche kann ich das auf jeden Fall bestätigen, hier erhält man direkt eine Infobox die einem mitteilt dass der Workload nicht gelöscht werden kann.

![2025-05-04 22_57_31-Remote Desktop Manager [hama-bak01].png 2025-05-04 22_57_31-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-04-22-57-31-remote-desktop-manager-hama-bak01.png)

Was macht also der clevere IT-ler? Er versucht es über die Kommandozeile mit dem root-User.

Hier konnte ich die Dateien ohne Probleme löschen mit einem einfachen rm Befehl. Das hat mich wenn ich ehrlich bin etwas geschockt. Hier dazu noch der passende Screenshot:

![2025-05-04 23_47_22-Remote Desktop Manager [hama-bak01].png 2025-05-04 23_47_22-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-04-23-47-22-remote-desktop-manager-hama-bak01.png)

Wenn ich nun versuche die Version im Wiederherstellungsportal zu öffnen erhalte ich auch eine Fehlermeldung und soll mich an den Synology-Support wenden.

Das habe ich tatsächlich nicht erwartet, da eine "Immutable Backup" die Daten vor jeglicher Veränderung oder Löschung schützten soll. Das ist hier aber faktisch nicht gegeben. In meinem Fall müsste nur jemand die SSH Verbindung hacken und könnte meine kompletten Daten löschen.

Viele werden nun sicher schreiben: Dann trenne doch das Management Netzwerk vom Backup Netzwerk. Das mag korrekt sein, aber solange es die Funktion gibt, reicht auch schon eine Schwachstelle in der Software mit der sich ein Angreifer root-Rechte erschleichen kann um die Backups zu löschen oder zu kompromittieren.

Hier muss also definitiv noch etwas passieren, mindestens ein Hinweis in der Oberfläche welche Art von Immutability genutzt wird (Enterprise = löschbar oder Compliance = unlöschbar). Leider habe ich nichts dergleichen im System entdecken können. Besser wäre es noch die Art der Immutability selbst wählen zu können wie dies unter DSM mit der WORM Funktion der Fall ist.

Oberfläche

Die Oberfläche des ActiveProtect Manager zeigt sich in einem neuen Gewand im Vergleich zu den bisherigen Oberflächen von Synology. Ein Umstand an den man sich erst gewöhnen muss. Dennoch wirkt die neue Oberfläche aufgeräumt und auf das Wesentliche konzentriert.![2025-04-22 23_56_50-Remote Desktop Manager [hama-bak01].png 2025-04-22 23_56_50-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-22-23-56-50-remote-desktop-manager-hama-bak01.png)

Hier sieht man das neue Dashboard, das wichtige Informationen an einer zentralen Stelle sammelt, z.B. ob Backups erfolgreich waren oder fehlgeschlagen sind, wie die Speicherverteilung nach der Deduplizierung aussieht und und ob in den vergangenen Tagen die Sicherungen erfolgreich waren oder ob es Probleme gab. Diese Art des Dashboards kennt man aber schon aus dem Active Backup for Business (ABB), hier ist die Ansicht dafür etwas moderner gestaltet.

![2025-04-22 23_57_08-Remote Desktop Manager [hama-bak01].png 2025-04-22 23_57_08-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-22-23-57-08-remote-desktop-manager-hama-bak01.png)

In der Serverübersicht sieht man alle gesicherten Systemen im Überblick, das finde ich besser gelöst als beim bisher genutzten Vorgänger ABB. Man sieht sofort und über alle Systeme hinweg ob eine Sicherung erfolgreich war, wie groß die Sicherung ist, wann diese das letzte Mal lief und den Verlauf der letzten 30 Tage.

![2025-04-22 23_57_15-Remote Desktop Manager [hama-bak01].png 2025-04-22 23_57_15-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-22-23-57-15-remote-desktop-manager-hama-bak01.png)

Ebenso aufgeräumt sieht die Ansicht beim MS365 Backup aus. Auch hier sieht man sofort welches Objekt man gerade prüfen bzw. Wiederherstellen möchte, wie groß das Backup ist und ob es gelaufen ist oder nicht. An dieser Stelle ein großes Lob an Synology.

Ebenso einfach ist es den Sicherungsplan zu wechseln. Musste man hierzu im ABB eine Aufgabe editieren, kann man hier einfach per Rechtsklick einen neuen Plan mit den entsprechenden Einstellungen auswählen.

Doch auch das ActiveProtect (AP) bietet über den Port 5001 noch die alte Oberfläche an, jedoch mit deutlich reduziertem Funktionsumfang, sowohl auf der Oberfläche selbst als auch in der Systemsteuerung. Diese Oberfläche steht aber auch nicht im Mittelpunkt der neuen Lösung.

![2025-04-23 00_14_04-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 00_14_04-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-00-14-04-remote-desktop-manager-hama-bak01-management.png)

Backups

Kommen wir zur Kernkompetenz von ActiveProtect, den Backups.Um diese zu erstellen benötigt es eigentlich nur zwei Dinge:

- Sicherungsplan

- Verbindungsschlüssel (außer bei virtuellen Workloads)

Sicherungsplan anlegen

Mit dem Sicherungsplan bzw. "Pläne zum Schutz", wie es hier auch von Synology bezeichnet wird, werden die Grundlegenden Sicherungseinstellungen definiert, die man im ABB bisher in der entsprechenden Aufgabe definiert hat.Der Wizard besteht dabei aus 7 Schritten.

- Plan Typ auswählen

Hierbei wird man gefragt ob man ein unveränderliches Backup (Immutable) oder ein normales Backup anlegen möchte - Grundlegende Informationen

Name und eine Beschreibung für den Backup Plan - Sicherungseinstellungen

- Aufbewahrungsfristen

- Standardumfang und Zeitplan

- Benutzerdefinierter Umfang und Zeitpläne

- Anwendungskonsistente Sicherung

Anwendungskonsistenz durch Snapshots und VSS

Datenbankkonsistenz z.B. durch Löschen der Transaktionsprotokolle (neu in AP) - Erweiterte Einstellungen

Sicherungsüberprüfung und Energieeinstellungen - Sicherungskopien

kopieren der gesicherten Daten an einen weiteren Standort.

Hierzu werde ich nachher noch im Detail darauf eingehen. - Zusammenfassung

Verbindungsschlüssel

Die Verbindung zwischen einem Client oder Server und der ActiveProtect Appliance wird hier mit einem eindeutigen Verbindungsschlüssel durchgeführt. So muss man im Client lediglich die IP-Adresse der Appliance und den Verbindungsschlüssel angeben. Alle weiteren Informationen werden nach erfolgreicher Verbindung von der Appliance geladen und man kann die Einrichtung direkt danach einfach beenden oder auch direkt eine Sicherung starten.Für virtuelle Workloads entfällt der Verbindungsschlüssel, hier muss man lediglich die Zugangsdaten eintragen und kann im Anschluss die virtuellen Maschinen manuell auswählen oder alle VMs in einen automatischen Sicherungsplan aufnehmen.

Backup erstellen

Ist alles eingerichtet können die Sicherungen gestartet werden. Entweder man wartet auf die automatischen Sicherungen oder startet einfach von Hand eine Sicherung.Nach ca. 2,5 Wochen sieht die Übersicht der Backups dann z.B. wie folgt aus:

![2025-05-02 21_36_20-Remote Desktop Manager [hama-bak01].png 2025-05-02 21_36_20-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-02-21-36-20-remote-desktop-manager-hama-bak01.png)

Die Last während eines Backups auf dem System selbst ist relativ hoch, da die Appliance aber nicht anderes macht außer Backups sollte das allerdings auch kein Problem darstellen.

Sicherungskopie

Die Sicherungskopie ist neu in ActiveProtect und erlaubt es, die gesicherten Daten nach einem erfolgreichen lokalen Backup zusätzlich an einen weiteren Ort zu kopieren. Damit wurde hier nun eine Funktion eingeführt, die es bei anderen Anbietern schon länger gibt.![2025-05-02 21_26_12-Remote Desktop Manager [hama-bak01].png 2025-05-02 21_26_12-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-02-21-26-12-remote-desktop-manager-hama-bak01.png)

Diese neue Funktion finde ich super, da nun das 3-2-1 Backups System einfacher umsetzbar ist. Eine externe Kopie lässt sich hier direkt im Anschluss an das eigentliche Backup erstellen. Bisher musste man sich im Synology-Umfeld hier mit zeitlich aufeinander abgestimmten Workarounds wie HyperBackup oder Snapshot Replication behelfen.

Allerdings kann man hier lediglich zwischen einer weiteren ActiveProtect Appliance, Synology C2 Block Storage und Amazon S3 auswählen kann. Wäre hier beispielsweise noch ein SMB-Server oder rsync an einen weiteren Standort möglich dann wäre dieses Feature um einiges hilfreicher.

So habe ich eben nur mein Paperless zum Test auf den kostenlosen Synology C2 Speicher mit 15GB gesichert.

Das wiederum hat wunderbar geklappt.

- Remote-Speicher auswählen

- mit Object Storage verbinden (Zugriffsschlüssel und Secret Key wird hier benötigt für das Bucket)

- Bucket auswählen (muss Objektsperre aktiv haben)

- Clientseitige Verschlüsselung aktiveren (schließlich schicke ich die Daten ins Internet)

- Zusammenfassung

Sicherlich gibt es hier auch Use-Cases in denen mehr als eine Sicherungskopie gewünscht ist. Das ist aber mit dem aktuellen Softwarestand von ActiveProtect nicht möglich oder ich habe die Funktion schlicht nicht gefunden.

In der C2 Weboberfläche sieht man dann die gesicherten Daten. Bzw. um genau zu sein sieht man nur Chunks, da die Daten vollständig verschlüsselt sind, aber man sieht die Speicherbelegung.

Restore

In der Vergangenheit hat mir mal jemand erzählt, dass er nach einem Datenverlust nach der Wiederherstellung der Daten gefragt wurde. Seine Antwort: "Wir haben hier nur ein Backup-Konzept, von Restore war nie die Rede." Ich musste sehr lachen als ich das gehört habe, auch wenn es eigentlich nichts zum Lachen ist.Sollte eine Wiederherstellung der gesicherten Daten nicht möglich sein kann ich mir das Backup auch komplett sparen und einfach auf gut Glück durch den Tag leben.

Genau aus diesem Grund hab ich mir aber natürlich auch die Wiederherstellungsfunktionen von ActiveProtect angeschaut. Diese sind vom Umfang her identisch mit denen von Active Backup. Es gibt ein Wiederherstellungsportal, in dem man komplette VMs oder auch nur einzelnen Dateien aus den VMs wiederherstellen kann, es gibt die Möglichkeit gesicherte Clients und native Server über einen bootbaren USB-Stick direkt auf Bare-Metal wiederherzustellen und man kann E-Mails, Dateien, Chats und mehr aus MS365 Umgebungen wiederherstellen.

Dazu sucht man sich in der Oberfläche eine gesicherte Workload aus und kann dann per Rechtsklick im Kontextmenü das Wiederherstellungsportal auswählen. Hier findet man nun den File-Level-Restore der gesicherten Workloads und kann die Dateien entweder direkt auf dem System selbst wiederherstellen oder einfach herunterladen und dann auf eine andere Art und Weise zur Verfügung stellen.

Gesicherte "Server" kann ich alternativ auch zu einer virtuellen Maschine wandeln. Damit habe ich quasi die Möglichkeit, native Systeme zu sichern und danach als VM weiter zu betreiben sollte ich diese in der Zukunft noch einmal benötigen.

![2025-05-02 21_07_21-Remote Desktop Manager [hama-bak01].png 2025-05-02 21_07_21-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-02-21-07-21-remote-desktop-manager-hama-bak01.png) Sandbox-Umgebung

Sandbox-Umgebung

Diese Funktion ist auf der DP320 leider sehr eingeschränkt. Während die größeren Modelle hier auf dem Papier die Möglichkeit bieten mehrere gesicherte Umgebungen gleichzeitig zu starten und auch z.B. Malware-Scans vor dem Restore durchzuführen, beschränkt sich die Sandbox-Umgebung auf der DP320 lediglich darauf die Server und VMs auf die Restore-Fähigkeit zu prüfen. Das heißt: Server hochfahren & Login Bildschirm abwarten und das alles als kurzes Video aufzeichnen.Hier hätte mich mir etwas mehr Funktionalität gewünscht, vor allem den Malware-Scan. Auch kleine Umgebungen oder Unternehmen könnten von dieser Funktion profitieren und haben auch sicher nicht wirklich etwas dagegen wenn das Backup oder der Restore dafür etwas länger dauert.

Deduplizierung

Die Deduplizierung funktioniert bei der ActiveProtect Appliance super. Im Vergleich zu ABB werden hier auch Fileserver mit dedupliziert, so dass hier weiterer Speicherplatz eingespart werden kann. Ebenso werden die Backups der Clouddienste (MS365) dedupliziert. Das spart auf Dauer einiges an Speicherplatz.Mein System hat nach nicht ganz 4 Wochen Testbetrieb ein Deduplizierungsrate von 51%.

![2025-05-05 21_19_48-Remote Desktop Manager [hama-bak01].png 2025-05-05 21_19_48-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-19-48-remote-desktop-manager-hama-bak01.png)

Damit ist die Appliance nun zu 22% belegt und hat noch Luft für zukünftige Sicherungen.

Monitoring

Die Appliance bietet die Möglichkeit Status-Mails zu versenden und damit eine Art Monitoring einzurichten. Hier werden Benachrichtigungen gesendet wenn etwas mit der Hardware nicht stimmt oder Backups fehlgeschlagen sind. Welche Benachrichtigungen man erhalten möchte lässt sich selbst in den Regeln definieren.Da das System auch die Abfrage über SNMP anbietet habe ich das System auch in mein Checkmk aufgenommen und geprüft was sich auslesen lässt. Mit dabei sind CPU, Memory, Festplatte, Netzwerkinterfaces, RAID Status, HDD Temperaturen, usw. Damit ist eine vollumfängliche Überwachung möglich und ich kann rechtzeitig reagieren, da ich die Benachrichtigungen aus meinem Checkmk per Push auf mein Smartphone erhalten.

![2025-05-05 21_29_58-Remote Desktop Manager [Check_MK Web].png 2025-05-05 21_29_58-Remote Desktop Manager [Check_MK Web].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-29-58-remote-desktop-manager-check-mk-web.png)

![2025-05-05 21_30_16-Remote Desktop Manager [Check_MK Web].png 2025-05-05 21_30_16-Remote Desktop Manager [Check_MK Web].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-30-16-remote-desktop-manager-check-mk-web.png)

![2025-05-05 21_30_31-Remote Desktop Manager [Check_MK Web].png 2025-05-05 21_30_31-Remote Desktop Manager [Check_MK Web].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-05-05-21-30-31-remote-desktop-manager-check-mk-web.png)

Plattenausfall

Es hat mich bei dem NAS natürlich auch interessiert, wie es sich bei einem simulierten Plattenausfall verhält. Also habe ich einfach eine der beiden Platten im laufenden Betrieb herausgezogen. Die Festplatten im NAS sind Hot-Swap fähig, deshalb sehe ich rein Hardwareseitig auch kein Problem bei der Aktion. Das NAS hat umgehend einen unüberhörbaren und sich wiederholenden Piep-Ton von sich gegeben, um auf seine missliche Lage aufmerksam zu machen. Zusätzlich wurde auch zwei E-Mails an mein Konto gesendet, mit den Betreffs "[ActiveProtect Appliance] Systempartition (Root) auf hama-bak01 hat sich verschlechtert (1/2)" und "[ActiveProtect Appliance] Speicherpool 1 ist fehlerhaft und wurde aus dem Zeitplan für die Datenbereinigung entfernt". Die Inhalte der Mail spiegeln quasi nur den Text aus dem Betreff wieder und weißen darauf hin dass man sich an den Synology Support wenden soll. Das Piepen kann man entweder in der Gerätemanager-Oberfläche abschalten wenn man z.B. auf eine Ersatzfestplatte wartet. Sobald wieder eine Platte eingesteckt wurde hört das Piepsen von alleine auf.Leider war ich von der Oberfläche selbst etwas enttäuscht, da es hier keinerlei Hinweise auf eine defekte Festplatte gibt, weder im Dashboard noch in der Ansicht des Sicherungsservers. Erst in den Speicher-Details des Sicherungsservers gab es dann einen Hinweis dass eine Platte ausgefallen ist.

![2025-04-23 21_02_12-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_02_12-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-02-12-remote-desktop-manager-hama-bak01.png)

![2025-04-23 21_02_22-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_02_22-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-02-22-remote-desktop-manager-hama-bak01.png)

![2025-04-23 21_04_04-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_04_04-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-05/scaled-1680-/2025-04-23-21-04-04-remote-desktop-manager-hama-bak01.png)

In der Gerätemanager-Oberfläche hingegen wird man quasi an jeder Stelle auf den Fehler aufmerksam gemacht.

![2025-04-23 21_02_57-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 21_02_57-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-02-57-remote-desktop-manager-hama-bak01-management.png)

![2025-04-23 21_01_32-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 21_01_32-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-01-32-remote-desktop-manager-hama-bak01-management.png)

Um es dem System schwer zu machen habe ich die Festplatte per SATA wieder an meinen Rechner angesteckt, mit NTFS neu formatiert, ein paar ISOs abgelegt und danach die Platte wieder zurück in das DP320 gesteckt.

Die Festplatte wurde anstandslos wiedererkannt und das System hat auch direkt mit der Reparatur des RAID1 begonnen. Dazu wurde zu Beginn die Systempartition geprüft was keine 3 Minuten gedauert hat.

![2025-04-23 21_03_51-Remote Desktop Manager [hama-bak01 - Management].png 2025-04-23 21_03_51-Remote Desktop Manager [hama-bak01 - Management].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-03-51-remote-desktop-manager-hama-bak01-management.png)

Im Anschluss wurde mit der eigentlichen Reparatur des RAID begonnen. Dieser Vorgang läuft etwas länger, da die Festplatte einen neuen Spiegel aller Daten der noch funktionierenden Platte erhält.

![2025-04-23 21_05_32-Remote Desktop Manager [hama-bak01].png 2025-04-23 21_05_32-Remote Desktop Manager [hama-bak01].png](https://bookstack.jelinek-rz.de/uploads/images/gallery/2025-04/scaled-1680-/2025-04-23-21-05-32-remote-desktop-manager-hama-bak01.png)

Die technische Umsetzung eines Plattenausfalls ist wie bei allen anderen Systemen von Synology tadellos und hier gibt es nicht zu bemängeln. Allerdings hätte ich mir im Dashboard der AP-Oberfläche einen Hinweis gewünscht, dass etwas mit der Hardware bzw. den Festplatten nicht in Ordnung ist. Hier ist aus meiner Sicht noch Nachholbedarf.

Zusätzliche Erkenntnisse

SSH Zugang

Natürlich habe ich mich, wie auch oben zu sehen, per SSH auf die Appliance verbunden, um die "dd" Befehle auszuführen. Hier musste ich leider feststellen dass die gewählten Sicherheitseinstellungen nicht mehr aktuell sind und aus meiner Sicht ein Sicherheitsrisiko darstellen.Der Zugriff per SSH war mir ausschließlich mit den folgendem Befehl möglich: ssh -c aes128-cbc -m hmac-sha1 -oHostKeyAlgorithms=+ssh-rsa -oKexAlgorithms=+diffie-hellman-group1-sha1 -p 57 sascha@192.168.178.20

Hier sieht man die veralteten Ciphers. Mac-Keys und Algorithmen. Eine Möglichkeit diese anzupassen habe ich leider nicht gefunden, hier sollte Synology auf jeden Fall nachbessern und aktuelle Werte akzeptieren, da die hier genannten Werte seit den Jahren 2015-2017 als Unsicher zu betrachten sind.

Stromverbrauch und Energieeinstellungen

Ein Feature dass ich bei meinen reinen Backup-Systemen gerne nutze ist das automatische aus- und einschalten. Das ganze einfach aus dem Grund weil ich es als recht sinnlos erachte das System laufen zu lassen so lange keinerlei Backups durchgeführt werden. Die Backups führe ich hauptsächlich nachts aus, so dass das System zwischen 10 Uhr vormittags und 4 Uhr nachts nicht zu tun hat.Bei einem Standby Stromverbrauch von durchschnittlich 24W (gemessen) kommen hier ca. 0,43 kWh / Tag zusammen die ich mir sparen kann.

Etwas gerundet (Verbrauch 0,5 kWh, Strompreis 30 Cent / kWh) spare ich mir hier dann ganze 15 kWh bzw. grob 4,50€ pro Monat ein. Geld dass ich lieber in meine Kinder investiere.

Im Betrieb braucht die Appliance grob 30W. das ist aus meiner Sicht ein guter Wert für 2x 3,5 Zoll Festplatten.

Leider gibt es bei der ActiveProtect Appliance keine Möglichkeit im Vergleich zu DSM einen Aus- & Einschalt-Timer anzulegen. Also musste ich mir einen Workaround über meinen HomeAssistant bauen der mein NAS über einen SSH Befehl mit "expect" herunterfährt und per WoL wieder hochfährt. Vielleicht folgt diese Funktion aber noch in Zukunft.

Mein Fazit nach ca. 4 Wochen

Nach ca. 4 Wochen mit der Synology DP320 ziehe ich eingemischtes Fazit. Synology liefert mit der ActiveProtect-Serie eine Backup-Lösung, die in Sachen Benutzerfreundlichkeit und Performance neue Maßstäbe setzt, zumindest für klassische Anwendungsfälle. Die Inbetriebnahme ist ein Kinderspiel: Anschließen, ein paar Klicks durch den Assistenten, und schon ist das System einsatzbereit. Die Hardware ist solide, die Lautstärke angenehm niedrig und die Performance der HAT3310-Festplatten ausreichend für den Einsatzzweck. Auch die zentrale Verwaltung aller Workloads über den ActiveProtect Manager ist ein echtes Plus, besonders wenn man viele Clients und verschiedene Backup-Quellen unter einen Hut bringen muss.Doch wo Licht ist, ist auch Schatten. So finde ich es immer noch schade dass weiterhin keine Unterstützung für ARM-basierte Server vorhanden ist mit dem ActiveProtect Agent. Gerade im Zeitalter von energieeffizienten ARM-Servern, die in immer mehr Unternehmen und Home-Labs zum Einsatz kommen, ist das schlicht nicht mehr zeitgemäß.

Ebenso enttäuschend oder sogar schon schlimmer: Proxmox, eine der aktuell beliebtesten Open-Source-Virtualisierungslösungen nach der Aktion von Broadcom, wird immer noch nicht unterstützt. Für viele IT-Profis und Admins ist das ein echter Showstopper, gerade weil Proxmox im Mittelstand und bei IT-affinen Nutzern sehr beliebt und weit verbreitet ist.

Ein weiterer und massiver Kritikpunkt ist die unsichere Standardkonfiguration der SSH-Verbindung. In einer Backup-Appliance, die per Definition sensible Daten verwaltet, darf so etwas einfach nicht passieren. SHA1 ist schon seit mehreren Jahren nicht mehr sicher. Hier muss Synology dringend nachbessern, besser gestern als morgen. Sicherheit darf keine Option, sondern muss Standard sein.

Auch die künstliche Trennung der Produktlinien ist ärgerlich: Die Möglichkeit, bestehende ABB-Installationen auf kleineren Modellen zentral zu verwalten, bleibt den großen Appliances vorbehalten. Ebenso die abgespeckte Sandbox-Umgebung bei den kleinen Modellen finde ich schade.

Unterm Strich ist die DP320 eine leistungsfähige und angenehm unkomplizierte Backup-Appliance, die gerade für klassische x86-Umgebungen eine echte Empfehlung bleibt. Wer auf ARM-Server-Backups, Proxmox-Support oder maximale Sicherheit out-of-the-box setzt, findet hier zwar noch nicht alle Wünsche erfüllt, doch Synology zeigt mit der ActiveProtect-Serie, dass viel Potenzial und Komfort in einer modernen Backup-Lösung stecken kann. Wer mit den aktuellen Einschränkungen leben kann, bekommt ein zuverlässiges, schnelles und erfreulich wartungsarmes System, das im Alltag überzeugt und mit zukünftigen Updates hoffentlich noch weiter an Reife gewinnen wird.

Vielen Dank an dieser Stelle an die Hardwareluxx Media GmbH und Synology Deutschland für das Testgerät und die Möglichkeit dieses Reviews. Der Test hat mir viel Spaß gemacht und ich werde das Gerät trotz meiner gemischten Gefühle weiter nutzen, auch in der Hoffnung dass hier in naher Zukunft noch Firmware Updates kommen werden die den Funktionsumfang und die Sicherheit erhöhen.

Euer Sascha (Man-in-Black)