Ist ähnlich wie damals beim Intel Sockel 775. Da konnte man bei den letzten Boards auch uralte Netburst Celeron und Pentium 4 CPUs drauf nutzen, sowie spätere Pentium Ds (zwei Pentium 4 Dies auf einem Package) sowie dann das komplette Core2 LineUp inkl. Quad Cores.

War jetzt Sockel 775 deshalb so toll? Wäre doch nicht so schlimm gewesen dazwischen einen neuen Sockel zu bringen. Man wollte doch neue Features wie schnelleren DDR2 oder gar DDR3 RAM, PCI-E 2.0, neue SATA II Standards etc.

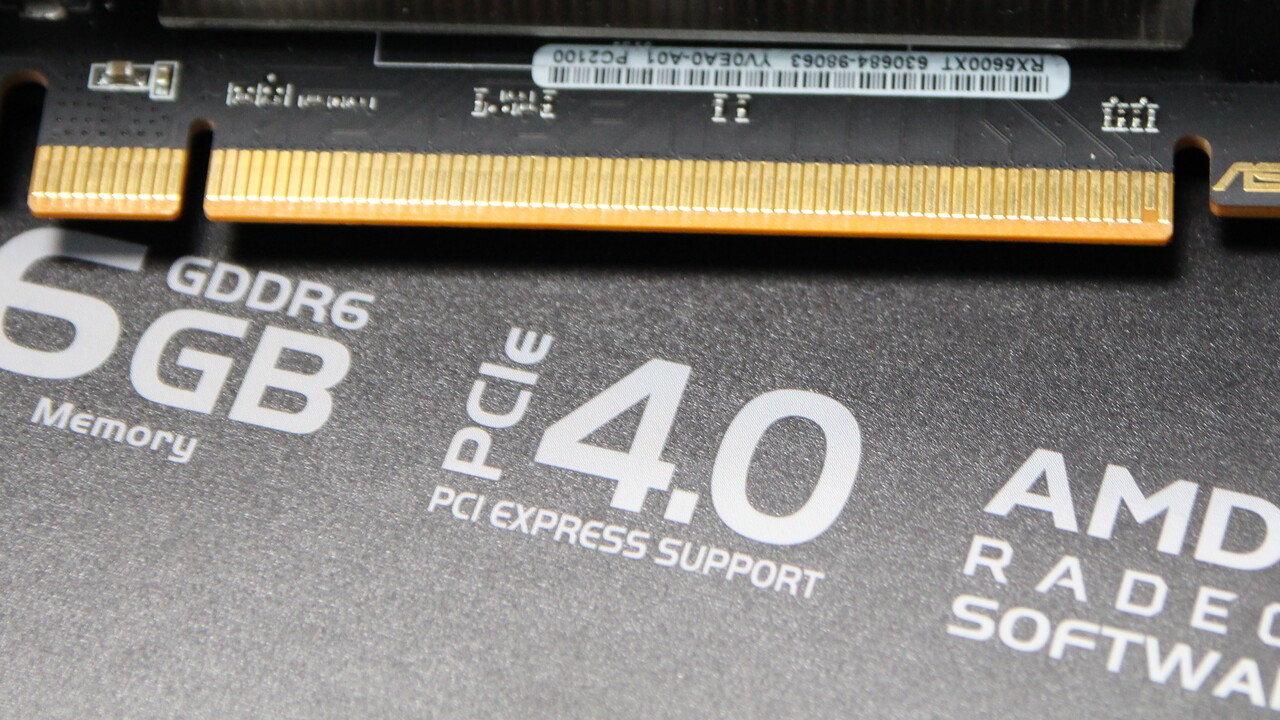

Das sind zwei paar Schuhe. S775 hatte auch Einschränkungen. P35 bspw. hatte doch offiziell keinen Netburst Support. Das ist aber ne andere Nummer, weil das was supportet ist und das was technisch durchführbar ist, wenn alle Seiten "mitspielen" und das auch nicht einseitig verboten wird (PCIe 4.0 auf alten AM4 Boards, irgendwelche CPUs auf alte Sockel bei Intel S11xx irgendwas usw.), kann man so einfach nicht direkt pauschalisieren.

Der Blick in der Vergangenheit ist leider dazu oft nicht ganz korrekt, wenn man die Details betrachtet. Du konntest bei S775 nämlich selten wirklich aufrüsten. Neue CPU = neues Board, war eher die Regel. Deswegen ist/war S775 auch nicht sonderlich toll.

Über Sinn und Nutzbarkeit lässt sich natürlich immer streiten, Ich persönlich denke es liegt hier an den Herstellern der Komponenten ob und wann die Geräte dafür bieten. Macht keinen Sinn PCI-E 5.0 zu haben aber nichts daß es nutzt. Klar werden die GPUs neben den NVMe SSDs die ersten sein die es supporten, aber wenn man kaum einen Nutzen davon hat ist es kein Argument das für eine Pro/Contra Entscheidung bei der Anschaffung sprechen sollte.

Kann man so oder so sehen... Ich hab ein PCIe 4.0 fähiges System und nutze 2.0 und 3.0 Geräte. Das läuft doch deswegen trotzdem... Das eine bedingt nicht automatisch das andere. Es ist doch lediglich ein Angebot. Wenn sie es bei AMD nicht liefern im ersten Anlauf, dann liefern sie eben PCIe 5.0 nicht - wenn es Intel liefert, dann ist das ebenso. Davon geht in keine der beiden Richtungen die Welt unter. Zumindest abseits der Markenaffinitäten

Je nach Lebensdauer des Sockels kann das halt auf Dauer dann schon ein Pluspunkt sein/werden, ob das supportet ist oder nicht. Aber das ist soweit in der Zukunft, da kann sonstwas passieren. Die viel interessante Frage ist, ob sie auf der CPU Seite so ne Art S939 > AM2 Sidegrade einschieben oder ob das wieder 10-20% pro Takt Performance drauf gibt. Um so kleiner die Sprünge werden, desto mehr Sinn ergibt es, Standards neuester Art zu supporten, weil der Kunde wahrscheinlich die System auch länger nutzen kann und auch wird.

DDR5 wird im Zuge der Fehlerkorrekturtechniken für die Speicherchips definitiv ein Pluspunkt, der zu einem Wechsel anregen könnte. Aber gerade auch AMD ist ja mit dem IO Die + Compute Die Ansatz zumindest auf dem Papier einfach in der Lage, nen geänderten IO Die nachzuschieben - und dann gibts die gliechen CPUs mit nem neuen IO Die, vllt gepaart mit neuen Board Revisionen und PCIe 5.0 ist quasi ohne Aufwand möglich.

Das mag (auch) ein Henne-Ei Problem sein. Gibt's kein AVX512 im Mainstream, dann gibts auch keine Spiele mit AVX512 Support im Mainstream. Immerhin muss man einen Rechenpfad mit AVX512 und einen ohne pflegen und optimieren. Wenn da massig Stunden reingehen und der Nutzen eher begrenzt ist, dann kann ich jeden Entwickler verstehen, der lieber bei AVX2 bleibt.

Find das immer bisschen putzig, wie man da über die Aufwände spricht... Das wird lange nicht so heiß gegessen als es gelebt wird.

Am Ende ist das eine Frage der Basis. Entwickler entwickeln nicht x-fach. Es gibt ne Basis. Und sollte die mal sagen wir AVX2 only bedeuten, dann wird das dann einfach mit Flags in alternative Renderpfade geschubst, wie heute mit SSE Themen auch schon der Fall. Das ist weniger eine "wir bauen das genau so und deswegen ist das jetzt eben schnell" Thematik. Da wartet auch keiner drauf, dass da jetzt unbedingt AVX512 in die CPUs rein kommt, damit die endlich anfangen können... Sowas denken nur Träumer

Programmierer sind eher pragmatisch.

Btw. ist das auch gar nicht so einfach dort Fortschritte zu erreichen. Denn es gibt immer Leute mit alten Systemen, die beschweren sich dann Lautstark wenns gar nicht läuft. Stichwort SSE4.irgendwas auf alten vor Bulldozer AMD CPUs. Nur sind das schon 10 bis teils 12 Jahre alte CPUs - und man beschwert sich immernoch diese Zeit später. Wie soll das denn mal bei AVX512 ausschauen? Da reden wir dann über 2050 oder so