Werbung

Das bisher unter den Namen Recogni geführte, amerikanisch-deutsche Start-up mit Standorten in San Jose und München, gibt mit dem heutigen Tag nicht nur die Umbenennung in Tensordyne bekannt. Zudem spricht man über seine neuen Ansätze in der effizienteren Behandlung von KI-Algorithmen auf Soft- und Hardware-Level.

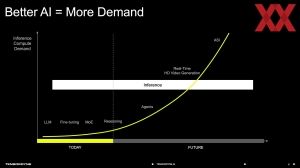

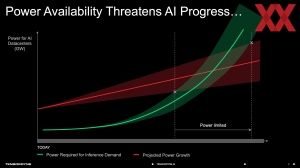

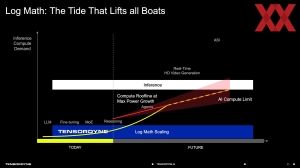

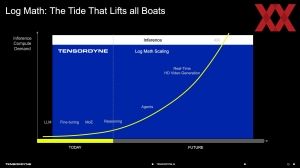

Tensordyne will eines der größten Probleme in der Verwertung großer KI-Modelle angehen: Den hohen Energiebedarf im Inferenzing, der auch immer wieder ein Hauptkritikpunkt in der Nutzung dieser Technik ist. Eine KI-Suchanfrage beispielsweise verbraucht etwa 10-mal mehr Energie als eine konventionelle Google-Suche. Vielmehr noch wird der Bedarf an Inferencing-Leistung in Zukunft immer weiter steigen. Über die ersten LLMs, optimierten Modelle (Fine-tuning), Mixture of Experts-Modelle (MoEs), den ersten Reasoning-Modellen und dem nun immer stärkeren Aufkommen der sogenannten Agents gibt es eigentlich keine "einfachen" KI-Anfragen mehr, sondern die Aufgaben werden immer komplexer, benötigen immer mehr Tokens, bzw. eine höhere Rechenleistung und werden damit immer energieintensiver.

Tensordyne entwickelte noch als Recogni unter anderem effiziente Hardware- und Softwarelösungen für die Echtzeit-Umfelderkennung in autonomen Fahrzeugen. Die Prozessoren von Recogni sind so konzipiert, dass sie große Datenmengen von Sensoren und Kameras extrem schnell und mit sehr niedrigem Energieverbrauch verarbeiten. Zu den Investoren zählen unter anderem Bosch, Continental, BMW und Toyota AI Ventures.

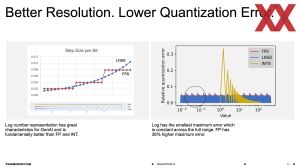

Mathematische Optimierungen wie Sparsity oder die Verwendung Datenformaten wie FP8 und FP4 für das KI-Inferencing ermöglicht durch stärkere Komprimierung eine höhere Rechenleistung und Energieeffizienz bei nahezu gleichbleibender Modellgenauigkeit.

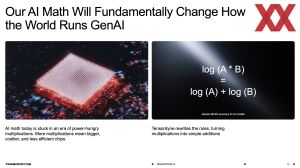

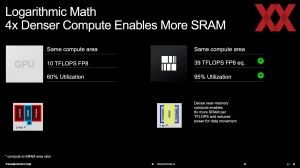

Logarithmische Mathematik soll ein Ansatz von Tensordyne sein, dies weiter zu optimieren. Letztendlich sollen komplexe Multiplikationen durch einfachere Additionen ersetzt und stark wachsende Rechenaufgaben übersichtlicher/sparsamer in ihrer Berechnung werden. Anstatt der logarithmischen Funktion "log (A x B)" wird eine Addition von "log (A) + log (B)" ausgeführt – so das einfache Beispiel von Tensordyne. Gegenüber einer FP16-Multiplikation soll eine Tensordyne FP16-Addition um den Faktor 22 energieeffizienter sein und auch die Fläche auf dem Chip, in dem eine solche Berechnung ausgeführt werden kann, wird deutlich kleiner.

Einen Nachteil hat der Ansatz von Tensordyne allerdings zunächst, denn die recht einfachen logarithmischen Daten müssen addiert werden und dies ist für gewöhnlich recht aufwändig. Zudem ist man nicht das erste Unternehmen, welches diesen Ansatz verfolgt. Microsoft, NVIDIA, Google und viele mehr verfolgen diesen Ansatz ebenfalls.

Der entscheidende Ansatz ist hier von den logarithmischen Daten zu linearen Daten zu kommen, um die Addition zu vereinfachen. Es handelt sich dabei um eine Annäherung – so zumindest unser Verständnis was Tensordyne hier umgesetzt hat. Weitere Details wollte man aber nicht verraten.

Schon beim Wechsel der Modelle von FP32 auf beispielsweise Bfloat16 oder später FP8 und nun verstärkt auf FP4 stellt sich die Frage, wie genau diese Modelle bei immer geringerer Genauigkeit noch sein können. Angaben von 99,9 % oder dergleichen werden hier meist gemacht und sind für die Ausführung der Modelle in der Praxis völlig ausreichend – sprich der Nutzer wird nicht merken, dass das Modell etwas ungenauer wird und in der Bilderstellung noch immer 99,9 % so gut ist, wie bei einer höheren Genauigkeit.

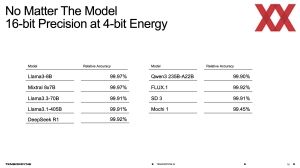

Laut Tensordyne behalten die KI-Modelle selbst unter Verwendung des LNS8 (so der Name des logarithmischen Datenformats) ihre Genauigkeit. Angaben wie 99,97 % für Llama3-8B oder 99,92 % für DeepSeek R1 werden gemacht.

Logarithmische Mathematik und die Hardware

Die Vorteile des neuen LNS8-Datenformats will Tensordyne aber auch in Hardware umsetzen. Durch die geringere Komplexität in der Berechnung wird weniger Chipfläche für diese benötigt und Platz für einen größeren SRAM frei. Das Verhältnis aus Compute-Fläche und SRAM soll sich laut Tensordyne im Verhältnis 1:1 vorliegen.

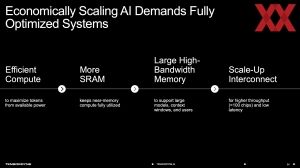

Es benötigt allerdings einen möglichst schnellen und großen Speicher für die Modelle, die bei inzwischen 400 Milliarden Parametern angekommen sind und damit mehrere hundert Gigabyte an Speicherplatz belegen. Die KI-Beschleuniger von AMD und NVIDIA sind bei 288, bzw. 256 GB angekommen. Es benötigt dennoch mehrere Beschleuniger, die dann zusammenarbeiten, um solch große Modelle zu verarbeiten. Entsprechend haben AMD und NVIDIA die Interconnects wie Infinity Fabric Link und NVLink entwickelt, um möglichst viele Chips gemeinsam an einem Problem arbeiten zu lassen. Dies hat auch Tensordyne vor.

Der von Tensordyne entwickelte Chip besitzt 256 MB SRAM und 144 GB an HBM3E. Die Fertigung findet bei TSMC in einem 3-nm-Prozess statt. Der Interconnect verbindet die Chips mit jeweils 460 GB/s unidirektional miteinander. AMD und NVIDIA kommen bei ihrer Interconnect-Technologie inzwischen auf 900 GB/s.

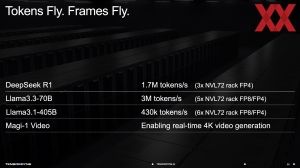

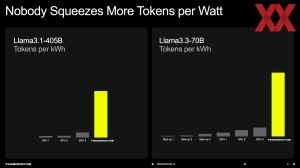

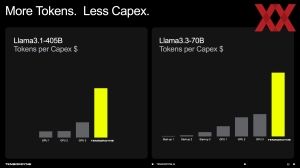

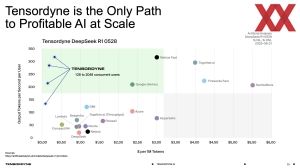

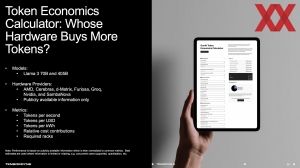

Schlussendlich will Tensordyne seine Chips in ein Rack packen und erreicht darin für Llama 3.3-70B einen Durchsatz von 3.000.000 Tokens pro Sekunde. Laut des MLPerf Inference v4.1 Benchmarks mit Llama 3.3-70B als Referenz kommt NVIDIA für ein GB200-NVL72-System auf 865.000 Tokens pro Sekunde. Zugleich will man nicht nur etwa dreimal mehr Tokens liefern können, sondern dies auch bei einem Achtel der Leistungsaufnahme tun.

Das Tensordyne-SDK soll sicherstellen, dass Nutzer einen niederschwelligen Zugriff auf die Anwendungen und Modelle haben. Unterstützt werden Torch, Huggingface und Triton. Ein zusätzliches Training oder eine Kalibrierung soll der Modelle soll nicht notwendig sein. Die Umwandlung des Datenformats in LNS8 erfolgt automatisch.

Leistungsvergleich mit simulierter Hardware

In einem ersten Beispiel für Llama3.3-70B nannte Tensordyne einen um den Faktor drei höheren Durchsatz an Tokens pro Rack. Auch für andere Modelle sieht man sich in diesem Maße oder gar noch stärker im Vorteil.

Die höhere Effizienz soll es besonders für eine aufwändige Video-Generierung ermöglichen, dass hier ein 4K-Video in Echtzeit erstellt wird. Während es aktuell Beschränkungen in der Auflösung oder Länge der Videos gibt, sieht Tensordyne die Möglichkeit, solche Aufgaben deutlich zu beschleunigen, bzw. die Ergebnisse zu verbessern.

Bisher basieren alle gezeigten Ergebnisse noch nicht auf verfügbaren Chips, denn der Tape-Out des neuen Chips von Tensordyne ist noch nicht vollzogen. Aufgrund der bisherigen Erfahrung mit bereits ausgelieferter Hardware will Tensordyne die Funktionsweise des neuen Datenformats und die Nähe von Simulation und letztendlicher Leistung der echten Hardware bewiesen haben.

Finale Einschätzung erst später möglich

Im kommenden Jahr soll die neue Tensordyne-Hardware in Form von Chips und Racks zur Verfügung stehen. Dann soll es weitere Details zur Hardware und der Umsetzung geben. Bis dahin bleibt es bei denen vom Hersteller gemachten Angaben zur Effizienz und der gesteigerten Rechenleistung im Vergleich zur Konkurrenz.

Ob Tensordyne durch die Nutzung des neuen Datenformats und eine darauf abgestimmte Hardware letztendlich auch zur Konkurrenz von NVIDIA, AMD und Co. werden kann, bleibt abzuwarten. Vor allem die großen Anbieter wie Amazon, Google, Microsoft und ab 2026 wohl auch OpenAI versuchen mit eigener Hardware die Abhängigkeit von vor allem NVIDIA zu reduzieren und können ihre eigene Hardware ebenfalls besser auf das eigene Anwendungsprofil hin optimieren.