Werbung

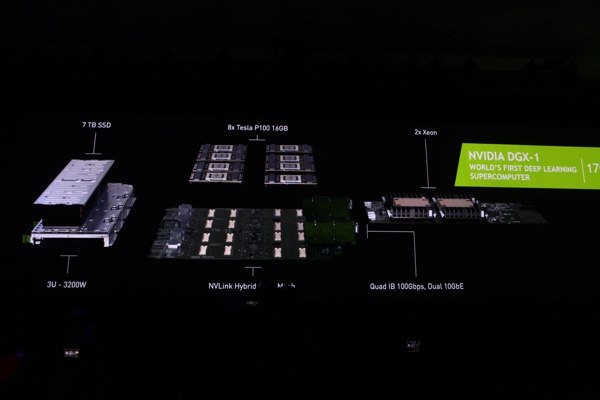

Mit dem DGX-1 präsentierte NVIDIA im Frühjahr einen Deep-Learning-Supercomputer mit acht Tesla P100, die via NVLink miteinander verbunden sind. Alle Details zur verwendeten Pascal-Architektur im Hinblick auf die Compute-Funktionen haben wir in einer gesonderten Meldung bereits zusammengefasst. Wir sehen aktuell das Endergebnis einer jahrelangen Entwicklung, doch bei NVIDIA spricht man auch etwas über die Entwicklung des DGX-1 und hat dies in einem Blogpost zusammengefasst.

Demnach begann die Entwicklung des DGX-1 im Mai 2015 – NVIDIA spricht hier vom Supercomputer selbst, nicht von der Pascal-Architektur oder den dazugehörigen Chips, die sich auch zum damaligen Zeitpunkt bereits seit einigen Jahren in der Entwicklung befunden haben. Im Mai 2015 ist aber bereits die Entscheidung zum Einsatz eines Cube Mesh gefallen, in dem über NVLink acht GPUs miteinander organisiert werden. Zum damaligen Zeitpunkt standen aber noch keine GPUs mit NVLink zur Verfügung. Dies sollte erst einige Monate danach der Fall sein.

NVIDIA DGX-1 Supercomputer mit acht Tesla P100

Nicht nur die Entwicklung der Hardware befand sich im Frühjahr des vergangenen Jahres im vollem Gange, auch die Software musste erst noch entwickelt werden, denn anders ist das Potenzial einer solchen Hardware kaum zu nutzen. NVIDIA entwickelte dazu eine NCCL (NVIDIA Collective Communication Library), welche die Verbindung zwischen der Hardware und den Deep-Learnging-Tools wie Caffe, Theano, Torch, TensorFlow und CNTK sein soll.

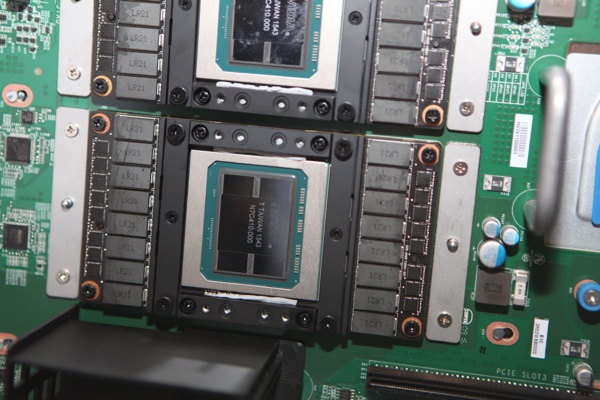

Im November feierte NVIDIA den Tape Out des GP100, der ersten GPU auf Basis der Pascal-Architektur. Für NVIDIA und den Auftragsfertiger TSMC ist eine solche GPU eine besondere Herausforderung, denn NVIDIA wechselte auf die Fertigung in 16 nm. Zusammen mit der Tatsache, dass erstmals HBM der 2. Generation zum Einsatz kommen sollte und die GPU alleine auf 15,7 Milliarden Transistoren kommt, eine Mammutaufgabe für jedes Ingenieursteam. Im Dezember konnten die ersten GPUs für den DGX-1 verwendet werden. In einem ersten Schritt wurden zwei GPUs, dann drei zusammengefasst. Eine vierte GPU konnte zunächst nicht eingebunden werden, da im Code für die NVLink-Infrastruktur noch Teile fehlten. Da auch das finale Gehäuse noch nicht verfügbar war, wurde eine Eigenkreation aus Plexiglas, Metallplatten und Klebeband erstellt.

QuantaPlex T21W-3U

Ende März, nur eine Woche vor der GPU Technology Conference, auf der der DGX-1 offiziell präsentiert werden sollte, wurde der erste Prototyp aus Südkorea in die USA transportiert. Dort sollte er zum ersten Mal präsentiert werden, andere Prototypen dürften zu diesem Zeitpunkt bereits ersten Tests unterzogen worden sein. In einem Deep-Learning-Netzwerk von Google, AlexNet, sollte DGX-1 die 10-fache Leistung gegenüber vergleichbaren Systemen erreichen. Am 3. April, einen Tag vor der GTC 2016, erreichte DGX-1 durch Optimierungen sogar die 12-fache Leistung. Am 5. April präsentierte NVIDIAs CEO den DGX-1 auf der Keynote der GTC 2016.

Derzeit arbeitet der erste Prototyp des DGX-1 in einem Rechenzentrum von NVIDIA und verarbeitet dort Daten des Autonomous-Driving-Team von NVIDIA, welches in New Jersey sitzt. Seit dem 30. Mai wurden die ersten Endkunden-Systeme des DGX-1 an die Kunden ausgeliefert. Damit ist NVIDIA auch der erste Hersteller, der GPUs mit HBM der 2. Generation an Endkunden liefert. Ein DGX-1-Supercomputer kostet 129.000 US-Dollar.