Werbung

Bereits vor einigen Wochen hatten wir berichtet, dass die kommende Grafikkarten-Generation „Arctic Island“ von AMD das Tape-Out erreicht habe und somit nur noch kleinste Änderungen bis zur Serienproduktion vorgenommen würden. Inzwischen hat sich AMD selbst zu Wort gemeldet und bestätigt, dass die kommenden GPUs deutlich effizienter arbeiten sollen. Laut CEO Dr. Lisa Su sei die kommende Generation pro Takt bis zu zweimal effizienter als dies noch bei den aktuellen Modellen der Fall sei.

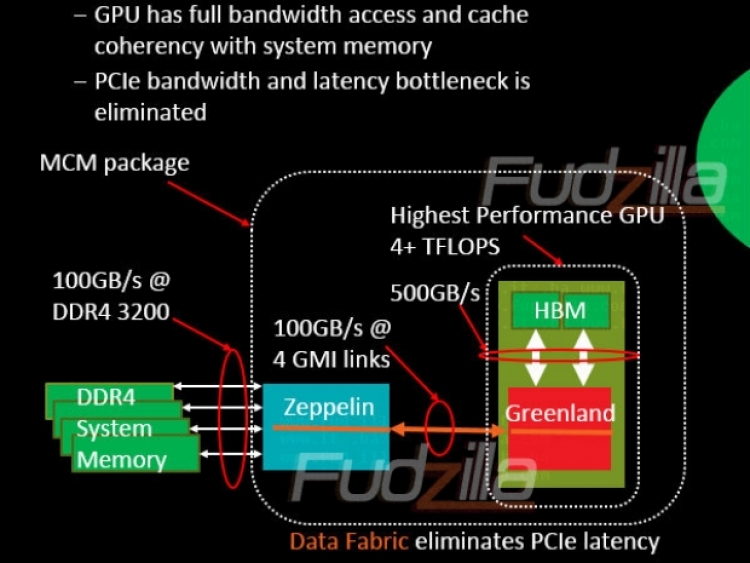

Die Leistungssteigerung würde laut Hersteller jedoch nicht nur durch eine neue Architektur erreicht. Zwar soll diese auch dazu beitragen, jedoch soll vor allem die kleinere Strukturbreite von 16 nm für eine höhere Effizienz sorgen. Die kommenden Grafikchips mt dem Codenamen "Greenland" werden von TSMC im 16-nm FinFET-Produktionsprozess produziert, während die aktuellen 3D-Beschleuniger noch auf den 28-nm-Prozess zurückgreifen. Durch die kleinere Strukturbreite kann AMD auf die gleiche Fläche deutlich mehr Transistoren packen. Die Gerüchte sprechen sogar davon, dass die Anzahl der Transistoren nahezu verdoppelt werden soll. NVIDIA hatte bereits gemeldet, dass die kommenden Pascal-GPUs bis zu 17 Milliarden Transistoren aufweisen soll und wahrscheinlich wird sich AMD auf ähnlichem Niveau befinden.

Weiterhin soll auch die zweite Generation des schnellen HBM-Speichers zum Einsatz kommen, sodass auch an dieser Stelle nochmals ein Leistungszuwachs zu erwarten ist. Die ersten Grafikkarten auf Basis von Artic-Island sollen im kommenden Jahr in den Handel kommen. Wann genau wollte AMD allerdings allerdings nicht verraten.