Werbung

Mit Virtu hat LucidLogix eine Technologie auf den Markt gebracht, die im Desktop-Segment das automatische Umschalten zwischen disketer und integrierter GPU ermöglicht. Relativ schnell gab es dann die Ankündigung, dass AMD und NVIDIA sich nicht die Butter vom Brot nehmen lassen, sondern mit ähnlichen Lösungen aufwarten wollen (wir berichteten). Anders als Virtu sollen diese Lösungen zudem für die Mainboardhersteller kostenfrei sein.

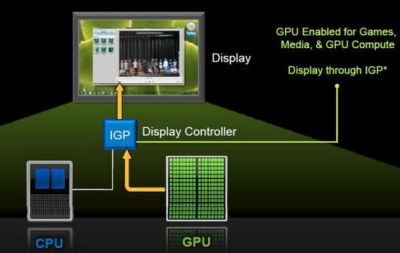

Jetzt sind Details zu NVIDIAs Fahrplan in dieser Angelegenheit bekannt geworden. Demnach soll Desktop-Optimus (auch als Synergy bezeichnet) auf der kommenden COMPUTEX in Taipei präsentiert werden - also im Zeitraum vom 31. Mai bis zum 4. Juni. Eine erste Folie verrät bereits Details zu Desktop-Optimus. Demnach sollen vorerst Mainboards mit den Intel-Chipsätzen H61, H67 und Z68 unterstützt werden. Mindestens ein Bildschirm muss an die integrierte GPU angeschlossen werden. Wie Virtu wird auch Desktop-Optimus die Möglichkeit bieten, Intels Quick Sync-Technologie bei vorhandener diskreter GPU zu nutzen.

Weiterführende Links: