Werbung

Mit der GeForce GTX 560 steht NVIDIAs neue Midrange-Lösung in den Startlöchern. Basierend auf dem GF114 soll sie mit ihren 384 Shader-Prozessoren vor allem der Radeon HD 6950 Paroli bieten können (wir berichteten). Die Gerüchteküche Fudzilla will jetzt neue Informationen zu dieser Grafikkarte in Erfahrung gebracht haben.

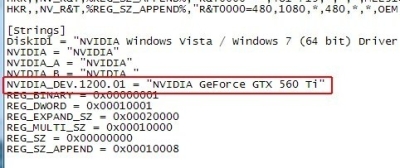

So soll für diese Grafikkarte ein geradezu historisches Kürzel reaktiviert werden. Das "Ti" als Abkürzung von "Titanium" kam z.B. bei dem erfolgreichen Midrange-Modell Geforce4 Ti 4200 zum Einsatz. Scheinbar will NVIDIA an diese Tradition anknüpfen. Enthüllt wurde diese Benennung durch einen geleakten Treiber (266.44). Nachdem Gerüchten zufolge schon AMD die FX-Prozessoren wiederauferstehen lassen wird (wir berichteten), wäre die GeForce GTX 560 Ti eine weitere Rückbesinnung auf längst vergangen geglaubte IT-Zeiten.

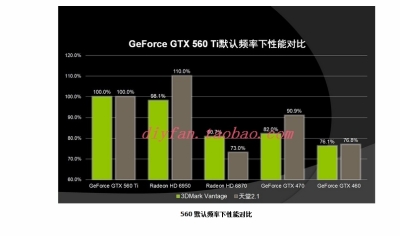

"Butter bei die Fische" gibt es in einer zweiten Fudzilla-Meldung, die erste Benchmarkergebnisse der GTX 560 Ti im 3DMark Vantage enthüllt. Diese Ergebnisse stammen ursprünglich aus dem chinesischen Forum Chiphell.com. Demnach ist die die neue Midrange-Karte etwa 25 Prozent schneller als ihr Vorgänger, die GeForce GTX 460 und als die Radeon HD 6870. Sie kann sogar der Radeon HD 6950 gefährlich werden. Die in unserer letzten News enthüllten Spezifikationen wurden bestätigt und im Detail ergänzt. Neben den 384 Shader-Prozessoren soll die Karte demnach über 32 ROPs verfügen. Der 1024 MB große GDDR5-Speicher wird per 256-Bit-Interface angebunden, die Bandbreite liegt bei 128,3 GB/s. Der GPU-Takt soll bei 823 MHz liegen, Shader und Speicher mit 1645 bzw. 1002 MHz takten.

Weiterführende Links: