Werbung

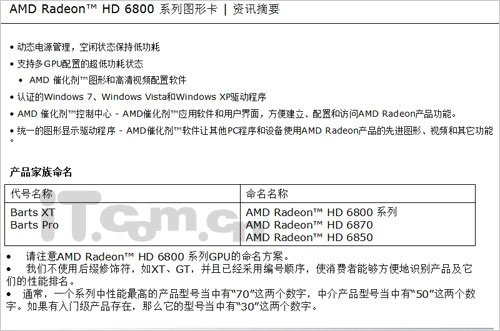

Es vergeht kaum ein Tag, an dem keine weiteren Informationshäppchen zur kommenden Grafikkarten-Generation von AMD ans Tageslicht gelangen. Während man bislang davon ausgehen konnte, dass unter dem Codenamen "Caymen" die High-End-Modelle der AMD-Radeon-HD-6000-Familie erscheinen werden und "Barts" hingegen die langsameren-Ableger darstellt, könnte es nun ganz anders kommen. In einem PDF-Dokument, welches jetzt im Forum von Chiphell.com auftauchte, wird verraten, dass die AMD Radeon HD 6870 und Radeon HD 6850 auf den "BartsXT"- bzw. "BartsPro"-Chip aufbauen sollen. Zieht man die Gerüchte der letzten Tage zum Vergleich heran, so kann "BartsXT" in seiner Vollbestückung auf insgesamt 1280 (320 4D) Streamprozessoren, 64 Textureinheiten und 32 Rasterendstufen zurückgreifen. Zusammen mit Taktraten von 900 respektive 1050 MHz für den 1024 MB großen GDDR5-Videospeicher, welcher weiterhin über 256 Datenleitungen kommunizieren soll, würde es eine AMD Radeon HD 6870 auf eine arithmetische Rohleistung von maximal 2.304 TFlops bringen. Der ältere "CypressXT"-Chip - besser bekannt als ATI Radeon HD 5870 - bringt es dabei allerdings schon 2.720 TFlops.

Würde man von diesem Leistungsrückschritt allerdings absehen, so stellt sich die Frage, was dann mit "Caymen" und "Antilles" passieren würde. Sicherlich könnte "Caymen" Karten der AMD-Radeon-HD-6900-Reihe umfassen, was wäre aber dann mit den Dual-GPU-Modellen, welche eigentlich unter dieser Produktbezeichnung laufen? Was passiert mit "Antilles"? Eine AMD Radeon HD 6890 oder gar AMD Radeon HD 6990 fallen ebenfalls aus, da die Grafikschmiede bislang immer auf Kürzel wie 30, 50 und 70 vertraute. Die letzten Worte sind dabei also noch längst nicht gesprochen.

Viel erfreulicher ist aber die Tatsache, dass das PDF-Dokument weitere Features der kommenden Generation nennt. Demnach unterstützen die neuen Modelle nicht nur ATI Eyefinity, sondern sogar auch ATI EyeSpeed. Was sich dahinter allerdings verbirgt, ist noch nicht bekannt. Auch einen 3DVision-Gegner wir es mit AMD HD3D endlich geben – die genaueren Informationen hierzu folgen leider etwas später. Zu guter Letzt wird man auch UVD3 unterstützen. Obwohl die Gerüchte in den letzten Wochen durchaus vielversprechend aussahen, kann man noch längst nicht von ihrer Richtigkeit ausgehen. Tatsache ist aber, dass die AMD-Radeon-HD-6000-Familie demnächst vorgestellt werden wird.

Wir sind weiter gespannt und halten Sie auf dem Laufenden!

Weiterführende Links: