Hallo zusammen,

ich plane einen neuen Build mit einem Threadripper 9970X und das Ziel ist, später bis zu 3-4 RTX 5090 zu betreiben. Um das Budget vorerst im Rahmen zu halten, werde ich zunächst mit einer einzigen RTX 5090 starten.

Das ist meine aktuell geplante Konfiguration:

ich plane einen neuen Build mit einem Threadripper 9970X und das Ziel ist, später bis zu 3-4 RTX 5090 zu betreiben. Um das Budget vorerst im Rahmen zu halten, werde ich zunächst mit einer einzigen RTX 5090 starten.

Das ist meine aktuell geplante Konfiguration:

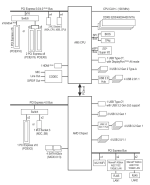

- Mainboard: Gigabyte TRX50 AI TOP

- CPU: Threadripper 9970X

- Gehäuse: PHANTEKS Enthoo Pro 2 Server Big-Tower

- Netzteil: SEASONIC PRIME PX-2200 2200W

- Arbeitsspeicher (RAM): V-Color DDR5 | OC R-DIMM | AMD Ryzen TRX50 | Workstation Memory 4x48GB

- SSD: Samsung 4.0 TB 9100 PRO M.2 NVMe SSD

- CPU-Kühler: Silverstone SST-XE360-TR5 Wasserkühlung

- Gehäuselüfter: 3-4x?

- Sieht die Zusammenstellung im Großen und Ganzen vernünftig aus?

- Gibt es bessere Empfehlungen für das Gehäuse (Tower)? Bei der Kühlung bin ich mir auch sehr unsicher, da ich selbst noch nie eine Wasserkühlung verbaut habe. Ist die von mir ausgewählte eine gute Wahl? Oder sollte ich vielleicht sogar auf Luftkühlung setzen? Welche Art von Gehäuselüftern wäre zu empfehlen?

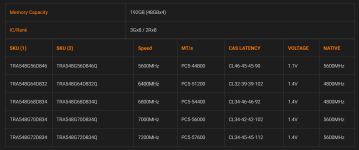

- Was den RAM angeht: Ich habe gesehen, dass V-Color auf der QVL (Qualified Vendor List) des Mainboards steht, aber die Module sind für mich in Europa sehr schwer zu bestellen. Gibt es da gute Alternativen? Ich würde sogar 4x64GB bevorzugen, falls das funktioniert. Wäre alternativ auch eine Konfiguration mit 8x32GB möglich?