G

gucklochfahrer

Guest

Ja, auf diese Passage von Jensen ist er im Video explizit eingegangen. Der "NVidia way" damit umzugehen halt. Die haben sich mit 3000 verspekuliertAlso doch künstliche Verknappung?

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Ja, auf diese Passage von Jensen ist er im Video explizit eingegangen. Der "NVidia way" damit umzugehen halt. Die haben sich mit 3000 verspekuliertAlso doch künstliche Verknappung?

Ich hoffe, dass sich evtl. mit Release von RDNA3 nochmal etwas verändert, auch wenn ich nicht daran glaube aber bis dahin werde ich in jedem Fall mal abwarten.

das war in dem video von steve.@Scrush

Beitrag automatisch zusammengeführt:

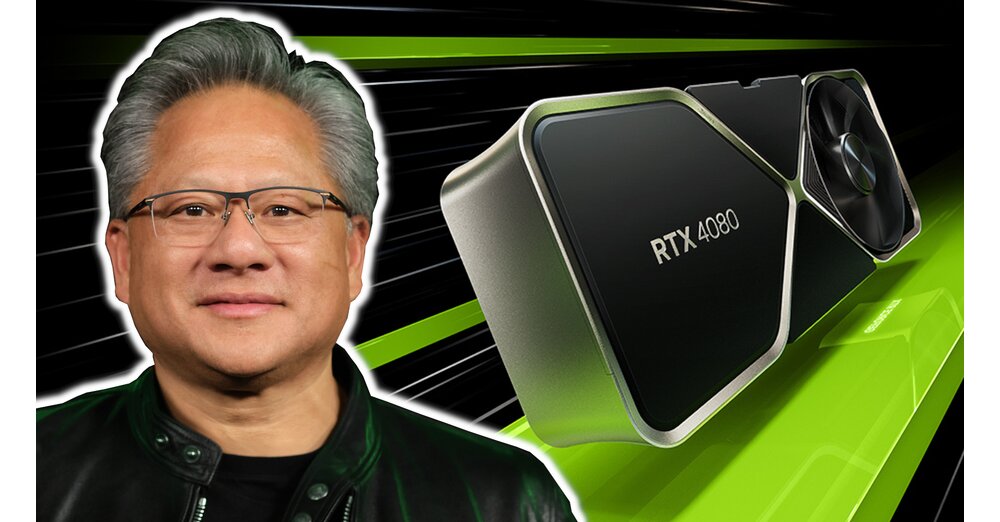

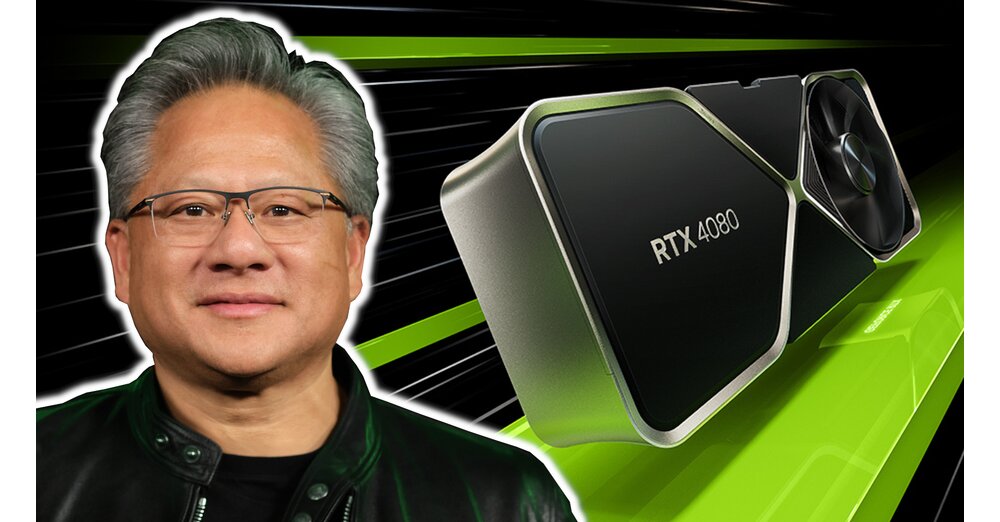

Von welcher Quelle bzw Streamer kommt denn dieses Bild denn her?

Hat der nicht mal gesagt, dass Grafikkarten sich vom Preisniveau an Konsolen annähern sollen? Oder war das jemand anderes gewesen?Tja mit Pech muss man dann im November direkt wieder auf RDNA3 wechseln, wenn die schneller sind aber Jensen hat ja heute gesagt, das die GPU Preise nicht mehr gesenkt werden, dann sollte man ja seine 4090 noch gut verkauft bekommen.

Tja mit Pech muss man dann im November direkt wieder auf RDNA3 wechseln, wenn die schneller sind aber Jensen hat ja heute gesagt, das die GPU Preise nicht mehr gesenkt werden, dann sollte man ja seine 4090 noch gut verkauft bekommen.

Genau daran werde ich die 4090 messen. Aktuell ist meine 3090 nicht dazu in der Lage alles in 4K mit 60Hz darszustellen. Wenn die 4090 tatsächlich jedes aktuelle Spiel in 4K, Raytracing, max. Details... ohne DLSS in 60 FPS darstellen kann, werde ich sie mir holen. Ansonsten warte ich weiterhin auf eine echte 4K Karte.Am Ende wird sowieso nicht jedes Game mit 4K, 144 Hz, RTX ON, vsync usw. flüssig laufen.

Kann ich nachvollziehen, hier will ein 4k OLED mit bis zu 120fps bedient werden. Das benötigt einfach viel Leistung.Genau daran werde ich die 4090 messen. Aktuell ist meine 3090 nicht dazu in der Lage alles in 4K mit 60Hz darszustellen. Wenn die 4090 tatsächlich jedes aktuelle Spiel in 4K, Raytracing, max. Details... ohne DLSS in 60 FPS darstellen kann, werde ich sie mir holen. Ansonsten warte ich weiterhin auf eine echte 4K Karte.

Hä? Ada hat weiterhin 128 Einheiten pro SM, von denen 64 feste FP32 Einheiten sind und 64 weitere, die entweder INT32 oder ebenfalls FP32 rechnen können.Nun ist es offiziell ada ist ein Turing Nachfolger mit 64 fp32 pro sm

Eine deutliche höheren dichte was zur folge hat das die 64 fp23 sehr heiß werden

Anzunehmende Leistung

rtx4090 +42% vs rtx3090ti

rtx4080 16gb +0% vs rtx3090ti

rtx4080 12gb +25% vs rtx3070ti

keine fp64 Einheiten die wie bei ampere für zusätzlich fp32 pro sm sorgten

40-50 fps, also wirklich schön spielt es sich @4k nicht aber was bringt mir DLSS 3.0 wenn es Kacke aussieht?Anhang anzeigen 795058

Kann jemand der das Spiel und eine 3090 und/oder 3090 Ti hat gucken, was die FPS sein würden, wenn man DLSS "ON" stellt? ist doch schon mal ein Anfang

Wenn die Herstellkosten steigen gibts auch irgendwo nen unteren Grenzpreis. Also Herstellkosten + Logistik + Admin + Gemeinkosten + erwünschter Gewinn. Selbst wenn du beim erwünschten Gewinn, bei Gemeinkosten usw. runter gehst... irgendwann biste beim unteren Grenzpreis ab dem du miese machst, wenn du weiter runter gehst.Am Ende bestimmt der Markt den Preis, nicht der Hersteller. Auch nicht mit Bekräftigungen.

Zitat aus dem Artikel: "Allerdings können die Hersteller im traditionell starken dritten Quartal dieses Jahr nicht an die Verkaufszahlen von 2018 anknüpfen: Insgesamt verkauften sie 89 Millionen GPU-Einheiten, was gegenüber dem dritten Quartal 2018 einem Minus von sechs Millionen Einheiten beziehungsweise 5,6 Prozent entspricht."