Mein persönlicher Favorit ist der Chiplet Ausbau auf max. 12 Kerne

Dies hätte ich auch vermutet, aber es scheint derzeit nicht danach auszusehen, da es ja pro CCD bei 8 Kernen zu bleiben scheint. Es könnte allenfalls wieder zurück zu zwei CCDs pro Chiplet gehen, so wie es bei Zen2 ja der Fall ist. Dies wäre dann aber für die Latenz zwischen den Kernen auf unterschiedlichen CCDs eines Chiplets nicht optimal.

Die Grafik dürfte wohl für nicht mehr als eine Bildausgabe und das Abspielen von Videos ausgelegt sein.

Das reicht doch auch, wer mehr will, kauft entweder eine richtige APU, dann bekommt er halt weniger Kerne oder eine Graka, an deren Leistung eine APU sowieso nie rankommen kann.

Für die 12 und 16 Kerner finde ich 170W auch nicht übertrieben viel. Das braucht es halt, damit solche CPUs auch mit entsprechend hohem Takt laufen können. Aktuell ist der Takt bei denen aufgrund der max. 142W Verbrauch ja generell geringer als beim 8 Kerner.

Das wird AMD wohl ändern wollen.

Anzunehmen. Wenn die Gerüchte um die Leistung von Alder Lake stimmen, dann hat die Konkurrenz aufgeholt und AMD wird kein Mittel auslassen, welches einen Leistungsvorteil verspricht. Intel hatte eben wegen der Probleme mit dem 10nm Prozess lange Probleme und da diese nun offensichtlich überwunden sind, müssen sich nun beide wieder richtig ins Zeug legen.

Im Consumerbereich halte ich 170 W für ausgeschlossen. Man muss ja bedenken, dass solche CPUs (wenn auch selten) in OEM-Rechnern zum Einsatz kommen würden und OEM sind ja nicht bekannt dafür, wahnsinnig viel Geld für gute Kühler auszugeben.

Erstens spielt der OEM Bereich bei AMD längst nicht die Rolle wie bei Intel, zweitens wären diese TDP nur für die Spitzenmodelle, es wird für die preissensiblen Segmente wie die Officekisten sicher auch CPUs mit weit weniger TDP geben und drittens gibt es ja auch heute schon OEM Rechner mit CPUs mit so viel oder noch mehr TDP. Die sind dann natürlich sowohl von der Zielgruppe als auch preislich in einem anderen Bereich angesiedelt als kleine Officekisten.

Ähnlich wie intel gibt die TDP einer CPU nur den "normalen" Verbrauch an, exklusive Turbo.

Sofern im BIOS das PL1 Power Limit entsprechend der Intel Vorgab (TDP) eingestellt ist.

Die Effizienz der AMD Ryzen 5000 ist weit besser

Lies mal dies hier:

28535402

Davon abgesehen ist es derzeit ein Vergleich von Intels 14nm zu TSMC 7nm und obendrein ist es von der Effizienz her immer besser mehr Kerne mit weniger Takt als weniger Kerne mit mehr Takt zu betrieben, sobald man in den Taktbereich kommt, in dem die Effizienz fällt:

Hebt AMD nun den Stromverbrauch bei den kommenden CPUs etwas weiter an und bringt dadurch entsprechend viel Mehrleistung zustande, ist das absolut ok. Intel hingegen hat diese Aktion gebracht um am Ende trotzdem kaum Mehrleistung zu bieten. Ein totaler Fail halt.

Auch AMD wird nicht zaubern können, wenn sie mehr Takt wollen, werden sie an Effizienz verlieren, weil sie in der Kurve weiter nach rechts rücken und auch wenn diese Kurven bei jeder CPU anderes aussieht, so ist sie im Prinzip immer ähnlich. Intel bewegt sich weiter oben in Taktbereichen die auf diese Kurve nicht zu sehen sind, aber ich haben keine andere und wenn Intel das macht ist es entweder genauso in Ordnung oder Fail wie wenn AMD dies macht, sonst wäre das mit zweierlei Maß gemessen.

Heatdensity ist bei den immer kleiner werdenden Fertigungsgrößen sicherlich zunehmend ein Problem

Das auf jeden Fall, aber man sollte nicht vergessen, dass die Strukturen auf den Chips unterschiedliche Größen haben, so sind die Transistoren größer, wenn diese mit hohen Taktraten arbeiten, also eben gerade in den Kernen.

Letztendlich ist die Fertigungsgröße Hupe, es geht hauptsächlich um die Fläche des Chiplets und die Leistung, die über diese Fläche abgeführt werden muss.

Nein, die Hotspots spielen auch eine Rolle.

Laut Wikipedia ist die Leitfähigkeit von Silizium mit 163 weit geringer als von reinem Alu mit 236 oder reinem Kupfer mit 401. Für Legierungen sehen die Werte etwas anders aus, aber liest noch mal dies:

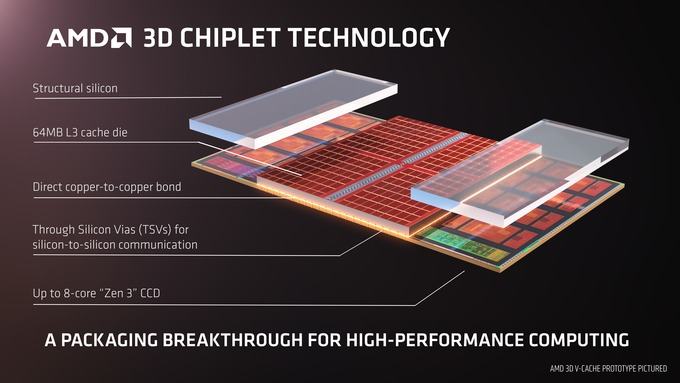

AMD zeigt Ryzen-Prozessor mit gestapeltem 3D V-Cache.

www.hardwareluxx.de

AMD stapelt den 3D V-Cache bewusst nur über den L3 Cache auf dem Chiplet und dies würde keinen Sinn machen, wenn deine Aussage stimmen würde und es für die Wärmeabfuhr nur auf die Fläche und Leistung des ganzen Chiplets ankommen würde. Totes Extrasilizium an den Seiten eines Chips bringt für die Kühlung praktisch nichts, da die Wärme vor allem von Die auf den HS/Kühlkörper darüber geht, zumal bei einem verlöteten HS.

Im 4K-tauglichen HEDT-Segment geht der Trend offenbar kontinuierlich in Richtung 200 W für die CPU und 400 W für die GPU.

Das ist eben das Ergebnis der Konkurrenzsituation, die die Hersteller zwingt, die Leistung zur Not mit der Brechstange über den Takt zu holen um vorne zu sein bzw. mithalten zu können. Solange aber immer noch so viele Leute lieber übertakten und einen besseren Kühler kaufen um dann die Temperaturen in den Griff zu bekommen als über die BIOS Einstellungen das OC zurückzuschrauben, scheint das ja zu sein was die Kunden möchten und die Hersteller werden immer bemüht sein die Kundenwünsche zu bedienen, sonst verkaufen sich die Produkte nämlich schlecht. Aber es gibt ja auch Optionen für Energiesparer, die leisten dann aber eben auch weniger.

www.hardwareluxx.de

www.hardwareluxx.de