Werbung

Alle aktuellen IT-Systeme führen ihre Berechnungen aktuell auf Prozessoren aus, die im Grunde nur zwei Zustände kennen – 0 und 1. In Binärzahlen ausgedrückt werden sämtliche Berechnungen und Speichervorgänge ausgeführt. Doch trotz des Moorsches Gesetzes wird der Verdopplung der Integrationsdichte der Transistoren alle 18 Monate irgendwann eine Grenze auferlegt sein, auch wenn diese durch Intel und andere Hersteller immer wieder nach hinten geschoben wird.

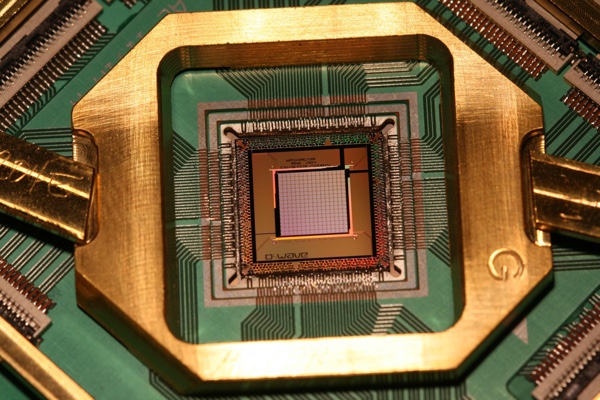

Quantencomputer sollen in absehbarer Zukunft eine Alternative sein. Viele große Unternehmen und Forschungsinstitute arbeiten seit Jahren an der praktischen Umsetzung dieses Projektes. Nachdem immer wieder Zweifel aufkamen, ob ein Quantencomputer überhaupt funktionieren könne, scheint zumindest dieser Punkt seit einigen Jahren unstrittig. Google, die NASA und die Universities Space Research Association (USRA) forschen seit Jahren an einem Projekt namens D-Wave. Dabei handelt es sich um einen Quantancomputer, der bisher mit 512 QuBits arbeitete.

Bevor wir aber zu den QuBits kommen, noch einmal ein Blick auf unser binäres System, auf dem die aktuelle Technik arbeitet. Dort wird mit Transistoren gearbeitet, die offen oder geschlossen sein können. Ein offener Transistor repräsentiert eine 0 und ein geschlossener Transistor eine 1. Ein Quantencomputer arbeitet aber nach dem Prinzip der Quantenmechanik und darin anhand der Superposition. Eine gleiche physikalische Größe kann sich dabei überlagern, ohne sich dabei gegenseitig zu behindern. Ein QuBit kann also gleichzeitig eine 1 und eine 0 repräsentieren. Die genauen physikalischen Vorgänge dahinter beschreibt die Quantenmechanik. Für die Beschreibung des Quantencomputers bliebt wichtig, dass ein Bit oder QuBit eben nicht nur 0 oder 1 sein kann, sondern 0 und 1 gleichzeitig. Binär ausgedrückt werden über ein QuBit 00, 01, 10 und 11 repräsentiert. Mit einer Steigerung der QuBits steigt somit auch die Rechenleistung des Systems exponentiell an.

Soweit mag dies noch alles einleuchtend sein und bringt die Frage auf, warum Computer nicht heute schon so arbeiten. Doch der Aufbau eines Quantencomputer und der einzelnen QuBits gestaltet sich sehr schwierig. Sobald die Informationen aus einem QuBit ausgelesen werden, werden diese dekohärent – sind danach also verändert und müssten für eine Speicherung erneut geschrieben werden. Aber dies ist nur eine der Hürden, die noch genommen werden müssen.

D-Wave in seiner ersten Version wurde 2007 gebaut und verwendete 16 QuBits. Inzwischen war man bei 512 QuBits angelangt, wobei jeder QuBit einen kleinen superleitenden Schaltkreis darstellt. Dieses System wird dazu extrem niedrigen Temperaturen ausgesetzt und ermöglicht so einen Stromfluss in beide Richtungen. Über Algorithmen und das erkennen bestimmter Muster bei Temperaturerhöhungen wird die Berechnung ausgeführt. Physikalisch sind auch hier viele Prozesse gleichzeitig im Gange, die sich nur schwer erklären lassen. D-Wave ist vermutlich auch noch kein echter Quantencomputer, es werden noch keine echten Berechnungen ausgeführt, sondern er wird dazu verwendet zu verstehen, wie dies früher oder später funktionieren könnte.

Der Ausbau auf nun mehr als 1.000 QuBits soll dazu der nächste Schritt sein. Dabei muss man sich zunächst auch einmal vor Augen führen, welche technischen Voraussetzungen geschaffen werden müssen, damit D-Wave überhaupt funktioniert. Alleine das Kühlsystem verbraucht mehr als 15.000 W, während der Chip selbst auf nur wenige Mikrowatt kommt. Der Ausbau von 512 auf mehr als 1.000 QuBits soll aber gelungen sein, ohne dass dabei der Verbrauch signifikant gestiegen ist. Dies soll ein entscheidender Schritt bei der Entwicklung der Quantencomputer sein, auch wenn die Auswirkungen aktuell minimal klingen.

Bis die klassischen Computer an ihre Grenzen stoßen, werden noch einige Jahre wenn nicht Jahrzehnte vergehen. Bis dahin werden sich die Quantencomputer sicherlich auch auf ein praktikables Niveau entwickelt haben – auch wenn diese Schwelle derzeit auf beiden Seiten noch nicht abzusehen ist.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen