Werbung

Ähnlich wie die Speicherbandbreite bei modernen GPUs zu einem immer entscheidenderen Faktor wird und vermutlich auch dazu führt, dass wir in den nächsten Generationen bereits Implementationen von 3D Memory oder High Bandwith Memory (HBM) sehen werden, so wird gerade im Server-Bereich der Interconnect zwischen GPUs untereinander aber auch zu übrigen Komponenten immer wichtiger. Auf der GTC 2014 im Frühjahr präsentierte NVIDIA eine neue Technologie namens NVLINK. NVLINK soll für die nahe Zukunft eine schnelle Verbindung ermöglichen und damit den offensichtlichen Flaschenhals eines modernen Server-Systems lösen.

Um zu verstehen wo NVLINK ansetzen wird, sollte man sich ein paar Zahlen vor Augen führen: So beträgt die Bandbreite für PCI-Express bis zu 16 GB pro Sekunde. Zwischen dem Arbeitsspeicher und dem Prozessor sind es 60 GB pro Sekunde und moderne GPUs kommen über ein 512 Bit breites Speicherinterface auf über 300 GB pro Sekunde. Bei den GPUs ist bereits ein Trend zu neuen Wegen für die Anbindung des eigenen Speichers zu erkennen. Doch inzwischen geraten die Herstellern an technische Grenzen und müssen sich außerdem Mittel und Wege einfallen, große parallelisierte Systeme schnellstmöglich untereinander anzubinden.

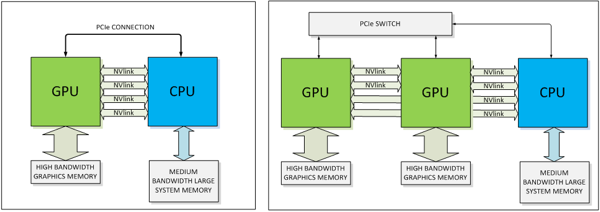

Bereits auf der GTC 2014 wurde NVLINK für eine Server-Version (GPU-Beschleuniger) der Pascal-Architektur vorgestellt. Dabei setzt NVIDIA NVLINK eine direkte Punkt-zu-Punkt-Verbindung ein. Diese besteht wiederum aus jeweils acht Lanes pro NVLINK-Verbindung. Pascal wird zunächst einmal vier NVLINKs anbieten können. Laut NVIDIA lässt sich deren Anzahl aber auch abhängig vom gewünschten Zielmarkt anpassen. Die NVLINK-Verbindungen können flexibel zusammengefasst, um auch hier wieder dem jeweiligen Anwendungsfall gerecht zu werden. Denkbar ist beispielsweise eine einfache GPU-CPU-Verbindung, aber auch ein Netzwerk aus GPU-CPU- und GPU-GPU-Verbindungen. Hier kommt nun auch IBM ins Spiel. Die Server-Sparte von IBM meldete laut NVIDIA bereits großes Interesse an und war somit auch einer der ersten Hersteller, der eine Zusammenarbeit ankündigte.

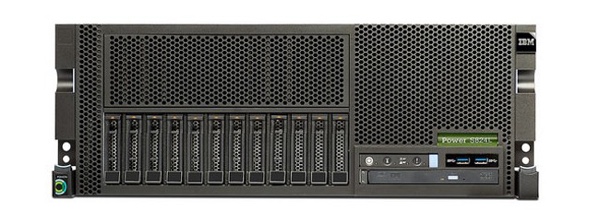

Am Freitag präsentierte IBM das Power S824L System. Darin zum Einsatz kommen IBMs Power8-Prozessoren sowie Tesla-Grafikkarten. IBM sieht spezielle Datenbank-Systeme und Modellberechnungen mit SOAP3, NAMD, GROMACS, FFTW und Quantum Espresso als Anwendungsfeld dieser Hardware. Doch der aktuellen Hardware sind bereits heute Grenzen gesetzt, die man ab 2016 durch NVLINK umgehen möchte. Neben dem Interconnect mehrerer GPUs in einem Server-Rack dürfte NVLINK aber auch die Datenübertragung zwischen den einzelnen Racks und damit die Gesamtperformance eines Servers beschleunigen. Häufig kommen hier 40Gb-Ethernet-Adapter zum Einsatz, die bidirektional 40 GBit pro Sekunde erreichen sollen, in der Praxis aber für beide Kanäle auf 50 GBit pro Sekunde limitiert sind. Grund hierfür sind die nur acht PCI-Express-Lanes, über die solche Erweiterungskarten angebunden sind. Entsprechende Erweiterungskarten mit 16 Lanes gibt es nicht, da in den Servern häufig keine dazugehörigen Slots angeboten werden oder diese bereits durch die GPU-Beschleuniger belegt sind.

Wie genau die Implementation von NVLINK aussehen soll, verraten NVIDIA und IBM allerdings noch nicht. Zur GTC 2015 erwarten wir uns hier weitere Erkenntnisse, die dann vermutlich auch Auskunft darüber können, ob NVLINK für den Endverbraucher interessant werden könnte.