Werbung

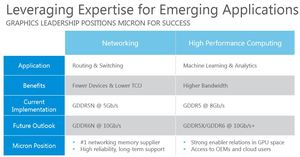

Die derzeit schnellsten Speicherstandards bei den Grafikkarten heißen HBM2 mit bis zu 1.024 GB/s und GDDR5X, der einmal bis zu 512 GB/s ermöglichen soll. Beide Speicherstandards unterscheiden sich maßgeblich durch die Breite des Speicherinterfaces und arbeiten daher mit unterschiedlichen Takten. Während HBM2 mit 1.024 Bit pro Speicherchip daher kommt, sind es bei GDDR5X 190 Bit. HBM2 wird von NVIDIA bereits für die GP100-GPU eingesetzt und wird sich mit der Vega-Architektur bei AMD auch in den ersten Gaming-Grafikkarten einfinden.

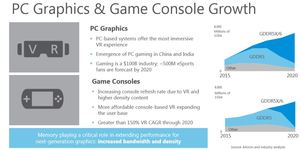

Aufgrund der einfacheren Bauart sowie Anbindung wird GDDR-Speicher im preisbewussten Markt noch lange eine wichtige Rolle spielen und will dabei hinsichtlich der Geschwindigkeit noch einen Zahn zulegen. High Bandwidth Memory hingegen wird im High-End-Segment mehr und mehr Verbreitung finden, sich aber noch lange nicht im Massenmarkt durchsetzen können.

GDDR6 steigert die Bandbreite pro Pin auf 16 GB/s, was 10x schneller als DDR3 ist. GDDR5X kommt derzeit auf 10 GB/s und soll später einmal ebenfalls 16 GB/s erreichen. GDDR6 oder eben der schnelle GDDR5X würden bei einem 256 Bit breiten Speicherinterface eine Gesamt-Speicherbandbreite von 384 auf 512 GB/s ermöglichen. Während es im HPC-Bereich allerdings keine Frage ist, dass eine schnelle Speicheranbindung von entscheidender Bedeutung ist, profitieren Gaming-Grafikkarten nicht zwangsläufig in diesem Maße davon. Moderne Kompressionsalgorithmen helfen den Speicherbedarf und die benötigten Speicherbandbreite zu reduzieren. Moderne Speichercontroller, wie der in der Vega-GPU, sollen ebenfalls durch unterschiedliche Optimierungen ihren Beitrag leisten.

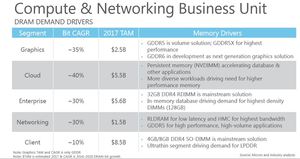

Für GDDR5-Speicher sieht Micron ein Marktpotenzial von 2,5 Milliarden US-Dollar im aktuellen Jahr und dies soll in den kommenden Jahren nicht weniger werden. Nicht nur Desktop-Grafikkarten werden damit bestückt, auch in Konsolen soll GDDR-Speicher eine immer größere Verbreitung finden.

Micron nennt derzeit keinen konkreten Fahrplan für GDDR6. In Branchenkreisen geht man allerdings davon aus, dass Micron Ende 2017 erste Samples ausliefern will, sodass Hersteller wie NVIDIA, AMD, Sony und Microsoft für 2018 mit entsprechenden Produkten planen können. Bis 2020 soll GDDR6 die alten Standards dann fast vollständig abgelöst haben.