Werbung

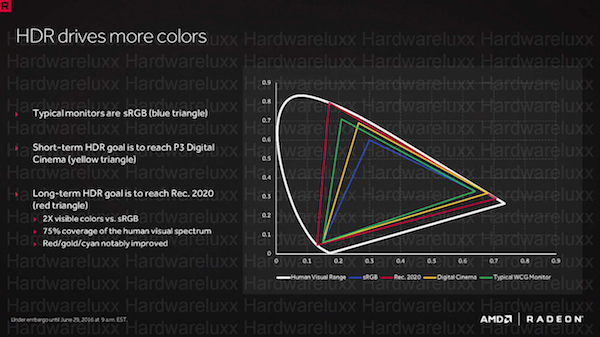

Das Thema HDR wird uns in Zukunft immer wieder beschäftigen und das nicht nur, weil womöglich immer mehr Inhalte auf den größeren Dynamikumfang setzen, sondern auch weil es hier keinen echten Standard gibt und sowohl auf Seiten der Inhalte-Anbieter wie auch auf Seiten der Hardware-Hersteller keine einheitliche Vorgaben gemacht werden. Dies gilt sowohl für die maximale Helligkeit eines Displays, wie auch für den Farbraum, der dargestellt werden kann. Angaben wie P3 Digital Cinema und Rec. 2020 geben bei den Farben zumindest den genauen Farbraum an, ein HDR-Standard sind sie damit aber noch lange nicht.

Wie die Kollegen der c't nun herausgefunden haben, bedient sich auch AMD einiger Tricks bei der Wiedergabe von HDR-Inhalten. So geben die aktuellen Radeon-RX-Grafikkarte mit Polaris-GPU in PC-Spielen nur Frames mit einer Farbtiefe von 8 Bit statt 10 Bit pro Farbkanal aus, wenn die Ausgabe per HDMI 2.0 erfolgt. Um die fehlenden zwei Bit zumindest etwas zu kompensieren, wird ein Dithering-Verfahren im Bezug auf die Gamma-Kurve eingesetzt – eine sogenannte Perceptual Curve. Damit sind die Farbverläufe dann dennoch ohne sichtbare Abstufungen, wenngleich die eigentliche HDR-Farbwiedergabe nur berechnet wird und nicht aus dem Quellmaterial, in diesem Fall der Berechnung durch die Engine, stammt.

Bei der Übertragung mittels DisplayPort 1.3/1.4 besteht dieses Problem nicht, allerdings nutzen die meisten Fernseher den HDMI-Anschluss. DisplayPort stellt in dieser Version eine ausreichende Bandbreite zur Verfügung, um 4K-HDR-Bilder mit 10 Bit, 60 Hz und voller YCrBr-4:4:4-Farbabtastung zu übertragen. Bei HDMI 2.0 ist dies nicht der Fall, zumindest nicht, ohne die Abtastung auf 4:2:2 oder 4:2:0 zu reduzieren. Beim Launch der Radeon RX 480 als erste Grafikkarte der Polaris-Generation sprach AMD noch von der vollen Unterstützung von 10 Bit HDR mit einer Abtastung von 4:4:4 und sogar von 12 Bit HDR ist hier die Rede. Allerdings wird auch einmal deutlich, von welchen weiteren Faktoren die Wiedergabe in HDR abhängig ist. Offen ist noch die Frage, ob die Farbtiefe von 8 Bit sich nur auf HDR-Spiele bezieht oder auch Filme in HDR.

[h2]Rechnen die anderen Hersteller auch anders?[/h2]

Nachdem das Verhalten bei den Karten von AMD nun bekannt ist, stellt sich die Frage, wie sich die Grafikkarten mit NVIDIA-GPU oder Konsolen verhalten. NVIDIA reagierte bisher nicht auf die Anfrage der c't. In einem optischen Test konnten die Redakteure allerdings keinerlei Unterschiede zwischen einer GeForce- und einer Radeon-RX-Grafikkarte feststellen. Allerdings soll die Leistung bei den NVIDIA-Grafikkarten beim Zuschalten der HDR-Darstellung etwas einbrechen, während die AMD-Grafikkarte stabil bleiben.

Die gleiche Frage stellt sich natürlich auch bei der PlayStation 4 Pro, denn auch hier kommt eine Polaris-GPU von AMD zum Einsatz. Derzeit kann davon ausgegangen werden, dass auch hier 8 anstatt 10 Bit verwendet werden. Eine Bestätigung dafür gibt es bisher aber nicht.