Werbung

Bereits vor einigen Monaten tauchten Gerüchte und konkrete Hinweise zu einer AMD Radeon R9 380X auf, welche auf dem voll ausgebauten Tonga-Chip mit der aktuellsten GCN-Architektur basieren sollte. Bisher kam der Chip lediglich in der beschnittenen Variante als AMD Radeon R9 285 bzw. AMD Radeon R9 380 sowie im Vollausbau beim Apple iMac mit 5K-Display sowie einigen Alienware-Notebooks als AMD Radeon R9 M295X bzw. AMD Radeon R9 M395X zum Einsatz.

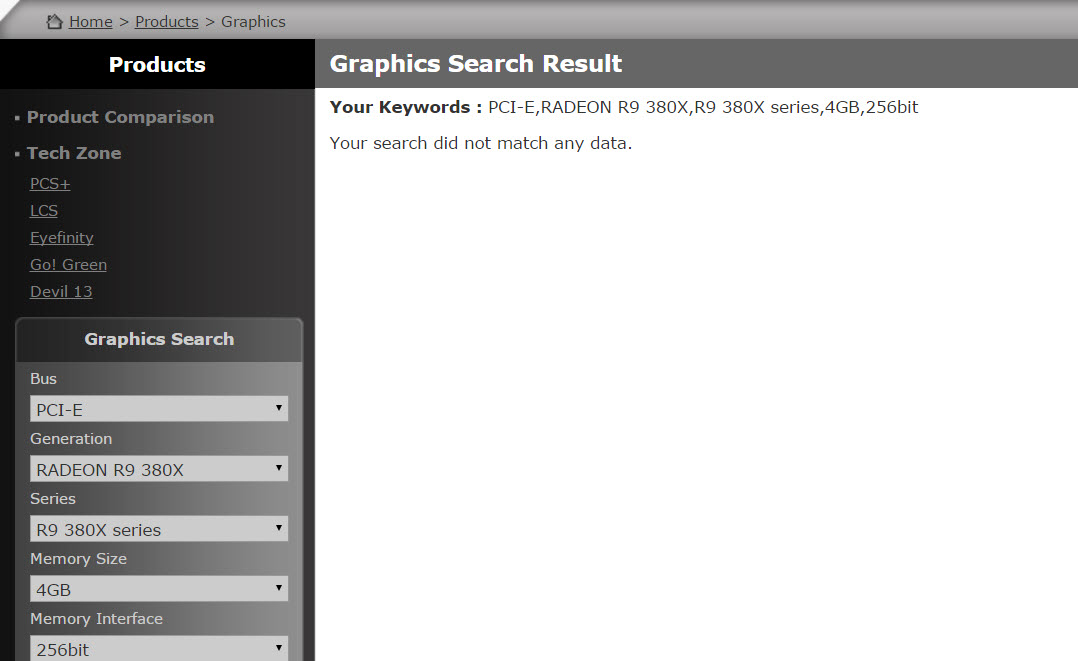

Nun hat PowerColor wohl eher unabsichtlich die groben Eckdaten zur Radeon R9 380X auf der eigenen Webseite preisgegeben. So wird die Grafikkarte auf dem Tonga-Chip basieren und 2.048 GCN-Recheneinheiten für sich verbuchen können. Auch ist damit das 256-Bit-GDDR5-Speicherinterface bestätigt, an welches 4 GB Grafikspeicher anbinden werden.

Zu den Taktraten ist bisher noch relativ wenig bekannt, allerdings geht die Webseite wccftec davon aus, dass ein Takt zwischen 1.000 und 1.100 MHz anliegen wird. Von der Leistung soll diese dann knapp auf die Radeon R9 290 aufschließen können.

An Features sind dank der aktuellsten GCN-Inkarnation natürlich FreeSync, VSR, die VCE in Version 3.0 und der UVD 6.0 für den Support von HEVC (h.265) und viele weitere mit an Bord. Der Chip wird in 28 nm beim taiwanischen Chipfertiger TSMC vom Band laufen.

Über einen etwaigen Preis liegen nach aktuellem Stand leider noch keine Informationen vor.