Werbung

Im kommenden Jahr werden sowohl AMD als auch NVIDIA bei der Fertigung ihrer GPUs auf das FinFET-Verfahren wechseln. Alle aktuellen Chips für die Grafikbeschleuniger werden noch in 28 nm gefertigt, so dass der Wechsel ein großer Sprung sein wird. Für die Hersteller bedeutet er sowohl eine Herausforderung als auch die Möglichkeit, hinsichtlich der Komplexität und Effizienz deutlich aufzustocken. TSMC und Samsung gelten als die einzigen beiden Auftragsfertiger, die in der Lage sind, solch komplexe Chips in einem neuen Verfahren fertigen zu können. Wie die Business Korea nun berichtet, scheint der südkoreanische Konzern-Gigant mit Halbleitersparte - Samsung - nun aber aus dem Rennen zu sein und das taiwanesische Unternehmen TSMC (Taiwan Semiconductor Manufacturing Company) bekommt zumindest den Auftrag, weiterhin für NVIDIA die GPUs zu fertigen. Auch für AMD ist dieser Schritt mehr als wahrscheinlich, die Meldung bezieht sich aber zunächst einmal auf NVIDIA.

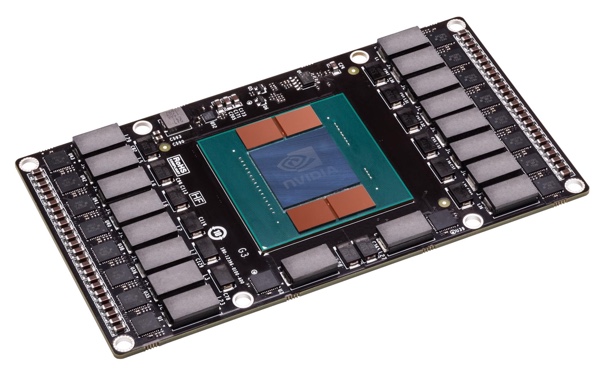

Am 15. September soll NVIDIA die endgültige Entscheidung für TSMC und gegen Samsung gefällt haben. Konkret geht es um die Fertigung der Pascal-GPU, die in der ersten Jahreshälfte 2016 erscheinen soll. Denkbar wäre auch ein Aufspalten der Aufträge gewesen, allerdings verwenden TSMC und Samsung unterschiedliche Iterationen des FinFET-Verfahrens. Die jahrelange Zusammenarbeit und das Vertrauen in TSMC sollen letztendlich dazu beigetragen haben, dass sich NVIDIA für TSMC entschieden hat.

Für Samsung ist der Verlust eines solchen Auftrages aber sicherlich verkraftbar. Die Halbleitersparte von Samsung ist aktuell der größte Wachstumsbereich des südkoreanischen Unternehmens. Neben den eigenen Exynos-SoCs fertigt man auch die A8- und A9-Prozessoren für Apples iPhones und iPads. Im Falle des A9 kommt auch hier schon das FinFET-Verfahren zum Einsatz. Eine gewisse Erfahrung lässt sich Samsung also in dieser Hinsicht nicht absprechen, allerdings besteht ein Unterschied zwischen der Fertigung eines SoCs und einer komplexen GPU mit fast zehn Milliarden Transistoren.

Während der Fertigung müssen Auftraggeber und Fertiger eng zusammenarbeiten, um eventuellen Problemen mit spezifischen Details der GPU oder Architektur zu begegnen. NVIDIA hat hier bereits schlechte Erfahrungen gemacht. Bei der Fermi-GPU verwendete NVIDIA wie in der aktuellen Architektur auch die sogenannten SMs (Streaming-Multiprozessoren), die über einen Interconnect untereinander und mit dem Speicher kommunizieren. Die Verbindungen zwischen den SMs und dem Speicher werden über ein "Fabric", ein Gewebe aus feinen Drähten (Wires), hergestellt. Da diese Verbindungen mit extrem hohen Taktraten arbeiten müssen, kommt es aufgrund der räumlichen Nähe der einzelnen Verbindungen zu elektromagnetischen Interferenzen. Diese Interferenzen sorgen für große Probleme bei der Fertigung der Fermi-GPU. Mit dem Vertrauensvorschuss zu TSMC möchte NVIDIA diesen sicherlich bei Pascal aus dem Wege gehen.