Werbung

Das NVIDIA mit "Kepler" bzw. der GK104-GPU bei der Effizienz einen Schritt in die richtige Richtung gemacht hat, zeigte bereits der erste Test der GeForce GTX 680. Da NVIDIA nicht einfach nur einen Shrink einer bestehenden Architektur auf eine kleinere Fertigung vollzogen hat, sind die Einsparungen und Optimierungen beim Stromverbrauch also nicht einfach nur auf die kleineren Transistoren zurückzuführen. Dennoch geht NVIDIA in einem Blogeintrag auf die Details genauer ein.

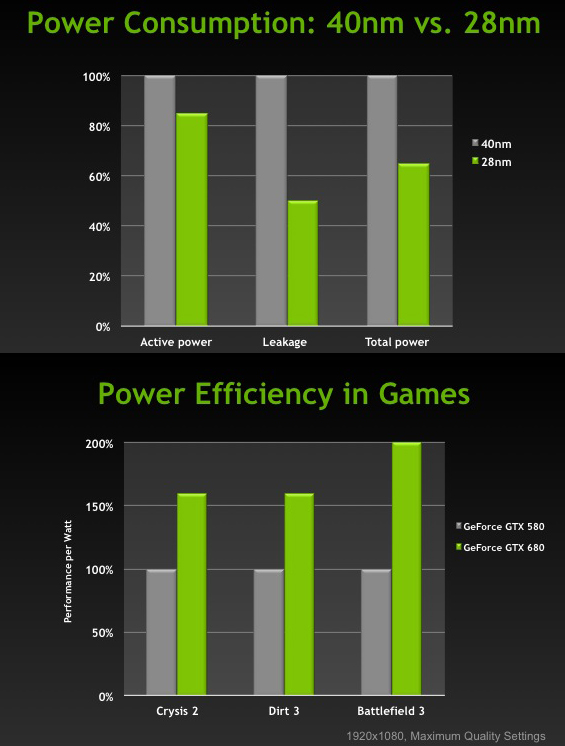

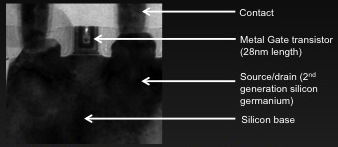

Eigenen Angaben zufolge hat NVIDIA über drei Jahre hinweg zusammen mit TSMC an der Fertigung von "Kepler" gearbeitet. Letztendlich dabei herausgekommen ist eine 28 nm High Performance (HP) Fertigung mit der 1. Generation der High-K Metal Gate (HKMG) Technologie zusammen mit der 2. Generation der SiGe (Silicon Germanium) Dotierung. Im Vergleich zu früheren SiON-Gates in den Transistoren verursacht das Dielektrikum beim HKMG-Verfahren weitaus geringere Leckströme. Durch die SiGe-Dotierung stehen mehr bewegliche Elektronen zur Verfügung, was die Leitfähigkeit weiter erhöht. Insgesamt konnte die benötigte Energie um 15 Prozent und die Leckströme um 50 Prozent im Vergleich zur 40-nm-Fertigung reduziert werden. Insgesamt spricht NVIDIA von einer Verbesserung der Effizient um 35 Prozent.

Über die dreijährige Zusammenarbeit zwischen NVIDIA und TSMC hinweg haben beide Unternehmen ein sogenanntes Production Qualification Vehicle (PQV) entwickelt, dass es beiden Unternehmen erlaubte das Design und die Fertigung über die verschiedenen Phasen des Prototyping hindurch zu optimieren - schon weit bevor der erste Tape-Out stattfand.

Laut eigenen Angaben hat NVIDIA vor kurzem das erste PQV für den 20-nm-Prozess erhalten und hofft somit die Ausbeute und Effizient kommender GPUs weiter verbessern zu können.