Werbung

Und wieder einmal mehr sind wenige Tage vor dem Start einer kommenden Grafikkarte alle Details ans Tageslicht gelangt. Neben den ersten Benchmarks zur heiß erwarteten NVIDIA GeForce GTX 680 sind auch die ersten Blockdiagramme der „Kepler“-GPU aufgetaucht. Demnach soll die kalifornische Grafikschmiede kleinere Änderungen gegenüber der „Fermi“-Architektur vorgenommen und weitere Feinheiten angepasst haben. Schon seit Längerem schreibt die Gerüchteküche dem kommenden Gegner der AMD Radeon HD 7970 drei Mal so viele Shadereinheiten vo wie bei einer NVIDIA GeForce GTX 580. Diese scheinen sich nun endgültig zu bestätigen und sollen sich in vier Graphics Processing Clustern (GPCs) organisieren. Jeder GPC soll dabei zwei Streaming-Multiprozessoren (SMs) oder – wie sie jetzt heißen – zwei SMX-Einheiten beherbergen. Diese sollen sich den Angaben zufolge einen L2-Cache teilen und eine Single Raster Engine bereithalten. In jeder SMX finden sich 192 CUDA-Cores, eine Polymorph-Engine der zweiten Generation, ein Instruction-Cache, ein 64 KB großer L1-Cache (shared) und vier Dispatch-Einheiten, die gewohnt die Auslastung der einzelnen ALUs erhöhen sollen.

Während die GF104-GPU noch zwei GPCs mit vier SMs besaß, stehen dem namentlichen Nachfolger vier GPCs zur Seite, die aber mit nur noch zwei SMs bzw. SMXs bestückt wurden. Dafür gibt es mehr Textureinheiten je Cluster. Waren es beim GF104 noch acht Texture Mapping Units je Streaming-Multiprozessor sind es jetzt pro SMX 16 TMUs. Bei Vollausbau soll der GK104-Chip acht XMS-Einheiten besitzen und es somit auf satte 128 Textureinheiten bringen.

{jphoto image=22278}

Beim Speicherinterface warten vier 64-Bit-Controller auf ihre Verwendung. Die NVIDIA GeForce GTX 680 wirft damit 256 Bit in die Waagschale und muss mit zwei Speichercontrollern weniger auskommen als eine GeForce GTX 580. Diese basaß ein 384 Bit breites Speicherinterface. An jeden Speichercontroller ist ein ROP-Cluster angeschlossen, der sich aus je acht Raster Operation Units zusammensetzt. In der Summe stehen somit 32 ROPs zur Verfügung. Die insgesamt 1536 skalaren Einheiten sollen auf einer Fläche von 294 mm² und in über 3,54 Milliarden Transistoren ihren Platz finden. Gefertigt wird die neu GPU wie AMDs Radeon HD 7970 im fortschrittlichen 28-nm-Prozess.

Bei den Taktraten geht man aktuelle von einem Grundtakt von 1006 MHz aus, der sich dank eines Turbos auf mindestens 1058 MHz automatisch heraufsetzen soll – je nach aktueller Leistungsaufnahme. Der 2048 MB große GDDR5-Videospeicher, was bei der oben beschriebenen Speicheranbindung technisch machbar wäre, sollen effektive 6000 MHz anliegen. Apropos Leistungsaufnahme: Hier gelten aktuell 195 Watt als bestätigt. Somit reichen der GeForce GTX 680 zwei 6-Pin-Anschlüsse. Zum Vergleich: Eine AMD Radeon HD 7970 dürstet nach einem 6- und einem zusätzlichen 8-Pin-Stecker.

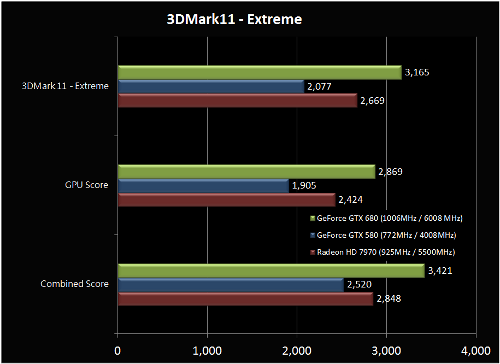

Soweit zur Theorie. Auch in der Praxis will man die neue GeForce GTX 680 schon ausgiebig getestet haben. Die Kollegen von HKEPC haben ihr Sample durch den Benchmarks-Parcours, bestehend aus 3DMark 11, Battlefield 3, Batman: Arkham City, Call of Duty: Modern Warfare 3, Lost Planet 2 und Unigine Heaven, geschickt. Alle Tests wurden in einer Auflösung von 1920 x 1080 und mit achtfachem MSAA erstellt. Als Testsystem dienten ein ASUS Rampage IV Extreme, ein Intel Core i7-3960X Extreme Edition, insgesamt 8 GB DDR3-Arbeitsspeicher und ein Corsair AX1200-Netzteil. Den Benchmarks zur Folge liegt die NVIDIA GeForce GTX 680 stets vor einer AMD Radeon HD 7970 – mal mehr, mal weniger. Während es bei Call of Duty mit 74 FPS keinerlei Unterschiede zwischen den beiden Konkurrenten gab, fiel der Abstand in Lost Planet 2 deutlicher aus. Hier stehen sich 73,4 und 58,5 FPS gegenüber. Im Extreme-Preset von 3DMark Vantage brachte es das „Tahiti“-Flaggschiff von AMD auf 2669 Punkte. Die NVIDIA-Karte lieferte mit 3165 Punkten abermals eine höhere Leistung und ist damit knapp 20 Prozent schneller. Im Performance-Preset liegt der Vorsprung sogar bei 50 Prozent. Im Tessellation-Test Unigine-Heaven liegt die GeForce GTX 680 mit zwölf Prozent Vorsprung in Führung.

Sollten diese Informationen zutreffen, so hätte AMD hart zu knappern, könnte dafür aber mit einer aggressiveren Preis-Strategie sehr gut gegenhalten. Bislang waren die Preise der Radeon-HD-7000-Familie allesamt nicht konkurrenzfähig und meist kräftig überteuert. Auch ein Preis für die GeForce GTX 680 geistert derzeit durchs Netz. In unserem Nachbarland ist eine ZOTAC GeForce GTX 680 gelistet und soll inklusive Steuern für 512,34 Euro ihren Besitzer wechseln. Ohne steuerliche Abgaben werden 431,38 Euro fällig. Lieferbar sein und auf die Reise geschickt werden, soll der 3D-Beschleuniger allerdings erst in zwei bis fünf Wochen. Als Startschuss gilt immer noch der 22. März.