Werbung

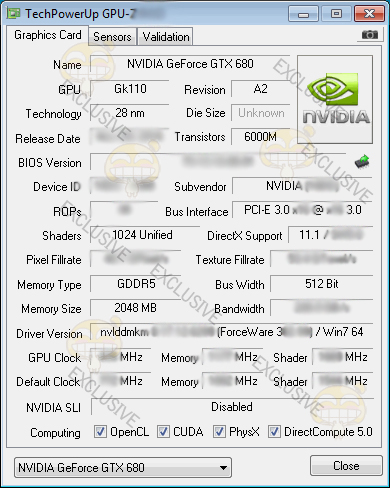

Noch hat das kalifornische Unternehmen NVIDIA für seine kommende Grafikkarten-Generation "Kepler" keinen Veröffentlichungstermin genannt, aber nun ist angeblich der erste GPU-Z-Screenshot von einer GTX 680 aufgenommen worden. Der Grafikprozessor wird bekanntlich erstmals in 28 Nanometern gefertigt und kann wohl auf 1024 CUDA-Cores zurückgreifen. Neben einer Verdoppelung der CUDA-Kerne gegenüber dem Vorgänger GTX 580, soll auch die Transistoren-Anzahl ordentlich gewachsen sein. An dieser Stelle verrät der Screenshot mit 6 Millionen Transistoren ebenfalls die doppelte Anzahl gegenüber dem kleineren Bruder. Zur weiteren Ausstattung zählen ein 512-Bit-Interface, um den verbauten 2,0 GB großen GDDR5-Speicher auch mit einer genügend hohen Geschwindigkeit ansprechen zu können. Zum Übertragen der Berechnungen wird ein PCI-Express-Interface in der Version 3.0 zum Einsatz kommen. Die Taktraten hingegen wurden leider unkenntlich gemacht.

Beim Blick auf die Revision des verwendeten Chips ist die Bezeichnung "A2" zu finden. Dies könnte auch die Erklärung für die Verschiebung von Kepler sein, denn laut älteren Gerüchten zufolge, hat die Revision "A1" noch Probleme bereitet und dadurch hat sich das Unternehmen zu einer Verschiebung entschieden. Trotz dieses Screenshots sollten aber auch diese Informationen mit ein wenig Vorsicht genossen werden, denn eigentlich kann GPU-Z den neuen Grafikprozessor GK110 noch nicht auslesen, sodass dieses Bild auch eine Fälschung sein könnte. Ob es sich um ein reales Bild handelt, wird sich wohl wirklich erst in den kommenden Wochen herausstellen, aber spätestens zu der offiziellen Vorstellung seitens NVIDIA.