Werbung

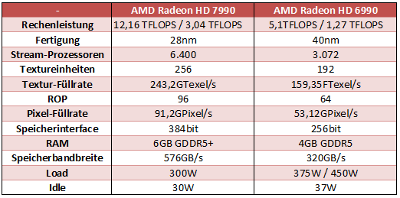

Kaum ist AMDs Radeon HD 6990 (Hardwareluxx-Test) auf dem Markt, keimen kurz vor dem Start der NVIDIA GeForce GTX 590 die ersten Gerüchte zum Nachfolger der zweifachen "CaymanXT"-Grafikkarte auf. Demnach soll die US-Amerikanische Grafikschmiede weiterhin an ihrem Namensschema festhalten und das kommende Flaggschiff im zweiten Quartal 2012 auf den Markt werfen. Wie üblich soll die Leistung der nächsten Generation noch höher ausfallen. Während "Antilles" aktuell bei doppelter Genauigkeit 1,27 TFLOPS erreicht, soll es die AMD Radeon HD 7990 schon auf 3,04 TFLOPs bringen – etwas mehr als das Doppelte. Hierfür sollen insgesamt 6.400 Streamprozessoren, 256 Textur-Mapping-Units und 96 ROPs zum Einsatz kommen. Auch bei der Speicheranbindung soll es eine Änderung geben. Während die GDDR5-Chips bislang über ein 256 Bit breites Speicherinterface angebunden waren, soll der Videospeicher der nächsten Generation hingegen über 384 Datenleitungen kommunizieren und mit 6 GB Speicher 50 Prozent mehr Kapazität bieten.

Trotz der gesteigerten Anzahl an Rechenwerken und des größeren Videospeichers soll AMD die Leistungsaufnahme weiter gesenkt haben. Den Angaben zufolge soll diese bei 30 Watt im Leerlauf und bei 300 Watt unter 3D-Last liegen, was hauptsächlich der fortschrittlicheren 28-nm-Fertigung zuzuschreiben wäre. Über die Taktraten hat man allerdings noch kein einziges Wort verloren. Bei einer Speicherbandbreite von 288 GB/Sek. würde sich allerdings ein Speichertakt von rund 1500 MHz ergeben – damit 250 MHz über dem jetzigen Modell. Auch auf PCI-Express 3.0 will man schon zurückgreifen.

Die hier genannten Angaben sind allerdings noch mit größter Vorsicht zu genießen. Es ist wenige Tage nach dem Start der AMD Radeon HD 6990 einfach noch zu früh für Spekulationen. Wir halten diese Angaben ehrlich gesagt für eine Ente bzw. Wunschdenken, wollen Ihnen diese Informationen aber dennoch nicht vorenthalten.

Weiterführende Links: