Werbung

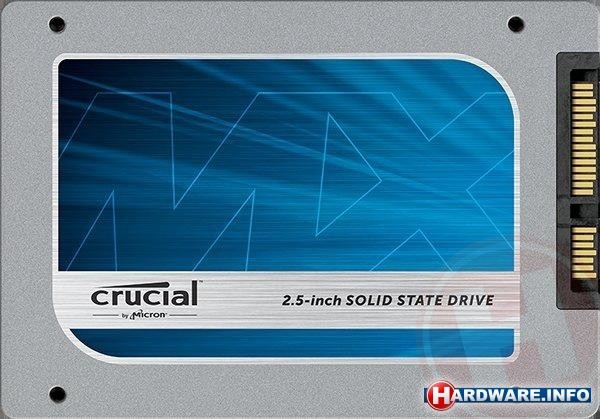

Der Chiphersteller Micron wird bald eine neue SSD-Baureihe in sein Portfolio aufnehmen. Die Laufwerke werden im Handel unter der Bezeichnung Crucial MX100 zu finden sein und sollen vor allem durch neue Flash-Speicher-Bausteine auffallen. Der Hersteller wird in dieser Baureihe erstmals auf Speicherchips mit 16-nm-Prozess setzen und damit nochmals eine deutlich kleinere Strukturbreite nutzen. Durch die kleinere Strukturbreite sollen die Preise der Chips nochmals etwas nach unten gehen, aber diese Entwicklung wird wahrscheinlich noch einige Wochen dauern.

Leider sind bisher noch keine weiteren Details zu der kommenden Baureihe bekannt. Es ist weder bekannt, welcher Controller bei der MX100-Serie zum Einsatz kommt und auch die genauen Leistungsdaten wurden noch nicht verraten. Da die SSDs aber bereits Anfang Juni auf der Computex 2014 offiziell vorgestellt werden sollen, werden diese Informationen wohl nicht mehr allzu lange auf sich warten lassen.