Werbung

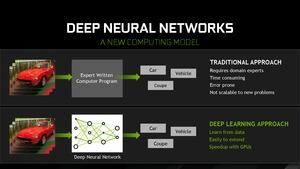

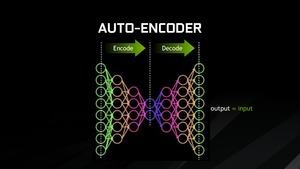

Machine Learning, AI, Deep Learning – diese Begriffe sind derzeit bei fast allen Herstellern und deren Präsentationen sehr beliebt. Oft wissen Nutzer gar nicht, dass sie bereits heute auf diese Techniken angewiesen sind. Digitale Assistenten, viele Cloud-Dienste und unzählige Anwendungen sind bereits heute auf solche Techniken angewiesen. NVIDIA arbeitet mit zahlreichen Entwicklern daran, dass solche Netzwerke künftig auch bei der Entwicklung von Spielen eine Rolle spielen.

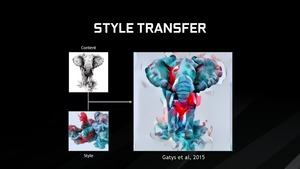

Doch bei der Entwicklung von Spielen sollen Deep-Learning-Netzwerke helfen, die Spiele noch realistischer und noch besser zu machen. Dies zielt vor allem auf die grafische Darstellung ab, denn hier haben sich in jüngster Vergangenheit Techniken entwickelt, die eine enorme Menge an Daten produzieren, die dann später verarbeitet werden müssen.

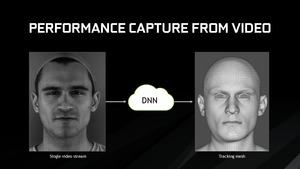

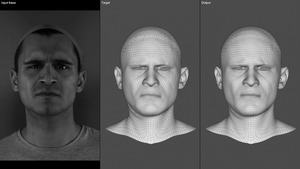

Ein Beispiel ist das Motion Capturing, bei dem komplette Charaktere oder aber nur deren Gesichter mit Hilfe einer 3D-Erkennung erfasst und abgetastet werden. Auch wenn es bereits viel Software gibt, welche die Entwickler dabei unterstützten, so ist dennoch häufig noch eine manuelle Bearbeitung der Daten notwendig, da die Software Daten zwar zuweisen, im Fall der Fälle aber nicht bewerten kann, ob diese so auch stimmen können oder nicht. Deep-Learning-Netzwerke können aber derart trainiert werden, dass sie aus ihren Fehlern lernen und die Erkennung damit sukzessive verbessern.

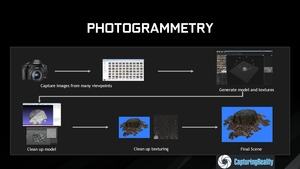

Eine weitere Anwendung ist die Photogrammetrie. Dabei werden Texturen und 3D-Objekte mit Hilfe von Kameras abfotografiert und daraus eben eine digitale Textur oder ein 3D-Objekt erstellt. Auch hier helfen solche Netzwerke dabei, die Erfassung der Daten zu verbessern. Es ist aber auch möglich, die erfassten Daten in der Form weiter zu verarbeiten, dass zusätzliche Inhalte entstehen. So kann die Aufnahme eines Steinbodens derart verändert werden, dass die dazugehörige Textur und das 3D-Modell immer wieder zufällig angepasst wird, so dass keine Wiederholungen entstehen. Dies hilft dabei, eine virtuelle Welt natürlicher und realistischer zu gestalten.

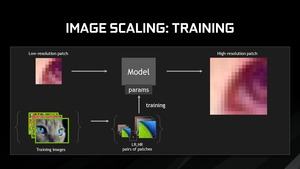

Liegen keine hochauflösenden Daten vor, können solche Algorithmen dafür sorgen, dass ein Upscaling besser funktioniert als dies klassisch der Fall ist. NVIDIA bietet zu allen erwähnten Techniken eine entsprechende Plattform an, auf der sich Entwickler anmelden und dies ausprobieren können. Techniken wie die Photogrammetrie kommen bereits heute in Spielen zum Einsatz – allerdings ohne die Unterstützung von AI.