Spieluhr

Banned

- Mitglied seit

- 17.03.2006

- Beiträge

- 11.890

- Ort

- Dortmund

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-13600KF (5,8/5,5)

- Mainboard

- MSI MEG Z690 ACE

- Kühler

- DeepCool Gammaxx L360 RGB V2 (alte Rev.) @ Push'n'Pull 6x AC P12PWM (Rev.4)

- Speicher

- 32GB Corsair Vengeance @ 6667MHz | DDR5

- Grafikprozessor

- AMD RX6500XT *Ersatz wegen defekt*

- Display

- Acer KG 272 UP (WQHD/165Hz)

- SSD

- WD SN850X (2TB) | 2x SK Hynix Platinum P41 (2TB) | Fanxiang S880 (4TB) | Fikwot FN955 (4TB)

- Gehäuse

- Corsair 5000D Airflow White @ 4x AC P12PWM (Rev.4) | 3x DeepCool RF120 RGB (alte Rev.)

- Netzteil

- Corsair RM850x (Serie 2022) 850W.

- Keyboard

- Cherry Stream V2 RGB

- Mouse

- Tecknet GM299 RGB

- Betriebssystem

- W11 Prof. Retail Version

- Webbrowser

- der beknackte Fuchs

- Sonstiges

- Satelliten: PreSonus Eris E4.5BT Studio Kevlar Subwoofer: PreSonus Eris Sub8 Studio (aktiv) Kabels: AdamHall 5Star (IRP) TS/TRS 6,5/3,5 Klinke Absorber: AdamHall Gravity IF01 / PAD ECO2

- Internet

- ▼1000 MBit ▲50 MBit

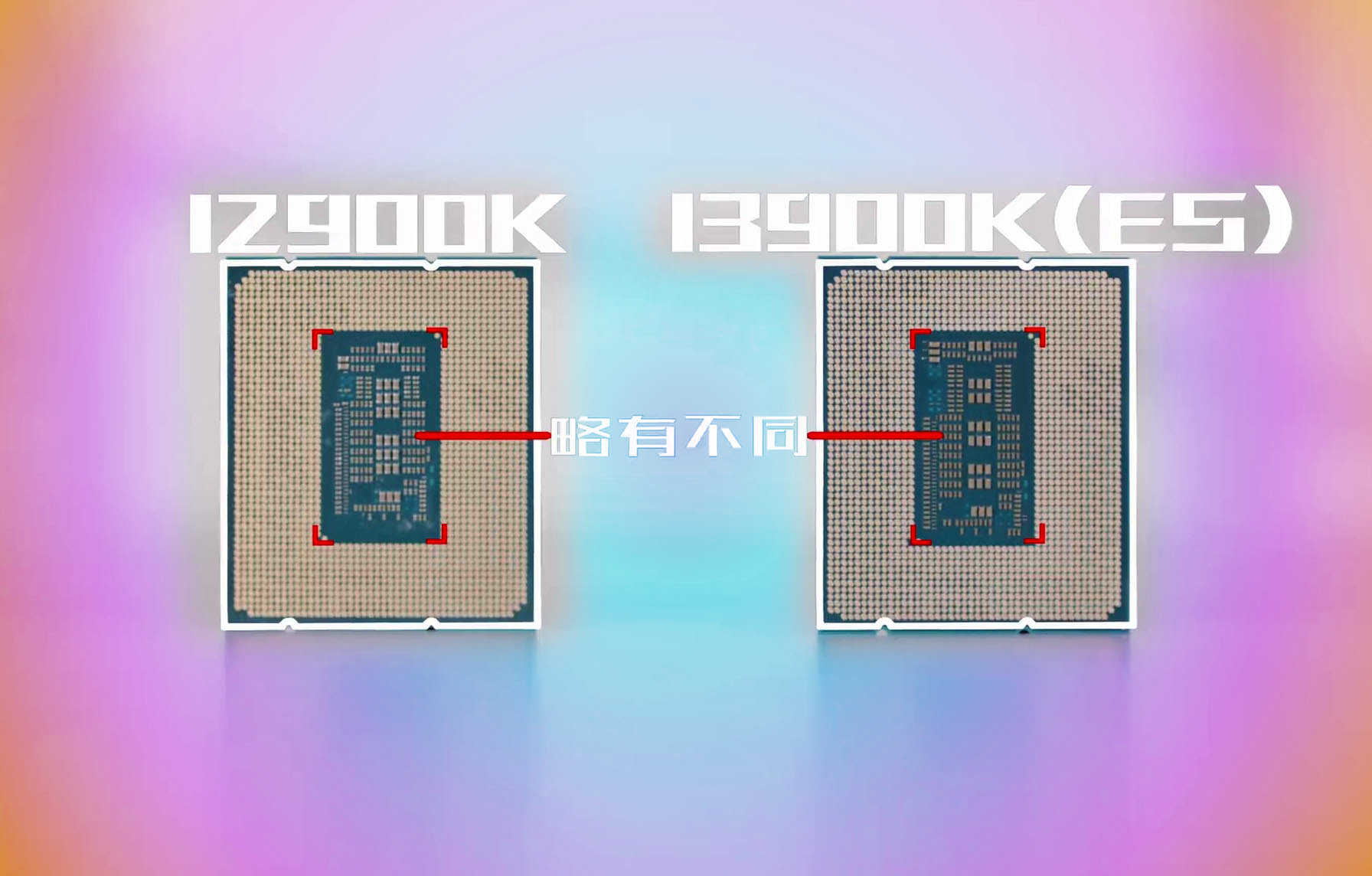

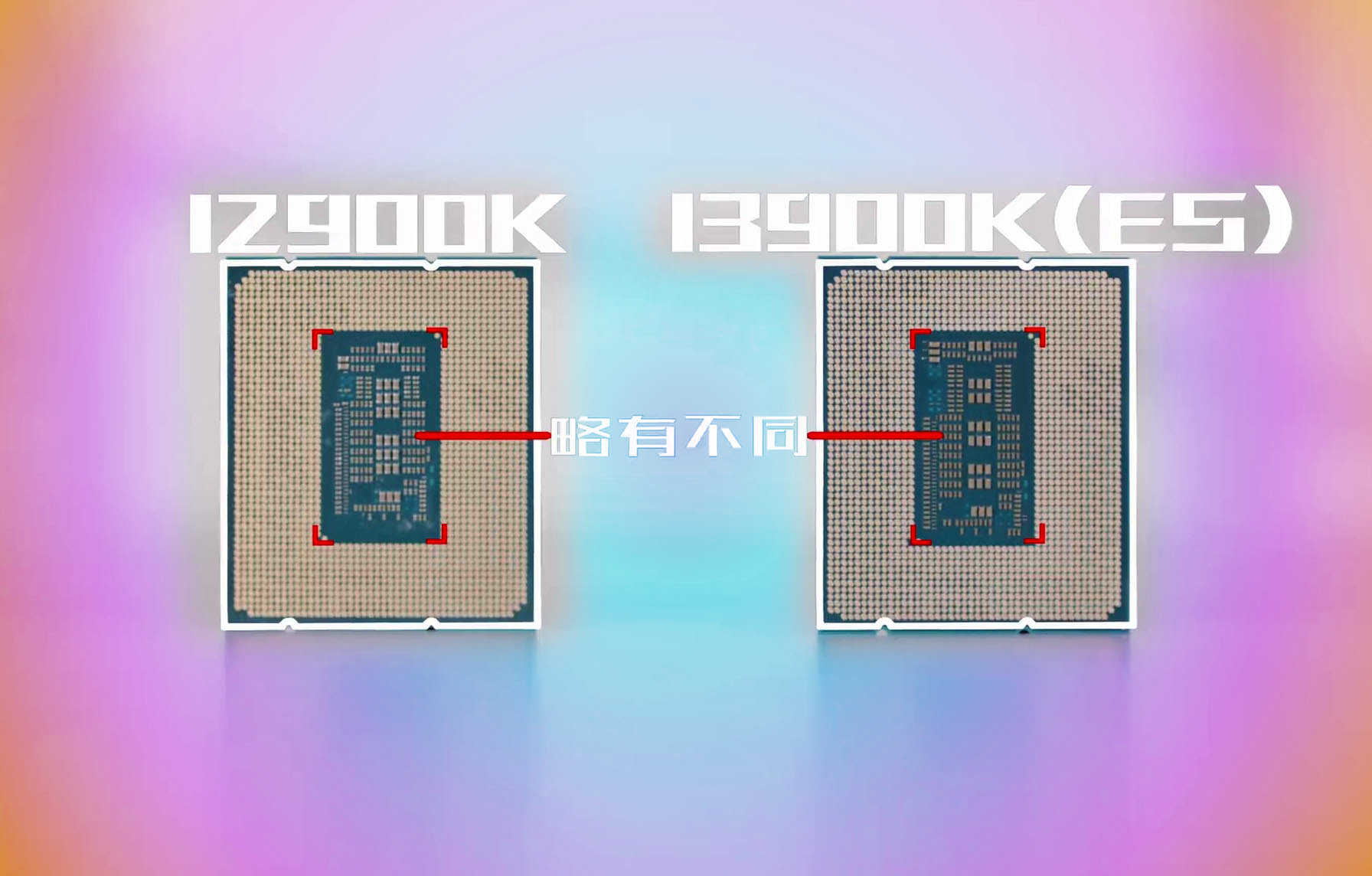

Weiterer Leak der 13900K vs. 12900K mit Video:

videocardz.com

videocardz.com

i9 12900K @ 4,9GHz: 279,9W. / 86°C

i9 13900K @ 4,9GHz: 177,3W. / 61°C

..wenn das so stimmt wäre das schon krass.

Another Intel Core i9-13900K "Raptor Lake" CPU gets tested ahead of October launch - VideoCardz.com

Intel Core i9-13900K ES tested Luckily for us, Intel has a problem with early reviews of their engineering samples. We have already seen very comprehensive tests from other Chinese sources, but some were already removed on Intel request. Hopefully, the same fate will not meet the latest videos...

Im AIDA64-Test bei gesperrter 4,9-GHz-Frequenz für die Performance-Kerne ist der i9-13900K viel kühler als der i9-12900K.

Mit einer TDP von 280 W und einer Temperatur von durchschnittlich 86 °C benötigt Alder Lake 100 W mehr Leistung und läuft bei einer viel höheren Temperatur als Raptor Lake mit 61 °C.

i9 12900K @ 4,9GHz: 279,9W. / 86°C

i9 13900K @ 4,9GHz: 177,3W. / 61°C

..wenn das so stimmt wäre das schon krass.

Zuletzt bearbeitet: