In einem älteren Thread wurden mal Bedenken geäussert, dass die Areca (SAS) Controller gerade bei I/O ziemlich schlecht im Vergleich zum Rest der Welt abschneiden - vor allem basierend auf dem Testbericht von www.tomshardware.com

Ich habe nun selber 2 von den ARC-1680i SAS Controller zur Hand, in jeweils 2 baugleichen Systemen (Supermicro 5025M) mit Core2Quad CPU und 4GB Ram.

Dazu stecken in einem System 8x die 1TB, 7200rpm SATA Disk von Western Digital und im andern System 4x eine 300GB SAS, 15k rpm Disk von Seagate drin.

Zur WD gibts noch zu sagen, dass dies eine "Greenpower" Version ist und Gerüchten zufolgen mitunter auch nur mit 5400rpm läuft. (evtl. dynamisch gesteuert?)

Anyway, ich habe beide Rigs mal durch den IOMeter gejagt, mit den identischen Benchmarkpattern wie bei Tomshardware.

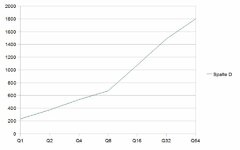

Zur Erinnerung, bei Tomshardware kam folgendes raus: (da waren acht 10k SAS Disks im Einsatz)

und

Bei meinem Test mit folgenden Settings

Auch wenn die Resultate generell langsamer sind als dieder andern Controller von Tomshardware, sieht man dass es trotzdem deutlich besser ist als was Onkel Tom da beim Areca gemessen hat....und nicht vergessen, das waren hier nur langsame 1TB SATA Disks.

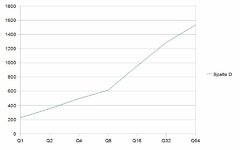

Kommen wir nun zu den SAS Disks:

Bis zu einer Queue Tiefe von 16 zieht der Areca hier alles ab was bei www.tomshardware.com getestet wurde, danach bricht er aber ein und bringt kaum mehr eine Steigerung. Ob dies nun daran liegt dass ich nur 4 Disks hatte und damit bereits bei einer Queue von 16 am Limit war kann ich leider nicht sagen, dazu müsste ich mal eine weitere Disk kaufen

Aber man erkennt deutlich, dass die Performance um Welten besser ist als was beim Tom gebencht wurde - und das wie gesagt, bei nur 4 Disks.

Ich habe nun selber 2 von den ARC-1680i SAS Controller zur Hand, in jeweils 2 baugleichen Systemen (Supermicro 5025M) mit Core2Quad CPU und 4GB Ram.

Dazu stecken in einem System 8x die 1TB, 7200rpm SATA Disk von Western Digital und im andern System 4x eine 300GB SAS, 15k rpm Disk von Seagate drin.

Zur WD gibts noch zu sagen, dass dies eine "Greenpower" Version ist und Gerüchten zufolgen mitunter auch nur mit 5400rpm läuft. (evtl. dynamisch gesteuert?)

Anyway, ich habe beide Rigs mal durch den IOMeter gejagt, mit den identischen Benchmarkpattern wie bei Tomshardware.

Zur Erinnerung, bei Tomshardware kam folgendes raus: (da waren acht 10k SAS Disks im Einsatz)

und

Bei meinem Test mit folgenden Settings

kam bei den selben Tests folgendes raus:- Raid5

- Stripesize: 64kB

- Write Back Cache

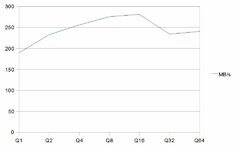

FileServer Testpattern auf 8x WD 1TB SATA:

Q1: 128

Q2: 208

Q4: 298

Q8: 389

Q16: 522

Q32: 616

Q64: 634

Workstation Testpattern auf 8x WD 1TB SATA:

Q1: 146

Q2: 232

Q4: 327

Q8: 443

Q16: 672

Q32: 656

Q64: 659

Auch wenn die Resultate generell langsamer sind als dieder andern Controller von Tomshardware, sieht man dass es trotzdem deutlich besser ist als was Onkel Tom da beim Areca gemessen hat....und nicht vergessen, das waren hier nur langsame 1TB SATA Disks.

Kommen wir nun zu den SAS Disks:

Fileserver Testpattern auf 4x Seagate 300GB SAS:

Q1: 267

Q2: 217

Q4: 588

Q8: 808

Q16: 1027

Q32: 1062

Q64: 1071

Workstation Testpattern auf 4x Seagate 300GB SAS:

Q1: 279

Q2: 427

Q4: 628

Q8: 851

Q16: 1070

Q32: 1123

Q64: 1142

Bis zu einer Queue Tiefe von 16 zieht der Areca hier alles ab was bei www.tomshardware.com getestet wurde, danach bricht er aber ein und bringt kaum mehr eine Steigerung. Ob dies nun daran liegt dass ich nur 4 Disks hatte und damit bereits bei einer Queue von 16 am Limit war kann ich leider nicht sagen, dazu müsste ich mal eine weitere Disk kaufen

Aber man erkennt deutlich, dass die Performance um Welten besser ist als was beim Tom gebencht wurde - und das wie gesagt, bei nur 4 Disks.