Selbst mit passender Hardware ist es kein Garant das es von der Consumer Softwareseite läuft.

Also ich wüsste nicht, was da nicht laufen sollen, aber ich vermute du meinst, dass die Software die Vorteile kaum bis gar nicht nutzt.

Die Nachfrage sinkt nach einer weile, wenn es kein Angebot gibt.

Das sehe ich so nicht und wo gibt es kein Angebot? Phison hat bei den Consumer SSDs jeweils bei PCIe 4.0 und PCIe 5.0 mit dem E16 bzw. E26 vorgelegt, wenn auch leider nur mit aufgebohrten Vorgängerdesigns die wegen ihrer zu altmodischen Fertigung zu ineffizient waren und daher zu heiß wurden. Bei den Grakas hat es länger gedauert, aber deswegen haben die Leute sich trotzdem schon mal Boards mit PCIe 5.0 gekauft, um eben für das nächste Upgrade der Graka gerüstet zu sein.

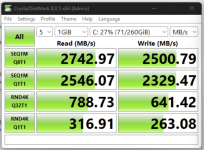

im bereich ssds hat der heimanwender auch kaum einen nutzen der immer schneller werdenden sequentiellen leistungen.

Weil die eben auch noch mehr parallele und lange Zugriffe erfordert um sie überhaupt aus der SSD zu kitzeln, vor allem Lesend. Solche Zugriffe kommen aber eben in der Praxis bei Heimanwendern kaum bis nie vor.

die Software zieht da nicht mit oder nur sehr langsam. Da man immer schaut möglichst abwärtskompatibel zu sein gibt es wenig motivation bei der Softwareentwicklung neueste Hardware zu priorisieren.

Der Punkt ist, dass man bei realer Software, anders als bei Benchmarks, die gelesenen Daten verarbeiten bzw. gelesenen Programmcode auch abarbeiten muss und dies dauert eben seine Zeit. Da läuft auch nicht so viel parallel und es lässt sich auch nicht alles parallelisieren. Dies ist bei Servern meisten anders und sei es nur, weil da viele Instanzen (z.B. VMs) parallel laufen, aber wer spielt schon mehrere Spielen oder startet Dutzende Programme parallel?

Das Interesse im Heimbereich wäre da, wenn man auf x1 SSDs gehen würde. Da kann man sich die Verschwendung von PCIe lanes sparen.

Dabei gewinnt man massiv lanes und schon kann man MBs wieder normal ausstatten.

Nein, denn keiner würde das Geld für eine PCIe 6.0 Plattform ausgeben um dann nur M.2 Slots mit einer Lane oder zwei Lanes zu haben in denen seine bisherigen PCIe x4 SSDs langsamer als bisher laufen, weil es ja nur eine Lane oder zwei Lanes gibt und kein SSD (Controller) Hersteller würde Geld ausgeben um eine PCIe 6.0 x2 SSD zu entwickeln, die dann nicht schneller als eine PCIe 5.0 x4 SSD ist, aber nur von den wenigen Käufern von Board mit M.2 PCIe 6.0 x2 Slots sinnvoll genutzt werden kann, die aber dann nicht schneller als ihr PCIe 5.0 x4 Vorgänger ist. Die ersten PCIe 6.0 SSDs werden viel teurer als ihre Vorgänger werden und sich nur deshalb verkaufen, weil dann auf dem Papier wieder höhere Lese- und Schreibraten stehen, egal wie viel davon im Alltag ankommt.

Und was soll ein normal ausgestattetes Mainboard sein? Den meisten reichen die 2 bis maximal so 5 M.2 Slots die man auf den aktuellen Boards bekommt und auch wenn man dann ein Board mit 10 statt 5 M.2 Slots mit PCIe Lanes versorgen kann, wenn man jedem nur zwei Lanes gönnt, wo sollen man sie dann unterbringen? Dafür gibt es doch gar keinen Platz auf den Mainboards.

warum sind die Nvidia Karten wohl besonders RAM kastriert?

Obwohl die 4090/5090 locker mit x8 auskommen könnten, werden die mit x16 geliefert. So Bald man die auf x8 reduziert verlieren die halt Performance.

Erst beschwerst Du Dich selbst, dann die Karten zu wenig RAM haben, dann widersprichst Du Dir gleich darauf, indem Du meinst sie würden auch mit 8 Lanes auskommen. Gerade wenn die Karten zu wenig RAM haben, wird die Bandbreite der Anbindung aber umso wichtiger, da dann ständig Daten geschaufelt werden müssen. Die Top GPUs haben 16 Lanes, damit sie auch von Leuten gekauft werden, deren Plattform älter ist und eben vielleicht nur PCIe 3.0 hat, die sollen ihr Geld ja lieber für die Top GPU ausgeben, also für ein Systemupgrade und dann reicht es nur für eine kleinere GPU. Schau Dir außerdem mal an, wie viele Leute hier reagieren, wenn man ihnen etwas vorschlägt (z.B. einen bestimmten M.2 Slot zu nehmen) was dazu führt das ihre Graka nur noch mit 8 statt 16 Lanes laufen würde. Selbst wenn sie dabei in Games vielleicht nur 1 oder 2% der fps verlieren, wollen sie davon nichts wissen.

Ich habe nicht gesagt, dass man die gesparten Lanes in weitere SSD Slots investiert.

Ansonsten kann man in PCIe Slots auch was anderes als GPU stecken, also habe ich mal gehört.

Also "habe ich mal gehört", dürfte für 99% der Nutzer zutreffen, wobei die meisten des einem Prozent dann an ihre Soundkarte denken. Also was soll dies andere sein? Die paar wenigen Heimanwender die in Consumer Mainboard einen 10GbE NIC oder einen alten SAS HBA/RAID Controller stecken, sind doch wirklich komplett Nische.

Es hat aber auch Vorteile auf x1 zu gehen, da man beim routing es dann einfacher hat, was die Längenkompensation angeht. Da wird mit den höheren Datenraten zunehmen ein immer größeres Problem.

Leider kennst du dich echt nicht mit Elektronik aus! Denn das ist bei PCIe kein Problem, sonst könnte man nicht einfach mal von den 16 PCIe Lanes für die Graka 8 über einen Muxer/Demuxer schicken um sie bei Bedarf auf einen zweiten Slot schicken zu können, was die Signallaufzeiten für die Lanes auch unterschiedlich sein lässt.

Das war auch ein Grund, warum man vor vielen Jahren die Entwicklung von Ultra-640 SCSI Geräten gar nicht erst angefangen hat und auf SAS umgeschwenkt ist.

SCSI war parallel und dabei müssen die Laufzeiten der Signale für die einzelnen Bits eines Bytes identisch sein, damit man die Bits dann auch dem richtigem Byte zuordnen kann, was sie maximal mögliche Datentransferraten sehr limitiert. SAS ist seriell und ebenso ist PCIe eine serielle Verbindung, man kann aber eben mehrere serielle Verbindungen im Controller wieder kombinieren, dies nennt sich bandwidth aggregation.

Das macht daraus aber keine parallele Verbindung, denn die Definition er parallelen Verbindung ist halt, dass dort die Bits eines (oder mehrerer) Bytes über jeweils eine eigene Leitung übertragen werden, während bei einer seriellen Verbindung die Bits eines Bytes nacheinander über die gleiche Leitung übertragen werden und genau dies ist bei PCIe immer der Fall, egal wie viele Lanes man bündelt. Dann hat man zwar auch eine gewisse Parallelität, aber eben nicht auf Bitebene, sondern auf einer höheren Ebene des Protokolls, wo der Controller entscheidet über welche der Lanes er ein Paket schickt. Die Pakete enthalten ja eben verschiedene Informationen im Header, der dann eben für den Overhead sorgt der den Unterschied aus den theoretisch und praktisch möglichen Transferraten ausmacht. So steht im Header neben Adressen von Sender und Empfänger, Länge, Prüfsumme und den eigentlichen Daten, auch eine fortlaufende Nummer die die Sequenz der Pakete angibt, die es dem Empfänger dann eben erlaubt die Pakete die über die verschiedenen sequentiellen Leitungen kommen, dann wieder in die richtige Reihenfolge zu bringen, auch wenn sie wegen leicht unterschiedlicher Laufzeiten eben nicht in dieser Reihenfolge angekommen sind.

Das geht halt bei parallelen Verbindungen nicht, da wird ja auf jeder Leitung immer nur ein Bit ohne zusätzlicher Daten übertragen und der Takt bestimmt dann, zu welchem Bytes diese Bits zugeordnet werden, weshalb die Laufzeit für alle Bit identisch sein muss. Dies ist auch der Grund warum schnellere serielle als parallele Übertragungen möglich sind und erst recht, wenn man eben mehrere Lanes und bandwidth aggregation verwendet und warum dann daraus trotzdem keine parallelen Verbindungen werden, auch wenn es eine Parallelität gibt.

Ich wüsste ehrlich gesagt nicht mal was ich damit mach. Ich krieg die 4TB nicht annähernd halb voll XD

Jeder macht eben andere Sachen, nicht jeder nutzen den PC nur zum Spielen. Bei mir sind die 4TB und die 8TB auch schon wieder viel zu voll, von den kleineren ganz zu schweigen.

aber bei den Prosumer Boards fände ich mehr M.2 Slots mit CPU Lanes doch wünschenswert.

Wieso müssen die unbedingt an den PCIe Lanes von der CPU hängen?

Ich hätte nichts gegen M.2 Slots mit zwei PCIe6 Lanes als Standard für die nächsten Jahre, wenn satt der Bandbreite die Latenz merklich besser werden würde.

Das Problem ist aber nicht die Verbindung, die macht sehr wenig aus, sondern die Latenz des NANDs. Das 3D-XPoint der Optane hat eine viel geringere Latenz und dies macht die Optane bei vielen Anwendungen auch heute noch unschlagbar, selbst die alten 900P die nur so 2,6GB/s lesen können und selbst im Vergleich zu den schnellsten PCIe 4.0 SSDs, einen Vergleich zu PCIe 5.0 SSDs habe ich noch nicht gefunden. Die Optane haben sie aber nicht durchgesetzt, da sie viel zu teuer waren und dies, obwohl Micron und Intel mit 3D-XPoint nur Verluste eingefahren und es deswegen dann auch eingestellt haben. NAND hat halt den Vorteil einen extrem einfachen Aufbau zu haben und damit unschlagbar billig herzustellen zu sein, so wie DRAM eben auch so viel einfacher ausgebaut ist als SRAM und daher auch viel billiger ist, was aber auch hier mit einer schlechteren Latenz erkauft werden muss.