Meldet sich Crucial wirklich zurück oder nicht doch eher ab,

nachdem nun Highend PCIe SSDs unter dem Markennamen "Ballistix by Micron" statt wie bisher unter dem Label Crucial laufen sollen und Ballistix zu einer eigenständigen Gaming-Marke promiviert hat?

Mit einem SLC-Cache, von Crucial Dynamic Write Acceleration genannt, werden zur kurzzeitigen Performancesteigerung Schreibzugriffe abgefangen und erst zu einem späteren Zeitpunkt in den TLC-Speicher geschrieben.

Da es wie bisher nur bei MLC SSDs üblich ein Pseudo-SLC Schreibmodus ist der auf allen Zellen angewendet werden kann und kein fester Cachebereich mit Zelle die nur im SLC Modus arbeiten wie es sonst bei allen SSDs TLC und Pseudo-SLC Cache implementiert ist, würde ich es auch nicht als SLC-Cache sondern als Pseudo-SLC Schreibmodus bezeichnen. Der Unterschied ist eben, dass der größer ausfallen kann, aber die Write Amplification dadurch beim Umkopieren steigt, während man den festen Pseudo-SLC Cachebereichen die P/E Zyklen in diesen nur als SLC genutzten Zellen gar nicht mitzählt, die vertragen im Pseudo-SLC Modus ja auch deutlich mehr P/E Zyklen. Da man dann auch Daten die schon ungültig geworden sind weil überschrieben oder getrimmt wurden nicht in die normalen NAND Bereiche kopieren musst, erreicht man bestenfalls sogar eine Write Amplification von unter 1.

Damit ist auch der Teil "erst zu einem späteren Zeitpunkt in den TLC-Speicher geschrieben" falsch, denn alle Daten werden bei der MX300 immer in den TLC Speicher geschrieben, der Cache ist eben nicht in einem besonderen Bereich fest angelegt, sondern je Zelle kann auch als Pseudo-TLC Schreibcache dienen. Die Werte später nur umkopiert um dann statt einem Bit wieder 3 Bits in jeder Zelle gespeichert zu haben, sonst wäre die Kapazität ja nur noch 250GB.

Die von Intel und Micron verwendete Technologie führt zu einer Kapazität von 384 Gbit pro Die, wobei auf der Crucial MX300 750 GB insgesamt 16 Dice zum Einsatz kommen, was eine Bruttokapazität von 768 GByte ergibt.

Es sind 768GiB (Gibiybte) (bzw. 824GB) denn die NANDs haben ja auch nicht wirklich 768GBit sondern Gibibit. Das sieht man hier am Beispiel dieser alten Micron NANDs gut:

Jede Page hat 8192 Byte (+448 für Extradaten wie die ECC), also 8192*8 Bits, ein Block enthält 256 Pages und als 64Gb Die hat es 4096 Blöcke. Macht also 8192*8*256*4096 = 68719476736Bit. 68719476736/1024^3 sind dann genau 64

Gibibit und nicht 64 Gigabit, dafür hätte man durch 1000^3 teilen müssen.

Ein Feature, das man sonst praktisch nur bei wesentlich teureren Enterprise-Laufwerken findet, ist eine Power-Loss-Protection.

Wobei man aber zwischen den Lösungen bei Enterprise und Client Laufwerken unterscheiden muss. Die Enterprise SSDs haben dann i.d.R. eine Full-Power-Loss Protection die auch die Userdaten im Schreibcache absichert, während Client SSD wie die Crucial m500, m550, MX100, MX200 und nun die MX300 oder auch die OCZ Vector 180 nur eine Lösung zu Absicherung der Data-at-Rest haben, also der Mappingtabelle und Low-Pages. OCZ sagt das auch offen und es war in allen Reviews zu lesen, auch bei euch:

Bzgl. der Crucial SSDs hat

Anandtech es im Review der Micron 500DC klargestellt:

Die MX300 ist damit für den Enterpriseeinsatz also nicht gleichwerte geeignet wie eine echte Enterprise SSD, dafür ist das Feature nicht gedacht und die Kondensatoren sind zu knapp dimensioniert,

die auf der M500DC sind deutlich größer und dabei hat die MLC NANDs in die man im Zweifel die Daten deutlich schneller schreiben kann als in TLC und auf den Pseudo-SLC Schreibmodus kann man sich auch nicht immer verlassen, der könnte schon voll sein und damit nicht zur Verfügung stehen wenn gerade plötzlich die Spannungsversorgung unterbrochen wird.

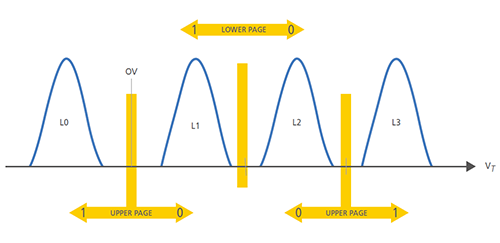

Die Daten, die eigentlich in die Upper Page hätten geschrieben werden sollen, gehen dabei allerdings verloren. Daher handelt es sich nur um eine teilweise und nicht um eine vollständige Power-Loss-Protection.

Das stimmt so auch nicht, die Upper Page muss vollständig geschrieben werden, sonst kann man die Lower Page nicht schützen aber es wird dann eben nur noch die eine Upper Page vollständig mit Nutzerdaten beschrieben bei der diese Vorgang schon in Gang war und die anderen Userdaten aus dem Schreibcache gehen verloren, da die Kapazität der Stützkondensatoren eben nicht für alles reicht und die Verwaltungsdaten, also vor allem die Mappingtabelle (bei Micron L2P table - logical to physical - genannt) eben auch noch gesichert werden müssen.

es wurden bis dahin also ca. 50 GB mit voller Geschwindigkeit geschrieben.

50GB? komisch, bei

Computerbase waren es nur 30GB mit der Firmware-Version nun M0CR011, mit der vorherigen M0CR010 deutlich mehr. Habt ihr das gemessen oder einfach nur aus der Geschwindigkeit in den 5s und der Zeit hochgerechnet? Die Leistungsbeständigkeit ist ja sowieso ein großes Problem der MX300, was die Unterschiede erklären könnte.

Bzgl. der Frage wie viel man davon im Alltag merkt, sollte man auch eine Messung mit einer fast vollen SSD, z.B. zu 80% gefüllt, ausführen, denn wie die Besitzer einer Toshiba SSDs mit so einem Pseudo-SLC Schreibmodus wissen, kann es dann bzgl. der Cachenutzung und damit bei der Schreibperformance schon deutlich anderes aussehen und bei den meisten anderen Reviews viel die Performance der MX300 deutlich, wenn diese nicht mehr leer war und zwar schon bei nur 50% Befüllung und Alltag dürfte kaum jemand auf seiner SSD dauernd die Hälfte unbenutzt lassen.

Unter Last ist der Stromverbrauch ziemlich niedrig

Ist auch so nur möglich, weil die eben einen großen Bereich als Pseudo-SLC Schreibcache nutzt und das schreiben nur eines Bits geht nicht nur schnell, es verbraucht auch sehr wenig Energie und wenn nur dann die Leistungsaufnahme ermittelt wird, entsteht halt ein falscher Eindruck. Der Controller muss die Daten hinterher ja noch umkopieren, kehrt also nicht so bald zuur gering Idle Leistungsaufnahme zurück, Akkulaufzeit würden also nicht so lang sein wie die Werte es vermuten lassen und sollte daher wirklich mit einem Notebook ermittelt werden. Diese normalen Messungen der Leistungsaufnahme sind auch wegen solche Pseudo-SLC Caches und der damit verbundenen Aktivitäten im Idle einfach nicht mehr geeignet darüber eine Aussage zu treffen wie lange ein Notebook auf dem Akku mit dieser oder jener SSD laufen wird. Rückschlüsse auf die Energieeffizienz aufgrund solche Momentaufnahmen verbieten sie damit ebenfalls.

Leider habt ihr die MX300 auch nur im Neuzustand gebencht, also leer und daher nicht die bei dieser SSDs besonders ausgeprägten Leistungsabfälle bei zunehmender Befüllung erkannt, obwohl andere Reviews die früher erschienen sind wie der von Computerbase auf diese Problem schon aufmerksam gemacht haben. Dieser Review ist daher leider als ähnlich schwach wie die Leistung der MX300 einzustufen.

danke Holt), eigentlich eien Unverschämtheit bei dem Preis. Aber, aus Samdumm Logik nur eine EVO..

danke Holt), eigentlich eien Unverschämtheit bei dem Preis. Aber, aus Samdumm Logik nur eine EVO..