Werbung

Mit der SSD 840 Series kommt auch eine neue Version der Verwaltungssoftware, die Samsung „SSD Magician" nennt. Nach der Installation lassen sich über den Startbildschirm der Software verschiedene Funktionen auswählen, auf die wir im Folgenden eingehen.

Zur Optimierung der Performance und ggf. auch der Haltbarkeit sind die Punkte „Over Provisioning" und „OS Optimization" interessant. Die erste Funktion erlaubt es, der SSD einen größeren Speicherbereich zur Verfügung zu stellen, der für interne Aufgaben wie das Wear-Leveling (gleichmäßige Zellabnutzung) oder die Garbage-Collection (mehr freie Blöcke sorgen auch nach starker Belastung für eine höhere Performance) genutzt werden kann. In den meisten Fällen ist es jedoch nicht nötig, das Over-Provisioning (auch Spare-Area genannt) zu ändern. Die eingebaute Funktion im SSD Magician arbeitet außerdem relativ simpel: Es muss eine (NTFS-)Partition existieren und diese wird einfach verkleinert, sodass ein Teil des Laufwerks unpartitioniert ist. Den gleichen Effekt kann man auch erzielen, indem man das fabrikneue bzw. gelöschte Laufwerk einfach nicht vollständig partitioniert. In diesem Fall funktioniert das Vergrößern der Spare-Area dann natürlich auch mit allen anderen Partitionstypen. Lediglich, wenn die Spare-Area nachträglich geändert werden soll, muss sichergestellt werden, dass in dem dann unpartitionierten Bereich vorher keine Daten gelegen haben – sonst kann der Controller diesen Bereich nicht für interne Aufgaben nutzen. Benutzt man die Software zur Verkleinerung der Partition, wird dies sichergestellt.

Die Funktion „OS Optimization" ist hingegen weniger nützlich und teilweise auch irreführend: Ob man Super Fetch und den Indexservice ausschalten sollte, ist Geschmackssache. Super Fetch bringt bei SSDs praktisch keinen Vorteil, schadet allerdings auch nicht wirklich. Das Suchen von Dateien geht auf SSDs aufgrund der kurzen Zugriffszeiten natürlich wesentlich schneller als bei Festplatten. Gerade wenn sich sehr viele Dateien auf dem Laufwerk befinden, kann der Indexservice aber auch bei einer SSD deutlich schneller zu den Suchergebnissen führen. In diesem Fall wäre davon abzuraten, den Indexservice zu deaktivieren. Auch die Defragmentierung soll laut SSD Magician deaktiviert werden. Hier herrscht allerdings ein sehr häufiges Misverständnis: Während der Derfragmentierungs-Service bei Windows immer läuft, werden seit Windows 7 SSDs grundsätzlich von der Defragmentierung ausgeschlossen. Dies lässt sich leicht nachprüfen, indem man das Windows-Programm „Defragmentierung" startet und unter „Zeitplan konfigurieren" auf „Datenträger auswählen" klickt. Partitionen, die auf SSDs liegen, werden hier nicht angezeigt und damit auch nicht automatisch durch Windows defragmentiert. Im Zweifelsfall sollte man alle Einstellungen einfach so lassen und nicht den Anweisungen der Software folgen. Wurde das Betriebssystem nicht auf einer SSD, sondern auf einer Festplatte installiert und erst nachträglich umgezogen, reicht es, den Windows-Leistungsindex neu erstellen zu lassen. Windows nimmt spätestens dann alle nötigen und sinnvollen Einstellungen vor.

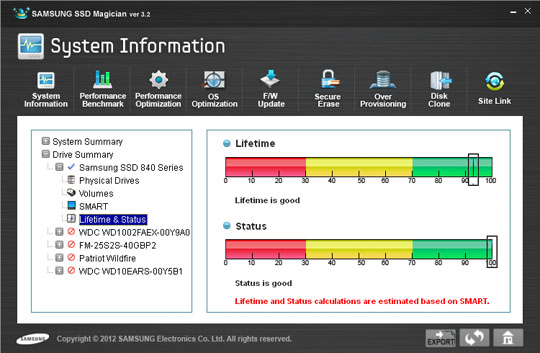

Schließlich bietet die Magician-Software auch noch Tools, um die SSD zu überwachen. Zum einen lassen sich einige SMART-Werte anzeigen, die sich natürlich auch mit anderer Überwachungs-Software auslesen lassen. Die Informationen, die sich aus diesen Werten gewinnen lassen, sind allerdings häufig sehr begrenzt, denn über den Zustand einer SSD sagt ein einzelner Wert nicht unbedingt viel aus.

Interessanter ist für diesen Fall schon der Punkt „Lifetime & Status": Basierend auf den SMART-Werten werden hier von der Software zwei Werte berechnet, die eine ungefähre Abschätzung über die restliche Lebensdauer geben. Warum die Software in unserem Fall nicht (nahe) bei 100 Prozent anfängt, ist nicht bekannt – möglicherweise war unser Sample der SSD nicht neu, sondern wurde bereits von Samsung für Burn-In-Tests o.ä. verwendet. Eine Warnung soll an dieser Stelle allerdings auch noch ausgesprochen werden: Die Lebensdauer-Anzeige bezieht sich ausschließlich auf die Haltbarkeit des Flash-Speichers. Ein Laufwerk kann jedoch aus vielen Gründen ausfallen. Hardware-Defekte und/oder Firmwarefehler sind nicht vorhersehbar und können bei fehlendem Backup zu einem fatalen und unvorhergesehenen Datenverlust führen.