Werbung

Die Radeon R9 Fury X ist sicherlich das beherrschende Thema der vergangenen Tage und wird uns in dieser Form auch noch einige Zeit erhalten bleiben. Ab sofort dürfen wir aber zumindest schon einmal über die bisher bekannten technischen Daten sprechen. Für die ersten Benchmarks müssen wir noch um ein paar Tage Geduld bitten. AMD lässt mit dem "Fiji"-Chip aber derart viele Neuerungen in die eigenen Produkte einfließen, dass man diese Zweiteilung für sich zu rechtfertigen weiß. Das Thema heute sollen also sämtliche technische Daten der Radeon R9 Fury X sowie im speziellen das Design und die Fertigung der GPU und des HBM-Speichers auf dem Package sein.

An dieser Stelle möchten wir auch auf unseren Artikel zu den technischen Daten der kompletten Radeon-300er-Serie sowie das Review zur Radeon R9 390X, R9 390 und R9 380 verweisen. Auch wenn es sich grundsätzlich vielleicht um bereits altbekannte Hardware handelt, so hat AMD doch einige Änderungen vorgenommen und positioniert die Karten zumindest neu.

| Die technischen Daten der AMD Radeon R9 Fury X im Überblick | ||

|---|---|---|

| Modell | AMD Radeon R9 Fury X | NVIDIA GeForce GTX 980 Ti |

| Straßenpreis | 649 US-Dollar | ab 700 Euro |

| Homepage | www.amd.de | www.nvidia.de |

| Technische Daten | ||

| GPU | Fiji XT | GM200 (GM200-310-A1) |

| Fertigung | 28 nm | 28 nm |

| Transistoren | 8,9 Milliarden | 8 Milliarden |

| GPU-Takt (Base Clock) | - | 1.000 MHz |

| GPU-Takt (Boost Clock) | 1.050 MHz | 1.075 MHz |

| Speichertakt | 500 MHz | 1.750 MHz |

| Speichertyp | HBM | GDDR5 |

| Speichergröße | 4 GB | 6 GB |

| Speicherinterface | 4.096 Bit | 384 Bit |

| Speicherbandbreite | 512,0 GB/Sek. | 336,6 GB/s |

| DirectX-Version | 12 | 12 |

| Shadereinheiten | 4.096 | 2.816 |

| Textureinheiten | 256 | 176 |

| ROPs | 64 | 96 |

| Typische Boardpower | 275 Watt | 250 Watt |

| SLI/CrossFire | CrossFire | SLI |

Auf der Radeon R9 Fury X kommt die "Fiji XT"-GPU zum Einsatz. Diese wird weiterhin in 28 nm von TSMC gefertigt und kommt auf 8,9 Milliarden Transistoren. Da das Package bestehend aus GPU, HBM und dem Interposer eine interessante technische Neuerung ist, gehen wir später darauf noch etwas genauer ein. Den Chiptakt gibt AMD mit 1.050 MHz an und dank Wasserkühlung kann dieser laut AMD über sämtliche Lastfälle gehalten werden. Die Temperaturschwelle, ab der eine Drosselung der Spannung und des Taktes stattfindet, konnte uns AMD zum jetzigen Zeitpunkt noch nicht nennen.

Die 4 GB HBM arbeiten mit 500 MHz und bieten eine Speicherbandbreite von 512 GB pro Sekunde, was natürlich nur über das 4.096 Bit breite Speicherinterface sichergestellt werden kann. Auf Seiten der Architektur organisiert AMD insgesamt 4.096 Shadereinheiten in 64 Compute Units. Hinzu kommen 256 Textureinheiten und 64 ROPs. Die Compute-Performance liegt bei 8,6 TFLOPS bei einfacher Genauigkeit. Bei einem Verhältnis von 1:16 erreicht die GPU eine Double-Precision-Performance von 537,6 GFLOPS.

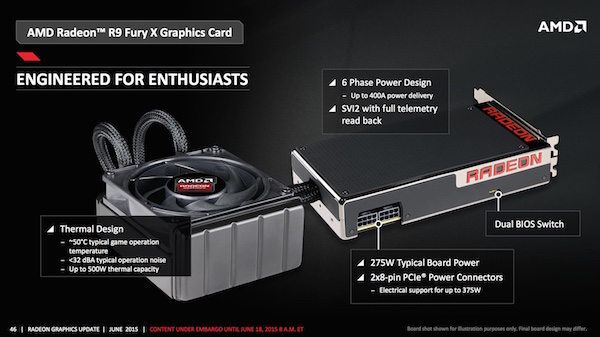

Die Strom- und Spannungsversorgung erfolgt über zwei 8-Pin-Anschlüsse – wie auch schon auf der Radeon R9 295X2. Eventuelle Bedenken bezüglich der elektrischen Eigenschaften der Anschlüsse und Stecker haben wir bereits an dieser Stelle weitestgehend ausgeräumt. AMD gibt eine typische Boardpower von 275 Watt an. In einigen Extremfällen soll sie auch darüber liegen können. Theoretisch kann eine Radeon R9 Fury X in einem CrossFire-System mit zwei, drei und vier Karten betrieben werden. Auf die dazugehörigen CrossFire-Anschlüsse verzichtet AMD aber wie auch schon bei den "Hawaii"-Karten. Die notwenige Kommunikation erfolgt direkt über das PCI-Express-Interface.

Ebenfalls von der Radeon R9 Fury X unterstützt werden Virtual Super Resolution (VSR), FreeSync und Frame Rate Target Control (FRTC).

Das Blockdiagramm zeigt den architektonischen Aufbau der "Fiji"-GPU. In der Mitte sind die 64 Compute-Units zu sehen, welche jeweils noch einmal 64 Shadereinheiten beherbergen. Doch fangen wir im Blockdiagramm links an: Hier zu sehen sind die vier HBM-Chips, die jeweils mit 2x 512 Bit am Memory-Controller der GPU angebunden sind. Dahinter befindet sich der L2-Cache, der 2 MB groß ist. Wie auch bei "Hawaii" kommen bei "Fiji" acht Asynchronous Compute Engines zum Einsatz, die AMD unter anderem für die Asynchronous Shaders und ein beschleunigtes Rendering verwendet.

Über den Global Data Share bzw. die Shader Engines werden die Aufgaben auf die vier großen Blöcke von jeweils 16 Compute Units verteilt. Weiterhin mit an Bord sind eine TrueAudio-Engine, auch wenn AMD das Engadgement weitestgehend eingestellt hat. Man wartet derzeit auf die Entwickler, dass diese wieder vermehrt Wert auf die Audioqualität legen. Bisher ist Thief das einzige Spiel, welches TrueAudio im größeren Umfang verwendet.

Der Unified Video Decoder (UVD) ist auf dem gleichen Stand wie bei den aktuellen "Carrizo"-APUs und kommt somit auch mit H.265 HVEC zurecht. Der Eyefinity Display Controller ist für die Ansteuerung von bis zu sechs Displays verantwortlich. In diesem ist auch die fehlende Unterstützung von HDMI 2.0 begründet, die wir später noch besprechen werden. Bereits angesprochen haben wir die XDMA Engine, die unter anderem für ein funktionierendes CrossFire ohne Brücke sorgt. Das Interface zum restlichen System verbleibt natürlich bei PCI-Express 3.0 – dieses dürfte auch noch einige Zeit der aktuelle Standard bleiben.

AMD verwendet in der "Fiji"-GPU die GCN-Architektur der dritten Generation. Damit ist man auf Niveau der "Tonga"-GPU des letzten Jahres und verwendet auch die gleichen Optimierungen. Eine Möglichkeit, die Performance eines Chips bei gleichem Takt zu steigern, ist die Anzahl der Berechnungen pro Takt zu erhöhen. Im Vergleich zu den Vorgänger-Architekturen kann die "Fiji"-GPU vier sogenannte "Primitives", also einfache Additionen pro Takt berechnen. Dies entspricht einer Verdopplung gegenüber "Tahiti" und sorgt schon einmal für einen deutlichen Schub bei der Gesamtperformance. Damit liegt "Fiji" auf Niveau der "Hawaii"- und "Tonga"-GPU. Auch bei der Tesselation-Performance macht "Fiji" einen Sprung auf Höhe von "Hawaii" und "Tonga" und soll im Vergleich zu "Tahiti" um den Faktor 2 bis 4 schneller sein. Um den nur 4 GB großen Grafikspeicher zumindest etwas zu kompensieren, hat AMD eine verlustlose Delta-Farbkorrektur entwickelt, welche in etwa 40 Prozent Speicherbandbreite einspart, da nicht mehr derart viele Informationen übertragen werden müssen wie ohne dieses Kompressionsverfahren. Letztendlich soll der Speicherdurchsatz in vielerlei Hinsicht höher sein als bei klassischem GDDR5-Speicher.

Stark verbessert hat AMD aber auch das Verhalten beim GPU-Computing. Instruktionen für die parallele Bearbeitung können nun zwischen SIMD-Lanes ausgetauscht werden. Ebenfalls verbessert wurde das Task Scheduling, also die Methode zur Aufteilung von Rechenoperationen zwischen den Shadereinheiten. Neue 16-Bit-Fließkommainstruktionen sorgen ebenfalls für eine effizientere Arbeitsweise im GPU-Computing und Media Processing. All dies ist Teil eines aktualisierten ISA (Instruction Set Architecture) Instruction Sets.

"Fiji" baut auf HBM

Pressematerial zur AMD Radeon R9 Fury X

Größte Neuerung der "Fiji"-GPU ist sicherlich die Verwendung des High Bandwidth Memory (HBM). Dieser kommt zusammen mit der GPU in einem Package unter. Dieses erreicht eine Chipfläche von 596 mm², insgesamt ist das Package mit Interposer 1.011 mm² groß. Auf die Feinheiten der Fertigung und vor allem auf das entscheidende Element, das alle Bauteile miteinander kommunizieren lässt, den Interposer, gehen wir in einem gesonderten Artikel noch etwas genauer ein.

Pressematerial zur AMD Radeon R9 Fury X

Auf die Vorteile von HBM sind wir bereits mehrfach eingegangen. Zusammenfassend kann man aber sagen, dass es AMD durch den Einsatz von HBM möglich ist, die Speicherbandbreite im Vergleich zur Radeon R9 290X um 60 Prozent zu erhöhen. Weiterhin kann das Performance-pro-Watt-Verhältnis in Hinblick auf den Speicher um den Faktor 4 angehoben werden. In dieser Berechnung mit inbegriffen sind die Speicherchips als solches, aber auch die Verbindung durch den Interposer und das Speicherinterface auf der GPU.

Für das Design der Karte bzw. des PCBs ist es AMD aber auch wichtig zu erwähnen, dass durch den Einsatz von HBM eine Reduzierung der Fläche, die von der GPU und den Speicherchips eingenommen wird, um den Faktor drei möglich ist. Erst durch diese Maßnahme wird es AMD möglich, eine derart kurze Variante für eine High-End-Grafikkarten anzubieten.

Kompakte Abmessungen und potente Wasserkühlung

Anstatt einer Länge von 265 mm kommt die Radeon R9 Fury X auf eine Länge von 190,5 mm. Fairerweise muss aber auch die Wasserkühlung mit einberechnet werden und dann sieht es auch für die Radeon R9 Fury X nicht mehr ganz so rosig aus. Alleine auf das PCB und das Gehäuse des Kühlers reduziert stimmt die Einsparung in der Länge natürlich.

Mithilfe der Wasserkühlung will es AMD schaffen, die GPU-Temperatur ständig im Bereich von 50 °C zu halten. Ob dies auch unter unseren Testbedingungen der Fall ist, wird sich noch zeigen müssen. Natürlich kommt eine All-in-One-Wasserkühlung zum Einsatz, die einen geschlossenen Flüssigkeitskreislauf beherbergt. Durch ein effizientes Design des Kühlers will AMD aber auch die Lautstärke verbessern können und spricht von einem deutlich geringeren Betriebsgeräusch als dies bei der GeForce GTX Titan X der Fall ist. Auch dies muss erst noch durch unsere Messungen bestätigt werden.

Durch eine größere Kapazität des Radiators bzw. eine größere Menge an Kühlflüssigkeit will AMD die Leistung des Kühlers im Vergleich zur Radeon R9 295X2 verbessert haben. Bis zu 500 Watt lassen sich theoretisch abführen. Der Kühler deckt dabei nicht nur das Package aus GPU und HBM mit ab, sondern auch einige weitere Komponenten der Karte – unter anderem die VRMs.

Pressematerial zur AMD Radeon R9 Fury X

Besonders hervorheben möchte AMD auch die Konstruktion des Kühlers. Unter anderem eine wichtige Rolle soll dabei die Materialwahl spielen. Zum Einsatz kommt Aluminium als Grundkonstruktion, auf das weitere Elemente wie vernickelte Aluminium-Oberflächen, die spiegelnd poliert wurden, aufbauen. Weite Teile der Oberflächen sind mit Softtouch-Oberflächen versehen.

Der "Radeon"-Schriftzug auf der Kopfseite der Karte ist rot beleuchtet. Weitere LEDs kommen auf Höhe der zusätzlichen Stromanschlüsse zum Einsatz. Dort befinden sich acht LEDs, die Auskunft über die Last auf der GPU geben sollen. Der Nutzer kann via DIP-Schalter zudem die Farbe zwischen Rot und Blau wechseln. Eine einzelne grüne LED zeigt an, wenn sich die Karte im ZeroCore Power Mode befindet. Ein Abschalten der Wasserkühlung ist im ZeroCore Power Mode übringens nicht vorgesehen.

Leicht verwirrend ist die Angabe zu den Display-Anschlüssen. AMD spricht hier von "Next Generation Display", verwendet aber die bereits auf den meisten Karten verwendeten DisplayPort-Anschlüsse nach Standard 1.2 mit MST-Hub. Derer sind gleich drei verbaut. AMD verzichtet auf den Dual-Link-DVI-Ausgang und verbaut stattdessen noch einen HDMI-Anschluss. Doch auch bei diesem ist von Next-Gen wenig zu sehen, denn er entspricht dem Standard 1.4a und nicht wie bei NVIDIA dem aktuellen Standard 2.0, der auch eine Wiedergabe von UltraHD/4K-Auflösung und 60 Hz ermöglichen würde.

Laut AMD war man nicht in der Lage, den Display-Controller in der GPU neu zu designen und musste daher auf HDMI 1.4a verbleiben. Eine genaue Begründung dazu konnte man uns nicht nennen. Laut AMD seien vor allem Fernseher mit HDMI-2.0-Eingang nicht sonderlich weit verbreitet und daher sehe man noch keinen Bedarf, einen entsprechenden Anschluss anzubieten. Allerdings werden im Laufe des Jahres mehr und mehr Fernseher mit HDMI 2.0 auf den Markt kommen und durch die kompakten Abmessungen der Radeon R9 Fury sowie der Fury Nano spricht man sicherlich auch den Kundenkreis an, der sich für ein ITX-System im Wohnzimmer interessiert. Umso unverständlicher ist die fehlende Unterstützung von HDMI 2.0.

Noch eine weitere Ebene bekommt die fehlende Unterstützung durch die dann ebenfalls nicht vorhandene Implementation von HDCP 2.2. Der Kopierschutz wird eine Grundvoraussetzung für 4K-Inhalte per Streaming sein und auch die gegen Ende des Jahres erwarteten 4K-Blu-Rays setzen auf HDCP 2.2.

Noch einmal erwähnt AMD die maximale Leistungsaufnahme von 500 Watt für den Kühler, der die GPU bei etwa 50 °C halten soll. Außerdem noch einmal erwähnt wird die Verwendung von zwei 8-Pin-Anschlüssen, die zusammen mit dem PCI-Express-Steckplatz theoretisch bis zu 375 Watt an die Karte bringen können. Typischerweise soll die Radeon R9 Fury X auf einen Verbrauch von 275 Watt kommen. Die Spannungsversorgung erfolgt über sechs Phasen und ein maximaler Strom von bis zu 400 A soll ebenfalls möglich sein. Der BIOS-Switch dient dieses mal nicht zum Umschalten zwischen verschiedenen Modi (Quiet und Boost), sondern als einfaches Backup eines zweiten BIOS.

AMD empfiehlt nicht den Kühler von der Karte zu entfernen. Die Verbindung zwischen dem GPU-Package und dem Kühler sei extrem empfindlich und ließe sich nur schwer in den Originalzustand zurückversetzen. AMD warnt außerdem vor eventuellen Beschädigungen am Speicher, der GPU und dem Interposer. Auch zum ausführlichen Artikel werden wir also nicht mit eigenen Bildern zum PCB aufwarten können.

Finale Einschätzung

Ohne irgendwelche Benchmarks zu kennen, fällt eine Leistungseinschätzung natürlich schwer. An dieser Stelle müssen wir noch um ein paar Tage Geduld bitten. AMD will sich mit der Radeon R9 Fury X aber sicherlich nicht hinter der GeForce GTX 980 Ti verstecken. Wir erwarten daher einen interessanten Zweikampf zwischen den beiden Herstellern. Das haben auch die ersten Benchmarks aus der Gerüchteküche gezeigt.

Gespannt sind wir darauf, wie AMD mit den "nur" 4 GB Speicher umgeht. Zwar verwenden noch immer nur sehr wenige Spiele mehr als diese 4 GB, doch es gibt sie und dies kann der Radeon R9 Fury X nicht wirklich zum Vorteil gereichen. Die Auswirkungen in der Praxis müssen wir uns noch genauer anschauen und unklar ist auch noch, welche Verfahren AMD im Treiber verwendet, um den zur Verfügung stehenden Speicher besser zu nutzen.

Soviel zur Theorie, in einem zweiten Teil schauen wir uns auch die Fertigung des Packages, bestehend aus Interposer, GPU und HBM etwas genauer an. Genau das ist der Bereich, in den AMD in den vergangenen fünf Jahren viel investiert hat und diese Investitionen sollen sich nun schnellstmöglich auszahlen. Leider können wir heute noch nicht mit Leistungsdaten dienen.