Seit einigen Monaten ist es angekündigt, heute nun startet der Support von FreeSync alias Adaptive Sync. Wir hatten die Gelegenheit, die Technik mit zwei Monitoren auszuprobieren. Bevor wir allerdings zu einigen Praxis-Tests kommen, schauen wir uns die Theorie dazu noch einmal etwas genauer an. Die Probleme, die FreeSync beseitigen soll und der Ansatz sie zu reduzieren oder gar zu entfernen, sind identisch zu G-Sync. Allerdings hängt G-Sync der Makel des proprietären Standards an und entsprechende Monitore sind mangels Marktvielfalt deutlich zu teuer. Daran hat sich auch ein Jahr nach dem Start von G-Sync nichts geändert.

Die Video Electronics Standards Association, kurz VESA, gab gestern bekannt, dass Adaptive Sync Teil des DisplayPort-1.2a-Standards werden wird. Bei Adaptive Sync handelt es sich um eine Technik, bei der das Display das Bild erst dann aktualisiert, wenn die Grafikkarte ein neues Bild berechnet hat - die Bildwiederholrate wird also synchronisiert. Dabei ist Adaptive Sync bzw. die Technik dahinter nicht neu. Im Embedded DisplayPort spielt sie bereits seit 2009 eine Rolle. AMD vermarktes Adaptive Sync unter dem eigenen Produktnamen FreeSync, den wir für diesen Artikel so auch übernehmen werden. Wann immer also von FreeSync die Rede ist, meinen wir damit Adaptive Sync.

FreeSync ist also ein offener Standard und als Adaptive Sync Teil des VESA-Standards. Voraussetzung für die Unterstützung von Adaptive Sync sind eine Grafikkarte und ein Monitor mit DisplayPort 1.2a. Neben dem Display-Anschluss muss auch etwas Hardware im Monitor verbaut sein. Dabei handelt es sich um einen Scaler, der die Bildwiederholfrequenz dynamisch an die Framerate der Grafikkarte anpassen kann. Vermutlich ist dieser auch Teil des G-Sync-Moduls in einem jeden G-Sync-Monitor. Offenbar aber nutzt NVIDIA noch nicht alle Komponenten dieses Moduls und mit Aufkommen der FreeSync-Technologie wurde NVIDIA nicht müde zu betonen, dass man noch etwas in der Hinterhand habe.

FreeSync greift also genau dort ein, wo auch G-Sync arbeitet. Die fehlende Synchronisation der Ausgabe der Grafikkarte und der Darstellung auf dem Monitor sorgen dafür, dass es zu Bildfehlern und Schwankungen in der Bildwiderholrate kommt.

Via VSync, also der Festlegung der Ausgabe der Grafikkarte auf die Bildwiederholrate des Monitors, lässt sich dies zwar beheben, allerdings ist das nur möglich und sinnvoll, wenn die Grafikkarte auch ausreichend FPS ausgeben kann. Große Schwankungen in den FPS sind für Spiele mit wechselnden Anforderungen aber nicht unüblich und so ist eine Bindung an einen festen FPS-Wert schwierig. Zwar können die Monitore zwischen mehreren festgelegten Bildwiederholraten wechseln (144, 60, 30, 24 Hz), allerdings führen diese Übergänge ebenfalls zu einem Stottern. Zudem steigt der Input-Lag, sobald die festgelegten FPS nicht mehr gehalten werden können.

Via FreeSync wird das Bild auf dem Monitor immer dann ausgegeben, wenn es fertig ist. Die möglichen Bildwiederholraten bewegen sich dabei zwischen 9 und 240 Hz. Dies ist aber abhängig vom jeweiligen Monitor-Modell bzw. dem eingesetzten Panel. Bereits zum Start sind aber weitaus mehr Modelle mit FreeSync-Unterstützung angekündigt und wohl bald auch verfügbar, als bisher jemals mit G-Sync-Unterstützung.

Die Ansätze für FreeSync also identisch mit denen von G-Sync: Ruckler sollen minimiert, ein Tearing komplett unterbunden werden und dem Monitor wird die Möglichkeit gegeben, die FPS auszugeben, die auch wirklich aus von der Grafikkarte berechnet werden.

Gerne streicht AMD auch die Unterschiede zwischen FreeSync und Adaptive Sync heraus. Dabei spielt natürlich die Tatsache das G-Sync ein proprietärer Standard ist eine wichtige Rolle. Das Fehlen von Lizenzzahlungen soll dazu führen, dass FreeSync-Monitore deutlich günstiger sind. Für den Preis spielt aber sicherlich auch die größerer Konkurrenz innerhalb der Monitor-Hersteller eine wichtige Rolle. Außerdem spricht AMD für FreeSync von der Unterstützung von Bildwiederholraten von 9 bis 240 Hz. In den Extrembereichen von 24 Hz und weniger sowie 144 Hz und mehr hat aber noch kein Hersteller ein entsprechend kompatibles Panel angekündigt und so bleibt abzuwarten, ab wann FreeSync davon Gebrauch macht.

Während G-Sync bereits ab 30 FPS/Hz arbeitet, erfolgt eine Synchronisation bei FreeSync erst ab 40 bzw. 48 FPS/Hz. Dies ist abhängig vom jeweiligen Monitor-Modell. Liegen die FPS unter diesem Wert, arbeitet FreeSync noch nicht und damit können auch die Vorteile nicht ausgeschöpft werden.

Als wir uns den ersten G-Sync-Monitor in Form des ASUS ROG Swift PG278Q (Hardwareluxx-Artikel) anschauten, machten wir auch einige Messungen zum Performance-Verlust. Dabei zeigte sich, dass dieser zwar messbar, aber in einem extrem niedrigen Bereich vorhanden ist. AMD findet auch hier einen Angriffspunkt und spricht von bis zu 1,5 Prozent, wenngleich wir auch ein paar Prozentpunkte mehr feststellen konnten. Es ist also nicht abzustreiten, dass durch G-Sync ein paar FPS in der Leistung verloren gehen. Diese werden aber auch durch eine verbesserte Darstellung aufgefangen. Ähnliches war auch von FreeSync zu erwarten.

AMD spricht allerdings von einem nicht vorhandenen Performance-Verlust, der für uns innerhalb der Messungenauigkeit liegt. Sollten die 0,2 Prozent der Realität entsprechen, sehen wir auch hier keinen wirklichen Einfluss auf die Performance durch FreeSync. Wir haben aber auch einige eigene Messungen durchgeführt, die zu einem ähnlichen Ergebnis kommen.

Leistungsmessung - Battlefield 4

2.560 x 1.600 4xMSAA 16xAF

Werbung

Leistungsmessung - Crysis 3

2.560 x 1.600 4xMSAA 16xAF

Leistungsmessung - Metro: Last Light

2.560 x 1.600 1xSSAA 16xAF

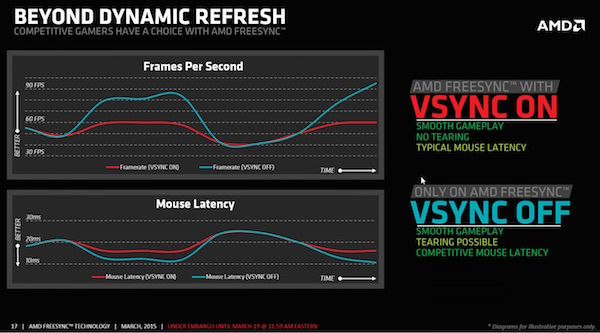

Einen weiteren Freiheitsgrad bietet FreeSync durch die Tatsache, das sich VSync ein- und ausschalten lässt. Je nachdem welches Verhalten bevorzugt wird, kann der Nutzer entscheiden, ob ihm möglichst hohe FPS wichtig sind oder eine möglichst geringe Latenz des Maus-Inputs.

AMDs FreeSync alias Adaptive Sync

Bereits zum Start von FreeSync soll es gleich mehrere verfügbare Modelle geben. Bereits testen konnten wir den Acer XG270HU sowie den LG 34M67. Auch BenQ, Samsung und einige weitere Hersteller haben ihre Modelle bereits zur CES angekündigt.

Obige Übersicht zeigt die bisher vorgestellten Modelle.